كيفية اكتشاف الانتحال في ChatGPT والذكاء الاصطناعي

نشرت: 2023-06-22قلبت ChatGPT العالمين الأكاديمي والتجاري رأسًا على عقب من خلال قدرتها على إنشاء نسخة متماسكة ومكتوبة جيدًا حول أي موضوع على وجه الأرض في غضون ثوانٍ.

وقد شهدت قدراتها الرائعة الطلاب من جميع المستويات التعليمية يتحولون إلى روبوت المحادثة - بالإضافة إلى منافسيه ، مثل Bard - لكتابة مقالات معقدة قد تستغرق ساعات حتى تنتهي.

أدى هذا إلى بدء محادثة عالمية حول ظاهرة جديدة ، غالبًا ما يشار إليها باسم "الانتحال الأدبي في ChatGPT". يغطي هذا الدليل الأدوات التي تستخدمها الشركات والمؤسسات التعليمية للكشف عن الانتحال في ChatGPT ، ومخاطر الغش باستخدام ChatGPT - وما إذا كان استخدام ChatGPT يعتبر سرقة أدبية على الإطلاق.

- كيفية الكشف عن الانتحال في ChatGPT

- الأكثر شيوعًا AI و ChatGPT مدققات الانتحال

- هل تعمل مدققات محتوى الذكاء الاصطناعي في الواقع؟

- هل استخدام ChatGPT أو Bard في الواقع انتحال؟

- مخاطر الغش مع ChatGPT

- هل ينتحل ChatGPT؟

- هل انتحل بارد؟

- هل تنتحل أدوات الذكاء الاصطناعي الأخرى؟

- هل يجب علي استخدام ChatGPT لمقالاتي أو عملي؟

كيفية الكشف عن الانتحال في ChatGPT

للكشف عن الانتحال في ChatGPT ، تحتاج إلى مدقق محتوى AI. تقوم مدققات محتوى الذكاء الاصطناعي بفحص مجموعات النصوص لتحديد ما إذا كان قد تم إنتاجها بواسطة روبوت محادثة مثل ChatGPT أو Bard ، أو بواسطة إنسان. ومع ذلك ، كما سنغطي لاحقًا ، فإن هذه الأدوات بعيدة كل البعد عن الاعتماد عليها.

من الصعب قليلاً اكتشاف الانتحال عندما يتعلق الأمر بالشفرة ، وهو شيء يمكن أن يولده ChatGPT أيضًا بشكل فعال. لا يوجد نفس النظام البيئي لأدوات الكشف عن الذكاء الاصطناعي للشفرة كما هو الحال بالنسبة للمحتوى.

ومع ذلك ، إذا كنت في بيئة جامعية ، على سبيل المثال ، وترسل رمزًا يتجاوز مستواك التقني ، فقد يكون لدى أستاذك أو محاضرك بعض الشكوك المعقولة جدًا التي طلبت من ChatGPT مساعدتك.

تمت مراجعة أدوات مدقق الانتحال الأكثر شيوعًا لمنظمة العفو الدولية و ChatGPT

منذ إطلاق ChatGPT في نوفمبر 2022 ، أنتجت الكثير من الشركات والمؤسسات التعليمية أدوات التحقق من محتوى الذكاء الاصطناعي ، والتي تدعي أنها قادرة على التمييز بين المحتوى المصطنع والمحتوى الذي أنشأه البشر. الآن ، تستخدم الكثير من الشركات أيضًا chatbot Bard من Google ، والذي يستخدم نموذجًا مختلفًا للغة.

ومع ذلك ، فإن الدقة المزعومة حتى لأكثر أدوات الكشف عن محتوى الذكاء الاصطناعي شهرة هي موضع نزاع شديد ، وقد تم بالفعل تنفيذ دعاوى قضائية بين الطلاب المتهمين زوراً باستخدام محتوى الذكاء الاصطناعي والتعليم.

خلاصة القول هي: لا توجد أداة في هذا الفضاء دقيقة بنسبة 100٪ ، لكن بعضها أفضل بكثير من البعض الآخر.

GPTZero

GPTZero هي أداة شائعة ومجانية لاكتشاف المحتوى بالذكاء الاصطناعي تدعي أنها "أكثر كاشفات الذكاء الاصطناعي دقة عبر حالات الاستخدام ، والتي تم التحقق منها من قبل عدة مصادر مستقلة".

ومع ذلك ، في أبريل ، أثبت طالب التاريخ في جامعة كاليفورنيا في ديفيس أن GPTZero - أداة الكشف عن محتوى الذكاء الاصطناعي التي يستخدمها أستاذه - كانت غير صحيحة عندما وصفت مقالته بأنها من إنتاج الذكاء الاصطناعي.

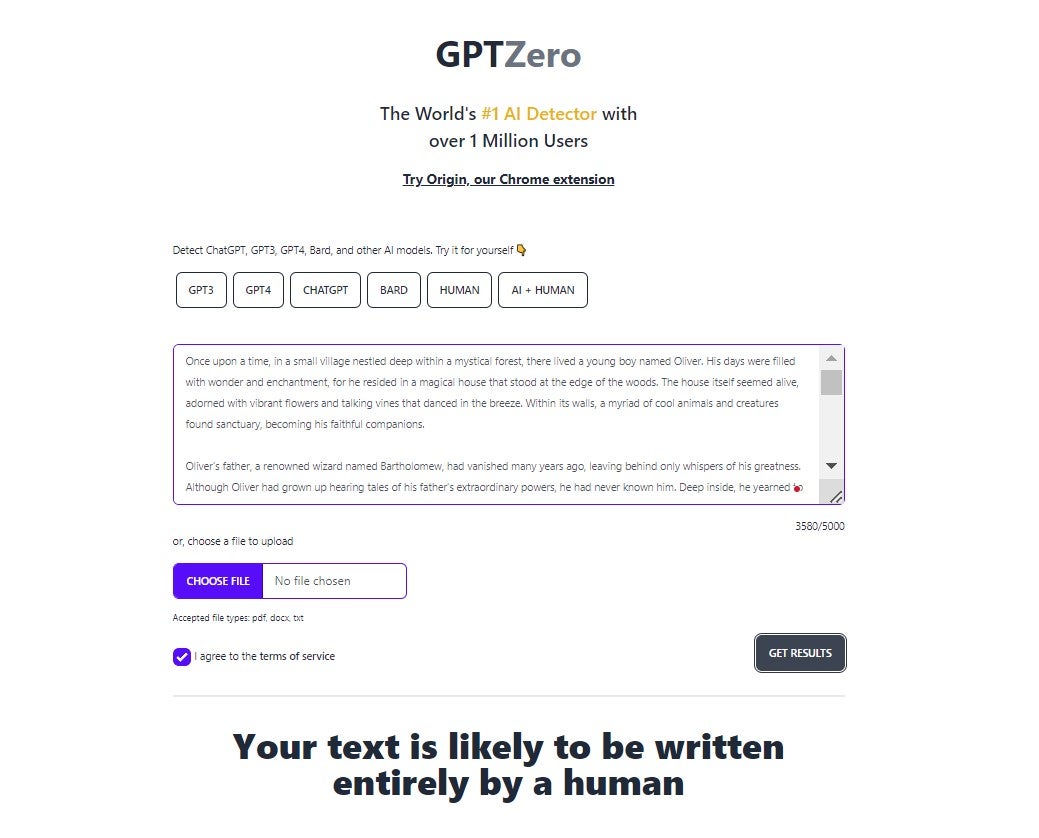

اختبرنا GPTZero عن طريق مطالبة ChatGPT بكتابة قصة قصيرة. GPTZero ، للأسف ، لم يكن قادرًا على معرفة أن المحتوى تمت كتابته بواسطة أداة AI:

الأصالة

تعتبر Originality.ai بالتأكيد واحدة من أكثر أدوات الكشف عن محتوى AI دقة المتوفرة حاليًا.

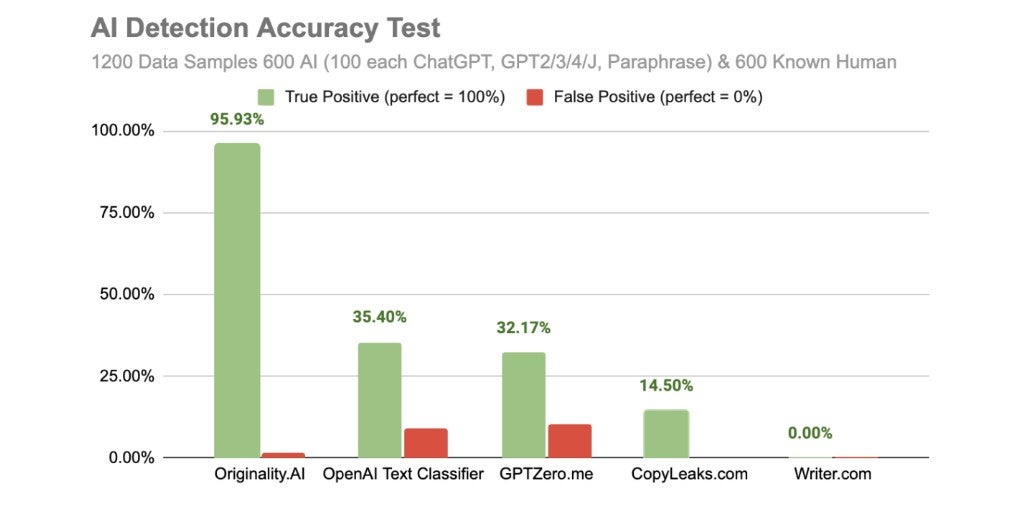

أجرت الشركة دراستها الخاصة حول أدوات الكشف عن محتوى الذكاء الاصطناعي في أبريل من هذا العام ، حيث قامت من خلالها بتغذية 600 كتلة مصطنعة و 600 كتلة نصية أنشأها الإنسان إلى نظام الكشف عن المحتوى الخاص بها ، بالإضافة إلى الأدوات الشائعة الأخرى التي تدعي أنها تفعل نفس الشيء. .

كما ترى من النتائج أدناه ، تفوق Originality.ai على جميع الأدوات المضمنة في الاختبار:

الجانب السلبي الوحيد لـ Originality.ai هو أنه لا توجد خطة مجانية ، ولا يمكنك حتى اختبارها مجانًا كما يمكنك مع التطبيقات الأخرى المضمنة في هذه المقالة. يكلف 20 دولارًا مقابل 2000 رصيد ، مما يتيح لك التحقق من 200000 كلمة.

كاشف محتوى AI Copyleaks

Copyleaks هو كاشف محتوى AI مجاني للاستخدام يدعي أنه قادر على التمييز بين النسخ التي تم إنشاؤها بواسطة الإنسان والنسخ التي تم إنشاؤها بواسطة AI بدقة 99.12 ٪.

ستخبرك Copyleaks أيضًا إذا كانت جوانب معينة من مستند أو مقطع مكتوبة بواسطة AI ، حتى لو بدا أن أجزاء أخرى منها كتبها إنسان.

يقول Copyleaks إنه قادر على اكتشاف المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي والذي تم إنشاؤه بواسطة "ChatGPT و GPT-4 و GPT-3 و Jasper وغيرهم" ، بل إنه يدعي أنه "بمجرد ظهور نماذج أحدث ، سنكون قادرين على اكتشافه تلقائيًا".

تتكلف CopyLeaks 8.33 دولارًا أمريكيًا شهريًا مقابل 1200 ائتمان (250 كلمة لكل ائتمان).

في اختبار أجرته TechCrunch في فبراير 2023 ، على الرغم من ذلك ، صنفت Copyleaks بشكل غير صحيح أنواعًا مختلفة مختلفة من النسخ التي تم إنشاؤها بواسطة AI ، بما في ذلك مقالة إخبارية ، وإدخال موسوعة ، ورسالة مقدمة على أنها من صنع الإنسان.

علاوة على ذلك ، وجدت دراسة Originality.ai المشار إليها أعلاه أنها دقيقة فقط في 14.50٪ من الحالات - وهو بعيد كل البعد عن دقة 99.12٪ التي تقدمها CopyLeaks.

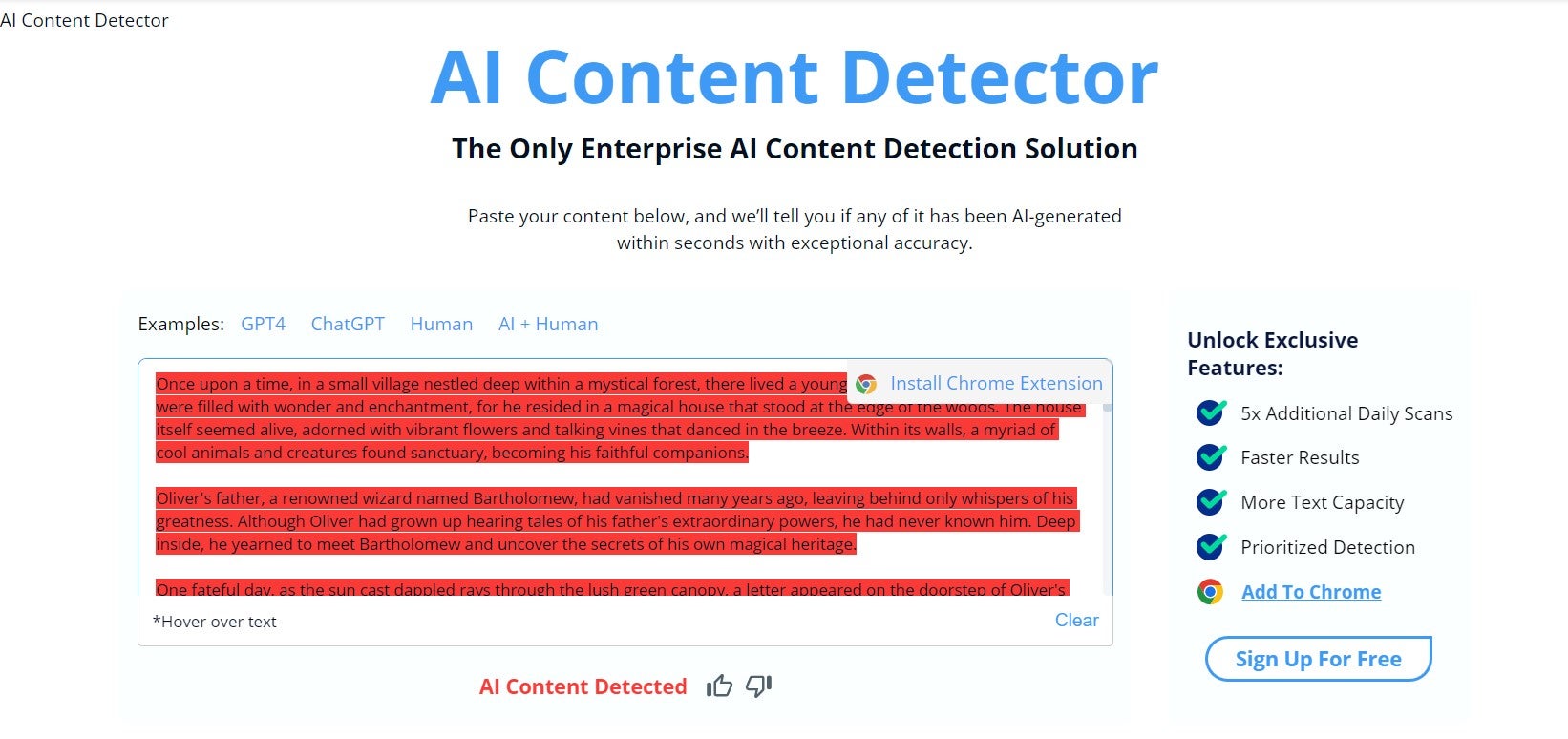

ومع ذلك ، عندما اختبرناه ، بدا أنه قادر على التقاط أن النص الذي أدخلناه قد تم إنشاؤه بواسطة ChatGPT:

كاشف Turnitin AI

Turnitin هي شركة مقرها الولايات المتحدة للكشف عن السرقات الأدبية ويتم نشرها من قبل مجموعة متنوعة من الجامعات لمسح عمل طلابها. تم تصميم Turnitin لاكتشاف جميع أنواع الانتحال ، لكنه كشف في أبريل أنه يستثمر في فريق يركز على الذكاء الاصطناعي لبعض الوقت الآن.

يقول Turnitin أنه بإمكانه "اكتشاف وجود الكتابة بالذكاء الاصطناعي بثقة 98٪ ومعدل إيجابي كاذب أقل من 1٪ في بيئة المختبر الخاضعة للرقابة".

ومع ذلك ، تقول الشركة أيضًا أن المحتوى إذا وضع علامة على جزء من المحتوى على أنه تم إنشاؤه بواسطة الذكاء الاصطناعي ، فيجب التعامل معه على أنه "مؤشر وليس اتهامًا". كانت الدقة الحقيقية لكاشف Turnitin للذكاء الاصطناعي موضع نزاع من قبل واشنطن بوست ، بالإضافة إلى مصادر أخرى.

برنامج الكشف عن محتوى AI من Turnitin مجاني حاليًا ، لكن الشركة تقول في الأسئلة الشائعة على موقعها الإلكتروني إنها تنتقل إلى برنامج ترخيص مدفوع في يناير 2024 - لم يتم تحديد سعره.

مصنف نص OpenAI

نظرًا لعدم رغبتها في الاستغناء عن مدققي محتوى AI التابعين لجهات خارجية ، أصدرت OpenAI نفسها جزءًا من البرامج المصممة لتصنيف ما إذا كان قد تم إنشاء المحتوى بواسطة AI.

يجب أن يزيد طول المستند أو النص الذي تدخله عن 1000 حرف. بمجرد إدخال المستند الخاص بك ، ستخبرك OpenAI على الفور تقريبًا عن مدى احتمالية اعتقادها بأنها قد تم إنشاؤها بواسطة البشر.

لقد نشرت مقتطفًا من مقال حديث لـ Tech.co ، كتبه كاتب - والذي قررت شركة OpenAI بشكل صحيح أنه "من غير المحتمل جدًا" أن تكون قد كتبته منظمة العفو الدولية.

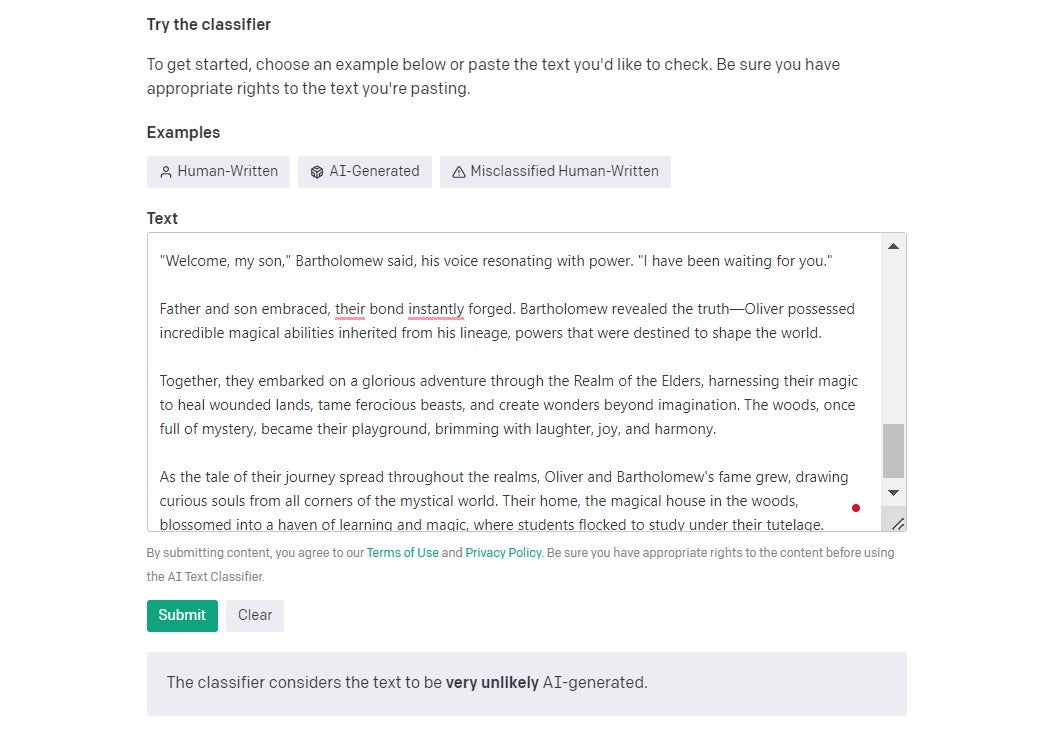

في نفس مقال TechCrunch الذي أشرنا إليه سابقًا ، يقول المنشور إن OpenAI يقدر أن مُصنِّف النص الخاص به يفقد 74٪ من المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي. إنه لأمر جيد أنهم صادقون جدًا بشأن هذا أيضًا - عندما أجرينا اختبارًا ثانيًا ، باستخدام قصة قصيرة تم إنشاؤها بواسطة ChatGPT ، لم يتم التعرف على حقيقة أنها تم إنشاؤها بواسطة الذكاء الاصطناعي:

هل يعمل اكتشاف المحتوى بالذكاء الاصطناعي بالفعل؟

لا توجد أداة للكشف عن المحتوى بالذكاء الاصطناعي يمكن الاعتماد عليها بنسبة 100٪ - أثبتت اختباراتنا ذلك بشكل مدوٍ.

ومع ذلك ، لا تدعي أي من الأدوات التي ناقشناها اليوم أنها دقيقة بنسبة 100٪ ، ويدعي عدد قليل جدًا أنها خالية تمامًا من الإيجابيات الكاذبة. آخرون ، مثل GPTZero ، ينشرون إخلاء المسؤولية حول أخذ نتائجهم على أنها إنجيل.

اضطر عدد من طلاب الجامعات المتهمين باستخدام الذكاء الاصطناعي لإنتاج مقالات إلى إثبات أن عملهم كان أصليًا.

في ولاية تكساس ، في مارس ، فشل أستاذ كاذبًا في فصل كامل من الطلاب بعد اتهامهم خطأ باستخدام ChatGPT لكتابة مقالات. هناك أيضًا مجموعة من التقارير - ودراسات مثل تلك التي أجرتها Originality.ai - والتي تشير إلى أنه حتى أكثر مدقق الانتحال قدرة ليست دقيقة كما تدعي.

حتى كاشف المحتوى المزود بالذكاء الاصطناعي من Turnitin ليس مضمونًا. في الاختبار الأخير الصغير نسبيًا الذي أجرته صحيفة واشنطن بوست والذي ناقشناه سابقًا ، كانت دقته أقل بكثير من نسبة 98٪ التي يزعمون أنهم قادرون على إنتاجها.

من ناحية أخرى ، فإن Originality.ai هي بالتأكيد واحدة من أقوى التقنيات المتاحة - وحتى تقنية الكشف الخاصة بها ليست مناسبة في كل مرة.

بالإضافة إلى ذلك ، في حالة وجود إيجابيات خاطئة بأي صفة ، فسيكون هناك دائمًا مجال للطلاب للادعاء بأن عملهم أصلي وقد تم التعرف عليه بشكل خاطئ.

هل تستخدم ChatGPT أو Bard الانتحال؟

من المثير للجدل ما إذا كان ChatGPT هو في الواقع سرقة أدبية على الإطلاق. تعرّف أكسفورد للغات الانتحال على أنه "ممارسة أخذ عمل أو أفكار شخص آخر وتمريرها على أنها أعمال أو أفكار خاصة به".

ChatGPT ليس شخصًا ، ولا يعيد إنتاج أعمال وأفكار الآخرين عندما يولد إجابة. لذلك ، من خلال تعريف القاموس ، فهي ليست سرقة أدبية صريحة.

حتى لو كان يفعل ذلك ، إذا كنت صادقًا بشأن مصدره (أي ChatGPT) ، فيمكن القول إن هذا لن يكون سرقة أدبية على أي حال.

ومع ذلك ، فإن بعض المدارس والجامعات لديها قواعد انتحال بعيدة المدى وتفكر في استخدام روبوتات المحادثة لكتابة المقالات على هذا النحو. فشل أحد الطلاب في جامعة فورمان في الحصول على درجة الفلسفة في ديسمبر بعد استخدام ChatGPT لكتابة مقاله. في حالة أخرى ، أفاد أستاذ في جامعة ميشيغان الشمالية بإمساك طالبين باستخدام روبوت المحادثة لكتابة مقالات لفصلهما.

إن استخدام ChatGPT لإنشاء مقالات ثم تمريرها على أنها عملك الخاص ربما يكون أفضل وصف له بأنه "غش" وهو بالتأكيد "غير أمين".

الهدف الكامل من كتابة مقال هو إظهار قدرتك على إنتاج أفكار أصلية ، وفهم المفاهيم ذات الصلة ، والتفكير بعناية في الحجج المتضاربة ، وتقديم المعلومات بوضوح ، والاستشهاد بمصادرك.

هناك فرق ضئيل للغاية بين استخدام ChatGPT بهذه الطريقة والدفع لطالب آخر لكتابة مقالتك نيابة عنك - وهو بالطبع غش.

فيما يتعلق بـ Google Bard ، فإن الإجابة أكثر تعقيدًا بعض الشيء. ينطبق نفس المنطق المستخدم أعلاه على Bard كما هو الحال في ChatGPT ، لكن Bard قد شابته اتهامات بالسرقة الأدبية والاقتباس غير الصحيح من الأشياء التي يسحبها من الإنترنت بطريقة لم يفعلها ChatGPT. لذلك ، قد يؤدي استخدام Bard إلى سرقة مصادر أخرى عن غير قصد ( المزيد حول هذا أدناه ).

مخاطر الغش مع ChatGPT

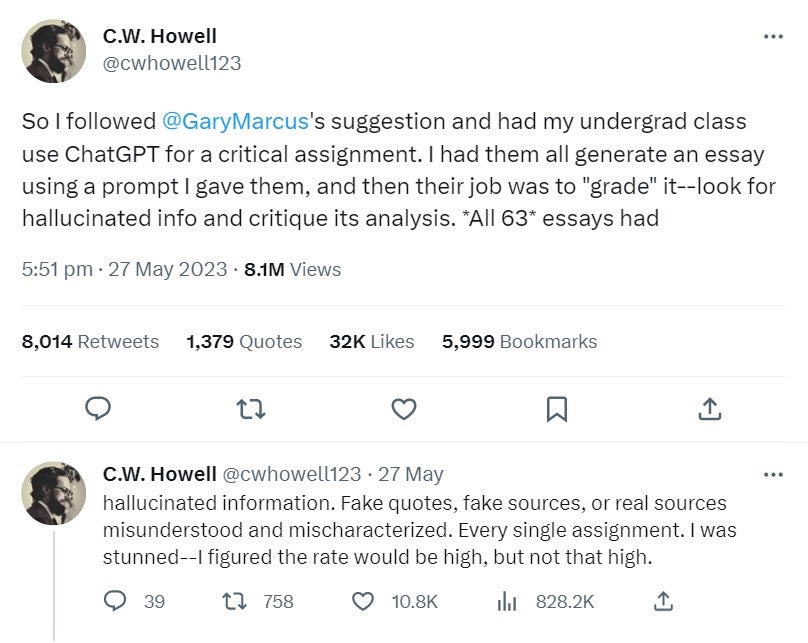

طلب كريستوفر هويل ، الأستاذ المساعد في جامعة إيلون ، مؤخرًا من مجموعة من الطلاب استخدام ChatGPT في مهمة حرجة ثم وضع درجات للمقالات التي أنتجها لهم.

أفاد في موضوع طويل على Twitter (الجزء الأول منه في الصورة أدناه) أن جميع الطلاب الـ 63 الذين شاركوا وجدوا شكلاً من أشكال "الهلوسة" - بما في ذلك الاقتباسات المزيفة ، والمصادر المزيفة والمفسرة بشكل خاطئ - في مهامهم.

هل ينتحل ChatGPT في ردوده؟

لا - لا يقوم ChatGPT بسحب المعلومات من مصادر أخرى ويقوم ببساطة بتشويشها معًا جملةً بجملة. هذا سوء فهم لكيفية عمل المحولات التوليدية المدربة مسبقًا.

يتم تدريب ChatGPT - أو بشكل أكثر دقة نموذج لغة GPT - على مجموعة بيانات ضخمة من المستندات ومواد مواقع الويب والنصوص الأخرى.

يستخدم الخوارزميات للعثور على التسلسلات والأنماط اللغوية ضمن مجموعات البيانات الخاصة به. يمكن بعد ذلك إنشاء الفقرات والجمل والكلمات بناءً على ما تعلمه نموذج اللغة عن اللغة من التسلسلات في مجموعات البيانات هذه.

هذا هو السبب في أنك إذا سألت ChatGPT نفس السؤال في نفس الوقت من جهازين مختلفين ، فعادة ما تكون إجاباته متشابهة للغاية - ولكن لا يزال هناك تباين ، وفي بعض الأحيان ، يقدم إجابات مختلفة تمامًا.

هل انتحل بارد في ردوده؟

أكبر منافس لـ ChatGPT ، واجه Bard من Google مشاكل مع المحتوى المسروق منذ إطلاقه أكثر من نظيره الأكثر شعبية. اكتشف موقع Tom's Hardware الإلكتروني للتكنولوجيا أن Bard قد سرقت إحدى مقالاتها ، ثم تقدمت بالاعتذار عندما دعاها أحد موظفيها.

في الآونة الأخيرة ، في مايو 2023 ، أخبر PlagiarismCheck موقع Yahoo News أنهم قاموا بإنشاء 35 قطعة نصية باستخدام Bard ، ووجدوا أنها مسروقة بنسبة تزيد عن 5٪ في 25 منها بمجرد إعادة صياغة المحتوى الحالي المنشور بالفعل على الإنترنت.

أحد الاختلافات الكبيرة بين Bard و ChatGPT والتي ربما تفسر ذلك هو أن Bard يمكنها البحث في الإنترنت عن الردود ، وهذا هو السبب في أنها تميل إلى التعامل بشكل أفضل مع الأسئلة المتعلقة بالأحداث بعد عام 2021 ، والتي تكافح ChatGPT معها. ومع ذلك ، يبدو أن هذا يعني أيضًا أنه يسحب البيانات من المصادر بطريقة أقل أصالة ويستشهد بمصادرها في كثير من الأحيان.

قد تكون هذه الأمثلة مضطربة ، ولكن من الجيد معرفة المخاطر إذا كنت تستخدم Bard في عمل مهم.

هل تنتحل أدوات الذكاء الاصطناعي الأخرى؟

لسوء الحظ ، نعم - وقد أحرجت بعض الشركات نفسها بالفعل باستخدام أدوات الذكاء الاصطناعي التي تحتوي على محتوى مسروق. على سبيل المثال ، وُجد أن موقع CNET - أحد أكبر مواقع التكنولوجيا في العالم - يستخدم أداة الذكاء الاصطناعي لإنشاء مقالات ، ولم يكن شفافًا بشأنه على الإطلاق. تم العثور على ما يقرب من نصف المقالات التي نشرتها CNET باستخدام الذكاء الاصطناعي تحتوي على بعض المعلومات غير الصحيحة.

ومما زاد الطين بلة ، أن Futurism ، التي أطلقت تحقيقًا في سرقة الذكاء الاصطناعي لـ CNET ، قالت إن "سوء سلوك الروبوت يتراوح من النسخ الحرفي إلى التعديلات المعتدلة إلى عمليات إعادة الصياغة المهمة ، كل ذلك دون تسجيل الأصل بشكل صحيح".

أدوات الذكاء الاصطناعي التي لا تنشئ محتوى فريدًا وأصليًا - سواء كان فنًا أو نصًا - لديها القدرة على سرقة المحتوى الذي تم نشره بالفعل على الإنترنت. من المهم أن تفهم بالضبط كيف يعمل نموذج اللغة الذي تستخدمه أداة الذكاء الاصطناعي الخاصة بك وأن يكون لديك أيضًا رقابة صارمة على المحتوى الذي تنتجه ، أو قد ينتهي بك الأمر في نفس وضع CNET.

هل يجب عليك استخدام ChatGPT للمقالات أو للعمل؟

استخدام ChatGPT للمقالات

حقيقة أن ChatGPT لا يسحب الإجابات من مصادر أخرى ويجمع الجمل معًا يعني أن الشركات كانت قادرة على استخدام ChatGPT في مجموعة متنوعة من المهام المختلفة دون القلق بشأن مشكلات حقوق النشر.

لكن ميكانيكاها الداخلية تعني أيضًا أنها غالبًا ما تهلوس وترتكب الأخطاء. إنه بعيد عن الكمال - وعلى الرغم من أنه من المغري الحصول على ChatGPT لكتابة مقالتك للجامعة أو الكلية ، فإننا ننصح بعدم القيام بذلك.

ستكون إرشادات التقديم الخاصة بكل مؤسسة تعليمية مختلفة قليلاً ، بالطبع ، ولكن من المحتمل جدًا أن يتم اعتبارها بالفعل "غشًا" أو سرقة أدبية في جامعتك أو مدرستك. بالإضافة إلى ذلك ، بغض النظر عن مدى دقتها ، تستخدم المؤسسات التعليمية أجهزة كشف المحتوى بالذكاء الاصطناعي ، والتي ستتحسن بمرور الوقت.

استخدام ChatGPT في العمل

بالطبع ، يستخدم الكثير من الأشخاص ChatGPT في العمل بالفعل - فقد ثبت أنه مفيد في مجموعة واسعة من الصناعات ، ويساعد العمال في جميع أنواع الأدوار على توفير الوقت الثمين في المهام اليومية.

ومع ذلك ، إذا كنت تستخدم ChatGPT في العمل ، فإننا ننصح بالانفتاح مع مديرك أو مشرفك بشأنه - خاصةً إذا كنت تستخدمه في أنشطة مهمة مثل كتابة التقارير لأصحاب المصلحة الخارجيين.

كما ننصح بشدة بتحرير كل العمل الذي تستخدمه ChatGPT أو Bard أو أي أداة أخرى للذكاء الاصطناعي ومراجعته عن كثب. ليس من الحكمة وضع معلومات شخصية أو معلومات خاصة بالشركة في أي روبوت محادثة ، حيث لا يوجد الكثير من المعلومات العامة حول مكان تخزين هذه الدردشات أو البنية التحتية الأمنية لـ OpenAI.

استخدام أدوات الذكاء الاصطناعي الأخرى للمقالات أو العمل

بالطبع ، Bard و ChatGPT ليسا روبوتَي الدردشة الوحيدان اللذان يعملان بنظام الذكاء الاصطناعي. ومع ذلك ، سنكون مترددين في تقديم دعمنا وراء أي أدوات ذكاء اصطناعي أصغر لا تدعمها نماذج لغة قوية. لن تكون ذات موارد جيدة ، ومن غير المرجح أن تجدها مفيدة إذا قمت بتجربة استخدامها في العمل.

ومع ذلك ، لا تزال نفس القواعد سارية - كن منفتحًا مع مديرك واستخدمها ، ولا تدخل أي بيانات حساسة للشركة ، وقم دائمًا بمراجعة الإجابات التي قدمتها.