Warum KI-Therapie-Chatbots das ultimative ethische Dilemma darstellen

Veröffentlicht: 2023-10-31Generative KI-Chatbots wie ChatGPT werden verwendet, um Prozesse am Arbeitsplatz zu rationalisieren, Code zu schreiben und sogar Drehbücher für Stand-up-Comedy-Sets zu schreiben. In den USA, wo die Fälle von Angstzuständen und Depressionen Rekordhöhen erreichen und die professionelle Unterstützung weiterhin unzureichend ist, ist es keine Überraschung, dass Benutzer die Technologie auch zur Unterstützung ihrer psychischen Gesundheit nutzen.

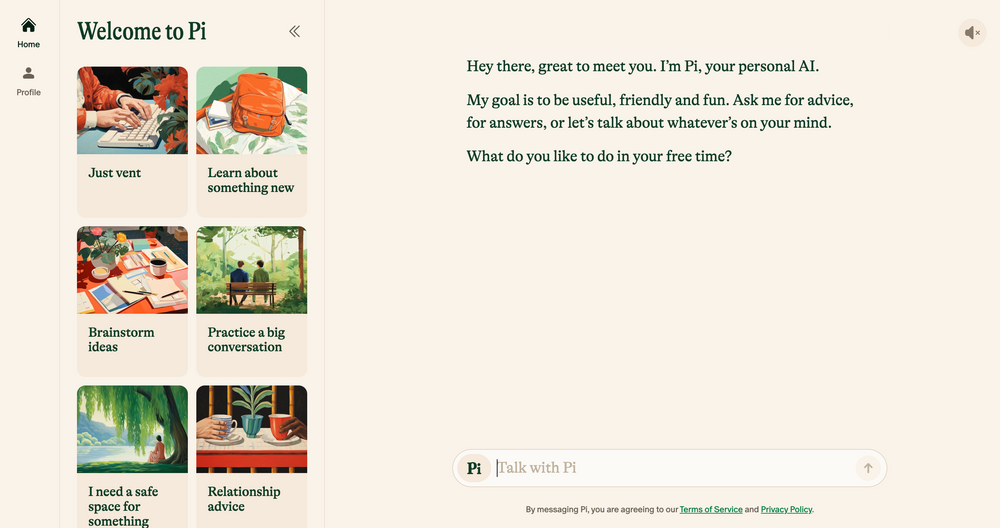

KI-Chatbots wie Elomia, Pi und Woebot bieten erschwinglichen, personalisierten Support rund um die Uhr, basierend auf bewährten Therapietechniken. Von der Unterstützung von Benutzern beim Umgehen langer Wartelisten bis hin zur Verringerung der Stigmatisierung beim Zugang zu Hilfe – ihre Vorteile sind enorm. Kann generative KI – die immer noch anfällig für Fehler, Halluzinationen und Voreingenommenheit ist – jemals mit der Empathie des menschlichen Ohrs verglichen werden?

Wir haben mit Akademikern, Psychologen und praktizierenden Therapeuten gesprochen, um zu beleuchten, wie die aufkommende Technologie die Zukunft der Therapie prägen wird. Wir diskutieren auch die Schattenseiten der KI-Therapie und zeigen auf, welche ethischen Bedenken heute angegangen werden müssen. Hier ist, was wir gefunden haben.

KI-Chatbots: Die neue Generation von Robotertherapeuten

Seit der Einführung des Chatbots ChatGPT von OpenAI im vergangenen November ist eine Armee von Chatbot-Nachahmern in den App-Stores aufgetaucht – von Allzweck-Apps wie Google Bard und Claude AI bis hin zu weniger konventionellen Marvel-Charaktersimulatoren.

Dieser aufstrebende Markt hat auch zum Aufstieg von KI-Therapie-Chatbots geführt – Apps, die generative KI nutzen, um Ratschläge und Anleitungen qualifizierter Therapeuten und Fachkräfte für psychische Gesundheit nachzuahmen.

Möchten Sie privat im Internet surfen? Oder so aussehen, als wären Sie in einem anderen Land?

Möchten Sie privat im Internet surfen? Oder so aussehen, als wären Sie in einem anderen Land?

Sichern Sie sich mit diesem Black Friday-Angebot von Tech.co satte 86 % Rabatt auf Surfshark. ![]()

Wichtige Beispiele sind Pi, ein selbsternannter „freundlicher Chat-Begleiter“, der als Resonanzboden fungiert und emotionale Unterstützung bietet; Replika, ein Chatbot-Programm, das den Sprechstil und die Persönlichkeit seiner Benutzer nachahmt; und Earkick, ein Angst-Tracker, der Ihnen dabei helfen soll, schwierige Emotionen aufzuzeichnen und zu verarbeiten.

„KI-basierte Plattformen bieten Privatsphäre und verringern das Stigma, das oft mit der Suche nach Hilfe bei psychischen Problemen verbunden ist.“ – Ryan Sultan, zertifizierter Psychiater und Professor an der Columbia University

Wie die besten Apps für psychische Gesundheit verzeichnen viele dieser Apps bereits sechsstellige Downloads – und ihre Beliebtheit ist kaum überraschend. Aufgrund eines Mangels an qualifizierten Psychologen, Psychiatern und Sozialarbeitern sowie einer landesweit steigenden Nachfrage nach Dienstleistungen kämpfen die USA derzeit mit einer der schlimmsten psychischen Krisen aller Zeiten.

Auch die hohen Kosten traditioneller Therapien und Tabus rund um die psychische Gesundheit halten viele davon ab, konventionelle Optionen in Anspruch zu nehmen, wodurch eine Lücke für diskretere, erschwinglichere Alternativen entsteht.

Erste Erkenntnisse deuten darauf hin, dass sie auch wirksam sind. Die eigenen Ergebnisse von Earkick von AI Chatbot ergaben, dass sich die Stimmung des Benutzers um 34 % verbesserte und das Angstniveau um 32 % sank, nachdem er die App fünf Monate lang genutzt hatte. Doch so erfolgreich diese Apps auch sein mögen, wenn es darum geht, kleinere Ängste zu unterdrücken, sie sind definitiv nicht das Allheilmittel für die psychische Gesundheit, auf das wir alle gewartet haben.

KI-Chatbots sind für schwere psychische Erkrankungen ungeeignet

Für viele wird es zweifellos hilfreich sein, vernünftige, vom Therapeuten anerkannte Ratschläge von einem Chatbot im Taschenformat zu erhalten. Allerdings werden diejenigen, die an schweren psychischen Erkrankungen wie Depressionen, Schizophrenie und bipolaren Störungen leiden, wahrscheinlich nicht davonkommen.

Psychische Störungen sind komplex, sehr nuanciert und für jede Person, die sie betrifft, individuell. In manchen Fällen lassen sie sich am besten mit Medikamenten behandeln, die nur von qualifiziertem medizinischem Fachpersonal korrekt verschrieben werden können. Während sich große Sprachmodelle (LLMs) in den letzten Jahren sprunghaft weiterentwickelt haben, werden ihre Ergebnisse niemals in der Lage sein, das klinische Fachwissen, die Empathie und das Mitgefühl von Psychiatern, Psychologen und Therapeuten zu ersetzen.

„Ich schätze, dass sich die Algorithmen verbessert haben, aber letztendlich glaube ich nicht, dass sie die chaotischeren sozialen Realitäten berücksichtigen werden, in denen sich Menschen befinden, wenn sie Hilfe suchen“, – Julia Brown, Anthropologieprofessorin an der University of California in San Francisco

Der strategische psychische Heiler Aanant Bisht glaubt auch, dass KI in ihrem aktuellen Zustand nicht in der Lage sein wird, die komplexe Heilungsreise jedes Benutzers zu unterstützen. „Es ist auch wichtig, eine zu starke Vereinfachung komplexer psychischer Gesundheitsprobleme zu vermeiden und Benutzer zu ermutigen, bei Bedarf professionelle Hilfe in Anspruch zu nehmen“, sagt Bisht gegenüber Tech.co.

Ein weiteres häufiges Anliegen von Experten, mit denen wir gesprochen haben, ist die medizinische Fehldiagnose. Die Gemeinschaft der psychischen Gesundheit hat seit langem Probleme mit der korrekten Identifizierung komplexer und schwerer psychiatrischer Störungen, und eine starke Abhängigkeit von KI könnte dieses Problem aufgrund der begrenzten Technologien, der nicht repräsentativen Datensätze und der Unfähigkeit, menschliche Nuancen zu interpretieren, wahrscheinlich noch verschärfen.

Auch die Folgen davon können drastisch sein. Eine Fehldiagnose der psychischen Gesundheit führt häufig zu unzureichender Behandlung und Unterstützung, zusätzlichem psychischen Druck und langfristiger Skepsis gegenüber dem medizinischen System. Nicht nur deshalb ist künstliche Intelligenz in ihrer jetzigen Form nicht in der Lage, den Therapeutenstuhl zu überholen.

KI ist fehlerhaft und voller ethischer Herausforderungen

Der rasante Aufstieg der generativen KI blieb nicht ohne Folgen. Da sich die Technologie rasant weiterentwickelt, kommt die Regulierung ihrer Nutzung nur langsam voran, was zu einer Reihe ethischer Herausforderungen im Zusammenhang mit Datenschutz, eingebetteter Voreingenommenheit und Missbrauch führt.

Diese Bedenken gelten nicht nur für die Therapie, aber die sensible Natur der psychischen Gesundheit bedeutet, dass ethische Rahmenbedingungen im Mittelpunkt jeder guten therapeutischen Beziehung stehen. Da es derzeit keinen offiziellen KI-Ethikkodex gibt, ist es äußerst problematisch, dass Benutzer sich für Beratung oder andere Unterstützung im Bereich der psychischen Gesundheit auf Chatbots statt auf qualifizierte Fachkräfte verlassen.

Datenschutz ist ein großes Thema. Chatbots wie ChatGPT sind häufig in Schwierigkeiten geraten, weil sie es versäumt haben, Benutzerdaten zu schützen . Damit sich Benutzer bei der Diskussion privater, persönlicher Informationen wohl fühlen, müssen KI-Unternehmen über eine narrensichere Datenschutzstrategie verfügen, die der Vertraulichkeit Vorrang einräumt.

„Der intime und sensible Charakter therapeutischer Gespräche erfordert ein beispielloses Maß an Datenschutz.“ – Dr. Langham, Psychologe bei Impulse Therapy

Ein weiterer wichtiger Faktor, den Sie beachten sollten, ist die Voreingenommenheit beim maschinellen Lernen. Alle KI-Systeme stützen sich auf vorgegebene Trainingsdaten, die oft eingebettete menschliche Vorurteile beinhalten, selbst wenn sensible Variablen wie Rasse und Geschlecht entfernt werden.

Laut Bayu Prihandito, CEO des Life-Coach-Unternehmens Life Architekture , könnte die KI, wenn sie auf voreingenommenen Daten trainiert wird, „bestehende Vorurteile aufrechterhalten oder verschärfen, was zu ungerechten Behandlungsempfehlungen führt“. Diese eingebauten Vorurteile wirken sich wahrscheinlich auch stärker auf Menschen aus Minderheitengruppen aus und unterstreichen die Bedeutung menschlicher Aufsicht sowie vielfältiger und repräsentativer Trainingsdatensätze.

KI als Assistent des Therapeuten, nicht als Ersatz

Freundliche Begleiter wie Pi und Woebot werden immer beliebter, da Benutzer weiterhin nach zugänglichen Möglichkeiten suchen, ihr geistiges Wohlbefinden zu verbessern. Aufgrund vielfältiger ethischer Bedenken ist künstliche Intelligenz jedoch noch nicht bereit, die Rolle der traditionellen Therapie zu ersetzen, und das sollte sie auch nie tun.

Das heißt jedoch nicht, dass die neue Technologie keine massiven Auswirkungen auf die Praxis als Ganzes haben wird. Die meisten Praktiker, mit denen wir gesprochen haben, glauben, dass KI-Tools ihnen durch die Durchführung einfacher Aufgaben wie der Triage mehr Zeit und Energie geben können, die sie in andere Bereiche der Praxis investieren können.

„Obwohl es die tiefe menschliche Verbindung, die Therapeuten bieten, nicht ersetzen kann, kann es als ergänzendes Instrument dienen.“ – Aanant Bish, Business-Psychic-Coach

„KI könnte erste Beurteilungen und laufende Überwachung übernehmen und weniger komplexe Fälle unterstützen, so dass wir uns auf schwerwiegendere oder heiklere Situationen konzentrieren können“, sagte Bayu Prihandito gegenüber Tech.co und fügte hinzu: „ Es ist, als hätte man ein zusätzliches Paar Hände, die immer da sind.“ verfügbar."

Der Columbia-Professor und zertifizierte Psychiater Sultan stimmt dem zu und erklärt gegenüber Tech.co, dass KI in fünf Jahren wahrscheinlich die traditionelle Therapie ergänzen wird, indem sie Verwaltungsaufgaben rationalisiert, Ärzten hilft, personalisiertere Behandlungspläne zu erstellen und „ Hybridmodelle zu schaffen, die menschliches Fachwissen mit KI kombinieren“. angetriebene Werkzeuge zur Verbesserung der Behandlung“.

Dies deutet darauf hin, dass KI die Praxis nicht ihrer Menschlichkeit beraubt, sondern tatsächlich die Macht hat, menschliche Fähigkeiten wie Empathie, Verbundenheit und Mitgefühl freizusetzen und Kunden dabei zu helfen, noch mehr aus dem Service herauszuholen.

Die Sorge um die psychische Gesundheit ist jedoch eine ernste Angelegenheit und kann oft über Leben und Tod entscheiden. Bevor KI zum Assistenten jedes Therapeuten wird oder ihn sogar ersetzt, müssen strenge Vorschriften für seinen Einsatz und seine Verwendung berücksichtigt werden.

Bis dieser Zeitpunkt gekommen ist, lässt sich das klare Potenzial von KI-Chatbots zur Verbesserung des Zugangs zu psychischer Unterstützung nicht vollständig mit den damit verbundenen Risiken in Einklang bringen. In einer Welt, in der ethische Dilemmata oft an der Tagesordnung sind, ist dieses einfach zu groß, um es zu ignorieren.