AI Voice Cloning Scams: 1 von 4 Erwachsenen bereits im Visier

Veröffentlicht: 2023-05-02Glaubst du, du könntest den Unterschied zwischen einer Voicemail von jemandem, den du liebst, und einer von KI generierten Voicemail erkennen? Nun, Betrüger, die die KI-Sprachklontechnologie verwenden, um ahnungslose Opfer zu betrügen, hoffen sicherlich, dass Sie es nicht können – und jetzt sind sie aktiver als je zuvor.

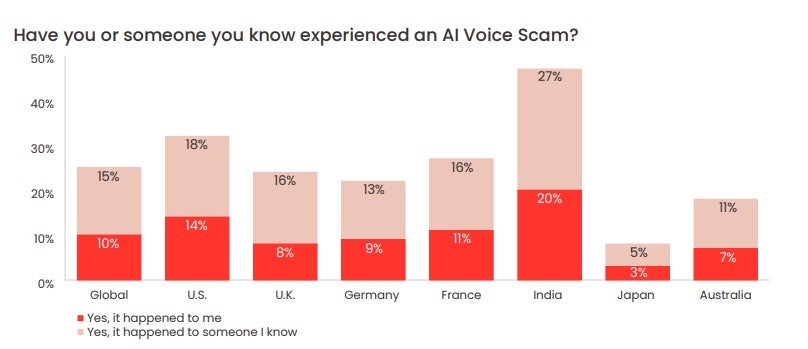

Eine kürzlich von McAfee durchgeführte Umfrage ergab, dass ein Viertel der Erwachsenen bereits Ziel von KI-Sprachbetrug geworden ist, wobei die überwältigende Mehrheit dadurch hart verdientes Geld verliert. Es zeigte sich auch, dass die Mehrheit der Erwachsenen ihre Stimme mindestens einmal pro Woche auf Social-Media- Plattformen und anderen Online-Räumen teilt – was Bedrohungsakteuren genau das gibt, was sie brauchen, um diese Art von Betrug immer wieder auszuführen.

Also, wie funktionieren KI-Sprachklon-Betrügereien eigentlich, wie verbreitet sind sie und wie können Sie einen KI-Sprachklon-Betrug erkennen? Wir schauen genauer hin.

- Was ist ein KI-Voice-Cloning-Betrug?

- Wie AI Voice Cloning tatsächlich funktioniert

- Wie häufig sind AI Voice Clone Scams?

- So erkennen Sie, ob es sich bei einer Nachricht um einen KI-Voice-Clone-Betrug handelt

Was ist ein KI-Voice-Cloning-Betrug?

Ein KI-Sprachklon-Betrug ist jeder Betrug, der künstlich erzeugte Audiodateien verwendet, um die Opfer zu täuschen, dass ihre Lieben in Gefahr sind oder dringend finanzielle Unterstützung benötigen und sie um Hilfe gebeten haben.

Bei einem Betrug dieser Art lässt ein Betrüger einen Clip einer sprechenden Person – oft aus sozialen Medien geschabt – durch einen KI-Sprachgenerator laufen. Mithilfe von maschinellem Lernen analysiert der Generator die Kadenz, den Ton und die Tonhöhe des ursprünglichen Clips und ermöglicht es dem Betrüger dann, einzigartige, originale Audiodaten zu produzieren, die die Stimme der Versuchsperson nahezu perfekt nachahmen.

Der Betrüger sendet diese Aufnahmen dann über Apps wie WhatsApp an Freunde und Verwandte des Opfers, in der Hoffnung, dass sie nicht in der Lage sind, zwischen ihrer geliebten Person und einer KI-generierten Version ihrer Stimme zu unterscheiden.

Wie bei anderen Online-Betrügereien üblich, versucht der Betrüger, seiner Korrespondenz ein Gefühl der Dringlichkeit und Bedrängnis zu verleihen, um das Ziel dazu zu bringen, vorschnell oder unberechenbar zu handeln.

In einem kürzlichen Fall versuchte ein KI-Stimmenbetrüger, eine Mutter in den USA davon zu überzeugen, dass ihre Tochter entführt worden war, indem sie die Stimme des Kindes geklont hatte.

Besorgniserregend ist, dass es einem angehenden Betrüger nicht schwer fallen wird, die Audiodateien zu finden, die er benötigt, um ein Opfer anzugreifen – tatsächlich haben sie wahrscheinlich die Qual der Wahl.

Eine von McAfee im Mai 2023 veröffentlichte Umfrage mit über 7.000 Personen aus sieben verschiedenen Ländern ergab, dass 53 % der Befragten angaben, dass sie ihre Meinung mindestens einmal pro Woche online teilen. In Indien waren es 86 %.

Wie das Klonen von Stimmen tatsächlich funktioniert

Das Klonen von KI-Stimmen ist nur mit einem KI-Tool namens KI-Sprachgenerator möglich. Kurz gesagt, KI-Sprachgeneratoren wandeln Textdateien in Sprache um (oft als „Text-to-Speech“- oder „TTS“-Tool bezeichnet).

KI-Sprachgeneratoren nutzen maschinelles Lernen, um sich selbst beizubringen, auf bestimmte Weise zu sprechen, indem sie Informationen aus Audiodateien von sprechenden Personen analysieren. Die Generatoren wenden dann das Gelernte an, um von Benutzern bereitgestellte Textdateien zu lesen und originale Audioinhalte zu generieren.

Viele dieser Generatoren haben benutzerdefinierte Stimmen, die Sie auswählen können, um Ihren Text zu lesen, sowie Stimmen von Prominenten, aus denen Sie wählen können – aber andere lassen Sie Ihre eigene Stimme aufnehmen und anschließend Audioinhalte erstellen.

Das Text-to-Speech-Tool Descript.com bietet einen selbstbeschriebenen „hochmodernen Sprachgenerator, der einen ultrarealistischen Klon Ihrer eigenen Stimme erstellt“.

KI-Sprachgeneratoren sind jetzt für alle Arten von Geräten weit verbreitet. Diese Programme sind sehr wertvoll für Menschen, die Schwierigkeiten beim Lesen haben oder einfach besser lernen, wenn sie Audio hören, anstatt das geschriebene Wort zu lesen.

Sie werden auch von Werbefirmen verwendet, die kein Budget haben, um einen teuren Sprecher für ihre Marketinginhalte einzustellen.

Der Erfolg und die weit verbreitete Nutzung von ChatGPT hat einen erneuten Fokus auf KI-Tools aller Formen und Größen gelegt, einschließlich solcher, die zum Klonen von Audio verwendet werden können. Trotz ihrer edlen Verwendung gibt es jetzt ein kleines Ökosystem von TTS-KI-Tools, die leider für schändliche Zwecke missbraucht werden können, einschließlich des Betrugs von Menschen.

Wie häufig sind AI Voice Clone Scams?

In der kürzlich veröffentlichten McAfee-Umfrage fand der Cybersicherheitsgigant heraus, dass 1 von 4 befragten Erwachsenen einen KI-Sprachbetrug erlebt hat.

77 % der Zielpersonen gaben an, dass sie durch den Betrug Geld verloren haben. McAfee berichtet, dass von diesen 77 % „mehr als ein Drittel über 1.000 US-Dollar verloren hat, während 7 % um 5.000 bis 15.000 US-Dollar betrogen wurden“.

Opfer in den USA verlieren am meisten, wie die Umfrage zeigt. 11 % der US-Opfer, die durch Betrug mit dem Klonen von KI-Stimmen Geld verloren haben, verloren zwischen 5.000 und 15.000 US-Dollar.

So erkennen Sie, ob es sich bei einer Nachricht um einen AI Voice Clone-Betrug handelt

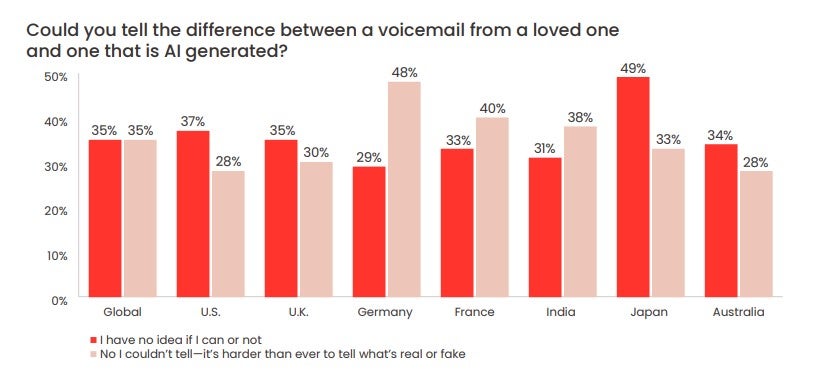

Die McAfee-Umfrage ergab außerdem, dass 70 % der Befragten angaben, „unsicher“ zu sein, ob sie den Unterschied zwischen einer KI-Stimme und einer menschlichen Stimme erkennen könnten.

Fast ein Drittel (28 %) der Befragten in den USA gab an, dass sie nicht in der Lage wären, den Unterschied zwischen einer von einem „künstlichen Betrüger“, wie McAfee es ausdrückt, hinterlassenen Voicemail und einem geliebten Menschen zu erkennen.

Denken Sie daran, dass Betrüger möglicherweise in der Lage sind, die Stimme eines geliebten Menschen zu replizieren – aber die Kontrolle über die Nummer oder das WhatsApp-Konto Ihres geliebten Menschen zu erlangen, ist viel schwieriger.

Es kann schwierig sein, ruhig zu bleiben, wenn es so klingt, als wäre einer Ihrer Verwandten oder Freunde in Not. Aber da KI-Sprachbetrug immer häufiger wird, ist es wichtig, dass Sie dies tun. Es gibt einige Anzeichen dafür, dass eine KI-Sprachnachricht ein Betrug sein könnte:

- Eine ungewöhnliche Kontaktmethode (z. B. eine unbekannte Nummer)

- Sofortige Anfragen nach großen Geldbeträgen

- Geldüberweisungsanträge auf ungewöhnliche Weise (z. B. Geschenkkarten oder Krypto)

- Eine Aufforderung, niemandem von dem Anruf/Vorfall zu erzählen

Vor diesem Hintergrund empfiehlt Ihnen die FTC Folgendes:

- Rufen Sie die Nummer an, die Ihnen die Nachricht hinterlassen hat, um zu überprüfen, wer es ist

- Rufen Sie Ihren Liebsten oder Freund unter seiner persönlichen Nummer an

- Benachrichtigen Sie Familie und enge Freunde der betreffenden Person

Wenn Sie keinen Kontakt herstellen können, ist es wichtig, dass Sie sofort die Strafverfolgungsbehörden informieren. Für diejenigen unter Ihnen, die noch nicht von einem dieser Betrügereien betroffen waren, aber sicherstellen möchten, dass Sie keinem zum Opfer fallen, richten Sie mit Ihrer Familie und Ihren Freunden ein Safeword ein .

Dies ist ein Code, mit dem Sie und Ihre Lieben sich gegenseitig identifizieren können. Dies ist eine der besten Möglichkeiten, um sicherzustellen, dass Sie nicht Opfer eines KI-Sprachbetrugs werden. Dies ist besonders für ältere Familienmitglieder nützlich und kann, wenn es nie aufgeschrieben wird, recht einfach gehalten werden.

Es ist auch wichtig, mit den neuesten Methoden, Techniken und Formaten Schritt zu halten, die KI-Sprachbetrüger verwenden, um Opfer zu erpressen. Neben der Wachsamkeit und dem Umgang mit Anrufen von unbekannten Nummern mit äußerster Vorsicht ist es oft das Beste, das Ohr offen zu halten.