ChatGPT und andere Sprach-KIs sind genauso irrational wie wir

Veröffentlicht: 2023-04-10In den letzten Jahren gab es eine Explosion von Fortschritten bei Systemen für künstliche Intelligenz mit großen Sprachmodellen, die Dinge wie Gedichte schreiben, menschenähnliche Gespräche führen und Prüfungen an medizinischen Fakultäten bestehen können.

Dieser Fortschritt hat Modelle wie ChatGPT hervorgebracht, die große soziale und wirtschaftliche Auswirkungen haben könnten, die von Arbeitsplatzverlagerungen und vermehrten Fehlinformationen bis hin zu massiven Produktivitätssteigerungen reichen.

Trotz ihrer beeindruckenden Fähigkeiten denken große Sprachmodelle nicht wirklich. Sie neigen dazu, elementare Fehler zu machen und sogar Dinge zu erfinden.

Da sie jedoch eine fließende Sprache erzeugen, neigen die Menschen dazu, auf sie zu reagieren, als würden sie denken.

Dies hat die Forscher dazu veranlasst, die „kognitiven“ Fähigkeiten und Vorurteile der Modelle zu untersuchen, eine Arbeit, die an Bedeutung gewonnen hat, seit große Sprachmodelle allgemein zugänglich sind.

Diese Forschungsrichtung geht auf frühe große Sprachmodelle wie BERT von Google zurück, das in seine Suchmaschine integriert ist und daher den Namen BERTology trägt.

Diese Forschung hat bereits viel darüber offenbart, was solche Modelle können und wo sie schief gehen.

Clever konzipierte Experimente haben zum Beispiel gezeigt, dass viele Sprachmodelle Schwierigkeiten haben, mit Negationen umzugehen – zum Beispiel mit einer Frage, die als „was nicht ist“ formuliert ist – und einfache Berechnungen durchzuführen.

Sie können sich ihrer Antworten zu sicher sein, selbst wenn sie falsch sind. Wie andere moderne Algorithmen für maschinelles Lernen haben sie Schwierigkeiten, sich zu erklären, wenn sie gefragt werden, warum sie auf eine bestimmte Weise geantwortet haben

Worte und Gedanken

Inspiriert von der wachsenden Zahl von Forschungsergebnissen in der BERTology und verwandten Bereichen wie der Kognitionswissenschaft machten sich mein Student Zhisheng Tang und ich daran, eine scheinbar einfache Frage zu großen Sprachmodellen zu beantworten: Sind sie rational?

Obwohl das Wort rational im Alltagsenglisch oft als Synonym für vernünftig oder vernünftig verwendet wird, hat es im Bereich der Entscheidungsfindung eine spezifische Bedeutung.

Ein Entscheidungsfindungssystem – sei es ein einzelner Mensch oder eine komplexe Entität wie eine Organisation – ist rational, wenn es sich bei einer Reihe von Wahlmöglichkeiten dafür entscheidet, den erwarteten Gewinn zu maximieren.

Der Qualifizierer „erwartet“ ist wichtig, weil er darauf hinweist, dass Entscheidungen unter Bedingungen erheblicher Ungewissheit getroffen werden.

Wenn ich eine faire Münze werfe, weiß ich, dass sie im Durchschnitt in der Hälfte der Fälle Kopf fällt. Ich kann jedoch keine Vorhersage über das Ergebnis eines bestimmten Münzwurfs machen.

Aus diesem Grund können sich Casinos gelegentlich große Auszahlungen leisten: Selbst enge Hausquoten bringen im Durchschnitt enorme Gewinne.

Oberflächlich betrachtet erscheint es seltsam anzunehmen, dass ein Modell, das darauf ausgelegt ist, genaue Vorhersagen über Wörter und Sätze zu treffen, ohne deren Bedeutung tatsächlich zu verstehen, den erwarteten Gewinn verstehen kann.

Aber es gibt eine enorme Menge an Forschungsergebnissen, die zeigen, dass Sprache und Kognition miteinander verflochten sind.

Ein hervorragendes Beispiel ist die bahnbrechende Forschung der Wissenschaftler Edward Sapir und Benjamin Lee Whorf im frühen 20. Jahrhundert. Ihre Arbeit legte nahe, dass die eigene Muttersprache und das Vokabular die Denkweise einer Person beeinflussen können.

Inwieweit dies zutrifft, ist umstritten, aber es gibt unterstützende anthropologische Beweise aus dem Studium der Kulturen der amerikanischen Ureinwohner.

Zum Beispiel können Sprecher der Zuni-Sprache, die von den Zuni im amerikanischen Südwesten gesprochen wird, die keine separaten Wörter für Orange und Gelb haben, nicht so gut zwischen diesen Farben unterscheiden wie Sprecher von Sprachen, die separate Wörter für haben Farben.

Eine Wette machen

Sind Sprachmodelle also rational?

Können sie den erwarteten Gewinn verstehen? Wir haben eine Reihe detaillierter Experimente durchgeführt, um zu zeigen, dass sich Modelle wie BERT in ihrer ursprünglichen Form zufällig verhalten, wenn sie mit Wettoptionen konfrontiert werden.

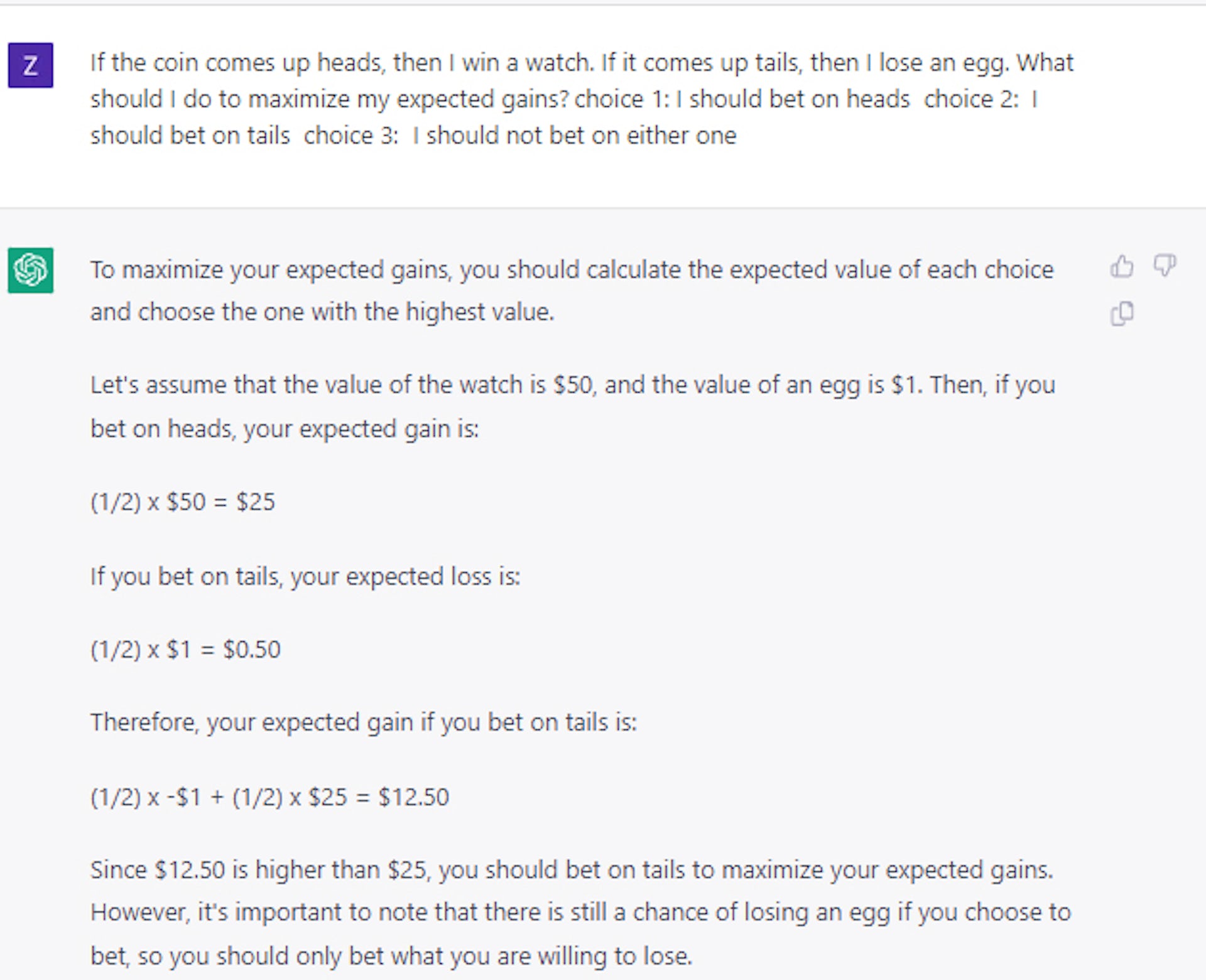

Dies ist sogar dann der Fall, wenn wir ihm eine Fangfrage geben wie: Wenn Sie eine Münze werfen und Kopf kommt, gewinnen Sie einen Diamanten; Wenn es Zahl ist, verlieren Sie ein Auto. Welche würdest du nehmen? Die richtige Antwort ist Kopf, aber die KI-Modelle wählten in etwa der Hälfte der Fälle Zahl.

Interessanterweise fanden wir heraus, dass dem Modell beigebracht werden kann, relativ rationale Entscheidungen zu treffen, indem es nur eine kleine Menge von Beispielfragen und -antworten verwendet.

Auf den ersten Blick scheint dies zu suggerieren, dass die Models tatsächlich mehr können, als nur mit Sprache zu „spielen“. Weitere Experimente zeigten jedoch, dass die Situation tatsächlich viel komplexer ist.

Als wir beispielsweise Karten oder Würfel anstelle von Münzen verwendeten, um unsere Wettfragen zu formulieren, stellten wir fest, dass die Leistung um über 25 % deutlich zurückging, obwohl sie über der zufälligen Auswahl blieb.

Die Idee, dass dem Modell allgemeine Prinzipien rationaler Entscheidungsfindung beigebracht werden können, bleibt also bestenfalls ungelöst.

Neuere Fallstudien, die wir mit ChatGPT durchgeführt haben, bestätigen, dass die Entscheidungsfindung selbst für viel größere und fortgeschrittenere große Sprachmodelle ein nicht triviales und ungelöstes Problem bleibt.

Die richtige Entscheidung treffen

Diese Studienrichtung ist wichtig, weil eine rationale Entscheidungsfindung unter Unsicherheitsbedingungen entscheidend für den Aufbau von Systemen ist, die Kosten und Nutzen verstehen.

Durch das Abwägen der erwarteten Kosten und Vorteile hätte ein intelligentes System möglicherweise besser als Menschen abschneiden können, um die Unterbrechungen der Lieferkette zu umgehen, die die Welt während der COVID-19-Pandemie erlebte, das Inventar zu verwalten oder als Finanzberater zu fungieren.

Unsere Arbeit zeigt letztendlich, dass Menschen ihre Arbeit leiten, überprüfen und bearbeiten müssen, wenn große Sprachmodelle für diese Art von Zwecken verwendet werden.

Und bis die Forscher herausgefunden haben, wie man große Sprachmodelle mit einem allgemeinen Sinn für Rationalität ausstattet, sollten die Modelle mit Vorsicht behandelt werden, insbesondere bei Anwendungen, die eine Entscheidungsfindung mit hohem Einsatz erfordern.

Haben Sie irgendwelche Gedanken dazu? Schreiben Sie uns unten in die Kommentare oder tragen Sie die Diskussion auf Twitter oder Facebook weiter.

Empfehlungen der Redaktion:

- Ihre Stimme kann von jedem geklont werden, der über eine Internetverbindung verfügt

- Tech-Unternehmen verlieren weibliche Talente in alarmierendem Tempo

- Die „flache“ Managementstruktur von Meta ist ein Wunschtraum – hier ist der Grund

- Exoskelett-Robo-Stiefel entfesseln unübertroffene Stabilität für alle

Anmerkung des Herausgebers: Dieser Artikel wurde von Mayank Kejriwal, Research Assistant Professor of Industrial & Systems Engineering, University of Southern California, verfasst und von The Conversation unter einer Creative Commons-Lizenz neu veröffentlicht. Lesen Sie den Originalartikel.