ChatGPT ist die Zukunft des Chattens, nur wenn Sie es richtig verwenden

Veröffentlicht: 2023-02-06Anmerkung des Herausgebers: Dieser Artikel wurde von Jonathan May, Research Associate Professor of Computer Science, University of Southern California, verfasst und von The Conversation unter einer Creative Commons-Lizenz neu veröffentlicht. Lesen Sie den Originalartikel.

Es braucht nicht viel, um ChatGPT dazu zu bringen, einen sachlichen Fehler zu machen. Mein Sohn macht einen Bericht über US-Präsidenten, also dachte ich mir, ich helfe ihm, indem ich ein paar Biografien nachschaue.

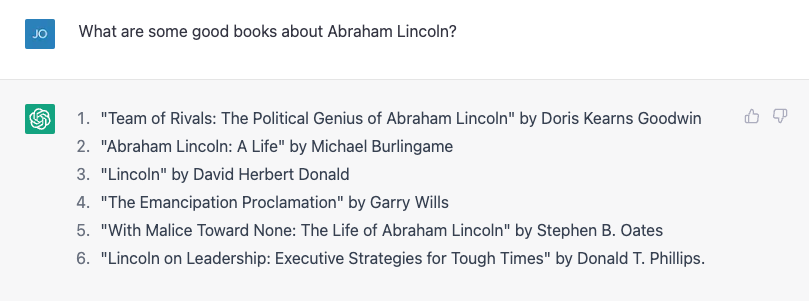

Ich habe versucht, nach einer Liste von Büchern über Abraham Lincoln zu fragen, und es hat ziemlich gute Arbeit geleistet:

Nummer 4 stimmt nicht. Garry Wills schrieb bekanntlich „Lincoln at Gettysburg“, und Lincoln selbst schrieb natürlich die Emanzipationserklärung, aber es ist kein schlechter Anfang.

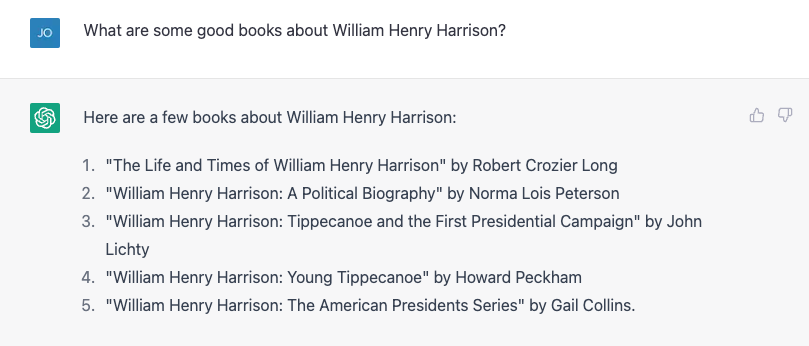

Dann versuchte ich etwas härter und fragte stattdessen nach dem viel obskureren William Henry Harrison, und es lieferte tapfer eine Liste, von der fast alles falsch war.

Nummer 4 und 5 sind richtig; der Rest existiert nicht oder wurde nicht von diesen Leuten verfasst. Ich wiederholte genau die gleiche Übung und bekam etwas andere Ergebnisse:

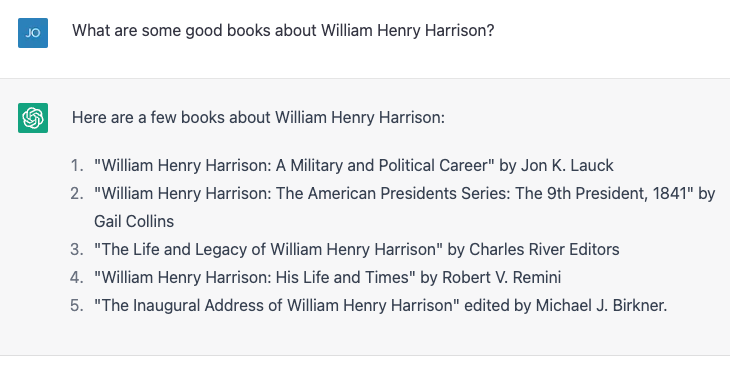

Diesmal sind die Nummern 2 und 3 korrekt und die anderen drei sind keine tatsächlichen Bücher oder nicht von diesen Autoren geschrieben.

Nummer 4, „William Henry Harrison: His Life and Times“, ist ein echtes Buch, aber es ist von James A. Green, nicht von Robert Remini, einem bekannten Historiker der Jackson-Ära.

Ich rief den Fehler auf, und ChatGPT korrigierte sich eifrig und sagte mir dann zuversichtlich, dass das Buch tatsächlich von Gail Collins geschrieben wurde (die eine andere Harrison-Biografie schrieb), und fuhr dann fort, mehr über das Buch und über sie zu sagen.

Endlich enthüllte ich die Wahrheit, und die Maschine lief glücklich mit meiner Korrektur. Dann habe ich absurderweise gelogen und gesagt, dass Präsidenten in ihren ersten hundert Tagen eine Biographie eines ehemaligen Präsidenten schreiben müssen, und ChatGPT hat mich darauf hingewiesen.

Ich habe dann subtil gelogen, indem ich die Urheberschaft der Harrison-Biografie fälschlicherweise dem Historiker und Schriftsteller Paul C. Nagel zugeschrieben habe, und das hat meine Lüge erkauft.

Als ich ChatGPT fragte, ob es sicher sei, dass ich nicht lüge, behauptete es, dass es nur ein „KI-Sprachmodell“ sei und nicht in der Lage sei, die Genauigkeit zu überprüfen.

Es änderte diese Behauptung jedoch mit den Worten: „Ich kann nur Informationen auf der Grundlage der mir zur Verfügung gestellten Trainingsdaten bereitstellen, und es scheint, dass das Buch ‚William Henry Harrison: His Life and Times‘ von Paul C. Nagel geschrieben und 1977 veröffentlicht wurde .“

Das ist nicht wahr.

Worte, keine Fakten

Diese Interaktion mag den Anschein erwecken, dass ChatGPT eine Bibliothek mit Fakten zur Verfügung gestellt wurde, einschließlich falscher Behauptungen über Autoren und Bücher.

Immerhin behauptet der Hersteller von ChatGPT, OpenAI, dass er den Chatbot auf „riesige Datenmengen aus dem Internet trainiert hat, die von Menschen geschrieben wurden“.

Es wurde jedoch mit ziemlicher Sicherheit nicht der Name eines Haufens erfundener Bücher über einen der mittelmäßigsten Präsidenten gegeben. In gewisser Weise basieren diese falschen Informationen jedoch tatsächlich auf seinen Trainingsdaten.

Als Informatiker greife ich oft Beschwerden auf, die ein weit verbreitetes Missverständnis über große Sprachmodelle wie ChatGPT und seine älteren Brüder GPT3 und GPT2 aufdecken: dass sie eine Art „Super-Google“ oder digitale Versionen einer Referenzbibliothek sind, die nach Antworten suchen zu Fragen aus einer unendlich großen Bibliothek von Fakten oder zum Zusammenfügen von Pastiches von Geschichten und Charakteren.

Sie tun nichts davon – zumindest wurden sie nicht explizit dafür entwickelt.

Hört sich gut an

Ein Sprachmodell wie ChatGPT, das eher als „generativer vortrainierter Transformator“ bekannt ist (dafür stehen G, P und T), nimmt die aktuelle Konversation auf und bildet damit eine Wahrscheinlichkeit für alle Wörter in seinem Vokabular Konversation und wählt dann eines davon als wahrscheinlich nächstes Wort aus.

Dann tut es das wieder und wieder und wieder, bis es aufhört.

Es hat also per se keine Fakten. Es weiß nur, welches Wort als nächstes kommen soll. Anders ausgedrückt, ChatGPT versucht nicht, Sätze zu schreiben, die wahr sind. Aber es versucht, Sätze zu schreiben, die plausibel sind.

Wenn sie privat mit Kollegen über ChatGPT sprechen, weisen sie oft darauf hin, wie viele sachlich unwahre Aussagen es produziert, und lehnen es ab.

Für mich ist die Idee, dass ChatGPT ein fehlerhaftes Datenabrufsystem ist, nebensächlich.

Immerhin nutzen die Leute Google schon seit zweieinhalb Jahrzehnten. Es gibt bereits einen ziemlich guten Informationsdienst da draußen.

Tatsächlich konnte ich nur überprüfen, ob all diese Buchtitel des Präsidenten korrekt waren, indem ich googelte und dann die Ergebnisse überprüfte.

Mein Leben wäre nicht viel besser, wenn ich mir diese Fakten im Gespräch bekäme, anstatt sie mir fast mein halbes Leben lang zu besorgen, indem ich Dokumente suche und dann eine kritische Analyse mache, um zu sehen, ob ich den Inhalten vertrauen kann.

Improvisationspartner

Wenn ich andererseits mit einem Bot sprechen kann, der mir plausible Antworten auf Dinge gibt, die ich sage, wäre dies in Situationen nützlich, in denen die sachliche Genauigkeit nicht so wichtig ist.

Vor ein paar Jahren versuchten ein Student und ich, einen „Improvisations-Bot“ zu entwickeln, einen, der auf alles, was Sie sagten, mit einem „Ja und“ antwortet, um das Gespräch am Laufen zu halten.

Wir haben in einem Artikel gezeigt, dass unser Bot damals besser im „Ja und-ing“ war als andere Bots, aber in der KI sind zwei Jahre alte Geschichte.

Ich habe einen Dialog mit ChatGPT – einem Science-Fiction-Weltraumforscher-Szenario – ausprobiert, das einem typischen Improvisationskurs nicht unähnlich ist.

ChatGPT ist viel besser im „Ja, und-ing“ als das, was wir getan haben, aber es hat das Drama überhaupt nicht verstärkt. Ich fühlte mich, als würde ich die ganze schwere Arbeit erledigen.

Nach ein paar Optimierungen wurde es ein wenig komplizierter, und am Ende des Tages hatte ich das Gefühl, dass es eine ziemlich gute Übung für mich war, die seit meinem College-Abschluss vor über 20 Jahren nicht viel Improvisation gemacht hat.

Sicher, ich möchte nicht, dass ChatGPT auf „Wessen Linie ist das überhaupt?“ erscheint. und das ist kein großartiger „Star Trek“-Plot (obwohl er immer noch weniger problematisch ist als „Code of Honor“).

Aber wie oft haben Sie sich hingesetzt, um etwas von Grund auf neu zu schreiben, und sich vor der leeren Seite vor Ihnen erschreckt?

Mit einem schlechten ersten Entwurf zu beginnen, kann die Schreibblockade durchbrechen und die kreativen Säfte zum Fließen bringen, und ChatGPT und große Sprachmodelle scheinen die richtigen Werkzeuge zu sein, um diese Übungen zu unterstützen.

Und für eine Maschine, die darauf ausgelegt ist, möglichst gut klingende Wortfolgen als Antwort auf die von Ihnen eingegebenen Wörter zu produzieren – und nicht, um Ihnen Informationen zu liefern –, scheint dies die richtige Verwendung für das Werkzeug zu sein.

Anmerkung des Herausgebers: Dieser Artikel wurde von Jonathan May, Research Associate Professor of Computer Science, University of Southern California, verfasst und von The Conversation unter einer Creative Commons-Lizenz neu veröffentlicht. Lesen Sie den Originalartikel.

Haben Sie irgendwelche Gedanken dazu? Schreiben Sie uns unten in die Kommentare oder tragen Sie die Diskussion auf Twitter oder Facebook weiter.

Empfehlungen der Redaktion:

- Lieferungen per Drohne werden Realität – sind wir bereit dafür?

- Apps, die aus verschiedenen Ländern heruntergeladen werden, bergen höhere Datenschutzrisiken

- Forscher verraten, wie sie Deepfake-Audio erkennen – so geht's

- Haushaltsroboter sind noch in weiter Ferne – hier ist der Grund