Umfrage: ChatGPT und KI-Inhalte – Können Menschen den Unterschied erkennen?

Veröffentlicht: 2023-03-08Können Menschen den Unterschied zwischen menschlichen und KI-Autoren erkennen und wirkt sich dies auf ihr Vertrauen in Marken aus?

Künstliche Intelligenz (KI) kann jetzt bequem Bilder, Musik und Texte erstellen, die von einem talentierten Menschen hätten erstellt werden können. Die Welt der Online-Inhalte erlebt in den 2020er Jahren einen enormen Wandel. Dies wird stark durch den generativen Chatbot ChatGPT beeinflusst, der schnell wächst und in nur fünf Tagen seine ersten eine Million Nutzer erreicht.

Auch wenn Technikinteressierte viel über KI und Chatbots wie ChatGPT wissen, ist das nicht jedermanns Sache. Tatsächlich wissen manche Menschen möglicherweise nicht einmal, wie ausgefeilt die Ergebnisse von KI-Tools sind und ob das, was sie online lesen, von einem Menschen oder einer KI erstellt wurde.

Um mehr zu diesem Thema zu erfahren, haben wir über 1.900 Amerikaner befragt, um herauszufinden, was sie über KI-Inhalte im Internet denken, wie sich diese auf ihr Vertrauen in Marken auswirken und ob sie letztendlich den Unterschied zwischen KI und menschlichen Inhalten erkennen können. Wir haben die Menschen gebeten, zu erraten, ob Texte in den Bereichen Gesundheit, Finanzen, Unterhaltung, Technologie und Reisen von KI oder Menschen erstellt wurden. Erfahren Sie hier mehr über die Methodik dieser Studie.

Hier erfahren Sie, was die amerikanische Öffentlichkeit über KI-Inhalte im Internet denkt.

Wichtigste Erkenntnisse

- Über 53 % können Inhalte, die ausschließlich von KI-Chatbots wie ChatGPT erstellt wurden, nicht genau identifizieren . Bei Verwendung des GPT-4.0-Modells steigt dieser Wert auf 63,5 % .

- Im Durchschnitt ist das GPT-4.0-Sprachmodell 16,5 % besser als GPT-3.5, wenn es darum geht, Menschen davon zu überzeugen, dass eine KI-generierte Kopie von einem Menschen geschrieben wurde.

- KI-generierte Gesundheitsinhalte konnten die Nutzer am meisten täuschen : 56,1 % gingen fälschlicherweise davon aus, dass KI-Inhalte von einem Menschen geschrieben oder bearbeitet wurden.

- Im Technologiesektor haben die Leser KI-generierte Inhalte am häufigsten richtig erraten , dem einzigen Sektor, in dem mehr als die Hälfte (51 %) KI-generierte Inhalte richtig identifiziert haben.

- Mit GPT-4.0 wurden technische Inhalte auch korrekterweise am häufigsten als KI-generiert identifiziert (60,3 %) .

- GPT-4.0- KI-Inhalte waren beim Reisen am wenigsten erkennbar , da 66,5 % der Leser der Meinung waren, dass die Inhalte von Menschen geschrieben wurden.

- Diejenigen, die mit KI-Tools wie ChatGPT besser vertraut sind , konnten KI-Inhalte geringfügig besser identifizieren , lagen jedoch immer noch nur in 48 % der Fälle richtig .

- Nur 40,8 % der Menschen, die mit generativer KI völlig unbekannt waren, konnten KI-Inhalte richtig identifizieren .

- Die Mehrheit der Menschen (80,5 %) ist der Meinung, dass Online-Publisher, die Blogs und Nachrichtenartikel veröffentlichen, ausdrücklich angeben sollten, ob KI an deren Erstellung beteiligt war .

- Mehr als sieben von zehn Befragten (71,3 %) gaben an, dass sie einer Marke weniger vertrauen würden, wenn sie unaufgefordert KI-generierte Inhalte erhalten würden.

- Die meisten Menschen (46,5 %) sagten, sie wären damit einverstanden, wenn KI sie zu Gesundheits- und Finanzthemen berät . 42,9 % gaben jedoch an, dass sie solche Ratschläge nur nutzen würden, wenn ein Mensch den Inhalt bearbeitet und überprüft hätte .

Können Menschen erkennen, ob Text von KI erstellt wird?

Um die Hauptfrage dieser Studie schnell zu beantworten: Nein, Menschen können den Unterschied zwischen KI-Inhalten und von Menschen geschriebenen Inhalten nicht erkennen .

Im Durchschnitt waren Menschen nur in 46,9 % der Fälle in der Lage, KI-geschriebene Inhalte richtig zu identifizieren. Bei der Verwendung von GPT-4.0 anstelle von GPT-3.5 konnten nur 36,5 % der Leser KI-geschriebene Inhalte korrekt identifizieren.

Dies variierte je nach Thema des Inhalts, den sie lasen, aber im Allgemeinen konnten die Leute KI in fast der Hälfte der Fälle identifizieren. Das bedeutet allerdings, dass KI-Inhalte für mehr als die Hälfte der Leser nicht erkennbar sind.

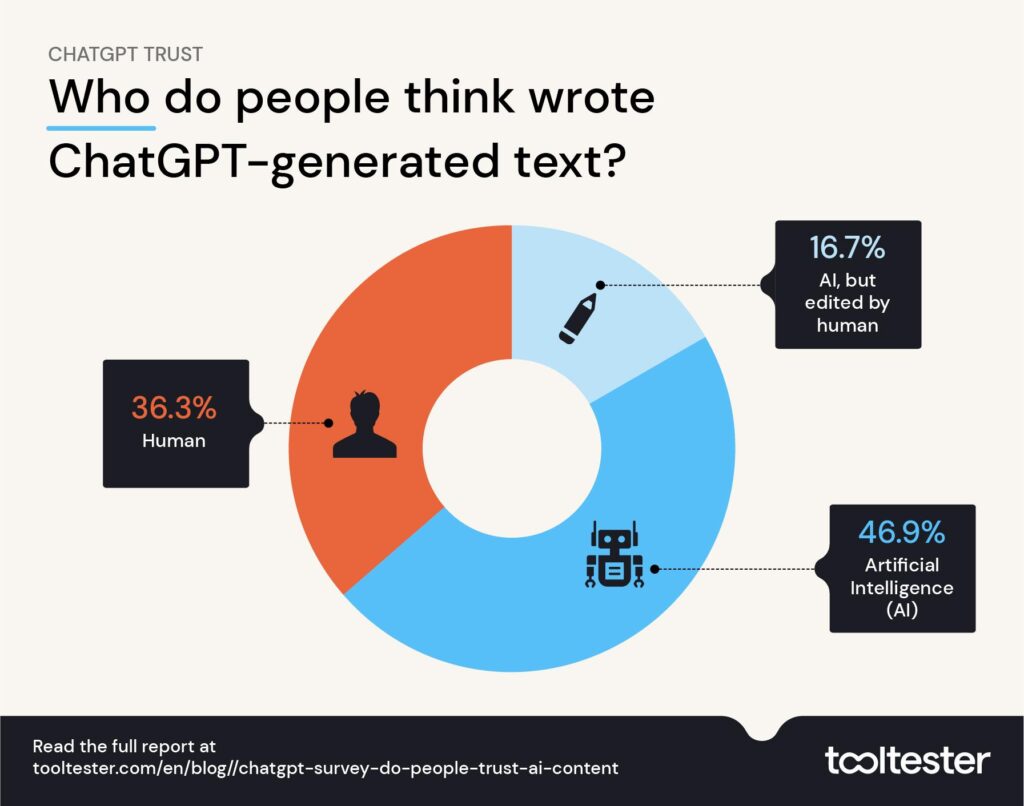

Bei näherer Betrachtung stellen wir jedoch fest, dass 36,3 % der Befragten der Meinung waren, dass KI-Inhalte tatsächlich von einem Menschen geschrieben wurden, während 16,7 % dachten, es handele sich um KI-Inhalte, die später von einem Menschen bearbeitet wurden.

Letztendlich lasen mehr als die Hälfte (53 %) KI-geschriebene Inhalte und gingen davon aus, dass irgendwann ein Mensch beteiligt war – so überzeugend kann es direkt aus dem Tool heraus wirken, bevor ein menschlicher Autor noch Flair und Persönlichkeit hinzufügt.

GPT-3.5 vs. GPT-4.0: Welches Modell produziert überzeugendere Kopien?

Die Originalversion dieser Studie wurde vor der Einführung von GPT-4.0 am 14. März 2023 erstellt. Danach haben wir unsere Ergebnisse durch eine erneute Leserbefragung aktualisiert.

Wir verwendeten dieselben Themen und Eingabeaufforderungen, befragten dieses Mal jedoch Befragte, die von ChatGPT erstellte Inhalte mit GPT-4.0 anstelle des 3.5-Modells verwendeten.

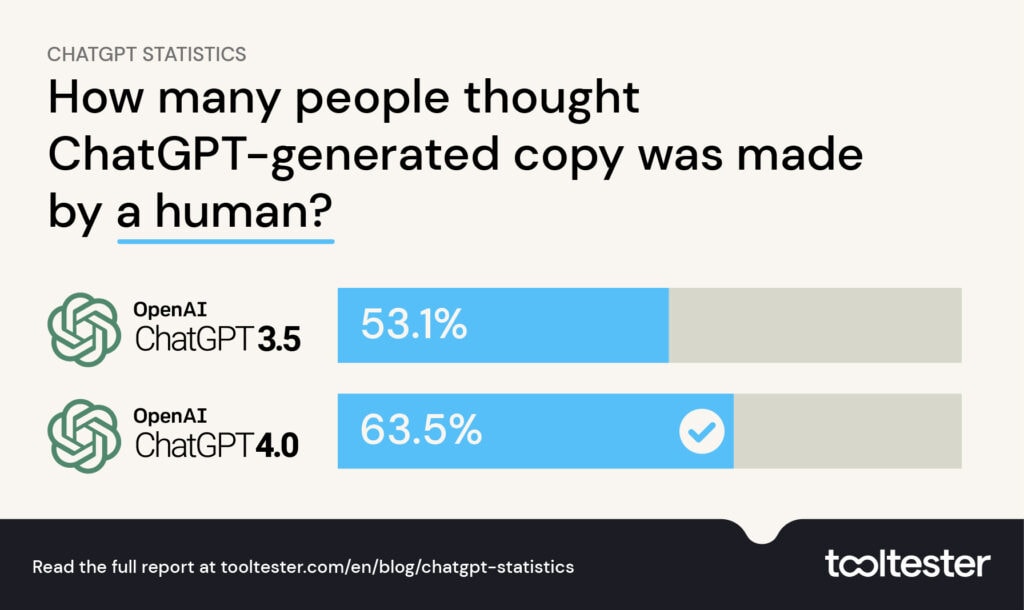

Wir haben festgestellt, dass die Zahl der Menschen, die glaubten, dass KI-generierte Inhalte von Menschen erstellt wurden, um 16,5 % zunahm, als wir GPT-4.0 verwendeten.

Mit GPT-3.5 haben wir herausgefunden, dass 53,1 % der Menschen dachten, dass das Verfassen von ChatGPT-Texten ein Mensch sei, während mit GPT-4.0 63,5 % der Leute glaubten, dass der Inhalt von einem menschlichen Autor erstellt oder bearbeitet wurde.

Ist ChatGPT besser darin, über bestimmte Themen zu schreiben?

Eine Frage, die diese Studie beantworten wollte, ist, ob ChatGPT besser darin ist, menschlichere Inhalte zu verschiedenen Themen zu schreiben. Aus unseren Erkenntnissen geht hervor, dass der KI-Chatbot besser darin ist, überzeugendere Gesundheitsinhalte zu schreiben, und dass sein Technologietext von der breiten Öffentlichkeit leichter erkannt wird.

Hier ein Überblick darüber, wie die KI-Inhalte bei der Generierung von Texten zu verschiedenen Themen von der breiten Öffentlichkeit wahrgenommen wurden:

| Wer hat die von ChatGPT generierten Inhalte geschrieben? | |||

|---|---|---|---|

| KI | Menschlich | KI, bearbeitet von einem Menschen | |

| Technik | 51,05 % | 32,97 % | 15,98 % |

| Unterhaltung | 47,28 % | 36,30 % | 16,41 % |

| Reisen | 46,72 % | 36,80 % | 16,50 % |

| Finanzen | 45,75 % | 37,17 % | 17,07 % |

| Gesundheit | 43,94 % | 38,40 % | 17,70 % |

Da diese Studie inzwischen aktualisiert wurde, können wir auch die Ergebnisse von GPT-3.5 und GPT-4.0 vergleichen, wenn es um Inhalte zu verschiedenen Themen geht. Genau wie GPT-3.5 wurde bei der Verwendung von GPT-4.0 das Sprachmodell am häufigsten in Technologieinhalten erkannt (39,7 %).

Reiseinhalte waren bei GPT-4.0 am wenigsten erkennbar , da 66,5 % der Leser glaubten, dass sie von Menschen stammen oder von Menschen bearbeitet wurden. Während Gesundheitsinhalte bei GPT-3,5 (56,1 %) am wenigsten erkennbar waren.

Wie glaubwürdig ist die von ChatGPT generierte Kopie?

Die folgende Tabelle zeigt den Prozentsatz der Personen, die dachten, dass die von ChatGPT generierte Kopie sowohl in GPT-3.5 als auch in GPT-4.0 von einer KI oder einem Menschen erstellt oder von einem Menschen bearbeitet wurde.

| GPT-3.5 | GPT-4.0 | GPT-3.5 | GPT-4.0 | |

|---|---|---|---|---|

| KI | KI | Von Menschen oder von Menschen bearbeitet | Von Menschen oder von Menschen bearbeitet | |

| Technik | 51,1 % | 39,7 % | 49,0 % | 60,3 % |

| Unterhaltung | 47,3 % | 34,1 % | 52,7 % | 65,9 % |

| Reisen | 46,7 % | 33,5 % | 53,3 % | 66,5 % |

| Finanzen | 45,8 % | 36,8 % | 54,2 % | 63,2 % |

| Gesundheit | 43,9 % | 37,8 % | 56,1 % | 62,2 % |

Nachfolgend haben wir die Sektoren weiter aufgeschlüsselt, damit Sie sehen können, wie gut ChatGPT menschlich klingende Inhalte zu verschiedenen Themen produziert.

Je vertrauter Sie mit KI-Tools sind, desto wahrscheinlicher ist es, dass Sie KI-Inhalte erkennen – allerdings nur geringfügig

Diejenigen, die angaben, mit KI-Tools wie ChatGPT vertraut zu sein, waren geringfügig besser darin, KI-Inhalte zu finden, lagen jedoch immer noch nur in 48 % der Fälle richtig.

Diese Fähigkeit, KI-Schreiben zu erkennen, sinkt um 7,2 % auf 40,8 %, wenn man sich Menschen ansieht, die angaben, noch nie von generativer KI gehört zu haben, was darauf hindeutet, dass Menschen die Fähigkeit erlangen können, Trends und Muster in KI-generierten Inhalten zu erkennen.

Insgesamt gab es keinen statistischen Unterschied zwischen Männern und Frauen bei der KI-Inhaltserkennung.

Wie überzeugend ist KI-Schreiben in verschiedenen Branchen?

In unserer Studie wurden Menschen in fünf Schlüsselsektoren dazu befragt, ob die Inhalte, die sie lasen, von einer KI erstellt wurden oder nicht. Im Folgenden finden Sie eine Aufschlüsselung der Ergebnisse der einzelnen Inhaltsgenres: Unterhaltung, Finanzen, Reisen, Technologie und Gesundheit.

Die Leser konnten KI in Technologieinhalten am häufigsten erkennen

Unsere Technologiefragen gaben Benutzern Antworten auf Fragen zu Mobiltelefonen, Computerhardware, Smart Tech, KI und Internetanbietern.

Im Durchschnitt konnten 51 % der Nutzer richtig erraten, ob die KI-geschriebenen Antworten tatsächlich von KI erstellt wurden, während ein Drittel (33 %) der Meinung war, dass derselbe Inhalt von Menschen erstellt wurde. Die restlichen 16 % waren sich nicht sicher und vermuteten, dass es sich um eine Form von KI-Inhalten handelte, die später von Menschen bearbeitet wurden.

Insgesamt hatten Technologieinhalte den höchsten Prozentsatz (51 %) an Nutzern, die die KI-Inhalte richtig identifizierten. Bei Frauen war die Wahrscheinlichkeit, KI-geschriebene technische Inhalte richtig zu identifizieren, etwas höher als bei Männern (52,4 % gegenüber 49,9 %).

Wenn es um von Menschen geschriebene technische Inhalte ging, konnten nur 36 % der Menschen erkennen, dass sie von einem Menschen geschrieben wurden, wobei die Mehrheit (48,4 %) davon überzeugt war, dass KI sie geschrieben hatte, während die restlichen 15,6 % fälschlicherweise glaubten, dass wahrscheinlich ein Mensch sie bearbeitet hatte KI-geschriebene Inhalte.

Von KI geschriebene Unterhaltungsinhalte täuschen am ehesten 18- bis 24-Jährige

Wenn es um Unterhaltungstexte ging, insbesondere um Textabschnitte, in denen es um Filme, Theater, Videospiele, Streaming und Musik ging, konnten 47,3 % der Befragten KI-Inhalte richtig identifizieren. Die 18- bis 24-Jährigen glaubten am häufigsten, dass KI-geschriebene Inhalte von einem Menschen geschrieben wurden (41,1 %), verglichen mit dem Gesamtdurchschnitt von 36,3 %.

Wenn es um von Menschen geschriebene Unterhaltungsinhalte ging, folgte ein ähnlicher Trend, da eine große Mehrheit (44,8 %) dachte, dass sie von einer KI geschrieben worden sein müssten, und etwas weniger (38,9 %) vermuteten richtig, dass es sich um einen menschlichen Autor handelte.

Diese Verwirrung folgt dem allgemeinen Trend, dass Menschen den Unterschied zwischen KI und von Menschen geschriebenen Inhalten nicht genau erkennen können.

Reisen

Wenn es um Online-Reiseberichte ging, testeten wir die Befragten mit Inhalten über die Suche nach günstigen Flügen und Hotels, die Vorbereitung auf Outdoor-Reisen, Tipps für die Anmietung eines Mietwagens und Meinungen zur Nutzung von Reisebüros.

Im ziemlich genauen Durchschnitt identifizierten 47 % der Menschen den KI-Text richtig, aber 35,9 % gaben an, dass er von einem Menschen geschrieben wurde.

Von Menschen erstellte Reiseinhalte polarisierten die Leser jedoch stark. Die Mehrheit (41,6 %) vermutete richtig, dass der Text von einem Menschen und nicht von einer KI geschrieben wurde, allerdings war ein ähnlich großer Anteil (40,5 %) der Leser der Meinung, dass derselbe Inhalt von einer KI erstellt werden müsste.

Finanzen

Wenn es um Finanzinhalte ging, konnten die Menschen KI-Inhalte gut erkennen und sie in etwa 45,8 % der Fälle richtig machen. Allerdings waren 37,2 % immer noch der Meinung, dass derselbe KI-Text von einem Menschen erstellt werden musste.

Bei von Menschen geschriebenen Inhalten waren 42,5 % davon überzeugt, dass sie von einer KI geschrieben wurden, während 40,5 % richtig vermuteten, dass sie von einem menschlichen Geist erstellt wurden.

KI-generierte Gesundheitsinhalte konnten 53,1 % der Nutzer täuschen

Wenn es um Gesundheitsinhalte ging, gaben wir den Nutzern Texte über die Kosten für Hüftprothesen, die Gefahren von Paracetamol, psychische Erkrankungen, Fitnesspläne und Vorsorgeuntersuchungen.

In diesem Fall glaubte der größte Teil der Leser der Studie (38,4 %), dass der KI-Inhalt von einem Menschen geschrieben wurde, während 43,9 % davon überzeugt waren, dass es sich um KI handelte. Die restlichen 17,7 % glaubten, es handele sich um von Menschen bearbeiteten KI-Text.

Von Menschen erstellte und von Medizinern überprüfte Gesundheitsinhalte konnten die Leser nicht überzeugen. Im Allgemeinen gingen die meisten Menschen (44,9 %) bei von Menschen erstellten Inhalten in diesem Bereich davon aus, dass sie von KI generiert wurden, während 37,9 % der Meinung waren, dass sie von einem Menschen erstellt wurden. Interessanterweise bedeutet dies, dass etwas mehr Menschen den KI-Gesundheitsinhalt für menschlicher hielten als tatsächlich von Menschen geschriebene Inhalte.

Von den fünf Sektoren, die wir in dieser Studie untersucht haben, verwirrten durch KI generierte Gesundheitsinhalte die Benutzer am meisten. Dies könnte sehr gefährlich sein, da wir uns auf eine Welt zubewegen, in der KI wahrscheinlich in mehr Teile unseres Lebens Einzug halten wird, einschließlich des Gesundheitswesens.

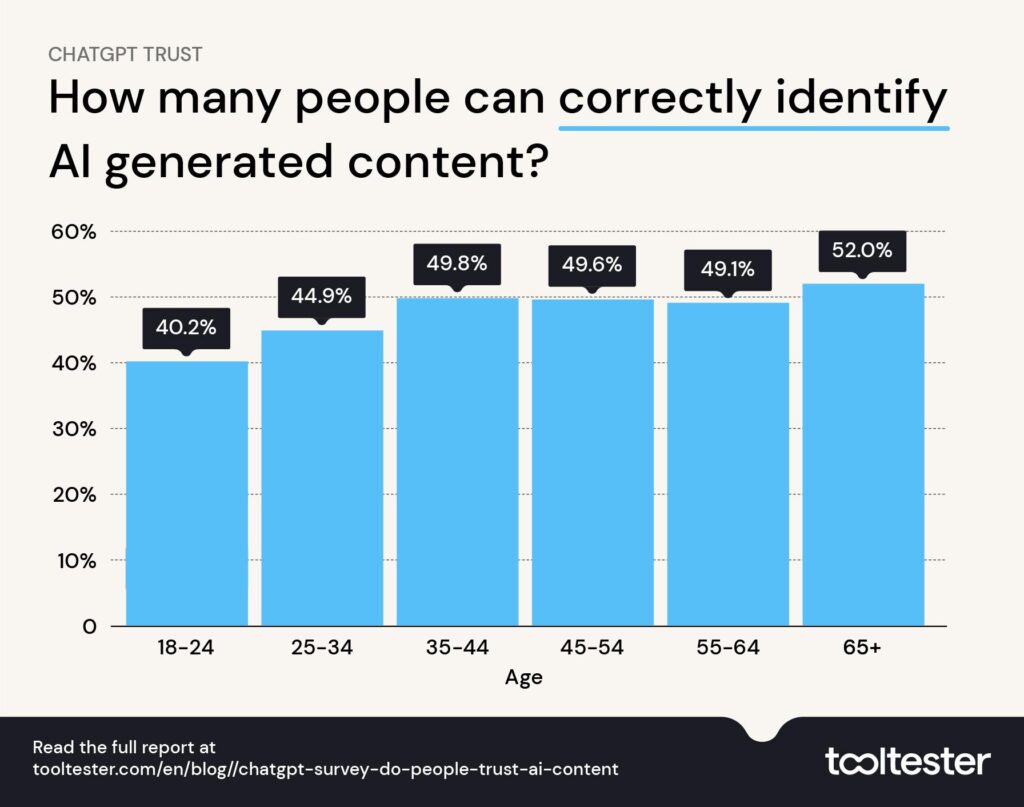

Jüngere Menschen haben größere Schwierigkeiten, KI-Inhalte zu erkennen

In der gesamten Studie waren die jüngsten Befragten im Allgemeinen am schlechtesten bei der Identifizierung von KI-geschriebenen Inhalten , wobei nur 2 von 5 (40,2 %) der 18- bis 24-Jährigen richtig geraten haben. Während die über 65-Jährigen zynischer waren und KI-Inhalte in mehr als der Hälfte der Fälle (52 %) richtig identifizierten.

Vertrauen Menschen KI-geschriebenen Inhalten?

Wenn Content-Herausgeber wie Blogger, Zeitungen und Zeitschriften KI-Inhalte veröffentlichen würden, ohne den Benutzern Bescheid zu geben (was einige getan haben, manchmal sogar voller Fehler), wollten wir wissen, was der normale Leser darüber denken würde.

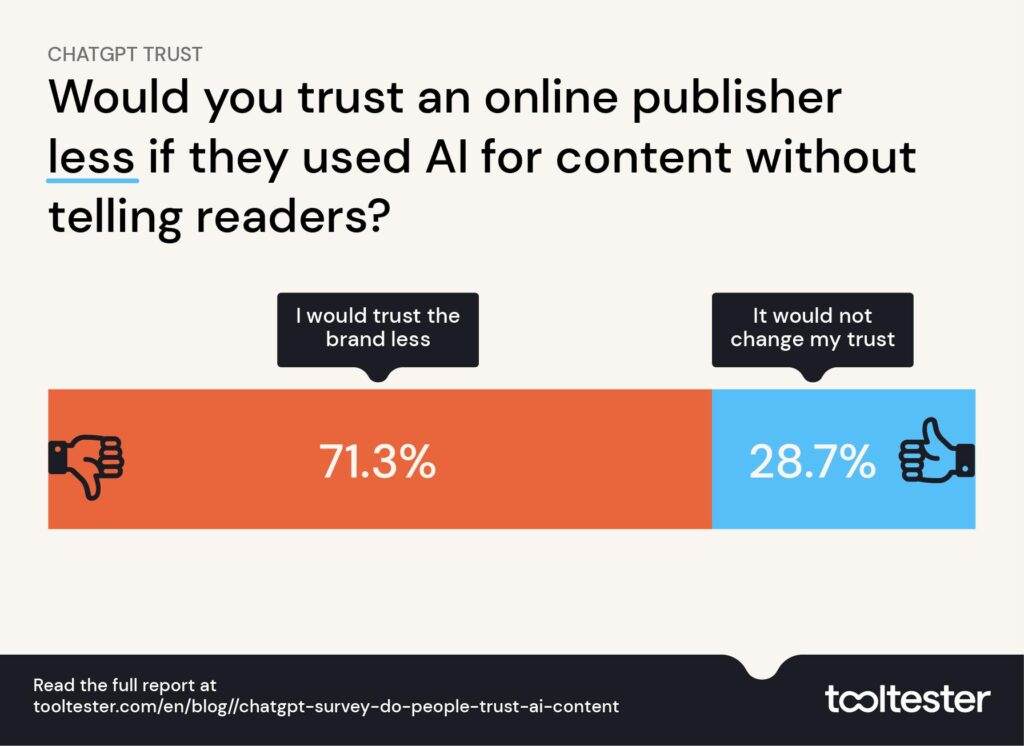

Die Mehrheit unserer Befragten (80,5 %) gab an, dass sie der Meinung sind, dass die Offenlegung von KI online die Norm sein sollte und Verlage die Menschen darauf aufmerksam machen sollten.

Es überrascht daher nicht, dass 71,3 % auch sagten, sie würden einer Marke weniger vertrauen, wenn sie KI-Inhalte veröffentlichen würde, ohne dies ausdrücklich zu sagen. Die restlichen 28,7 % sagten jedoch, dass dies ihr Vertrauen in eine Marke nicht beeinträchtigen würde, was darauf hindeutet, dass möglicherweise nicht jedem gesagt werden muss, woher seine Online-Inhalte stammen.

Wenn es um die Auswirkungen ging, die diese Enthüllungen auf die Leser haben könnten, verhielt es sich ähnlich. Eine etwas kleinere Mehrheit (67,8 %) gab an, dass sie einer Marke mehr vertrauen würde, wenn KI-Offenlegungen in einem Online-Inhalt vorhanden wären, während knapp ein Drittel (32,2 %) sagte, dass sich dies weder positiv noch negativ auf ihr Vertrauen auswirken würde.

Insgesamt deuten die Daten darauf hin, dass die meisten Menschen Marken bevorzugen würden, die explizit offenlegen, wie und wo KI zur Erstellung ihrer Inhalte eingesetzt wurde. Ob dies in der Welt der Online-Inhalte zur Norm wird, bleibt abzuwarten.

Methodik

1.920 amerikanische Erwachsene aller Altersgruppen wurden befragt und gebeten, zu entscheiden, ob ein Text von einer KI, einem Menschen, oder von einer KI erstellt und von einem Menschen bearbeitet wurde. Diese Frage wurde anhand von 75 Einzeltexten gestellt und für diese Analyse wurden 3.166 Antworten gesammelt. Die Umfragedaten wurden vom 20.02.2023 bis zum 26.02.2023 erhoben.

Die Umfrageteilnehmer wurden gefragt, wie vertraut sie mit KI und KI-Inhalten sind. Die Mehrheit der Personen in dieser Umfrage hat mindestens einmal irgendeine Form von KI-Tool ausprobiert, dazu gehört auch ChatGPT, aber möglicherweise nicht ChatGPT.

- 57,1 % unseres Publikums hatten mindestens einmal ein generatives KI-Tool ausprobiert

- 41,1 % hatten in irgendeiner Form davon gehört, es aber nie persönlich genutzt

- 1,8 % hatten vor der Teilnahme an der Umfrage noch nie von generativer KI gehört

In der Analyse wurden 25 Fragen mit drei Antworten pro Frage verwendet: eine von KI (ChatGPT), eine von einem menschlichen Journalisten verfasste und eine weitere von KI erstellte und dann von einem menschlichen professionellen Texter bearbeitete. Die Fragen und Antworten der Benutzer wurden vollständig zufällig ausgewählt, sodass sie nicht mehr als eine Antwort pro Frage sehen konnten.

Der Inhalt wurde durch Auswahl häufig gesuchter (bestimmt durch das Google-Suchvolumen) Fragen in den Bereichen Unterhaltung, Finanzen, Technologie, Reisen und Gesundheit ausgewählt.

ChatGPT erhielt die Aufforderung, als Experte zum jeweiligen Thema zu schreiben (z. B. als Reisejournalist oder Finanzmanager) und die Antworten „einfach“ zu erklären. Inhalte wurden aus der KI-Antwort entfernt, wenn daraus ersichtlich war, dass sie von einer KI geschrieben wurden, wie zum Beispiel „Okay, ich gebe vor, ein Finanzmanager zu sein, und das ist es, was ich sagen würde“. Von Menschen verfasste Inhalte wurden von Expertenseiten bezogen, die ausführliche Inhalte zu der jeweiligen Frage erstellt hatten. Websites, die die Verwendung von KI in ihren Inhalten offengelegt hatten, wurden für diese Analyse nicht herangezogen. Beispiele für Fragen und Antworten der Umfrageteilnehmer finden Sie hier.

GPT-4.0-Update zum Lernen

Um die Fähigkeiten von GPT-4.0 in ChatGPT zu bewerten, haben wir zwischen dem 22. und 25. März 2023 1.394 amerikanische Erwachsene befragt. Ihnen wurden die gleichen Fragen gestellt, ob ihrer Meinung nach ein Text von einer KI, einem Menschen oder bearbeitet wurde ein Mensch. Die Themen und Abfragen waren die gleichen wie in der GPT-3.5-Studie, Beispiele sind in der obigen Tabelle aufgeführt.

Andere KI-Ressourcen

Sie können heutzutage sogar KI verwenden, um Sie bei der Erstellung einer Website zu unterstützen! Weitere Informationen finden Sie in unserem Leitfaden zu den besten KI-Website-Erstellern.

Dieses Werk ist unter einer Creative Commons Attribution 4.0 International License lizenziert.