Feed-Forward-Neuronale Netze: Ein umfassender Leitfaden

Veröffentlicht: 2024-03-02

Willkommen zu unserem umfassenden Leitfaden zu Feed-Forward-Neuronalen Netzen. In der sich ständig weiterentwickelnden Szene des KI-Bewusstseins ist es von grundlegender Bedeutung, neuronale Netze zu verstehen. Neuronale Netze spiegeln den Aufbau und die Fähigkeiten des menschlichen Geistes wider und ermöglichen es PCs, Informationen zu nutzen und Entscheidungen auf eine Weise zu treffen, die der menschlichen Sichtweise ähnelt.

Diese Organisationen sind zur Grundlage verschiedener KI-Anwendungen geworden, die von der Bilderkennung bis zur normalen Sprachverarbeitung reichen. Wie dem auch sei, unter den zahlreichen neuronalen Netzwerkdesigns zeichnen sich Feed-Forward-Neuronale Netzwerke durch ihre Einfachheit und Lebensfähigkeit aus.

In diesem Leitfaden tauchen wir eingehend in die Komplexität von Feed-Forward-Brain-Organisationen ein und untersuchen deren Technik, Vorbereitungszyklen und Anwendungen. Daher sollten wir diesen Ausflug verlassen, um die Geheimnisse hinter Feed-Forward-Neuronalen Netzen zu entwirren und ihre Macht in den Bereich des KI-Bewusstseins zu verlagern.

Was ist ein Feed-Forward-Neuronales Netzwerk?

Willkommen zu unserer Untersuchung von Feed-Forward-Neuronalen Netzen, einem Hauptbestandteil aktueller computergestützter Argumentationssysteme. Ein Feed-Forward-Neuronales Netzwerk, oft auch nur als neuronales Netzwerk bezeichnet, ist eine Art gefälschtes neuronales Netzwerk, bei dem Assoziationen zwischen Hubs keine Rahmenzyklen bilden.

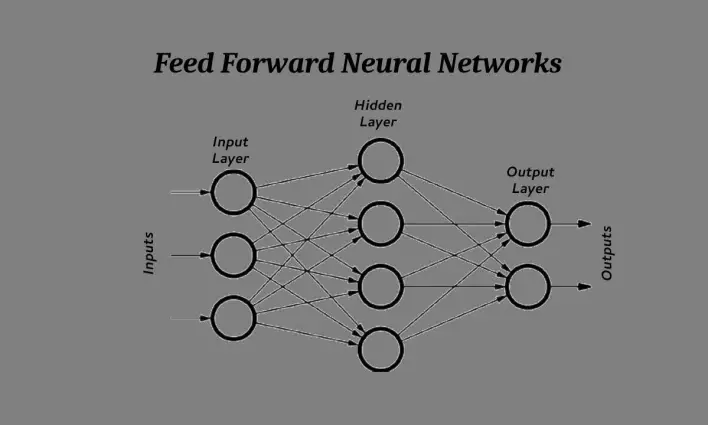

Definition und Grundstruktur

Im Zentrum besteht ein Feed-Forward-Neuronales Netzwerk aus Schichten miteinander verbundener Hubs oder Neuronen, die fortlaufend koordiniert werden. Jede Schicht erhält Eingaben von der vorherigen Schicht und gibt ihr Ergebnis praktisch ohne Kritikkreise an die folgende Schicht weiter. Dieser einseitige Verlauf der Daten vom Beitrag zum Ertrag verdeutlicht den Feed-Forward-Charakter dieser Netzwerke.

Vergleich mit anderen Arten neuronaler Netze

Im Gegensatz zu rekurrenten neuronalen Netzen (RNNs), die kritische Assoziationen aufweisen, die es ihnen ermöglichen, ein dynamisches, vorübergehendes Verhalten zu zeigen, benötigen vorwärtsgerichtete neuronale Netze solche repetitiven Assoziationen.

Durch diese Qualifikation eignen sich Feed-Forward-Netzwerke besonders für Unternehmen, die statische Informationsflusszuordnungen benötigen, z. B. Bildanordnungs- oder Rückfallprobleme. Während RNNs in der Lage sind, aufeinanderfolgende Informationen zu verarbeiten, gelingt es Feed-Forward-Netzwerken, Projekte durchzuführen, bei denen jede Information frei von früheren Datenquellen ist.

Grundsätzlich bieten Feed-Forward-Neuronale Netze direktes Engineering für den Umgang mit Informationen und treffen eine bekannte Entscheidung in anderen KI-Anwendungen. Wir sollten uns eingehender mit den Teilen und der Funktionsweise dieser Organisationen befassen, um ein vollständiges Verständnis ihrer Fähigkeiten und Hindernisse zu erlangen.

Lesen Sie auch: Deep Learning vs. Machine Learning: Hauptunterschiede

Komponenten eines Feed-Forward-Neuronalen Netzwerks

Wir sollten in die verblüffenden Teile eintauchen, aus denen ein Feed-Forward-Neuronales Netzwerk besteht, und die inneren Funktionen dieses starken computergestützten Argumentationsdesigns erhellen.

Eingabeebene

Die Infoschicht fungiert als Tür für Informationen, die in das neuronale Netzwerk gelangen. Jedes Neuron in dieser Schicht adressiert ein Element oder eine Qualität der Informationen.

Beispielsweise könnte sich in einer Bilderkennungsaufgabe jedes Neuron auf eine Pixelbewertung beziehen. Die Informationsschicht gibt lediglich die Informationsinformationen an die nachfolgenden Schichten weiter und startet so die Weiterleitung der Daten durch die Organisation.

Verborgene Schichten

Zwischen der Informations- und der Ergebnisschicht angesiedelt, finden in den geheimen Schichten die Berechnungen statt. Diese Schichten bestehen aus miteinander verbundenen Neuronen, die jeweils gewichtete Berechnungen anhand der Informationen durchführen.

Die Anzahl der geheimen Schichten und die Anzahl der Neuronen in jeder Schicht sind entscheidende Plangrenzen, die sich auf die Fähigkeit der Organisation auswirken, aus Informationen komplexe Beispiele zu gewinnen.

Durch fortschreitende Veränderungen in den geheimen Schichten extrahiert die Organisation aus den Informationen Highlights auf höherem Niveau und arbeitet dabei mit der expliziten Bildungserfahrung der Aufgabe.

Ausgabeebene

Im Mittelpunkt des neuronalen Netzwerks steht die Ergebnisschicht, in der die Organisation ihre Prognosen oder Gruppierungen liefert. Die Neuronen in dieser Schicht adressieren die potenziellen Ergebnisse oder Klassen der zu erledigenden Aufgabe.

Bei einem Problem mit doppelter Ordnung könnte die Ergebnisschicht beispielsweise zwei Neuronen enthalten, von denen jedes die Wahrscheinlichkeit anzeigt, einen Platz in einer der beiden Klassen zu haben. Die resultierende Schicht integriert die über die geheimen Schichten verarbeiteten Daten und erstellt das letzte Ergebnis des vorwärtsgerichteten neuronalen Netzwerks.

Das Verständnis der spezifischen Aufgaben und Kommunikationen dieser Teile ist von grundlegender Bedeutung, um den Nutzen und die Kapazitäten von Feed-Forward-Neuronalen Netzen in den Griff zu bekommen. Wie wäre es jetzt, wenn wir uns eingehender mit den Handlungsschritten befassen, die das Verhalten einzelner Neuronen innerhalb dieser Schichten steuern?

Aktivierungsfunktionen

Wie wäre es, wenn wir die entscheidende Aufgabe der Umsetzungsfähigkeiten im Bereich der Feed-Forward-Neuronalen Netze abwickeln und Einblicke in deren Bedeutung für die tiefgreifende Gestaltung der Verhaltensweise der Organisation und die Ermöglichung komplexer Berechnungen gewinnen?

Zweck und Arten von Aktivierungsfunktionen

Aktivierungsfunktionen wirken als nichtlineare Änderungen, die auf die gewichtete Menge an Beiträgen an jedem Neuron angewendet werden. Sie bringen Nichtlinearität in die Organisation und befähigen sie, komplexe Zusammenhänge in Informationen zu lernen. Sie spielen eine entscheidende Rolle bei der Entscheidung über das Ergebnis eines Neurons und damit des gesamten neuronalen Netzwerks.

Es gibt verschiedene Arten von Initiationsfähigkeiten, jede mit bemerkenswerten Eigenschaften und Sinnhaftigkeit für verschiedene Aufgaben. Das Verständnis der Qualitäten und Auswirkungen dieser Fähigkeiten ist für die tatsächliche Planung und Vorbereitung von Feed-Forward-Neuronalen Netzen unerlässlich.

Gängige Aktivierungsfunktionen, die in Feed-Forward-Netzwerken verwendet werden

Im Bereich der Feed-Forward-Neuronalen Netze haben einige Umsetzungsfähigkeiten aufgrund ihrer Praktikabilität und Rechenleistung an Bedeutung gewonnen. Unter diesen werden im Allgemeinen die Sigmoid Capability Amended Straight Unit (ReLU) und die Exaggerated Digression (Tanh)-Fähigkeit verwendet.

Jede Umsetzungsfähigkeit weist unverwechselbare Eigenschaften auf, die sich auf die Fähigkeit des Unternehmens auswirken, Informationen zu gewinnen und zusammenzufassen. Indem wir die Qualitäten und Verhaltensweisen dieser normalen Initiierungsfähigkeiten untersuchen, können wir Erfahrungen über ihre Auswirkungen auf die Netzwerkausführung und die Rationalisierung von Verfahren sammeln.

Vorwärtsausbreitung

Wir sollten uns mit dem entscheidenden Prozess der Vorwärtsausbreitung im Bereich der Feed-Forward-Neuronalen Netze befassen und das System entwirren, mit dem diese Organisationen Eingabeinformationen in signifikante Prognosen oder Vereinbarungen umwandeln.

Erläuterung des Vorwärtsausbreitungsprozesses

Die Vorwärtsausbreitung, auch Feed-Forward-Pass genannt, ist das Hauptsystem, durch das Eingabeinformationen das neuronale Netzwerk Schicht für Schicht durchlaufen und schließlich ein Ergebnis erzeugen. Der Zyklus beginnt mit der Informationsschicht, wo jedes Neuron separate Informationswerte erhält. Diese Eingaben werden dann gewichtet und summiert, wobei die gelernten Parameter (Gewichte) berücksichtigt werden, die jeder Verbindung zugeordnet sind.

Auf diese Weise werden die nachfolgenden Qualitäten durch die Betätigungsfähigkeit jedes Neurons in den geheimen Schichten durchlaufen, was Nichtlinearität in die Organisation bringt und komplexe Berechnungen ermöglicht. Dieser fortlaufende Datenverlauf durchläuft die geheimen Schichten, bis er zur Ergebnisschicht gelangt, wo die letzten Erwartungen oder Vereinbarungen übermittelt werden.

Vorwärtsgenerierung verkörpert den Kern von Feed-Forward-Neuronalen Netzen und arbeitet mit der Interpretation von Informationsinformationen in bemerkenswerte Wissenseinheiten durch fortschreitende Veränderungen über die Ebenen des Unternehmens hinweg.

Rolle von Gewichtungen und Vorurteilen

Von grundlegender Bedeutung für den Vorwärtsausbreitungsprozess sind die Grenzen, die als Lasten und Prädispositionen bekannt sind und die die Änderung der Informationsinformationen beim Durchqueren des neuronalen Netzwerks verwalten. Lasten befassen sich mit der Stärke der Assoziationen zwischen Neuronen und steuern den Einfluss von Informationswerten auf die Aktivierung resultierender Neuronen.

Biases hingegen dienen als zusätzliche Parameter, die Flexibilität schaffen und es dem Netzwerk ermöglichen, komplexe Muster aus Daten zu lernen.

Bei der Vorwärtsausbreitung werden die Informationen durch die jeweiligen Belastungen erhöht und mit Neigungen an jedem Neuron ergänzt, wodurch die Initiierungsebenen geformt und das Ergebnis der Organisation bestimmt werden.

Durch die Änderung dieser Grenzen durch die mit der Vorbereitung verbundene Methode können Feed-Forward-Neuronale Netzwerke erfolgreich Informationen gewinnen und ihr Verhalten anpassen, um gewünschte Ziele zu erreichen.

Training eines Feed-Forward-Neuronalen Netzwerks

Wir sollten uns auf den unvorhersehbaren Prozess der Entwicklung eines Feed-Forward-Neuronalen Netzwerks einlassen, die Instrumente öffnen, mit denen diese Organisationen Daten nutzen, und ihre Grenzen anpassen, um eine optimale Umsetzung zu erreichen.

Überblick über den Ausbildungsprozess

Die Vorbereitung eines Feed-Forward-Neuronalen Netzwerks umfasst die iterative Einführung markierter Vorbereitungsinformationen in das Unternehmen und die Änderung seiner Grenzen, um den Unterschied zwischen erwarteten und tatsächlichen Ergebnissen zu begrenzen. Dieser Zyklus bedeutet, die Fähigkeit des Unternehmens zu verbessern, von der Aufbereitung von Informationen bis hin zu verborgenen Modellen zusammenzufassen und so seine vorausschauende Präzision zu verbessern. In fortschreitenden Zyklen verfeinert die Organisation ihre inneren Darstellungen und arbeitet Schritt für Schritt an der Ausstellung der zu erledigenden Aufgabe.

Backpropagation-Algorithmus

Die Backpropagation-Berechnung ist für die Vorbereitung neuronaler Feed-Forward-Netzwerke von entscheidender Bedeutung, da sie die effektive Berechnung von Winkeln für Netzwerkgrenzen ermöglicht. Die Berechnung funktioniert, indem sie im gesamten Unternehmen umgekehrt Fehler erzeugt und sie einzelnen Neuronen zuschreibt, da sie sich für den allgemeinen Erwartungsfehler einsetzen.

Durch die iterative Änderung von Belastungen und Neigungen hin zu dem Weg, der den Fehler begrenzt, arbeitet Backpropagation mit der Kombination des Unternehmens in Richtung einer idealen Vereinbarung. Dieser iterative Ablauf von Vorwärts- und Rückwärtsdurchgängen ermöglicht es der Organisation, komplexe Beispiele aus Informationen zu gewinnen und ihre internen Darstellungen langfristig zu verfeinern.

Techniken zur Optimierung des Gradientenabstiegs

Methoden zur Verbesserung des Winkeleinbruchs ergänzen die Backpropagation-Berechnung, indem sie die Grenzaktualisierungen der Organisation auf den Verlauf des steilsten Einbruchs in der Fehlerszene ausrichten.

Diese Verfahren, wie der stochastische Gradientenabstieg (SGD) und seine Variationen, ändern die Lernrate, aktualisieren Regeln, um Kombinationen zu beschleunigen, und verhindern ein Überschießen nahegelegener Minima.

Durch die effektive Erkundung des hochschichtigen Grenzraums ermöglichen Strategien zur Verbesserung von Neigungsabfällen die Verknüpfung neuronaler Netze mit Vorwärtskopplung zu einer weltweit idealen Anordnung und verbessern so ihre vorausschauende Ausführung und Spekulationskapazität.

Lesen Sie auch: Was ist die Methodik des Deep Reinforcement Learning?

Anwendungen von Feed-Forward-Neuronalen Netzen

Durch die Untersuchung der unterschiedlichen Einsatzszenarien entstehen Feed-Forward-Neuronale Netze als anpassungsfähige Geräte mit unumgänglichem Nutzen in verschiedenen Räumen, von der Bildreihenfolge bis zum klinischen Befund. Ihre inhärente Fähigkeit, mit komplexen Informationen umzugehen und unvorhersehbare Beispiele zu lernen, macht sie zu bedeutenden Ressourcen im Bereich der KI.

Bildklassifizierung

Im Bereich des PC-Sehens haben Feed-Forward-Neuronale Netze die Bildreihenfolge durch die präzise Sortierung von Bildern in vordefinierte Klassen durcheinander gebracht.

Mithilfe von Convolutional Neural Network (CNN)-Strukturen zerlegen Feed-Forward-Netzwerke Hervorhebungen und progressive Darstellungen auf Pixelebene, um Elemente, Szenen oder Beispiele in Bildern zu erkennen.

Von unabhängigen Fahrzeugen bis hin zu Frameworks zur Gesichtserkennung – Feed-Forward-Neuronale Netze unterstützen zahlreiche bildbasierte Anwendungen und verbessern die Effektivität und Präzision bei visuellen Erkennungsaufgaben.

Verarbeitung natürlicher Sprache

Feed-Forward-Neuronale Netze finden breite Anwendung in der Verarbeitung natürlicher Sprache (NLP), wo sie bei Aufgaben wie Meinungsprüfung, Textcharakterisierung und Anerkennung benannter Substanzen erfolgreich sind.

Durch wiederkehrende neuronale Netze (RNN) oder Transformatordesigns verarbeiten Feed-Forward-Netze aufeinanderfolgende Informationen und extrahieren semantische Bedeutung und kontextorientierte Daten aus Texten.

Ihre Vielseitigkeit gegenüber etymologischen Feinheiten und die Fähigkeit, langfristige Bedingungen zu erfassen, machen sie zu Schlüsselgeräten bei der Entwicklung wirkungsvoller NLP-Anwendungen, von Chatbots bis hin zu Sprachinterpretations-Frameworks.

Finanzprognose

Im Finanzbereich spielen Feed-Forward-Neuronale Netze eine wichtige Rolle bei der Vorhersage von Marktmustern, Aktienkursen und der Bewertung von Finanzwetten.

Durch die Aufschlüsselung authentischer Informationen und finanzieller Hinweise meistern Feed-Forward-Netzwerke verborgene Beispiele und Beziehungen und ermöglichen so genaue Zahlen und eine fundierte Richtung.

Ihre Fähigkeit, mit nichtlinearen Zusammenhängen umzugehen und sich an sich entwickelnde wirtschaftliche Situationen anzupassen, macht sie zu grundlegenden Hilfsmitteln für Währungsexperten, Makler und Handelsunternehmen, die versuchen, in der einzigartigen Szene des Geldes die Oberhand zu gewinnen.

Lesen Sie auch: KI in Rohstoffmarkttrends: Von der Vorhersage zur Realität

Medizinische Diagnose

Im Bereich der medizinischen Versorgung bieten Feed-Forward-Neuronale Netze vielversprechende Wege zur Krankheitserkennung, zum Erraten und zur Therapieplanung. Durch die Analyse klinischer Bildgebungsinformationen, elektronischer Gesundheitsaufzeichnungen und genomischer Abfolgen helfen Feed-Forward-Netzwerke bei der Unterscheidung von Designs, die verschiedene Krankheiten und Zustände belegen.

Von der Identifizierung von Besonderheiten in Krankheitsbildern bis hin zur Vorhersage von Patientenergebnissen engagieren diese Organisationen medizinische Fachkräfte mit umfangreichen Kenntnissen und Entscheidungshilfen, um letztlich an der Analyse von Überlegungen und Behandlungsergebnissen zu arbeiten.

Herausforderungen und Einschränkungen

Die Erkundung der Landschaft vorwärtsgerichteter neuronaler Netze offenbart eine Menge Schwierigkeiten und Einschränkungen, die angegangen werden sollten, um ihre maximale Kapazität bei der Bewältigung verblüffender Probleme in verschiedenen Bereichen freizusetzen.

Das Verständnis dieser Hindernisse ist von grundlegender Bedeutung für die Entwicklung praktikabler Verfahren zur Abschwächung ihrer Auswirkungen und zur Förderung der Weiterentwicklung des computergestützten Denkens.

Überanpassung

Eine der wesentlichen Schwierigkeiten, mit denen Feed-Forward-Neuronale Netze konfrontiert sind, ist das Risiko einer Überanpassung, bei der das Modell Unruhe und unbedeutende Beispiele aus den Vorbereitungsinformationen auffängt, was zu unglücklichen Spekulationen über unauffällige Modelle führt.

Eine Überanpassung liegt vor, wenn sich die Organisation im Vergleich zu den zugänglichen Informationen als übermäßig verwirrend erweist und Erinnerung statt Lernen hervorruft.

Systeme wie Regularisierungsmethoden, Informationserweiterung und frühzeitiges Anhalten werden eingesetzt, um Überanpassungen zu bekämpfen und das Unternehmen dazu zu bringen, aus den Informationen aussagekräftige Darstellungen zu gewinnen.

Verschwindende und explodierende Farbverläufe

Eine weitere Herausforderung beim Training neuronaler Feed-Forward-Netze ist das Problem verschwindender und explodierender Gradienten, wobei die Steigungen entweder dramatisch abnehmen oder sich wild entwickeln, wenn sie sich während der Vorbereitung in umgekehrter Richtung durch die Organisation ausbreiten.

Diese Besonderheit kann den Aufbau der Organisation blockieren und ihre Lernfähigkeit beeinträchtigen. Techniken wie Winkelschneiden, sorgfältige Gewichtsangabe und Einführungsübungen, die das Eintauchen in die Neigung erleichtern, werden eingesetzt, um diesen Test zu meistern und die Vorbereitungsinteraktion auszugleichen.

Rechenkomplexität

Feed-Forward-Neuronale Netzwerke haben häufig mit der Rechenkomplexität zu kämpfen, insbesondere wenn die Größe und Tiefe des Netzwerks zunimmt. Die schiere Menge an Grenzen und Berechnungen, die mit der Vorbereitung von Organisationen mit großem Umfang verbunden sind, kann die Rechenressourcen belasten und das laufende Vermuten in pragmatischen Anwendungen behindern.

Methoden wie Modellbereinigung, Quantisierung und Parallelisierung werden verwendet, um die Rechenkomplexität zu verringern und die Leistungsfähigkeit von Feed-Forward-Neuronalen Netzen zu verbessern und deren Senden unter ressourcenpflichtigen Bedingungen zu ermöglichen.

Abschluss

Zusammenfassend lässt sich sagen, dass dieser ausführliche Leitfaden einen tiefgreifenden Einblick in die Komplexität von Feed-Forward-Neuronalen Netzen ermöglicht und Einblicke in deren Technik, Vorbereitungszyklen, Anwendungen und Schwierigkeiten gewährt.

Vom Verständnis der Teile von Feed-Forward-Organisationen bis hin zur Untersuchung ihrer unterschiedlichen raumübergreifenden Anwendungen, zum Beispiel Bildanordnung, Umgang mit normaler Sprache, Geldberechnung und klinischer Analyse, haben wir die signifikanten Auswirkungen dieser Organisationen auf den Bereich der Menschlichkeit aufgezeigt. Intelligenz geschaffen.

Feed-Forward-Neuronale Netze fungieren als zentrale Stützpunkte bei der Verbesserung intelligenter Frameworks, treiben die Entwicklung voran und sorgen für Fortschritte in verschiedenen Unternehmen. Während wir weiterhin die Geheimnisse von Feed-Forward-Organisationen lüften und die Grenzen der von Menschen geschaffenen Intelligenz erweitern, heißen wir Sie herzlich willkommen, Ihre Überlegungen und Erfahrungen in den folgenden Bemerkungen mitzuteilen.

Denken Sie daran, die Informationen zu verbreiten, indem Sie diese erstaunlichen Daten an Ihre Freunde und Partner weitergeben. Gemeinsam sollten wir uns auf den Weg machen, die maximale Kapazität von Feed-Forward-Neuronalen Netzen zu erschließen und das zukünftige Schicksal der künstlichen Intelligenz zu gestalten.