Überwindung von Verzerrungen bei der Datenannotation

Veröffentlicht: 2024-11-22Nur als Hinweis: Wenn Sie etwas über unsere Links kaufen, erhalten wir möglicherweise einen kleinen Anteil am Verkauf. Das ist eine der Möglichkeiten, wie wir hier dafür sorgen, dass das Licht an bleibt. Klicken Sie hier für mehr.

In der KI prägen annotierte Daten direkt die Genauigkeit und Fairness von Modellen für maschinelles Lernen. Allerdings kann eine Verzerrung zu unzuverlässigen Ergebnissen und einer schlechten Leistung von Modellen für maschinelles Lernen führen.

Lassen Sie uns in den Kern dieser Herausforderung eintauchen und praktische, umsetzbare Strategien erkunden, um Verzerrungen bei der Datenannotation zu überwinden.

Verzerrung in der Datenanmerkung verstehen

Erstens: Was ist Datenanmerkung und wie kann sich Voreingenommenheit darauf auswirken?

Bei der Datenannotation handelt es sich um den Prozess der Kennzeichnung von Daten wie Bildern, Text oder Videos, um Modelle für maschinelles Lernen zu trainieren.

Eine Verzerrung in diesem Prozess entsteht, wenn Etiketten durch persönliche Meinungen oder äußere Einflüsse beeinflusst werden. Es handelt sich um eine häufige Falle, und wenn sie nicht bekämpft wird, kann sie den gesamten Zweck des maschinellen Lernens untergraben.

Wenn beispielsweise ein Sentiment-Analysemodell mit Anmerkungen trainiert wird, die Phrasen aus einem bestimmten Dialekt durchweg als „negativ“ bewerten, kann es bei in diesem Dialekt verfassten Texten eine schlechte Leistung erbringen.

Schlimmer noch: Es kann Stereotypen verstärken, was zu ethischen Bedenken und fehlerhaften KI-Ergebnissen führt.

Arten von Verzerrungen bei der Datenanmerkung

Verzerrungen bei der Datenannotation manifestieren sich nicht nur auf eine Art; Sie nehmen je nach Datenquelle, Annotatoren und Beschriftungsanweisungen unterschiedliche Formen an. Hier sind einige häufige Übeltäter:

Stichprobenverzerrung

Dies geschieht, wenn die gesammelten Daten nicht die gesamte Vielfalt und Diversität der Bevölkerung umfassen. Beispielsweise kann das Training eines Gesichtserkennungssystems auf überwiegend hellhäutigen Gesichtern zu einer schlechteren Genauigkeit bei dunkleren Hauttönen führen.

Annotator-Bias

Dies ergibt sich aus den Hintergründen, Perspektiven oder Vorurteilen der Kommentatoren. Zwei Kommentatoren, die dasselbe Bild oder denselben Text betrachten, können es unterschiedlich interpretieren, insbesondere wenn kulturelle oder soziale Unterschiede im Spiel sind.

Etikettierungsverzerrung

Diese Tendenz beruht oft auf vagen oder subjektiven Kennzeichnungsanweisungen und tritt dann auf, wenn die Richtlinien Kommentatoren zu einer bestimmten Interpretation drängen.

Ein klassisches Beispiel ist die Kennzeichnung von Bildern von Sportlern als „Männer“, obwohl Frauen aufgrund stereotyper Kennzeichnungsrichtlinien dargestellt werden.

Strategien zur Minimierung von Verzerrungen bei Annotationen

Zum Glück muss Voreingenommenheit nicht unvermeidlich sein. Sie können konkrete Maßnahmen ergreifen, um Voreingenommenheit in Schach zu halten und sicherzustellen, dass Ihre Datenanmerkung so neutral und repräsentativ wie möglich bleibt.

Entwickeln Sie klare und neutrale Richtlinien

Beginnen Sie mit der Ausarbeitung technischer Richtlinien zur Datenannotation, die nur minimalen Raum für subjektive Interpretationen lassen.

Stellen Sie sich vor, Sie kommentieren Filmkritiken, wenn „negativ“ und „positiv“ die einzigen Kategorien sind, es aber keine spezifische Anleitung gibt, da Kommentatoren möglicherweise neutrale oder sarkastische Rezensionen falsch klassifizieren.

Bieten Sie stattdessen explizite Beschreibungen und Beispiele für jedes Etikett an, einschließlich Randfällen.

Stellen Sie einen vielfältigen Annotator-Pool zusammen

Stellen Sie sich Ihre Annotatoren als die Linse vor, durch die Ihr Modell die Welt betrachtet. Eine enge Linse führt zu engen Einblicken, sodass ein homogener Annotatorpool wahrscheinlich enge Perspektiven einbringt.

Durch die Einbeziehung einer vielfältigen Gruppe von Kommentatoren mit unterschiedlichem Hintergrund ist es wahrscheinlicher, dass Sie ein breites Spektrum an Ansichten erfassen.

Bieten Sie regelmäßige Schulungen und Feedback an

Training ist nicht nur etwas für Maschinen. Auch menschliche Kommentatoren profitieren von der regelmäßigen Neukalibrierung durch Schulungen und Feedbackschleifen.

Konsistentes, strukturiertes Feedback sowie Überprüfungen der Datenanmerkungen aus verschiedenen Perspektiven können ihnen dabei helfen, unbeabsichtigte Vorurteile in ihrer Arbeit zu erkennen.

Darüber hinaus werden Kommentatoren durch die Durchführung von Workshops zur Sensibilisierung für Vorurteile darin geschult, ihre eigenen Neigungen zu erkennen und unparteiische Entscheidungen zu treffen.

So wie eine Sprache mit zunehmender Übung immer nuancierter wird, können auch die Beschriftungsfähigkeiten von Kommentatoren mit der richtigen Anleitung schärfer und objektiver werden.

Nutzen Sie Cross-Annotation- und Konsensmechanismen

Seien wir ehrlich: Niemand ist perfekt. Selbst der fleißigste Kommentator kann manchmal das Ziel verfehlen. Hier bietet sich die Kreuzanmerkung an.

Indem mehrere Annotatoren an denselben Datenpunkten arbeiten, können Sie Diskrepanzen erkennen und bei mehrdeutigen Fällen einen Konsens erzielen.

Dadurch werden nicht nur individuelle Vorurteile ausgeglichen, sondern Sie erhalten auch einen zuverlässigeren Etikettensatz.

Dieser Ansatz ist besonders nützlich für subjektive Kategorien wie die Emotionserkennung, bei denen persönliche Ansichten häufig in die Anmerkung einfließen.

Nutzung von Technologie zur Bekämpfung von Voreingenommenheit

Menschlicher Einsatz allein kann möglicherweise nicht jeden Fall von Voreingenommenheit erkennen, insbesondere bei umfangreichen Annotationsprojekten. Hier können Technologie und das Fachwissen eines Datenannotationsunternehmens Ihnen dabei helfen, Vorurteile zu erkennen und zu beseitigen, die der menschlichen Kontrolle entgehen könnten.

Automatisierte Qualitätskontrolltools

Automatisierte Qualitätskontrolltools sind wie die Qualitätsprüfer der Anmerkungslinie. Diese Tools überprüfen gekennzeichnete Daten auf Inkonsistenzen und kennzeichnen Muster, die auf Verzerrungen hinweisen könnten.

KI-gesteuerte Anomalieerkennung

Anomalieerkennungstechniken bieten eine weitere Schutzebene. Diese Algorithmen erkennen Ausreißer in Ihren annotierten Daten und kennzeichnen Datenpunkte, die erheblich von der Norm abweichen.

Durch die Überprüfung der gekennzeichneten Fälle können Sie ungewöhnliche Kennzeichnungsmuster erkennen, die auf Voreingenommenheit hindeuten könnten, etwa die Überbewertung bestimmter Gefühle in Texten aus bestimmten demografischen Gruppen.

Bias-Audit-Frameworks

Mehrere Frameworks sind speziell für die Prüfung von Datensätzen auf mögliche Verzerrungen konzipiert. Bias-Auditing-Tools scannen Daten nach überrepräsentierten oder unterrepräsentierten Klassen und helfen Ihnen so, eine ausgewogene Verteilung zu erreichen.

Betrachten Sie es als einen Scheinwerfer, der Bereiche beleuchtet, in denen Ihre Daten möglicherweise ungleichmäßig sind. Durch die regelmäßige Durchführung dieser Audits bleibt Ihr Datensatz unter Kontrolle und richtet ihn an ethischen KI-Zielen aus.

Zusammenfassung der Best Practices

Die Überwindung von Vorurteilen bei Expertenkommentaren ist ein fortlaufender Prozess. Im Folgenden finden Sie einige Best Practices, die Sie erneut anwenden können, um einen hohen Standard an Objektivität in Ihren Daten aufrechtzuerhalten:

- Klare Richtlinien : Präzise, klar definierte Anweisungen mit Beispielen helfen, Unklarheiten zu beseitigen.

- Verschiedene Kommentatoren : Stellen Sie sicher, dass Ihr Kommentatorenteam so repräsentativ wie möglich ist, um unterschiedliche Perspektiven zu erfassen.

- Cross-Annotation : Setzen Sie bei mehrdeutigen Fällen mehrere Annotatoren ein, um die Subjektivität auszugleichen.

- Feedbackschleifen : Kontinuierliches Training und Feedback verbessern das Verständnis der Kommentatoren und reduzieren im Laufe der Zeit Voreingenommenheit.

- Technologische Hilfsmittel : Qualitätskontrolltools, Anomalieerkennung und Bias-Audit-Frameworks sorgen dafür, dass die Daten unvoreingenommen bleiben.

| Strategie | Objektiv | Beispielanwendungsfall |

| Klare Richtlinien | Minimieren Sie subjektive Interpretationen | Detaillierte Regeln für die Stimmungskennzeichnung |

| Verschiedene Kommentatoren | Erfassen Sie breite Perspektiven | Multikulturelles Team für NLP-Projekte |

| Kreuzanmerkung | Bringen Sie individuelle Vorurteile in Einklang | Konsens über mehrdeutige Fälle bei der Emotionserkennung |

| Rückkopplungsschleifen | Reduzieren Sie Voreingenommenheit durch kontinuierliche Verbesserung | Workshops zum Erkennen impliziter Vorurteile |

| Technische Hilfsmittel | Erkennen Sie Bias-Muster in großen Datensätzen | Automatisierte Tools zur Qualitätskontrolle und Anomalieerkennung |

Letzte Gedanken

Verzerrungen bei der Datenannotation sind eine Herausforderung, die jedoch mit sorgfältiger Planung und den richtigen Tools bewältigt werden kann. Durch den Aufbau eines starken Rahmens aus unterschiedlichen Perspektiven, klaren Richtlinien und fortschrittlichen Technologien stellen Sie Ihr Modell für maschinelles Lernen auf eine solide, objektive Grundlage.

Jede Anstrengung zählt, und wenn Sie Ihren Annotationsansatz verfeinern, verbessern Sie nicht nur die Modellgenauigkeit, sondern tragen auch zum umfassenderen Ziel einer ethischen, unvoreingenommenen KI bei.

Schließlich ist der Erfolg Ihres KI-Systems nur so zuverlässig wie die Daten, aus denen es lernt – also gestalten Sie diese Daten so fair und ausgewogen wie möglich.

Haben Sie irgendwelche Gedanken dazu? Schreiben Sie uns unten in die Kommentare oder tragen Sie die Diskussion auf Twitter oder Facebook weiter.

Empfehlungen der Redaktion:

Black Friday: GoveeLife Wasserlecksucher (3er-Pack) 45 % Rabatt

Von Daten zu Erkenntnissen: Automatisierung der groß angelegten Online-Datenerfassung

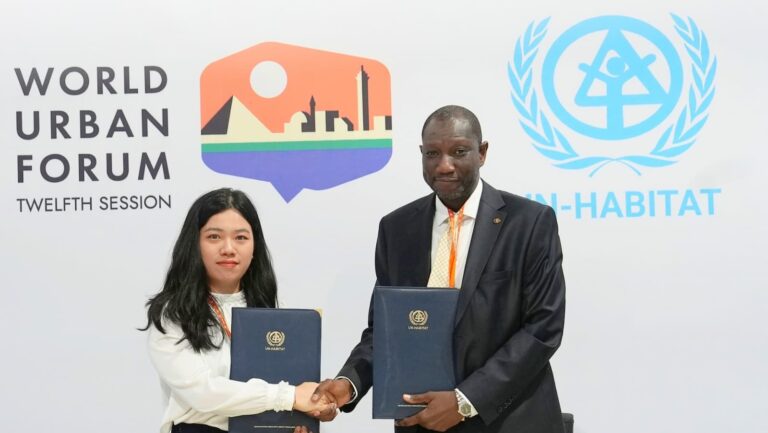

Bluetti und UN-Habitat arbeiten zusammen, um saubere Energie in Afrika zu fördern

Offenlegung: Dies ist ein gesponserter Beitrag. Unsere Meinungen, Rezensionen und sonstigen redaktionellen Inhalte werden jedoch durch das Sponsoring nicht beeinflusst und bleiben objektiv .