Von Daten zu Erkenntnissen: Automatisierung der groß angelegten Online-Datenerfassung

Veröffentlicht: 2024-11-18Nur als Hinweis: Wenn Sie etwas über unsere Links kaufen, erhalten wir möglicherweise einen kleinen Anteil am Verkauf. Das ist eine der Möglichkeiten, wie wir hier dafür sorgen, dass das Licht an bleibt. Klicken Sie hier für mehr.

Um Ihre Konkurrenten zu übertreffen, müssen Sie wissen, wie sie abschneiden.

Um Ihrer Zielgruppe Produkte und Dienstleistungen anbieten zu können, müssen Sie wissen, wonach sie sucht. Um Markttrends vorherzusagen, müssen Sie die aktuellen Marktbedingungen kennen.

Was auch immer Ihre Ziele und Vorgaben sind: Wenn Ihr Unternehmen florieren soll, benötigen Sie Zugriff auf hochwertige, aktuelle und relevante Daten.

Denn nur mit genauen Daten können Sie Erkenntnisse gewinnen, die Ihnen dabei helfen, bessere datengestützte Entscheidungen zu treffen.

Auch wenn die Qualität der Daten von entscheidender Bedeutung ist, sollte die Quantität nicht außer Acht gelassen werden. Glücklicherweise können Sie mit Tools wie der Scraper API die Erfassung umfangreicher Daten automatisieren und beide Vorteile genießen. Erfahren Sie unten mehr.

Die Bedeutung der Datenerfassung für Unternehmen

Die Datenerfassung ist für Unternehmen jeder Größe von entscheidender Bedeutung und hilft Ihnen, die Geschäftsexpansion zu beschleunigen und Ihre Entscheidungsprozesse zu verbessern.

Es bietet eine Reihe von Vorteilen, die Ihr Unternehmen zukunftssicher machen können:

- Verbessert die Lead-Generierung;

- Verbessert die Kundenbindung;

- Minimiert Risiken;

- Prognostiziert die Nachfrage;

- Verbessert das Verständnis des Kundenverhaltens;

- Prognostiziert die Aktivität der Konkurrenz;

- Verbessert Marketingstrategien;

- Erschließt Wachstumschancen.

Ohne relevante Daten basiert jede Entscheidung, die Sie treffen, einfach auf Ihrem Bauchgefühl, wodurch Sie unnötigen Risiken ausgesetzt werden und die Wahrscheinlichkeit eines Scheiterns steigt.

Durch umfassende Datenerfassung und gründliche Analyse können Sie wertvolle Erkenntnisse gewinnen, um Ihre Leistung zu steigern und Ihren Erfolg sicherzustellen.

Verwendung von Web Scraping zur Rationalisierung von Datenerfassungsprozessen

Obwohl es unzählige Methoden zur Datenerhebung gibt, darunter Interviews und Fokusgruppen, Umfragen und Formulare, ermöglicht Ihnen die Online-Datenextraktion den Zugriff auf die größten Datenmengen.

Bei der Online-Datenextraktion werden alle relevanten Websites in Ihrer Branche besucht und alle Datenpunkte erfasst, die Ihr Unternehmen benötigt.

Sie könnten aufschlussreiche Statistiken von Websites mit hoher Autorität in Ihrer Nische, Benutzerbewertungen von Websites Dritter, Preisinformationen von Websites von Mitbewerbern und mehr sammeln.

Es wird erwartet, dass die globale Datenmenge in den nächsten Jahren auf mehr als 180 Zettabyte anwächst, sodass Sie Zugriff auf viele Quellen und große Datenmengen haben.

Das einzige Problem besteht darin, dass die manuelle Erfassung aller benötigten Daten möglicherweise zu viel kostet.

Für eine groß angelegte Online-Datenerfassung müssen Sie Ihre Prozesse automatisieren, und glücklicherweise können Sie dies problemlos durch Web Scraping erreichen.

Beim Web Scraping werden Scraper-Bots zur Datenextraktion eingesetzt.

Sie müssen diese Bots lediglich so programmieren, dass sie jede gewünschte Webseite durchsuchen, die Art der Daten angeben, die sie extrahieren möchten, und Ihr bevorzugtes Extraktionsformat festlegen. Von dort aus kümmern sie sich um alles Weitere.

Web Scraper können in kürzester Zeit Hunderte von Webseiten durchsuchen und bieten dabei höchste Geschwindigkeit und Effizienz.

Sie eliminieren das Risiko menschlicher Fehler, minimieren Kosten und liefern qualitativ hochwertige, genaue Ergebnisse, sobald Sie sie benötigen.

Die beiden besten Web-Scraping-Tools

Bei der Auswahl von Web-Scrapern für die Datenerfassung und -extraktion haben Sie mehrere Möglichkeiten – vor allem traditionelle Web-Scraper wie Scraper API oder No-Code-Scraper.

Beide haben einzigartige Vor- und Nachteile, die Ihnen dabei helfen können, die bessere Lösung zu finden.

Herkömmliche Web-Scraper erfordern Programmierkenntnisse, da Sie über eine Programmiersprache mit ihnen interagieren müssen.

Ihre Geschwindigkeit, Effizienz, die Fähigkeit, mit Anti-Bot-Technologie umzugehen, dynamische Webseiten, Anpassungsmöglichkeiten und mehr heben sie jedoch von No-Code-Scrapern ab.

Vorteile traditioneller Web-Scraper:

- Flexibel;

- Effizient;

- Anpassbar.

Nachteile herkömmlicher Web-Scraper:

- Programmierkenntnisse erforderlich;

Aufgrund der umfangreichen erforderlichen Codierung eignen sich herkömmliche Web-Scraper besser für Unternehmen, die Scraping in großem Umfang benötigen.

Es handelt sich um wirksame Werkzeuge, die jedoch einen größeren Zeitaufwand erfordern.

Die gute Nachricht ist, dass sie problemlos in Ihre bestehende Infrastruktur integriert werden können und perfekt an Ihre individuellen Bedürfnisse angepasst werden können.

No-Code-Scraper sind im Allgemeinen viel einfacher zu verwenden.

Wie der Name schon sagt, erfordern sie keine Programmierkenntnisse Ihrerseits. Sie sind von Anfang an vollautomatisch und Sie können sie sofort nutzen.

Vorteile von No-Code-Scrapern:

- Vollautomatisch;

- Erfordern keine Programmierkenntnisse;

- Keine Wartung.

Nachteile von No-Code-Scraper:

- Nicht anpassbar;

Aufgrund ihrer Benutzerfreundlichkeit eignen sich No-Code-Scraper in der Regel am besten für Einzelpersonen und kleine Unternehmen, die keinen umfangreichen Datenerfassungsbedarf haben.

Während sie in kleinerem Maßstab effizient sein können, können sie mit zunehmendem Datenbedarf zu einer Einschränkung werden.

Wie und wann Sie diese Web-Scraper verwenden

Abhängig von Ihren Anforderungen können herkömmliche und No-Code-Scraper wertvoll sein, da sie in der Regel unterschiedliche Anwendungsfälle haben.

Herkömmliche Web-Scraper wie die Scraper-API werden am häufigsten verwendet für:

- Publikumsforschung;

- Marktforschung;

- Konkurrenzanalyse.

Andererseits werden No-Code-Web-Scraper am häufigsten verwendet für:

- Preisvergleiche;

- Überprüfungsüberwachung;

- Reputationsmanagement.

Als Faustregel gilt: Für die Verarbeitung großer Mengen quantitativer und qualitativer Daten ist es besser, herkömmliche Scraper zu verwenden. No-Code-Scraper können für kleinere Mengen quantitativer Daten hilfreich sein.

Abschluss

Die Automatisierung der groß angelegten Datenerfassung ist entscheidend, um über Markttrends auf dem Laufenden zu bleiben, sich mit Ihrer Zielgruppe vertraut zu machen und die Konkurrenz zu übertreffen.

Nur mit genauen und aktuellen Daten können Sie wertvolle Erkenntnisse gewinnen, die Ihr Unternehmen voranbringen können.

Haben Sie irgendwelche Gedanken dazu? Schreiben Sie uns unten in die Kommentare oder tragen Sie die Diskussion auf Twitter oder Facebook weiter.

Empfehlungen der Redaktion:

Bluetti und UN-Habitat arbeiten zusammen, um saubere Energie in Afrika zu fördern

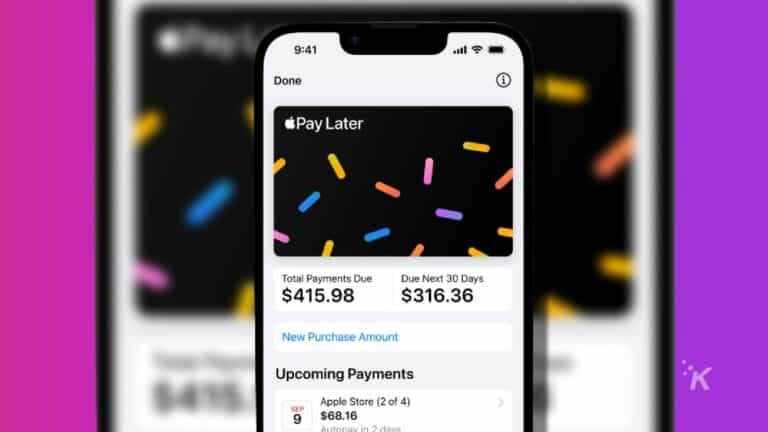

Warum im Jahr 2024 „Jetzt kaufen, später bezahlen“-Apps nutzen?

Schalten Sie das leistungsstarke Elite 200 V2-Kraftwerk während des Black Friday Sale von BLUETTI frei

Offenlegung: Dies ist ein gesponserter Beitrag. Unsere Meinungen, Rezensionen und sonstigen redaktionellen Inhalte werden jedoch durch das Sponsoring nicht beeinflusst und bleiben objektiv .