AI 治療用チャットボットが究極の倫理的ジレンマとなる理由

公開: 2023-10-31ChatGPTのような生成 AI チャットボットは、職場のプロセスを合理化し、コードを記述し、スタンドアップ コメディ セットの脚本を書くためにも使用されています。 不安症やうつ病の症例が過去最高に達し、専門家のサポートが依然として不足している米国では、ユーザーがメンタルヘルスの管理を支援するためにこのテクノロジーを利用しているのも不思議ではありません。

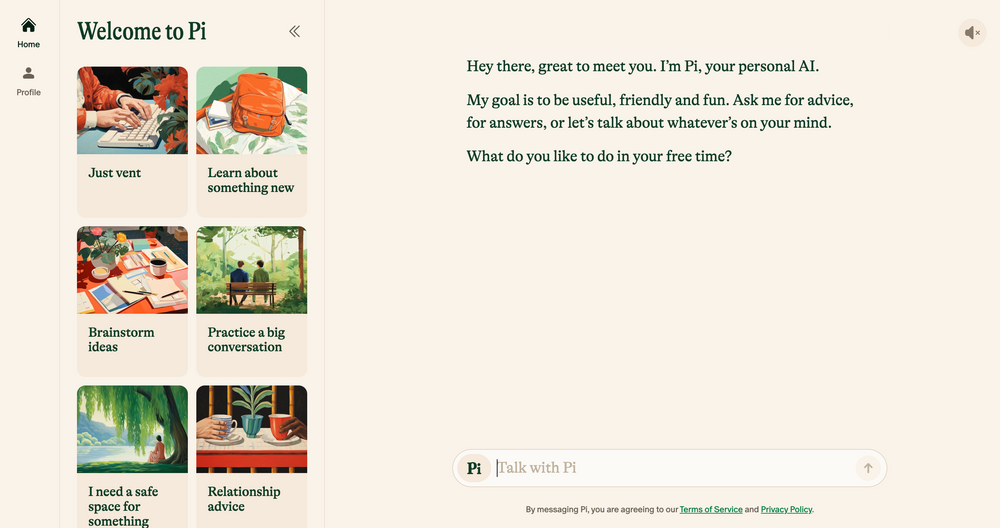

Elomia、Pi、Woebot などの AI チャットボットは、実証済みの治療技術に基づいて、手頃な価格でパーソナライズされたサポートを 24 時間年中無休で提供します。 ユーザーが長い待機リストを回避できるようにすることから、ヘルプへのアクセスに関する偏見の軽減に至るまで、そのメリットは非常に大きいです。 生成型 AI は依然として間違い、幻覚、偏見を招きやすいですが、人間の耳の共感力に匹敵するものでしょうか?

私たちは学者、心理学者、現役のセラピストに話を聞いて、新興テクノロジーがセラピーの未来をどのように形作る可能性があるかを明らかにしました。 また、AI 療法の危険な側面についても議論し、今日対処する必要がある倫理的懸念を特定します。 これが私たちが見つけたものです。

AI チャットボット: 新世代のロボット セラピスト

OpenAI のチャットボット ChatGPT が昨年 11 月に初めてリリースされて以来、Google Bard やClaude AIのような一般用途のアプリから、従来型ではない Marvel キャラクター シミュレーターに至るまで、チャットボットの模倣軍団がアプリ ストアに出現しました。

この急成長する市場は、AI セラピー チャットボットの台頭にもつながりました。AI セラピー チャットボットは、資格のあるセラピストやメンタルヘルス専門家が提供するアドバイスやガイダンスを模倣する生成 AI を使用するアプリです。

ウェブをプライベートに閲覧したいですか? それとも別の国にいるかのように見えますか?

ウェブをプライベートに閲覧したいですか? それとも別の国にいるかのように見えますか?

この Tech.co ブラック フライデー オファーで Surfshark を 86% オフで手に入れましょう。 ![]()

主な例としては、相談窓口として機能し、精神的なサポートを提供する自称「フレンドリーなチャット仲間」である Pi が挙げられます。 Replika は、ユーザーの話し方や性格を模倣するチャットボット プログラムです。 Earkick は、困難な感情を記録して対処できるように設計された不安トラッカーです。

「AI ベースのプラットフォームはプライバシーを提供し、精神的健康上の懸念に対して助けを求めることにしばしば伴う偏見を軽減します。」 –ライアン・スルタン、認定精神科医、コロンビア大学教授

最高のメンタルヘルス アプリと同様に、これらのアプリの多くはすでに 6 桁のダウンロード数を誇っており、その人気は驚くべきことではありません。 資格のある心理学者、精神科医、ソーシャルワーカーの不足に加え、全米でのサービス需要の急増により、米国は現在、史上最悪のメンタルヘルス危機の一つに直面している。

伝統的な治療の高額な費用とメンタルヘルスに関するタブーも、多くの人が従来の選択肢を追求することを思いとどまらせており、より目立たず、手頃な価格の代替手段へのギャップを生み出しています。

初期の証拠では、それらが効果的であることも示唆されています。 AI チャットボットの Earkick 自身の調査結果では、アプリを 5 か月間使い続けた後、ユーザーの気分が 34% 改善し、不安レベルが 32% 低下したことが明らかになりました。 ただし、これらのアプリは、小さな不安を和らげることには成功しているかもしれませんが、私たち全員が待ち望んでいたメンタルヘルスの万能薬ではないことは間違いありません。

AI チャットボットは重度の精神的健康状態には適さない

ポケットサイズのチャットボットからセラピストが承認した賢明なアドバイスを受け取ることは、間違いなく多くの人にとって有益です。 しかし、うつ病、統合失調症、双極性障害などの重度の精神的健康状態に苦しんでいる人は、変化が乏しいまま放置される可能性があります。

精神障害は複雑で微妙なニュアンスがあり、影響を受ける人ごとに異なります。 場合によっては、資格のある医療専門家のみが正しく処方できる薬を使用することが最も効果的である場合があります。 近年、大規模言語モデル (LLM) は飛躍的に進化していますが、その成果は、精神科医、心理学者、セラピストが提供する臨床専門知識、共感、同情に代わることはできません。

「アルゴリズムが改善されたことは評価しますが、最終的には、人々が助けを求めているときに置かれているより混乱した社会現実に対処することはできないと思います。」 –ジュリア・ブラウン、カリフォルニア大学サンフランシスコ校人類学教授

戦略的サイキックヒーラーであるアーナント・ビシュト氏も、AI は現状ではすべてのユーザーの複雑な治癒の旅を支援することはできないと考えています。 「複雑な精神的健康問題を過度に単純化することを避け、必要に応じて専門家の助けを求めるようユーザーに促すことも重要です」とビシュト氏は Tech.co に語った。

私たちが話を聞いた専門家が表明したもう 1 つの共通の懸念は、医療誤診です。 メンタルヘルスコミュニティには、複雑で重度の精神疾患を正確に特定するという長年の課題があり、テクノロジーが限られており、データセットが代表的ではなく、人間の微妙なニュアンスを解釈できないため、AI に大きく依存すると、この問題がさらに悪化する可能性があります。

この結果は悲惨なものになる可能性もあります。 メンタルヘルスの誤診は、不適切な治療やサポート、さらなる精神的プレッシャー、医療制度に対する長期的な懐疑につながることがよくあります。 人工知能が現在の形ではセラピストの椅子を追い越すことができない唯一の理由はこれだけではありません。

AI には欠陥があり、倫理的課題に覆われている

生成型 AI の急速な台頭は、結果を伴わないわけではありません。 このテクノロジーは猛烈なスピードで発展し続ける一方で、その使用に関する規制はなかなか追いついておらず、データプライバシー、埋め込まれた偏見、悪用に関連する一連の倫理的課題の一因となっています。

これらの懸念は治療に特有のものではありませんが、メンタルヘルスのデリケートな性質は、倫理的枠組みが良好な治療関係の中心であることを意味します。 公式のAI 倫理規定は現在存在しないため、ユーザーがカウンセリングやその他のメンタルヘルス サポートを有資格の専門家ではなくチャットボットに依存することには大きな問題があります。

データプライバシーは大きな問題の 1 つです。 ChatGPT のようなチャットボットは、ユーザー データの保護を怠ったために、しばしばひどい目に遭っています。 ユーザーがプライベートな個人情報について安心して議論できるようにするために、AI 企業は機密性を優先した確実なデータ保護戦略を立てる必要があります。

「治療上の会話は親密で機密性が高いため、比類のないレベルのデータ保護が必要です。」 –ランガム博士、インパルス セラピーの心理学者

注意すべきもう 1 つの重要な要素は、機械学習のバイアスです。 すべての AI システムは、事前に決定されたトレーニング データに依存しています。このデータには、たとえ人種や性別などの機密変数が除去されたとしても、人間のバイアスが組み込まれていることがよくあります。

ライフコーチ会社 Life Architecture の CEO、Bayu Prihandito 氏によると、AI が偏ったデータに基づいてトレーニングされると、「既存の偏見が永続化または悪化し、不公平な治療推奨が行われる可能性がある」とのことです。 これらの組み込みの偏見は、少数派グループの人々にもさらに影響を与える可能性が高く、人間による監視と多様で代表的なトレーニング データセットの重要性が強調されています。

AI はセラピストの代わりではなく、アシスタントとして

Pi や Woebot のようなフレンドリーなコンパニオンは、ユーザーが精神的な健康を補うためのアクセス可能な方法を模索し続けるにつれて人気が高まる一方です。 しかし、幅広い倫理的懸念があるため、人工知能が従来の治療の役割に取って代わる準備はできていませんし、またそうすべきではありません。

ただし、新興テクノロジーが医療全体に大きな影響を与えないというわけではありません。 私たちが話を聞いた実践者のほとんどは、AI ツールがトリアージなどの単調な作業を実行することで、より多くの時間とエネルギーを実践の他の分野に注ぐことができると信じています。

「セラピストが提供する深い人間関係に代わることはできませんが、補完的なツールとしては役立ちます。」 –アーナント・ビッシュ、ビジネスサイキックコーチ

「AI は初期評価、継続的なモニタリングを処理し、それほど複雑ではないケースのサポートを提供できるため、より深刻な状況やデリケートな状況に集中できるようになります」とバユ・プリハンディト氏は Tech.co に語った。利用可能。"

コロンビア大学教授で認定精神科医のスルタン氏もこれに同意し、5年後にはAIが管理業務を合理化し、医療従事者がより個別化された治療計画を立てるのを支援し、「人間の専門知識とAIを組み合わせたハイブリッドモデルを作成することによって、従来の治療を補完する可能性が高い」とTech.coに語った。治療を強化するためのツールを活用しています。」

これは、AI が人間性の実践を枯渇させるどころか、共感、つながり、同情などの人間のスキルを解放し、クライアントがサービスをさらに活用できるようにする力を実際に持っていることを示唆しています。

しかし、メンタルヘルスのケアは深刻な問題であり、多くの場合、生死にかかわる問題となる可能性があります。 AI がすべてのセラピストのアシスタントになる前に、または実際にセラピストに取って代わる前に、その導入と使用に関する厳格な規制を検討する必要があります。

そのような時代が到来するまでは、AI チャットボットがメンタルヘルス サポートへのアクセスを向上させる明らかな可能性と、AI チャットボットがもたらすリスクを完全に調和させることはできません。 倫理的ジレンマが当然のことであることが多い世界では、これは無視するには大きすぎます。