AI 音声クローン詐欺: 成人の 4 人に 1 人がすでに標的にされています

公開: 2023-05-02愛する人からのボイスメールと、AI によって生成されたボイスメールの違いを見分けることができると思いますか? AI ボイス クローニング テクノロジーを使用して無防備な被害者をだます詐欺師は、あなたがそうできないことを願っています。

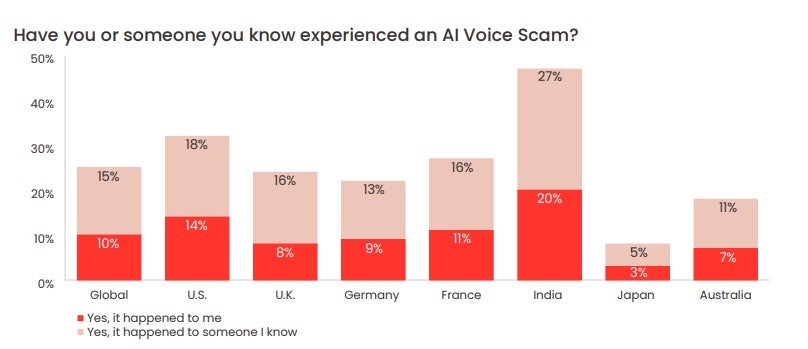

マカフィーが最近実施した調査によると、成人の 4 分の 1 がすでに AI 音声詐欺の標的にされており、その圧倒的多数が苦労して稼いだお金を失っています。 また、大多数の成人が少なくとも週に 1 回はソーシャル メディアプラットフォームやその他のオンライン スペースで自分の意見を共有していることも明らかになりました。これは、脅威アクターがこの種の詐欺を何度も何度も実行するために必要なものを正確に提供するものです。

では、AI ボイス クローン詐欺は実際にどのように機能し、どれくらい一般的であり、AI ボイス クローン詐欺をどのように見抜くことができるのでしょうか? 詳しく見てみましょう。

- AIボイスクローニング詐欺とは?

- AIボイスクローニングが実際にどのように機能するか

- AIボイスクローン詐欺はどのくらい一般的ですか?

- メッセージが AI ボイス クローン詐欺かどうかを見分ける方法

AIボイスクローニング詐欺とは?

AI ボイス クローン詐欺とは、人工的に生成された音声ファイルを使用して、愛する人が危険にさらされている、または緊急の経済的支援が必要であり、助けを求めて被害者に連絡したと被害者に思わせる詐欺です。

この種の詐欺では、詐欺師は AI 音声ジェネレーターを介して、ソーシャル メディアから盗み出されることが多い、被験者が話しているクリップを実行します。 ジェネレーターは機械学習を使用して、最初のクリップのリズム、トーン、およびピッチを分析し、詐欺師が被験者の声をほぼ完全に模倣する独自のオリジナルのオーディオを生成できるようにします。

詐欺師は、WhatsApp などのアプリを介して、対象の友人や親戚にこれらの録音を送信し、愛する人と AI によって生成された自分の声を区別できないことを望んでいます。

他のオンライン詐欺によくあることですが、詐欺師は、標的に性急な行動や不規則な行動を起こさせるために、緊急性と苦痛感を通信に注入しようとします。

最近のある事例では、AI 音声詐欺師が米国の母親に、娘の声を複製して誘拐されたことを納得させようとしました。

心配なことに、新進の詐欺師は、被害者を標的にするために必要な音声ファイルを見つけるのに苦労することはありません。

マカフィーが 2023 年 5 月に発表した調査では、7 か国から 7,000 人以上が参加し、調査回答者の 53% が少なくとも週に 1 回はオンラインで自分の意見を共有していると答えています。 インドでは、この数字は 86% でした。

ボイスクローニングの実際の仕組み

AIボイスのクローン作成は、AIボイスジェネレーターと呼ばれるAIツールでのみ可能です。 簡単に言えば、AI 音声ジェネレーターは、テキスト ファイルを音声に変換します (「テキスト読み上げ」または「TTS」ツールと呼ばれることがよくあります)。

AI 音声ジェネレーターは、機械学習を使用して、話している人の音声ファイルからの情報を分析することにより、特定の方法で話すことを学習します。 ジェネレーターは、学習した内容を適用して、ユーザーから提供されたテキスト ファイルを読み取り、オリジナルのオーディオ コンテンツを生成します。

これらのジェネレーターの多くには、テキストを読むために選択できるカスタム音声と、選択できる有名人の音声がありますが、自分の音声を録音して、その後のオーディオ コンテンツを作成できるものもあります。

テキスト読み上げツールの Descript.com は、自称「自分の声の超リアルなクローンを作成する最先端の音声ジェネレーター」を提供しています。

AI音声ジェネレーターは、あらゆる種類のデバイスで広く利用できるようになりました。 これらのプログラムは、文字を読むのが困難な人や、書かれた単語を読むよりも音声を聞いた方が学習効率が高い人に、多くの価値をもたらします。

また、マーケティング コンテンツのために高価なナレーション アーティストを雇う予算がない広告会社でも使用されています。

ChatGPTの成功と普及により、オーディオのクローン作成に使用できるものを含む、あらゆる形状とサイズの AI ツールに新たな焦点が当てられています。 その高貴な用途にもかかわらず、残念ながら、人々を詐欺するなど、悪用される可能性がある TTS AI ツールの小さなエコシステムが存在します。

AIボイスクローン詐欺はどのくらい一般的ですか?

最近リリースされた McAfee の調査で、サイバーセキュリティの巨人は、調査対象の成人の 4 人に 1 人が AI 音声詐欺を経験したことがあることがわかりました。

標的にされた人の 77% が、詐欺によってお金を失ったと報告しています。 マカフィーは、その 77% のうち、「3 分の 1 以上が 1,000 ドル以上を失い、7% は 5,000 ドルから 15,000 ドルの間でだまされた」と報告しています。

米国の被害者が最も多くを失っていることが調査で明らかになりました。 AI ボイス クローン詐欺で金銭を失った米国の被害者の 11% は、5,000 ~ 15,000 ドルを失いました。

メッセージが AI ボイス クローン詐欺かどうかを見分ける方法

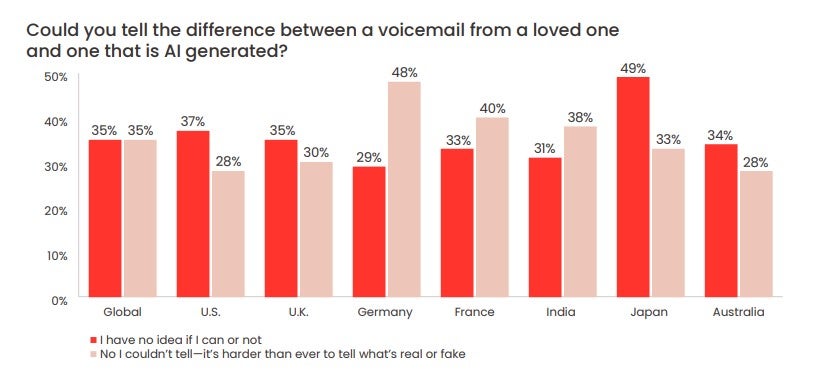

McAfee の調査では、70% の人が、AI の声と人間の声を区別できるかどうか「わからない」と答えていることもわかりました。

米国の回答者のほぼ 3 分の 1 (28%) が、McAfee が言うように「人為的ななりすまし」が残したボイスメールと、愛する人が残したボイスメールを見分けることができないと答えました。

詐欺師は愛する人の声を真似ることができるかもしれませんが、愛する人の番号や WhatsApp アカウントを制御するのは非常に困難です。

親戚や友人が苦しんでいるように聞こえる場合、冷静に行動するのは難しい場合があります。 しかし、AI 音声詐欺がますます一般的になっているため、それを行うことが重要です。 AI 音声メッセージが詐欺である可能性がある兆候がいくつかあります。

- 通常とは異なる連絡方法(不明な番号など)

- すぐに多額のお金を要求する

- 通常とは異なる手段 (ギフトカードや仮想通貨など) による送金の要求

- 電話/インシデントについて誰にも話さないでくださいという要求

それを念頭に置いて、FTC は次のことを行うべきだとアドバイスしています。

- メッセージを残した番号に電話して、それが誰であるかを確認します

- 愛する人や友人の個人番号に電話をかけます

- ご本人様のご家族・親しい方へのメッセージ

連絡が取れない場合は、すぐに法執行機関に知らせることが重要です。 これらの詐欺の標的にされたことはないが、被害に遭わないようにしたい場合は、家族や友人と安全な言葉を交わしてください。

これは、あなたとあなたの愛する人がお互いに自分自身を識別できることを意味するコードであり、AI 音声詐欺の犠牲にならないようにするための最良の方法の 1 つです。 これは、年配の家族にとって特に有用であり、書き留められていない場合は、非常にシンプルに保つことができます.

また、AI 音声詐欺師が被害者を脅迫するために使用している最新の方法、テクニック、および形式に遅れずについていくことも重要です。 用心深く、未知の番号からの電話に細心の注意を払って対処することに加えて、耳を地面に向けておくことが最善の方法であることがよくあります。