iPhoneでAIモデルをローカルにインストールして実行する方法

公開: 2025-02-20AppleはまだApple Intelligenceのコードを解読するのに苦労しています。 AIモデルがデバイスでローカルに実行され、処理が速くなり、プライバシーが強化されます。 Deepseek Revolutionに感謝します。これで、AndroidやiPhoneなどのモバイルデバイスなど、デバイスでよりインテリジェントな推論AIモデルをローカルで実行できます。

AndroidとPCでDeepseek R1をローカルに実行する方法に関する詳細なガイドについては、すでに説明しています。 Androidはサードパーティの方法を使用する場合に非常に柔軟であるためです。 Androidでローカルでモデルをインポート、使用、および実行するためのいくつかの方法が存在します。ただし、Appleはサードパーティの測定値を備えていますが、ありがたいことに、App Storeには、iPhoneにローカリモデルをローカルでインストールして実行できるアプリがあります。

私はいくつかのアプリを使用しており、テスト後、iPhoneでAIモデルをローカルに実行するための3つの最適なアプリを次に示します。これらのモデルは、デバイスがApple Intelligenceをサポートしていなくても機能します。準備ができているなら、始めましょう。

目次

iPhoneでAIモデルをローカルに実行する方法

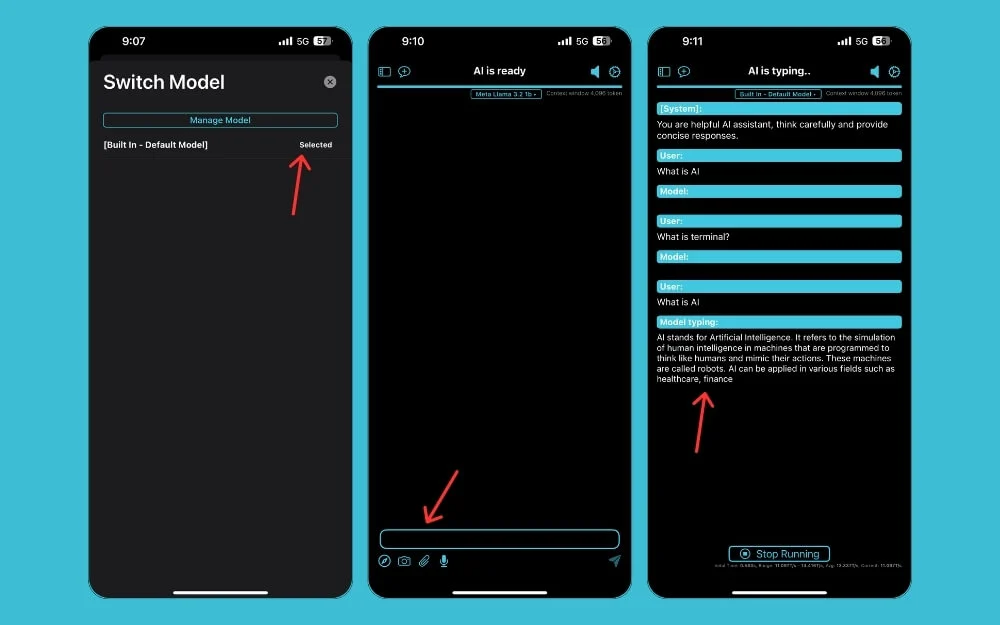

PocketPal AIアプリを使用します

PocketPal AIアプリのおかげで、iPhoneでiPhoneでさまざまなAIモデルをローカルに実行できるようになりました。これには、iPhoneのDeepSeek R1ローカルモデルやハイエンド70Bモデルなどがあります(ただし、iPhoneはこのモデルをサポートしていません)。

端末、複数のコマンドを使用し、コマンドラインインターフェイスでAIモデルを使用する必要があるTermuxメソッドとは異なり、PocketPal AIアプリは、iPhoneでモデルをローカルにインストールおよび実行するためのシンプルで使いやすいインターフェイスを提供します、初心者がデバイスにAIモデルをローカルにインストールして使用するのにさらに適しています。このアプリはAndroidでも利用できます。 Androidのこの方法をリストする詳細なガイドもあります。 iPhoneについては、以下の方法に従ってください。

iPhoneでAIモデルをローカルに実行するためにPocketPal AIアプリを使用する方法:

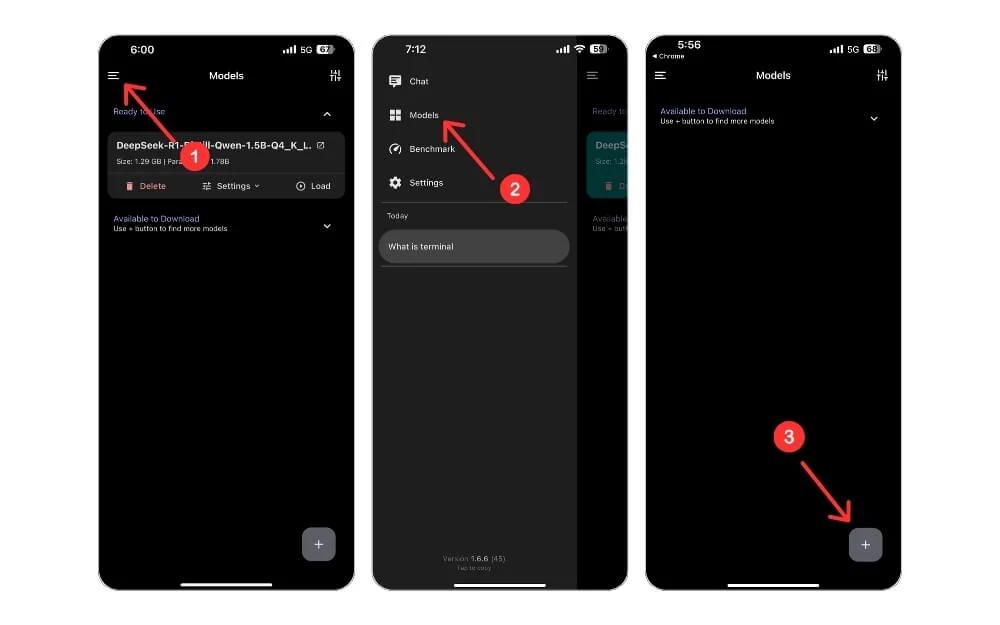

ステップ1: App StoreからPocketPalアプリ(無料)をインストールします。 iPhoneでPocketPalアプリを開き、ハンバーガーメニューをクリックします。

ステップ2:モデルをクリックします。

ステップ3:画面の右下隅にあるプラスアイコンをクリックして、ハグする顔からの追加をタップします。

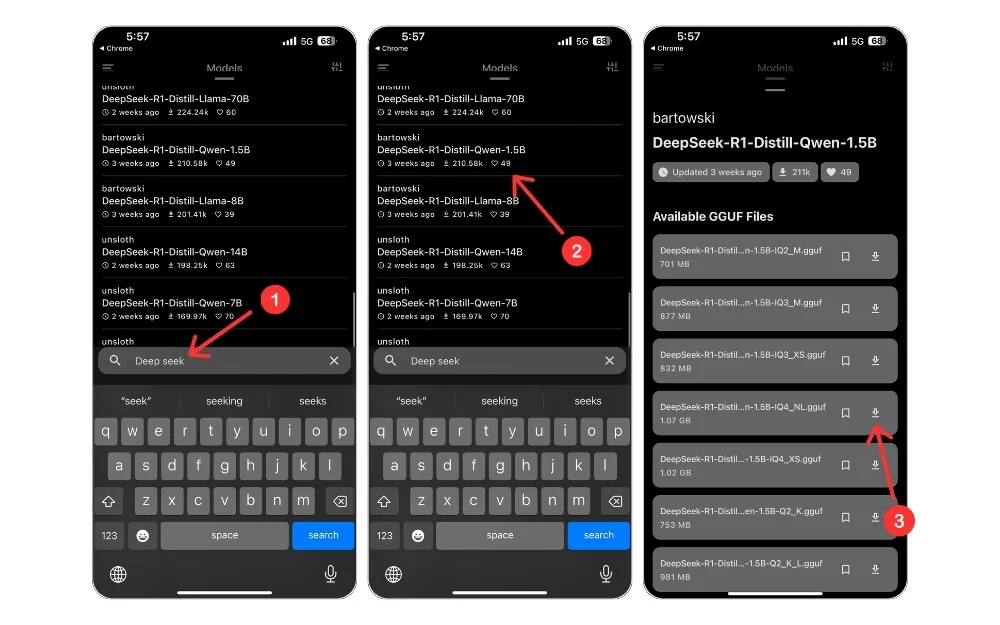

ステップ4:下の検索バーを使用し、実行するローカルAIモデルを選択します。このガイドでは、DeepSeek R1 1.5Bモデルをインストールしました。ステップ5:選択したモデルを検索およびインストールできます。

ステップ6:モデルをタップして、その横のダウンロードボタンをクリックします。

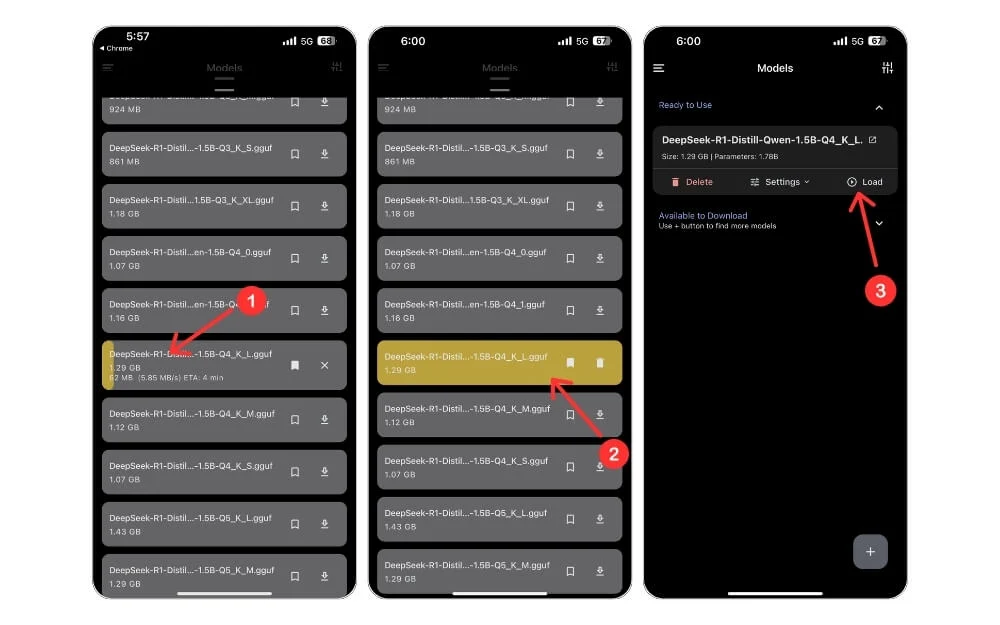

モデルがダウンロードされるのを待ちます。ダウンロードしたら、ホーム画面に戻り、モデルを選択し、[ロード]をクリックします。これにより、チャットインターフェイスにモデルがロードされます。次に、プロンプトを入力して[Enter]をクリックします。必要に応じて、インターネット接続をオフにすることもできます。

アプリをダウンロードします

オンデバイスアプリを使用します

または、オンデバイスAIアプリは、iPhoneで複数のAIモデルをローカルにインストールおよび実行できます。また、アプリがサポートする他のどのモデルよりもうまく機能するモデルが付属しています。ただし、他のモデルにはいくつかの問題があります。アプリをインストールし、iPhoneのほとんどのローカルAIタスクに無料モデルを使用できます。

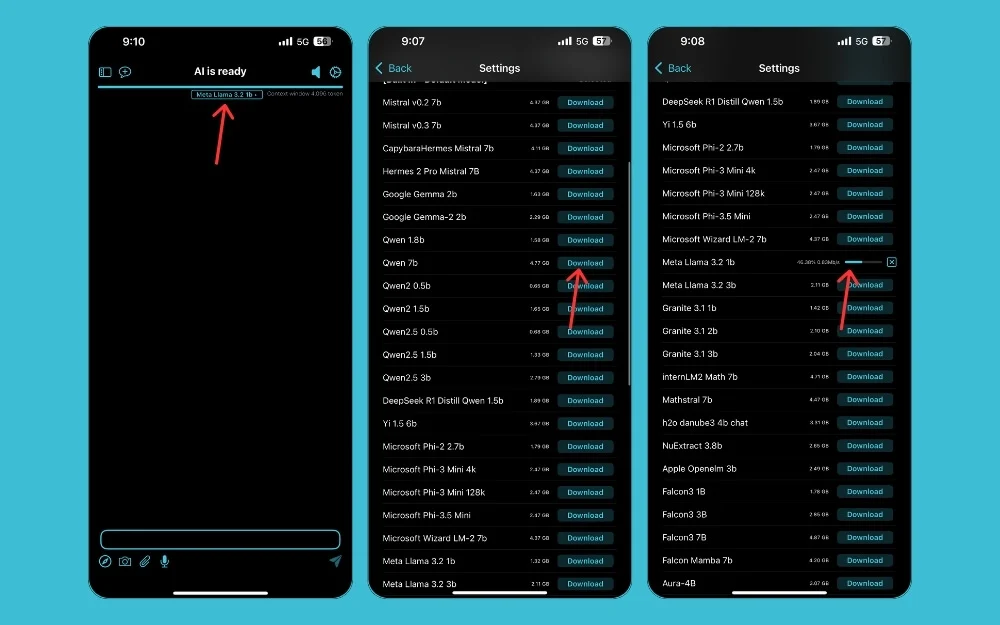

オンデバイスAIアプリを使用して、iPhoneでAIモデルをローカルに実行する方法:

ステップ1: iPhone(1.8GB)にオンデバイスAIアプリをインストールする

ステップ2:アプリを開き、選択したAIモデルをクリックします。

ステップ3:リストから、モデルを選択し、ダウンロードをクリックします。アプリがモデル全体をダウンロードするのを待ちます。

ステップ4:ホーム画面に戻り、選択したモデルをクリックし、ダウンロードしたモデルを選択します。

ステップ5:プロンプトを入力します。モデルが機能していない場合は、切り替えたり、デフォルトモデルを使用したりできます。ユーザーインターフェイスは、すべてのアプリからテストした最高のものではありません。

アプリをダウンロードします

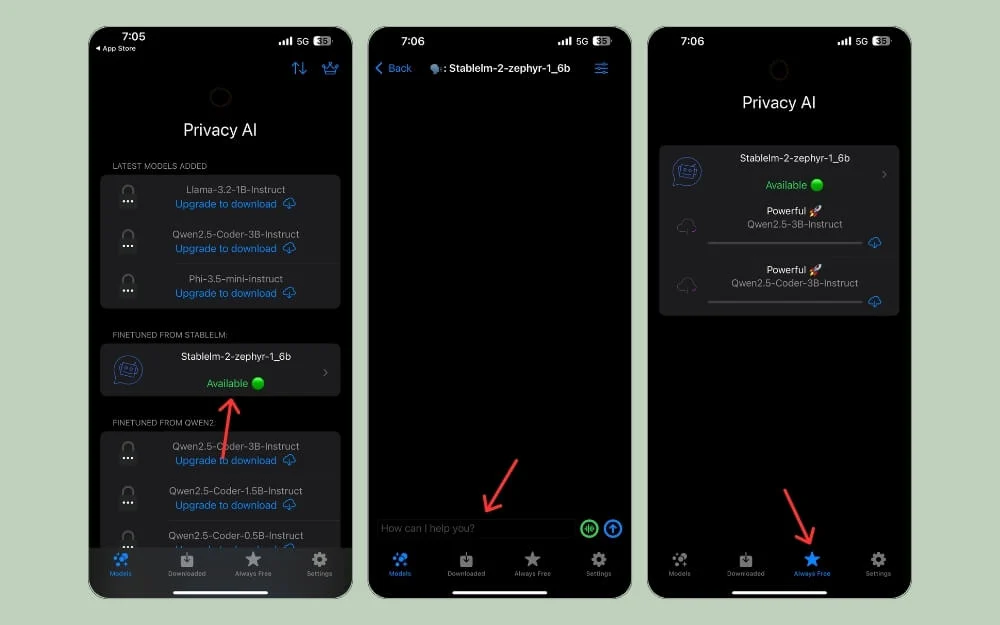

プライバシーAIローカルLLM

プライバシーAIローカルLLMは、iPhoneでAIモデルをローカルに実行できる別のアプリです。このアプリはiPhoneユーザー向けに特別に設計されています。つまり、iPhoneとMac用に最適化されており、他のパフォーマンスよりも優れたパフォーマンスを提供します。また、Llama 3、Google Gemma、Microsoft Phi-3などの大きくて強力なモデルもサポートしています。

プライバシーAIローカルLLM AIアプリを使用して、iPhoneでAIモデルをローカルに実行する方法:

ステップ1: App StoreからプライバシーAI LLMをインストールします。

ステップ2:アプリを開きます。プレミアムアクセスにアップグレードする場合は、クラウンアイコンをクリックし、計画を選択してアップグレードします。

ステップ3:アプリは、無料版で無料でStablelm-2を提供しています。モデルを使用するには、モデルをクリックし、ポップアップから「Let's Go。 」

ステップ4:これにより、モデルと対話し、プロンプトを入力し、応答を取得できる新しいチャットインターフェイスが開きます。モデルはデバイスでローカルに実行されるため、インターネット接続をオフにすることもできます。

ステップ5:より一般的でより良いモデルをダウンロードするには、「常に無料」モデルのロックを解除し、モデルを選択して、ダウンロードアイコンをクリックできます。これにより、モデルがダウンロードされます。それを使用するには、タップして同じ手順に従ってください。

一般に小さなモデルをサポートするポケットパルAIやオンデバイスAIアプリとは異なります。さらに、このアプリを使用すると、温度やシステムプロンプトなどを調整することでAI応答をカスタマイズできます。

iPhone用に作られているため、プライバシーAIローカルLLMをセットアップしてSiriおよびAppleショートカットを使用できます。そのため、アプリを開くことなくAIの質問をすばやく尋ねることができます。ただし、より大きなモデルを使用するには、1つの計画について読んだとしても、プレミアムプランを購読する必要があります。私の場合、すべての計画は毎年のサブスクリプションに基づいています。アプリをアップグレードしたら、iPhoneですべての大きな言語モデルにローカルにアクセスできます。

これらとは別に、アプリインターフェイスはシンプルで使いやすいです。モデルを選択し、チャットインターフェイスを取得し、テキストを介してモデルと対話できます。モデルに応じて、音声モード、マルチモーダルの画像などもサポートしています。

アプリをダウンロードします

iPhoneでAIモデルをローカルに実行します

Androidとは異なり、iPhoneはまだ閉じた環境で動作しているため、サードパーティの機能を使用することは困難です。アプリをサイドロードする方法はありますが、これらの方法はAndroidほど簡単ではありません。ただし、上記の方法を使用して、問題なくiPhoneでAIモデルをローカルにダウンロードして実行できます。これらは、初心者であっても、使用するのが簡単です。また、iPhoneと同じ高レベルの利点を享受するために、MacにDeepsel R1をローカルにインストールするための詳細なガイドもあります。

iPhoneでAIモデルをローカルに実行するFAQ

AIモデルを実行すると、iPhoneのバッテリーをすぐに排出しますか?

はい、AIモデルを実行すると、iPhoneのバッテリーが迅速に消耗します。これは、デバイスでローカルに実行するためにリソースとパワーが必要なためです。私たちの観察では、バッテリーの寿命は小さなタスクによってそれほど影響を受けません。ただし、これらのモデルをより頻繁に実行すると、バッテリー寿命が影響を受ける可能性があります。

これらのAIモデルをローカルで使用するには、インターネット接続が必要ですか?

これで、モデルをローカルにダウンロードしてインストールしたら、それを使用するためにインターネット接続は必要ありません。ただし、多くの場合GBSでダウンロードして、デバイスにモデルをローカルにダウンロードして保存するには、一定のインターネット接続が必要になります。

AIモデルをローカルで実行するために必要な最小iPhoneモデルはどのくらいですか?

電話にハードキャップ制限はありません。ただし、iPhoneが新しくなればなるほど、仕様が改善されたため、パフォーマンスが向上します。ただし、iPhone 12以降のデバイスは、パフォーマンスを向上させるために推奨されます。

これらのアプリにカスタムAIモデルをインストールできますか?

はい、これらのAIアプリにカスタムAIモデルをインストールして使用できます。 PocketPalを使用すると、ローカルモデルをデバイスからローカルにインポートし、ローカルでデバイスで使用できます。ただし、これらのAIモデルは、デバイスでローカルに実行するための要件を満たすために、特定の仕様に準拠する必要があります。

AIモデルはiPhoneでどのくらいのストレージスペースを占有していますか?

一般に、小さなモデル(1Bパラメーター)1-2GB、中モデル(7Bパラメーター)4-6GB、および大規模モデル(13B+パラメーター)10GB+(iPhoneではサポートされていないことが多い)。