Por qué los chatbots de terapia con IA son el máximo dilema ético

Publicado: 2023-10-31Los chatbots de IA generativa como ChatGPT se están utilizando para optimizar los procesos en el lugar de trabajo, escribir códigos e incluso escribir guiones para escenarios de comedia. En EE. UU., donde los casos de ansiedad y depresión están alcanzando niveles récord y el apoyo profesional sigue siendo limitado, no sorprende que los usuarios también estén utilizando la tecnología para ayudar a controlar su salud mental.

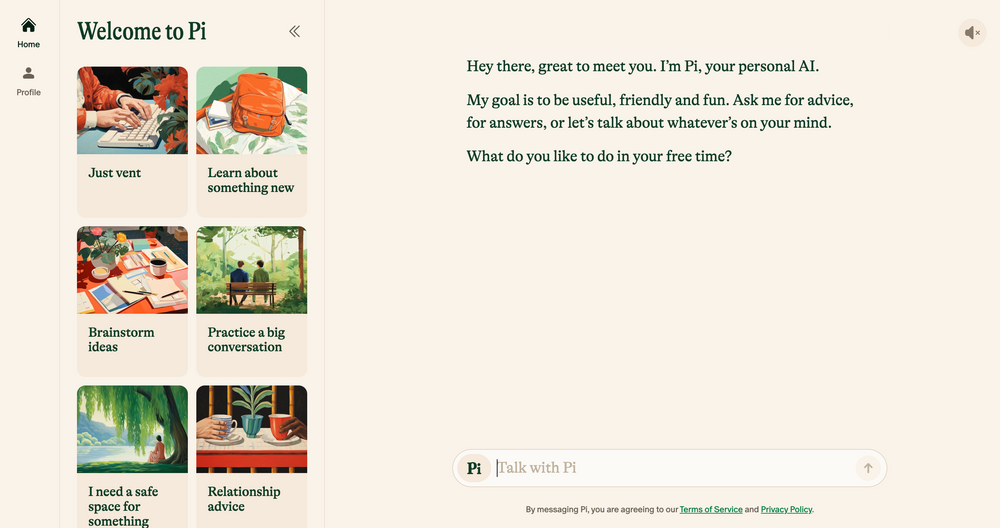

Los chatbots de IA como Elomia, Pi y Woebot ofrecen soporte personalizado y asequible las 24 horas, los 7 días de la semana, basado en técnicas de terapia probadas y comprobadas. Desde ayudar a los usuarios a evitar largas listas de espera hasta reducir el estigma en torno al acceso a ayuda, sus beneficios son enormes. ¿Se puede comparar la IA generativa, que todavía es propensa a errores, alucinaciones y prejuicios , con la empatía del oído humano?

Hablamos con académicos, psicólogos y terapeutas en ejercicio para arrojar luz sobre cómo la tecnología emergente probablemente dará forma al futuro de la terapia. También analizamos el lado más oscuro de la terapia con IA y señalamos qué preocupaciones éticas deben abordarse hoy. Esto es lo que encontramos.

Chatbots con IA: la nueva generación de robots terapeutas

Desde que el chatbot ChatGPT de OpenAI se lanzó por primera vez en noviembre pasado, ha surgido un ejército de imitadores de chatbot en las tiendas de aplicaciones, desde aplicaciones de uso general como Google Bard y Claude AI hasta simuladores de personajes de Marvel menos convencionales.

Este mercado floreciente también ha llevado al surgimiento de los chatbots de terapia con IA, aplicaciones que utilizan IA generativa para imitar los consejos y la orientación ofrecidos por terapeutas calificados y profesionales de la salud mental.

¿Quieres navegar por la web de forma privada? ¿O parecer como si estuvieras en otro país?

¿Quieres navegar por la web de forma privada? ¿O parecer como si estuvieras en otro país?

Obtenga un enorme 86% de descuento en Surfshark con esta oferta del Black Friday de Tech.co. ![]()

Los principales ejemplos incluyen a Pi, un autoproclamado “compañero amigable de chat” que actúa como caja de resonancia y ofrece apoyo emocional; Replika, un programa de chatbot que imita el estilo de hablar y la personalidad de sus usuarios; y Earkick, un rastreador de ansiedad diseñado para ayudarlo a registrar y superar emociones difíciles.

"Las plataformas basadas en inteligencia artificial ofrecen privacidad, lo que reduce el estigma que a menudo se asocia con la búsqueda de ayuda para problemas de salud mental". – Ryan Sultan, psiquiatra certificado y profesor de la Universidad de Columbia

Al igual que las mejores aplicaciones de salud mental , muchas de estas aplicaciones ya cuentan con descargas de seis cifras, y su popularidad no es sorprendente. Debido a la escasez de psicólogos, psiquiatras y trabajadores sociales calificados, además de un aumento en la demanda de servicios en todo el país, Estados Unidos se enfrenta actualmente a una de las peores crisis de salud mental de la historia.

El alto costo de la terapia tradicional y los tabúes en torno a la salud mental también están disuadiendo a muchos de buscar opciones convencionales, creando una brecha para alternativas más discretas y asequibles.

La evidencia preliminar sugiere que también son eficaces. Los propios hallazgos de Earkick de AI Chatbot revelaron que el estado de ánimo de su usuario mejoró en un 34% y los niveles de ansiedad disminuyeron en un 32% después de seguir con la aplicación durante cinco meses. Sin embargo, por más exitosas que puedan ser estas aplicaciones para calmar ansiedades menores, definitivamente no son la panacea para la salud mental que todos estábamos esperando.

Los chatbots de IA no son adecuados para enfermedades mentales graves

Sin duda, recibir consejos sensatos y aprobados por un terapeuta de un chatbot de bolsillo será útil para muchos. Sin embargo, aquellos que padecen enfermedades mentales graves como depresión, esquizofrenia y trastorno bipolar probablemente se quedarán defraudados.

Los trastornos mentales son complejos, tienen muchos matices y son únicos para cada persona a la que afectan. En algunos casos, se tratan mejor con medicamentos que sólo pueden recetarse correctamente por profesionales médicos cualificados. Si bien los grandes modelos de lenguaje (LLM) han evolucionado a pasos agigantados en los últimos años, su producción nunca podrá reemplazar la experiencia clínica, la empatía y la compasión brindadas por psiquiatras, psicólogos y terapeutas.

“Aprecio que los algoritmos hayan mejorado, pero en última instancia no creo que vayan a abordar las realidades sociales más confusas en las que se encuentran las personas cuando buscan ayuda”, – Julia Brown, profesora de antropología en la Universidad de California, San Francisco.

El sanador psíquico estratégico Aanant Bisht también cree que la IA, en su estado actual, será incapaz de ayudar en el complejo viaje de curación de cada usuario. "También es esencial evitar la simplificación excesiva de los problemas complejos de salud mental y alentar a los usuarios a buscar ayuda profesional cuando sea necesario", dice Bisht a Tech.co.

Otra preocupación común expresada por los expertos con los que hablamos es el diagnóstico médico erróneo. La comunidad de salud mental tiene un problema de larga data a la hora de identificar correctamente los trastornos psiquiátricos complejos y graves, y una gran dependencia de la IA probablemente podría exacerbar este problema, debido a las tecnologías limitadas, los conjuntos de datos no representativos y la incapacidad para interpretar los matices humanos.

Los resultados de esto también pueden ser crudos. Un diagnóstico erróneo de salud mental a menudo conduce a un tratamiento y apoyo inadecuados, presiones mentales adicionales y escepticismo a largo plazo hacia el sistema médico. Esta no es la única razón por la que la inteligencia artificial no es apta para ocupar la silla del terapeuta en su forma actual.

La IA tiene fallas y está rodeada de desafíos éticos

El rápido ascenso de la IA generativa no ha estado exento de consecuencias. A medida que la tecnología continúa desarrollándose a una velocidad vertiginosa, la regulación sobre su uso ha tardado en ponerse al día, lo que ha contribuido a una serie de desafíos éticos relacionados con la privacidad de los datos, los sesgos incorporados y el uso indebido.

Estas preocupaciones no son exclusivas de la terapia, pero la naturaleza sensible de la salud mental significa que los marcos éticos están en el centro de cualquier buena relación terapéutica. Dado que actualmente no existe un código de ética oficial de IA , es muy problemático que los usuarios dependan de chatbots en lugar de profesionales calificados para recibir asesoramiento u otro apoyo de salud mental.

La privacidad de los datos es un tema importante. Los chatbots como ChatGPT con frecuencia se han visto envueltos en problemas por no proteger los datos de los usuarios . Para que los usuarios se sientan cómodos hablando de información personal y privada, las empresas de inteligencia artificial necesitarán tener una estrategia de protección de datos infalible que priorice la confidencialidad.

"La naturaleza íntima y sensible de las conversaciones terapéuticas exige un nivel incomparable de protección de datos". – Dr. Langham, psicólogo de Impulse Therapy

Otro factor importante a tener en cuenta es el sesgo del aprendizaje automático. Todos los sistemas de IA se basan en datos de entrenamiento predeterminados, que a menudo incluyen sesgos humanos incorporados, incluso si se eliminan variables sensibles como la raza y el género.

Según Bayu Prihandito, director ejecutivo de la empresa de coaching de vida Life Architekture , si la IA se entrena con datos sesgados, “podría perpetuar o exacerbar los sesgos existentes, lo que llevaría a recomendaciones de tratamiento injustas”. Es probable que estos prejuicios incorporados también afecten más a las personas de grupos minoritarios, lo que destaca la importancia de la supervisión humana y de conjuntos de datos de capacitación diversos y representativos.

La IA como asistente de los terapeutas, no como reemplazo

Compañeros amigables como Pi y Woebot solo crecerán en popularidad a medida que los usuarios continúen buscando formas accesibles de complementar su bienestar mental. Sin embargo, debido a una amplia gama de preocupaciones éticas, la inteligencia artificial no está lista para reemplazar el papel de la terapia tradicional, ni debería estarlo nunca.

Sin embargo, esto no quiere decir que la tecnología emergente no tenga un impacto masivo en la práctica en su conjunto. La mayoría de los profesionales con los que hablamos creen que al realizar el trabajo duro, como la clasificación, las herramientas de IA podrán darles más tiempo y energía para dedicar a otras áreas de la práctica.

"Si bien no puede reemplazar la profunda conexión humana que ofrecen los terapeutas, puede servir como una herramienta complementaria". – Aanant Bish, coach psíquico empresarial

"La IA podría manejar evaluaciones iniciales, monitoreo continuo y brindar apoyo para casos menos complejos, permitiéndonos centrarnos en situaciones más graves o delicadas", dijo Bayu Prihandito a Tech.co, y agregó: " Es como tener un par de manos extra que siempre están disponible."

Sultan, profesor de Columbia y psiquiatra certificado, está de acuerdo y le dice a Tech.co que dentro de cinco años, la IA probablemente complementará la terapia tradicional al agilizar las tareas administrativas, ayudar a los profesionales a crear planes de tratamiento más personalizados y " crear modelos híbridos que combinen la experiencia humana con la IA". herramientas impulsadas para mejorar el tratamiento”.

Esto sugiere que, lejos de agotar la humanidad de la práctica, la IA en realidad tiene el poder de liberar habilidades humanas como la empatía, la conexión y la compasión, ayudando a los clientes a aprovechar aún más el servicio.

Sin embargo, cuidar la salud mental es algo serio y, a menudo, puede ser una cuestión de vida o muerte. Antes de que la IA se convierta en el asistente de todos los terapeutas, o incluso los reemplace, es necesario considerar regulaciones estrictas sobre su implementación y uso.

Hasta que llegue ese momento, el claro potencial de los chatbots de IA para mejorar el acceso al apoyo a la salud mental no puede conciliarse completamente con los riesgos que plantean. En un mundo donde los dilemas éticos suelen ser habituales, éste es simplemente demasiado grande para ignorarlo.