Estafas de clonación de voz con IA: 1 de cada 4 adultos ya está en el punto de mira

Publicado: 2023-05-02¿Crees que podrías notar la diferencia entre un mensaje de voz de alguien que amas y un mensaje de voz generado por IA? Bueno, los estafadores que usan la tecnología de clonación de voz de IA para defraudar a las víctimas desprevenidas ciertamente esperan que usted no pueda, y ahora están más activos que nunca.

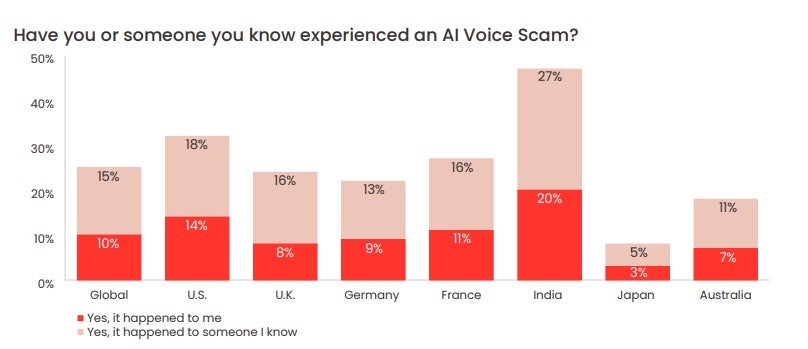

Una encuesta realizada recientemente por McAfee encontró que una cuarta parte de los adultos ya han sido objeto de estafas de voz de IA, y como resultado, la gran mayoría ha perdido el dinero que tanto le costó ganar. También reveló que la mayoría de los adultos comparten su voz en las plataformas de redes sociales y otros espacios en línea al menos una vez a la semana, lo que brinda a los actores de amenazas exactamente lo que necesitan para llevar a cabo este tipo de estafa una y otra vez.

Entonces, ¿cómo funcionan realmente las estafas de clonación de voz de IA, qué tan común es y cómo puede detectar una estafa de clonación de voz de IA? Echamos un vistazo más de cerca.

- ¿Qué es una estafa de clonación de voz de IA?

- Cómo funciona realmente la clonación de voz con IA

- ¿Qué tan comunes son las estafas de clones de voz de IA?

- Cómo saber si un mensaje es una estafa de clonación de voz de AI

¿Qué es una estafa de clonación de voz de IA?

Una estafa de clonación de voz de IA es cualquier estafa que utiliza archivos de audio generados artificialmente para engañar a las víctimas haciéndoles creer que sus seres queridos están en peligro o necesitan asistencia financiera urgente y se han puesto en contacto con ellos para pedir ayuda.

En una estafa de este tipo, un estafador reproducirá un clip de un sujeto hablando, a menudo extraído de las redes sociales, a través de un generador de voz de IA. Usando el aprendizaje automático, el generador analizará la cadencia, el tono y el tono del clip inicial, y luego permitirá que el estafador produzca un audio único y original que imita la voz de los sujetos casi a la perfección.

El estafador luego enviará estas grabaciones a amigos y familiares del sujeto a través de aplicaciones como WhatsApp, con la esperanza de que no puedan distinguir entre su ser querido y una versión de su voz generada por IA.

Como es común en otras estafas en línea , el estafador intentará inyectar un sentido de urgencia y angustia en su correspondencia, para empujar al objetivo a actuar de manera precipitada o errática.

En un caso reciente, un estafador de voz de IA trató de convencer a una madre en los EE. UU. de que su hija había sido secuestrada mediante la clonación de la voz de la niña.

De manera preocupante, a un estafador en ciernes no le resultará difícil desenterrar los archivos de audio que necesitará para atacar a una víctima; de hecho, es probable que tenga muchas opciones.

Una encuesta de mayo de 2023 publicada por McAfee en la que participaron más de 7000 personas de siete países diferentes encontró que el 53 % de los encuestados dijeron que comparten su voz en línea al menos una vez a la semana. En India, esta cifra fue del 86%.

Cómo funciona realmente la clonación de voz

La clonación de voz de IA solo es posible con una herramienta de IA llamada generador de voz de IA. En pocas palabras, los generadores de voz de IA convierten los archivos de texto en voz (a menudo llamada herramienta de "texto a voz" o "TTS").

Los generadores de voz de IA utilizan el aprendizaje automático para aprender a hablar de maneras específicas mediante el análisis de la información de los archivos de audio de las personas que hablan. Luego, los generadores aplican lo que han aprendido para leer archivos de texto proporcionados por los usuarios y generar contenido de audio original.

Muchos de estos generadores tienen voces personalizadas que puede seleccionar para leer su texto, así como voces de celebridades para elegir, pero otros le permitirán grabar su propia voz y crear contenido de audio posterior.

La herramienta de texto a voz Descript.com ofrece un autodenominado "generador de voz de última generación que crea un clon ultrarrealista de su propia voz".

Los generadores de voz de IA ahora están ampliamente disponibles para todo tipo de dispositivos. Estos programas brindan mucho valor a las personas que tienen dificultades para leer, o simplemente aprenden mejor cuando escuchan audio en lugar de leer la palabra escrita.

También son utilizados por empresas de publicidad que no tienen presupuesto para contratar a un locutor costoso para su contenido de marketing.

El éxito y el uso generalizado de ChatGPT ha puesto un enfoque renovado en las herramientas de IA de todas las formas y tamaños, incluidas las que se pueden usar para la clonación de audio. A pesar de sus usos nobles, ahora existe un pequeño ecosistema de herramientas TTS AI que, lamentablemente, pueden ser objeto de abuso para fines nefastos, incluida la estafa a las personas.

¿Qué tan comunes son las estafas de clones de voz de IA?

En la encuesta de McAfee publicada recientemente, el gigante de la ciberseguridad descubrió que 1 de cada 4 adultos encuestados ha experimentado una estafa de voz de IA.

El 77 % de los destinatarios informaron que perdieron dinero debido a la estafa. McAfee informa que de ese 77%, "más de un tercio perdió más de $1,000, mientras que el 7% fue engañado con entre $5,000 y $15,000".

Las víctimas en los EE. UU. son las que más pierden, revela la encuesta. El 11% de las víctimas de EE. UU. que perdieron dinero a través de estafas de clonación de voz de IA perdieron entre $ 5,000 y $ 15,000.

Cómo saber si un mensaje es una estafa de clonación de voz de AI

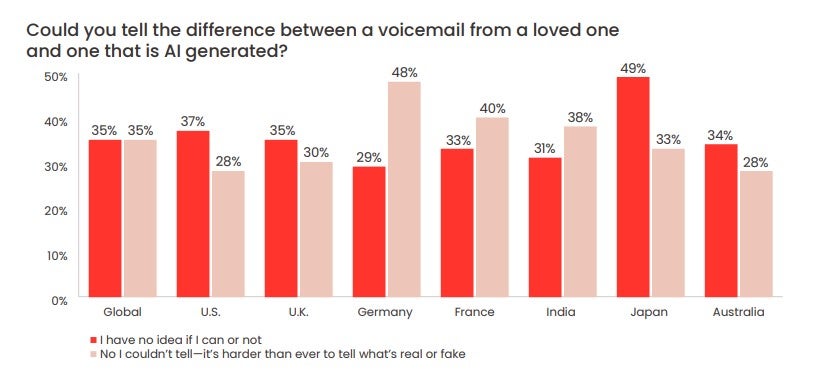

La encuesta de McAfee también encontró que el 70 % de las personas dijeron que no estaban "seguras" de poder diferenciar entre una voz de IA y una humana.

Casi un tercio (28%) de los encuestados de EE. UU. dijo que no sería capaz de diferenciar entre un mensaje de voz dejado por un "impostor artificial", como dice McAfee, y un ser querido.

Recuerde, los estafadores pueden replicar la voz de un ser querido, pero controlar el número o la cuenta de WhatsApp de su ser querido es mucho más difícil.

Puede ser difícil actuar con calma cuando parece que uno de sus familiares o amigos está angustiado. Pero con las estafas de voz de IA cada vez más comunes, es importante que lo haga. Hay algunas señales de que un mensaje de voz de IA podría ser una estafa:

- Un método de contacto inusual (por ejemplo, un número desconocido)

- Solicitudes inmediatas de grandes cantidades de dinero

- Solicitudes de transferencia de dinero a través de medios inusuales (por ejemplo, tarjetas de regalo o criptomonedas)

- Una demanda de que no le cuentes a nadie sobre la llamada/incidente

Con eso en mente, esto es lo que la FTC le aconseja que haga:

- Llama al número que te dejó el mensaje para verificar quién es

- Llame a su ser querido o amigo a su número personal

- Enviar mensajes a familiares y amigos cercanos de la persona en cuestión.

Si no puede ponerse en contacto, es importante que informe a la policía de inmediato. Para aquellos de ustedes que aún no han sido blanco de una de estas estafas pero quieren asegurarse de no ser víctimas de una, establezcan una palabra segura con su familia y amigos.

Este es un código que significa que usted y sus seres queridos pueden identificarse entre sí y es una de las mejores maneras de asegurarse de no ser víctima de una estafa de voz de IA. Esto será particularmente útil para los miembros mayores de la familia y, si nunca se escribe, puede mantenerse bastante simple.

También es importante mantenerse al día con los últimos métodos, técnicas y formatos que los estafadores de voz de IA utilizan para extorsionar a las víctimas. Además de estar atento y tratar las llamadas de números desconocidos con extrema precaución, lo mejor que puede hacer es mantener el oído en el suelo.