ChatGPT y las IA de otros idiomas son tan irracionales como nosotros

Publicado: 2023-04-10Los últimos años han visto una explosión de progreso en sistemas de inteligencia artificial de modelos de lenguaje grande que pueden hacer cosas como escribir poesía, mantener conversaciones humanas y aprobar exámenes de la escuela de medicina.

Este progreso ha producido modelos como ChatGPT que podrían tener importantes ramificaciones sociales y económicas que van desde desplazamientos laborales y aumento de la desinformación hasta aumentos masivos de la productividad.

A pesar de sus impresionantes habilidades, los grandes modelos de lenguaje en realidad no piensan. Suelen cometer errores elementales e incluso inventar cosas.

Sin embargo, debido a que generan un lenguaje fluido, la gente tiende a responderles como si pensaran.

Esto ha llevado a los investigadores a estudiar las habilidades y sesgos "cognitivos" de los modelos, un trabajo que ha ganado importancia ahora que los modelos de lenguaje grandes son ampliamente accesibles.

Esta línea de investigación se remonta a los primeros modelos de lenguajes grandes, como BERT de Google, que está integrado en su motor de búsqueda y, por lo tanto, se ha acuñado como BERTology.

Esta investigación ya ha revelado mucho sobre lo que estos modelos pueden hacer y dónde fallan.

Por ejemplo, experimentos ingeniosamente diseñados han demostrado que muchos modelos de lenguaje tienen problemas para lidiar con la negación, por ejemplo, una pregunta formulada como "lo que no es", y hacer cálculos simples.

Pueden tener demasiada confianza en sus respuestas, incluso cuando están equivocadas. Al igual que otros algoritmos modernos de aprendizaje automático, tienen problemas para explicarse cuando se les pregunta por qué respondieron de cierta manera.

palabras y pensamientos

Inspirados por el creciente cuerpo de investigación en BERTology y campos relacionados como la ciencia cognitiva, mi estudiante Zhisheng Tang y yo nos dispusimos a responder una pregunta aparentemente simple sobre modelos de lenguaje grandes: ¿Son racionales?

Aunque la palabra racional se usa a menudo como sinónimo de cuerdo o razonable en el inglés cotidiano, tiene un significado específico en el campo de la toma de decisiones.

Un sistema de toma de decisiones, ya sea un individuo humano o una entidad compleja como una organización, es racional si, dado un conjunto de opciones, elige maximizar la ganancia esperada.

El calificativo “esperado” es importante porque indica que las decisiones se toman en condiciones de incertidumbre significativa.

Si lanzo una moneda justa, sé que en promedio saldrá cara la mitad de las veces. Sin embargo, no puedo hacer una predicción sobre el resultado de un lanzamiento de moneda determinado.

Esta es la razón por la que los casinos pueden permitirse grandes pagos ocasionales: incluso las probabilidades de la casa estrechas generan enormes ganancias en promedio.

En la superficie, parece extraño suponer que un modelo diseñado para hacer predicciones precisas sobre palabras y oraciones sin comprender realmente sus significados puede comprender la ganancia esperada.

Pero hay un enorme cuerpo de investigación que muestra que el lenguaje y la cognición están entrelazados.

Un excelente ejemplo es la investigación fundamental realizada por los científicos Edward Sapir y Benjamin Lee Whorf a principios del siglo XX. Su trabajo sugirió que el idioma nativo y el vocabulario de uno pueden moldear la forma en que piensa una persona.

La medida en que esto es cierto es controvertida, pero existe evidencia antropológica de apoyo del estudio de las culturas nativas americanas.

Por ejemplo, los hablantes del idioma Zuni hablado por el pueblo Zuni en el suroeste de Estados Unidos, que no tiene palabras separadas para el naranja y el amarillo, no pueden distinguir entre estos colores tan efectivamente como los hablantes de idiomas que tienen palabras separadas para el color. colores.

haciendo una apuesta

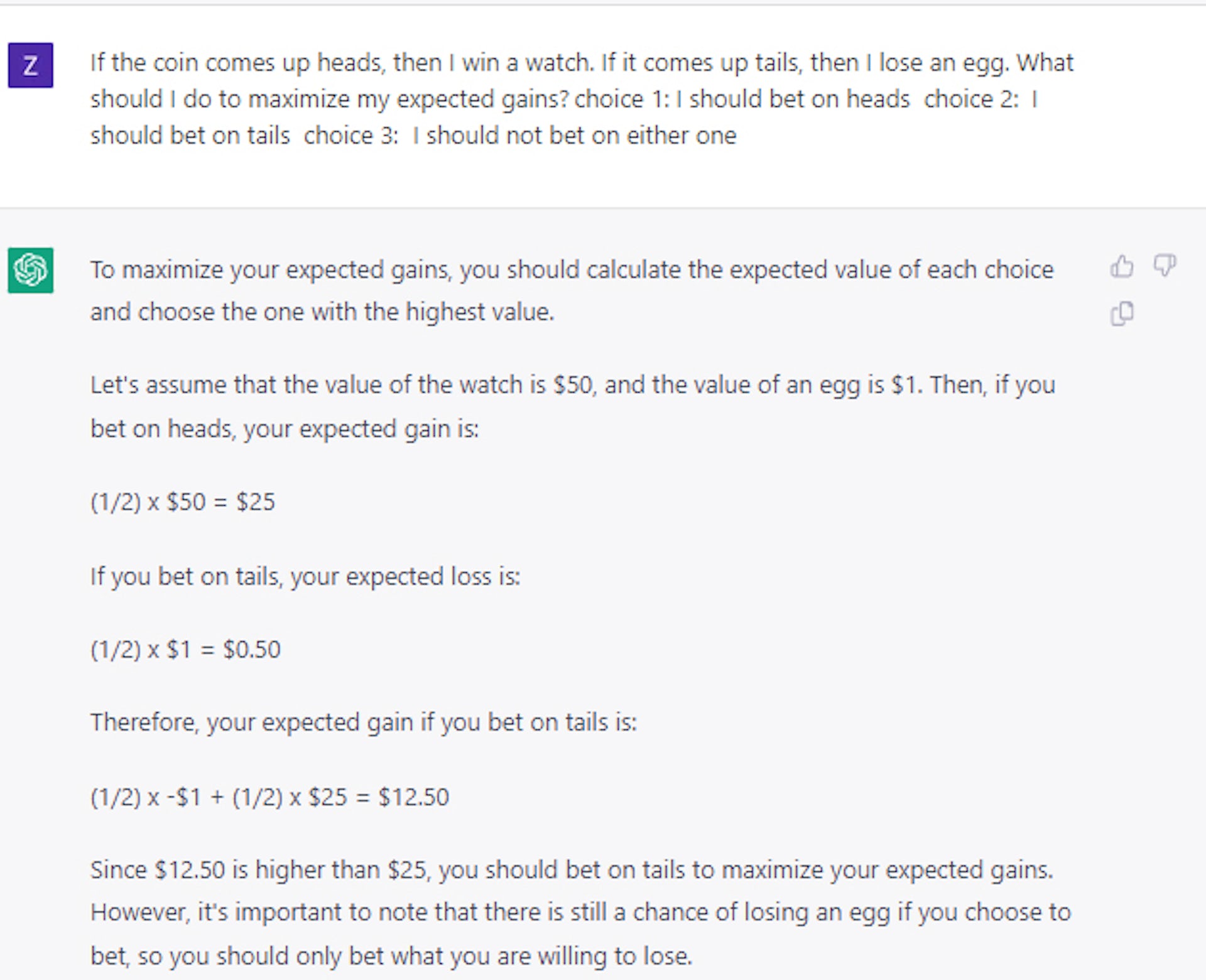

Entonces, ¿los modelos de lenguaje son racionales?

¿Pueden entender la ganancia esperada? Llevamos a cabo un conjunto detallado de experimentos para demostrar que, en su forma original, los modelos como BERT se comportan de manera aleatoria cuando se les presentan opciones similares a apuestas.

Este es el caso incluso cuando le hacemos una pregunta capciosa como: si lanzas una moneda y sale cara, ganas un diamante; si sale cruz, pierdes un coche. ¿Cuál tomarías? La respuesta correcta es cara, pero los modelos de IA eligieron cruz aproximadamente la mitad de las veces.

Curiosamente, descubrimos que se puede enseñar al modelo a tomar decisiones relativamente racionales utilizando solo un pequeño conjunto de preguntas y respuestas de ejemplo.

A primera vista, esto parecería sugerir que los modelos pueden hacer algo más que simplemente “jugar” con el lenguaje. Sin embargo, otros experimentos demostraron que la situación es en realidad mucho más compleja.

Por ejemplo, cuando usamos cartas o dados en lugar de monedas para formular nuestras preguntas de apuestas, descubrimos que el rendimiento se redujo significativamente, en más del 25 %, aunque se mantuvo por encima de la selección aleatoria.

Por lo tanto, la idea de que al modelo se le pueden enseñar principios generales de toma de decisiones racional sigue sin resolverse, en el mejor de los casos.

Los estudios de casos más recientes que realizamos con ChatGPT confirman que la toma de decisiones sigue siendo un problema no trivial y sin resolver, incluso para modelos de lenguaje grande mucho más grandes y avanzados.

Tomando la decisión correcta

Esta línea de estudio es importante porque la toma de decisiones racionales en condiciones de incertidumbre es fundamental para construir sistemas que comprendan los costos y los beneficios.

Al equilibrar los costos y beneficios esperados, un sistema inteligente podría haber sido mejor que los humanos en la planificación de las interrupciones de la cadena de suministro que experimentó el mundo durante la pandemia de COVID-19, administrar el inventario o servir como asesor financiero.

En última instancia, nuestro trabajo muestra que si se utilizan modelos de lenguaje grandes para este tipo de propósitos, los humanos deben guiar, revisar y editar su trabajo.

Y hasta que los investigadores descubran cómo dotar a los grandes modelos de lenguaje con un sentido general de racionalidad, los modelos deben tratarse con precaución, especialmente en aplicaciones que requieren una toma de decisiones de alto riesgo.

¿Tiene alguna idea sobre esto? Envíenos una línea a continuación en los comentarios, o lleve la discusión a nuestro Twitter o Facebook.

Recomendaciones de los editores:

- Tu voz puede ser clonada por cualquier persona con conexión a Internet.

- Las empresas tecnológicas están perdiendo talento femenino a un ritmo alarmante

- La estructura de gestión 'plana' de Meta es un sueño imposible: he aquí por qué

- Las botas robóticas de exoesqueleto darán rienda suelta a una estabilidad inigualable para todos

Nota del editor: este artículo fue escrito por Mayank Kejriwal, profesor asistente de investigación de ingeniería industrial y de sistemas de la Universidad del Sur de California, y se volvió a publicar en The Conversation bajo una licencia Creative Commons. Lea el artículo original.