De los datos a la información: automatizar la recopilación de datos en línea a gran escala

Publicado: 2024-11-18Solo un aviso: si compra algo a través de nuestros enlaces, es posible que obtengamos una pequeña parte de la venta. Es una de las formas en que mantenemos las luces encendidas aquí. Haga clic aquí para obtener más información.

Para superar a sus competidores, necesita saber cómo se están desempeñando.

Para ofrecer productos y servicios que utilizará su público objetivo, debe saber lo que está buscando. Para predecir las tendencias del mercado, es necesario conocer las condiciones actuales del mercado.

Cualesquiera que sean sus metas y objetivos, si desea que su negocio prospere, necesita acceso a datos relevantes, oportunos y de alta calidad.

Después de todo, sólo con datos precisos se pueden generar conocimientos que le ayudarán a tomar mejores decisiones basadas en datos.

Si bien la calidad de los datos es fundamental, no se debe ignorar la cantidad. Afortunadamente, puedes automatizar la recopilación de datos a gran escala y disfrutar de ambos beneficios con herramientas como Scraper API. Obtenga más información a continuación.

La importancia de la recopilación de datos para las empresas

La recopilación de datos es esencial para empresas de todos los tamaños, ya que le ayuda a acelerar la expansión empresarial y mejorar sus procesos de toma de decisiones.

Ofrece una variedad de beneficios que pueden ayudar a preparar su negocio para el futuro:

- Mejora la generación de leads;

- Mejora la retención de clientes;

- Minimiza los riesgos;

- Predice la demanda;

- Mejora la comprensión de los comportamientos de los clientes;

- Predice la actividad de la competencia;

- Mejora las estrategias de marketing;

- Libera oportunidades de crecimiento.

Sin datos relevantes, cualquier decisión que tomes se basará simplemente en tu instinto, exponiéndote a riesgos innecesarios y aumentando tus posibilidades de fracaso.

A través de una recopilación completa de datos y un análisis exhaustivo, puede obtener información valiosa para mejorar su rendimiento y garantizar su éxito.

Uso del web scraping para agilizar los procesos de recopilación de datos

Aunque existen innumerables métodos de recopilación de datos, incluidas entrevistas y grupos focales, encuestas y formularios, la extracción de datos en línea le brinda acceso a los mayores volúmenes de datos.

La extracción de datos en línea es el proceso de visitar todos los sitios web relevantes de su industria y recopilar los datos que su empresa necesita.

Puede recopilar estadísticas detalladas de sitios web de alta autoridad en su nicho, reseñas de usuarios de sitios web de terceros, información de precios de sitios web de la competencia y más.

En los próximos años, se espera que la creación global de datos crezca a más de 180 zettabytes, lo que le brindará acceso a muchas fuentes y abundantes volúmenes de datos.

El único problema es que recopilar manualmente todos los datos necesarios puede ser un bocado más grande de lo que puedes masticar.

Para la recopilación de datos en línea a gran escala, necesitará automatizar sus procesos y, afortunadamente, puede hacerlo fácilmente mediante el web scraping.

El web scraping implica el uso de robots scraper para la extracción de datos.

Todo lo que tendrá que hacer es programar estos robots para que rastreen cualquier página web que necesite, especificar el tipo de datos que desea que extraigan y establecer su formato de extracción preferido. A partir de ahí se encargan de todo lo demás.

Los web scrapers pueden rastrear cientos de páginas web prácticamente en poco tiempo, ofreciendo la máxima velocidad y eficiencia.

Eliminan los riesgos de error humano, minimizan los gastos y ofrecen resultados precisos y de alta calidad tan pronto como los necesita.

Las dos mejores herramientas de web scraping

Al elegir web scrapers para la recopilación y extracción de datos, tendrá varias opciones, en particular, web scrapers tradicionales, como Scraper API o scrapers sin código.

Ambos tienen ventajas y desventajas únicas que pueden ayudarle a determinar la mejor solución.

Los web scrapers tradicionales requieren habilidades de codificación, ya que necesitarás interactuar con ellos a través de un lenguaje programático.

Sin embargo, su velocidad, eficiencia, capacidad para manejar tecnología anti-bot, páginas web dinámicas, personalización y más los diferencian de los raspadores sin código.

Ventajas de los web scrapers tradicionales:

- Flexible;

- Eficiente;

- Personalizable.

Desventajas del web scraper tradicional:

- Requerir habilidades de codificación;

Debido a la extensa codificación requerida, los web scrapers tradicionales se adaptan mejor a las empresas que requieren scraping a gran escala.

Son herramientas potentes, pero requerirán mayores inversiones de tiempo.

La buena noticia es que pueden integrarse fácilmente en su infraestructura existente y son perfectamente personalizables para satisfacer sus necesidades específicas.

Los scrapers sin código son generalmente mucho más sencillos de usar.

Como sugiere su nombre, no requieren habilidades de codificación de su parte. Están totalmente automatizados desde el principio y puedes empezar a utilizarlos inmediatamente.

Ventajas del raspador sin código:

- Totalmente automatizado;

- No requiere habilidades de codificación;

- Sin mantenimiento.

Contras del raspador sin código:

- No personalizable;

Debido a su facilidad de uso, los scrapers sin código suelen ser más adecuados para individuos y pequeñas empresas sin grandes necesidades de recopilación de datos.

Si bien pueden ser eficientes a menor escala, pueden volverse limitantes a medida que aumentan sus necesidades de datos.

Cómo y cuándo utilizar estos web scrapers

Dependiendo de sus necesidades, los scrapers tradicionales y sin código pueden ser valiosos ya que tienden a tener casos de uso diferentes.

Los raspadores web tradicionales como Scraper API se usan más comúnmente para:

- Investigación de audiencia;

- Investigación de mercado;

- Análisis de la competencia.

Por otro lado, los web scrapers sin código se utilizan más comúnmente para:

- Comparaciones de precios;

- Monitoreo de revisión;

- Gestión de la reputación.

Como regla general, será mejor que utilice raspadores tradicionales para manejar grandes volúmenes de datos cuantitativos y cualitativos. Los raspadores sin código pueden resultar útiles para volúmenes más pequeños de datos cuantitativos.

Conclusión

Automatizar la recopilación de datos a gran escala es fundamental para mantenerse al tanto de las tendencias del mercado, familiarizarse con su público objetivo y superar a sus competidores.

Puede generar información valiosa que puede impulsar su negocio solo con datos precisos y oportunos.

¿Tiene alguna idea sobre esto? Escríbanos a continuación en los comentarios o lleve la discusión a nuestro Twitter o Facebook.

Recomendaciones de los editores:

Bluetti y ONU-Hábitat se asocian para impulsar la energía limpia en África

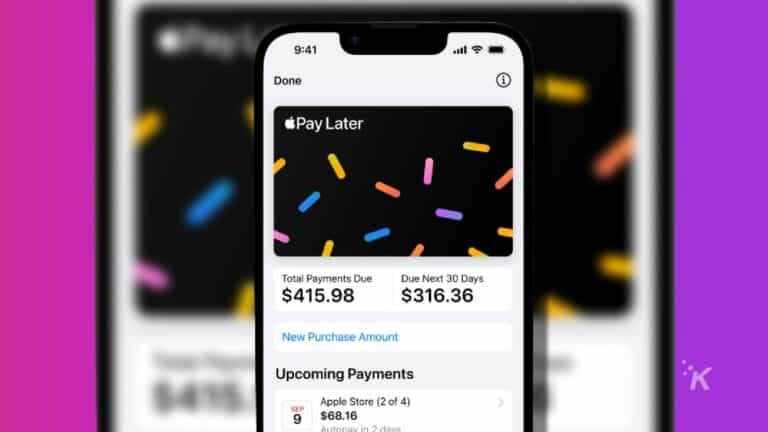

¿Por qué utilizar aplicaciones de comprar ahora y pagar después en 2024?

Desbloquee la central eléctrica todopoderosa Elite 200 V2 durante la oferta del Black Friday de BLUETTI

Divulgación: esta es una publicación patrocinada. Sin embargo, nuestras opiniones, reseñas y otro contenido editorial no se ven influenciados por el patrocinio y siguen siendo objetivos .