Pourquoi les chatbots de thérapie par l'IA sont le dilemme éthique ultime

Publié: 2023-10-31Les chatbots d'IA générative comme ChatGPT sont utilisés pour rationaliser les processus de travail, écrire du code et même écrire des scripts pour des décors de stand-up. Aux États-Unis, où les cas d'anxiété et de dépression atteignent des niveaux records et où le soutien professionnel reste limité, il n'est pas surprenant que les utilisateurs utilisent également la technologie pour les aider à gérer leur santé mentale.

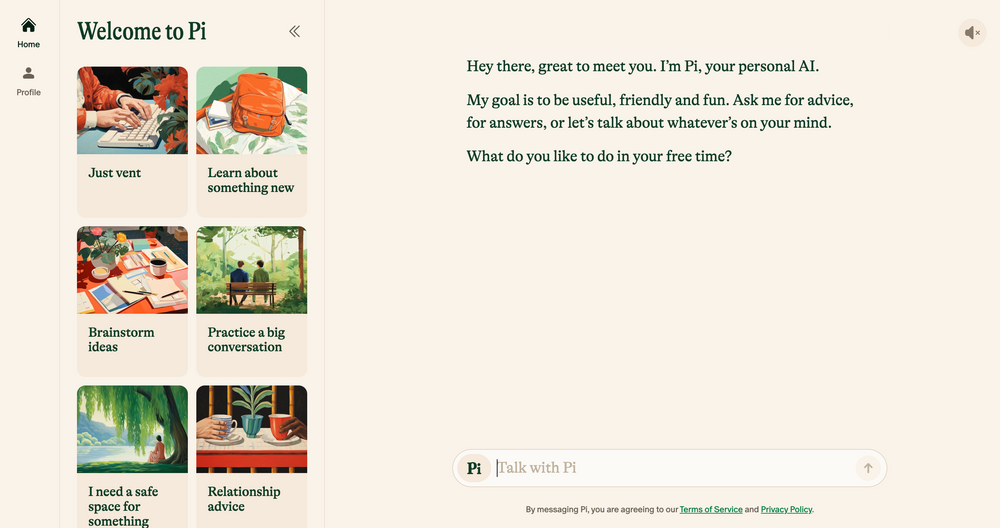

Les chatbots IA comme Elomia, Pi et Woebot offrent une assistance personnalisée et abordable 24h/24 et 7j/7, basée sur des techniques thérapeutiques éprouvées. Qu’il s’agisse d’aider les utilisateurs à éviter les longues listes d’attente ou de réduire la stigmatisation liée à l’accès à l’aide, leurs avantages sont énormes. L’IA générative – qui est encore sujette aux erreurs, aux hallucinations et aux préjugés – peut-elle un jour se comparer à l’empathie de l’oreille humaine ?

Nous avons discuté avec des universitaires, des psychologues et des thérapeutes en exercice pour faire la lumière sur la manière dont les technologies émergentes sont susceptibles de façonner l’avenir de la thérapie. Nous discutons également du côté le plus obscur de la thérapie par l’IA et identifions les préoccupations éthiques qui doivent être abordées aujourd’hui. Voici ce que nous avons trouvé.

Chatbots IA : la nouvelle génération de robots thérapeutes

Depuis le lancement du chatbot ChatGPT d'OpenAI en novembre dernier, une armée de copieurs de chatbots est apparue sur les magasins d'applications – depuis des applications à usage général comme Google Bard et Claude AI jusqu'aux simulateurs de personnages Marvel moins conventionnels.

Ce marché en plein essor a également conduit à l’essor des chatbots thérapeutiques basés sur l’IA – des applications qui utilisent l’IA générative pour imiter les conseils et l’orientation offerts par des thérapeutes qualifiés et des professionnels de la santé mentale.

Vous souhaitez naviguer sur le Web en privé ? Ou donner l'impression que vous êtes dans un autre pays ?

Vous souhaitez naviguer sur le Web en privé ? Ou donner l'impression que vous êtes dans un autre pays ?

Obtenez un énorme 86 % de réduction sur Surfshark avec cette offre Tech.co Black Friday. ![]()

Les principaux exemples incluent Pi, un « compagnon de discussion amical » autoproclamé qui agit comme une caisse de résonance et offre un soutien émotionnel ; Replika, un programme de chatbot qui imite le style de parole et la personnalité de ses utilisateurs ; et Earkick, un outil de suivi de l'anxiété conçu pour vous aider à vous connecter et à surmonter les émotions difficiles.

« Les plateformes basées sur l’IA garantissent la confidentialité, réduisant ainsi la stigmatisation souvent associée à la recherche d’aide pour des problèmes de santé mentale. » – Ryan Sultan, psychiatre certifié et professeur à l'Université de Columbia

Comme les meilleures applications de santé mentale , bon nombre de ces applications affichent déjà des téléchargements à six chiffres – et leur popularité n’est guère surprenante. En raison d’une pénurie de psychologues, de psychiatres et de travailleurs sociaux qualifiés, ainsi que d’une forte demande de services à travers le pays, les États-Unis sont actuellement aux prises avec l’une des pires crises de santé mentale jamais enregistrées.

Le coût élevé des thérapies traditionnelles et les tabous autour de la santé mentale dissuadent également de nombreuses personnes de recourir aux options conventionnelles, créant ainsi un vide vers des alternatives plus discrètes et abordables.

Les premières preuves suggèrent qu'ils sont également efficaces. Les propres conclusions d'Earkick d'AI Chatbot ont révélé que l'humeur de son utilisateur s'est améliorée de 34 % et que les niveaux d'anxiété ont chuté de 32 % après avoir suivi l'application pendant cinq mois. Cependant, aussi efficaces que soient ces applications pour apaiser les anxiétés mineures, elles ne sont certainement pas la panacée en matière de santé mentale que nous attendions tous.

Les chatbots IA ne conviennent pas aux problèmes de santé mentale graves

Recevoir des conseils judicieux et approuvés par un thérapeute d'un chatbot de poche sera sans aucun doute utile pour beaucoup. Cependant, ceux qui souffrent de problèmes de santé mentale graves comme la dépression, la schizophrénie et le trouble bipolaire seront probablement laissés pour compte.

Les troubles mentaux sont complexes, très nuancés et propres à chaque personne qu’ils touchent. Dans certains cas, ils sont mieux gérés avec des médicaments qui ne peuvent être correctement prescrits que par des professionnels de la santé qualifiés. Bien que les grands modèles linguistiques (LLM) aient évolué à pas de géant ces dernières années, leurs résultats ne pourront jamais remplacer l'expertise clinique, l'empathie et la compassion fournies par les psychiatres, les psychologues et les thérapeutes.

"J'apprécie que les algorithmes se soient améliorés, mais en fin de compte, je ne pense pas qu'ils répondront aux réalités sociales plus compliquées dans lesquelles se trouvent les gens lorsqu'ils cherchent de l'aide", - Julia Brown, professeur d'anthropologie à l'Université de Californie à San Francisco.

Le guérisseur psychique stratégique Aanant Bisht estime également que l'IA, dans son état actuel, sera incapable d'aider le parcours de guérison complexe de chaque utilisateur. "Il est également essentiel d'éviter une simplification excessive des problèmes de santé mentale complexes et d'encourager les utilisateurs à demander l'aide d'un professionnel en cas de besoin", explique Bisht à Tech.co.

Une autre préoccupation courante exprimée par les experts avec lesquels nous avons parlé est l’erreur de diagnostic médical. La communauté de la santé mentale a depuis longtemps un problème avec l’identification correcte des troubles psychiatriques complexes et graves, et une forte dépendance à l’IA pourrait probablement exacerber ce problème, en raison des technologies limitées, des ensembles de données non représentatifs et de l’incapacité à interpréter les nuances humaines.

Les résultats peuvent également être désastreux. Un diagnostic erroné de santé mentale conduit souvent à un traitement et un soutien inadéquats, à des pressions mentales supplémentaires et à un scepticisme à long terme à l’égard du système médical. Ce n’est pas la seule raison pour laquelle l’intelligence artificielle n’est pas apte à supplanter le fauteuil du thérapeute dans sa forme actuelle.

L’IA est imparfaite et entourée de défis éthiques

L’essor rapide de l’IA générative n’est pas sans conséquences. Alors que la technologie continue de se développer à une vitesse vertigineuse, la réglementation autour de son utilisation a mis du temps à rattraper son retard, contribuant ainsi à une série de défis éthiques liés à la confidentialité des données, aux préjugés intégrés et aux abus.

Ces préoccupations ne sont pas propres à la thérapie, mais la nature sensible de la santé mentale signifie que les cadres éthiques sont au cœur de toute bonne relation thérapeutique. Avec un code d’éthique officiel de l’IA actuellement inexistant, les utilisateurs s’appuyant sur des chatbots plutôt que sur des professionnels qualifiés pour des conseils ou autre soutien en matière de santé mentale sont très problématiques.

La confidentialité des données est un problème majeur. Les chatbots comme ChatGPT se sont souvent retrouvés dans une situation délicate pour avoir échoué à protéger les données des utilisateurs . Pour que les utilisateurs se sentent à l’aise pour discuter d’informations privées et personnelles, les sociétés d’IA devront disposer d’une stratégie de protection des données infaillible qui donne la priorité à la confidentialité.

« La nature intime et sensible des conversations thérapeutiques exige un niveau de protection des données sans précédent. » – Dr Langham, psychologue chez Impulse Therapy

Un autre facteur important à prendre en compte est le biais d’apprentissage automatique. Tous les systèmes d'IA s'appuient sur des données d'entraînement prédéterminées, qui incluent souvent des préjugés humains intégrés, même si des variables sensibles telles que la race et le sexe sont supprimées.

Selon Bayu Prihandito, PDG de la société de coaching de vie Life Architekture , si l'IA est formée sur des données biaisées, « elle pourrait perpétuer ou exacerber les préjugés existants, conduisant à des recommandations de traitement inéquitables ». Ces préjugés inhérents sont susceptibles d’avoir également un impact plus important sur les personnes issues de groupes minoritaires, soulignant l’importance de la surveillance humaine et d’ensembles de données de formation diversifiés et représentatifs.

L'IA comme assistante des thérapeutes, pas comme remplacement

Les compagnons amicaux comme Pi et Woebot ne feront que gagner en popularité à mesure que les utilisateurs continuent de rechercher des moyens accessibles pour compléter leur bien-être mental. Cependant, en raison d’un large éventail de préoccupations éthiques, l’intelligence artificielle n’est pas prête à remplacer le rôle de la thérapie traditionnelle, et elle ne devrait jamais le faire.

Cela ne veut pas dire pour autant que la technologie émergente n’aura pas un impact massif sur la pratique dans son ensemble. La plupart des praticiens avec lesquels nous avons parlé pensent qu’en effectuant des tâches fastidieuses telles que le tri, les outils d’IA pourront leur donner plus de temps et d’énergie à consacrer à d’autres domaines de la pratique.

"Bien qu'il ne puisse pas remplacer la connexion humaine profonde qu'offrent les thérapeutes, il peut servir d'outil complémentaire." – Aanant Bish, coach psychique d’affaires

"L'IA pourrait gérer les évaluations initiales, la surveillance continue et fournir une assistance pour les cas moins complexes, nous permettant ainsi de nous concentrer sur des situations plus graves ou délicates", a déclaré Bayu Prihandito à Tech.co, ajoutant " C'est comme avoir une paire de mains supplémentaires qui sont toujours disponibles". disponible."

Sultan, professeur à Columbia et psychiatre certifié, est d'accord, déclarant à Tech.co que dans cinq ans, l'IA complétera probablement la thérapie traditionnelle en rationalisant les tâches administratives, en aidant les praticiens à créer des plans de traitement plus personnalisés et en « créant des modèles hybrides combinant l'expertise humaine avec l'IA ». outils pilotés pour améliorer le traitement ».

Cela suggère que loin de vider la pratique de son humanité, l’IA a en réalité le pouvoir de libérer des compétences humaines telles que l’empathie, la connexion et la compassion, aidant ainsi les clients à tirer encore davantage parti du service.

Cependant, prendre soin de sa santé mentale est une chose sérieuse et peut souvent être une question de vie ou de mort. Avant que l'IA ne devienne l'assistant de chaque thérapeute, voire ne les remplace, des réglementations strictes concernant son déploiement et son utilisation doivent être envisagées.

En attendant que ce moment arrive, le potentiel évident des chatbots IA pour améliorer l’accès au soutien en matière de santé mentale ne peut pas être pleinement concilié avec les risques qu’ils posent. Dans un monde où les dilemmes éthiques sont souvent monnaie courante, celui-ci est tout simplement trop important pour être ignoré.