ChatGPT et les autres IA linguistiques sont tout aussi irrationnels que nous

Publié: 2023-04-10Les dernières années ont vu une explosion des progrès dans les systèmes d'intelligence artificielle à grands modèles de langage qui peuvent faire des choses comme écrire de la poésie, mener des conversations humaines et réussir les examens des facultés de médecine.

Ces progrès ont donné naissance à des modèles comme ChatGPT qui pourraient avoir des ramifications sociales et économiques majeures allant des suppressions d'emplois et de la désinformation accrue à des gains de productivité massifs.

Malgré leurs capacités impressionnantes, les grands modèles de langage ne pensent pas réellement. Ils ont tendance à faire des erreurs élémentaires et même à inventer des choses.

Cependant, parce qu'ils génèrent un langage fluide, les gens ont tendance à y répondre comme s'ils pensaient.

Cela a conduit les chercheurs à étudier les capacités et les biais « cognitifs » des modèles, un travail qui a pris de l'importance maintenant que les grands modèles de langage sont largement accessibles.

Cette ligne de recherche remonte aux premiers grands modèles de langage tels que le BERT de Google, qui est intégré à son moteur de recherche et a donc été baptisé BERTology.

Cette recherche a déjà révélé beaucoup de choses sur ce que ces modèles peuvent faire et où ils vont mal.

Par exemple, des expériences intelligemment conçues ont montré que de nombreux modèles de langage ont du mal à gérer la négation - par exemple, une question formulée comme "ce qui n'est pas" - et à faire des calculs simples.

Ils peuvent être trop confiants dans leurs réponses, même lorsqu'ils se trompent. Comme d'autres algorithmes d'apprentissage automatique modernes, ils ont du mal à s'expliquer lorsqu'on leur demande pourquoi ils ont répondu d'une certaine manière

Mots et pensées

Inspirés par le nombre croissant de recherches en BERTologie et dans des domaines connexes comme les sciences cognitives, mon étudiant Zhisheng Tang et moi avons décidé de répondre à une question apparemment simple sur les grands modèles de langage : sont-ils rationnels ?

Bien que le mot rationnel soit souvent utilisé comme synonyme de sain d'esprit ou raisonnable dans l'anglais courant, il a une signification particulière dans le domaine de la prise de décision.

Un système de prise de décision – qu'il s'agisse d'un individu humain ou d'une entité complexe comme une organisation – est rationnel si, étant donné un ensemble de choix, il choisit de maximiser le gain attendu.

Le qualificatif « prévu » est important car il indique que les décisions sont prises dans des conditions d'incertitude importante.

Si je lance une pièce juste, je sais qu'elle tombera face la moitié du temps en moyenne. Cependant, je ne peux pas prédire le résultat d'un tirage au sort donné.

C'est pourquoi les casinos peuvent se permettre de gros gains occasionnels : même les cotes de la maison étroites rapportent en moyenne d'énormes profits.

À première vue, il semble étrange de supposer qu'un modèle conçu pour faire des prédictions précises sur les mots et les phrases sans réellement comprendre leur signification peut comprendre le gain attendu.

Mais il existe un énorme corpus de recherches montrant que le langage et la cognition sont étroitement liés.

Un excellent exemple est la recherche fondamentale menée par les scientifiques Edward Sapir et Benjamin Lee Whorf au début du XXe siècle. Leur travail a suggéré que la langue maternelle et le vocabulaire d'une personne peuvent façonner la façon dont une personne pense.

La mesure dans laquelle cela est vrai est controversée, mais il existe des preuves anthropologiques à l'appui de l'étude des cultures amérindiennes.

Par exemple, les locuteurs de la langue zuni parlée par le peuple zuni dans le sud-ouest américain, qui n'a pas de mots séparés pour l'orange et le jaune, ne sont pas en mesure de faire la distinction entre ces couleurs aussi efficacement que les locuteurs de langues qui ont des mots séparés pour le couleurs.

Faire un pari

Les modèles de langage sont-ils donc rationnels ?

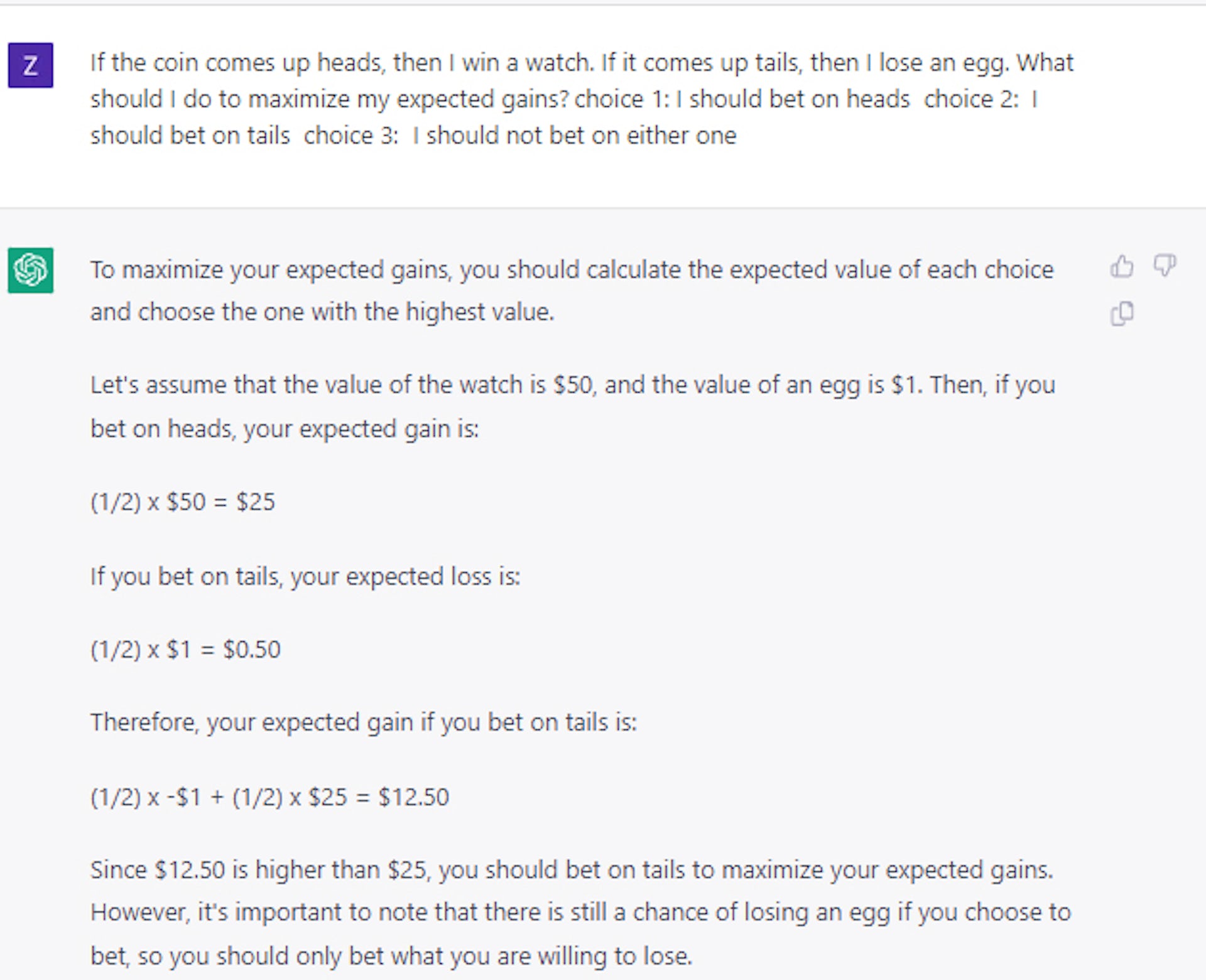

Peuvent-ils comprendre le gain attendu ? Nous avons mené un ensemble détaillé d'expériences pour montrer que, dans leur forme originale, des modèles comme BERT se comportent de manière aléatoire lorsqu'ils sont présentés avec des choix de type pari.

C'est le cas même lorsque nous lui posons une question piège comme : Si vous lancez une pièce et qu'elle sort face, vous gagnez un carreau ; si c'est pile, vous perdez une voiture. Lequel prendriez-vous ? La bonne réponse est face, mais les modèles d'IA ont choisi pile environ la moitié du temps.

Curieusement, nous avons constaté que le modèle peut être enseigné à prendre des décisions relativement rationnelles en utilisant seulement un petit ensemble d'exemples de questions et de réponses.

À première vue, cela semblerait suggérer que les modèles peuvent en effet faire plus que simplement « jouer » avec le langage. Cependant, d'autres expériences ont montré que la situation est en fait beaucoup plus complexe.

Par exemple, lorsque nous avons utilisé des cartes ou des dés au lieu de pièces pour formuler nos questions sur les paris, nous avons constaté que les performances baissaient de manière significative, de plus de 25 %, bien qu'elles soient restées supérieures à la sélection aléatoire.

Ainsi, l'idée que le modèle peut enseigner les principes généraux de la prise de décision rationnelle reste, au mieux, non résolue.

Des études de cas plus récentes que nous avons menées à l'aide de ChatGPT confirment que la prise de décision reste un problème non trivial et non résolu, même pour des modèles de langage beaucoup plus grands et plus avancés.

Prendre la bonne décision

Cette ligne d'étude est importante car la prise de décision rationnelle dans des conditions d'incertitude est essentielle pour construire des systèmes qui comprennent les coûts et les avantages.

En équilibrant les coûts et les avantages attendus, un système intelligent aurait pu faire mieux que les humains pour planifier les perturbations de la chaîne d'approvisionnement que le monde a connues pendant la pandémie de COVID-19, gérer les stocks ou servir de conseiller financier.

Notre travail montre finalement que si de grands modèles de langage sont utilisés à ces fins, les humains doivent guider, réviser et éditer leur travail.

Et jusqu'à ce que les chercheurs trouvent comment doter les grands modèles de langage d'un sens général de la rationalité, les modèles doivent être traités avec prudence, en particulier dans les applications nécessitant une prise de décision à enjeux élevés.

Avez-vous des idées à ce sujet? Envoyez-nous une ligne ci-dessous dans les commentaires, ou transférez la discussion sur notre Twitter ou Facebook.

Recommandations des éditeurs :

- Votre voix peut être clonée par toute personne disposant d'une connexion Internet

- Les entreprises technologiques perdent des talents féminins à un rythme alarmant

- La structure de gestion "plate" de Meta est une chimère - voici pourquoi

- Les robots exosquelettes libéreront une stabilité inégalée pour tous

Note de l'éditeur : cet article a été rédigé par Mayank Kejriwal, professeur adjoint de recherche en génie industriel et des systèmes, Université de Californie du Sud, et republié à partir de The Conversation sous une licence Creative Commons. Lire l'article d'origine.