Comment détecter le plagiat ChatGPT et AI

Publié: 2023-06-22ChatGPT a bouleversé le monde universitaire et des affaires avec sa capacité à générer une copie cohérente et bien écrite sur à peu près n'importe quel sujet sur terre en quelques secondes.

Ses capacités remarquables ont vu des étudiants de tous les niveaux d'enseignement se tourner vers le chatbot - ainsi que ses rivaux, tels que Bard - pour rédiger des essais complexes qui prendraient autrement des heures à terminer.

Cela a lancé une conversation mondiale sur un nouveau phénomène, souvent appelé "plagiat ChatGPT". Ce guide couvre les outils que les entreprises et les établissements d'enseignement utilisent pour détecter le plagiat ChatGPT, les dangers de la triche avec ChatGPT - et si l'utilisation de ChatGPT compte même comme du plagiat.

- Comment détecter le plagiat ChatGPT

- Vérificateurs de plagiat AI et ChatGPT les plus populaires

- Les vérificateurs de contenu AI fonctionnent-ils réellement ?

- L'utilisation de ChatGPT ou de Bard est-elle réellement du plagiat ?

- Les dangers de la triche avec ChatGPT

- ChatGPT plagie-t-il ?

- Est-ce que Bard plagie ?

- Les autres outils d'IA plagient-ils ?

- Dois-je utiliser ChatGPT pour mes essais ou mon travail ?

Comment détecter le plagiat ChatGPT

Pour détecter le plagiat ChatGPT, vous avez besoin d'un vérificateur de contenu AI. Les vérificateurs de contenu IA analysent les corps de texte pour déterminer s'ils ont été produits par un chatbot tel que ChatGPT ou Bard, ou par un humain. Cependant, comme nous le verrons plus tard, ces outils sont loin d'être fiables.

Il est légèrement plus difficile de détecter le plagiat en matière de code, ce que ChatGPT peut également générer avec compétence. Il n'y a pas tout à fait le même écosystème d'outils de détection d'IA pour le code que pour le contenu.

Cependant, si vous êtes dans un environnement universitaire, par exemple, et que vous soumettez du code bien au-delà de votre niveau technique, votre professeur ou conférencier peut avoir des soupçons très raisonnables que vous avez demandé à ChatGPT de vous aider.

Examen des outils de vérification du plagiat AI et ChatGPT les plus populaires

Depuis le lancement de ChatGPT en novembre 2022, de nombreuses entreprises et établissements d'enseignement ont produit des vérificateurs de contenu IA, qui prétendent pouvoir faire la distinction entre le contenu généré artificiellement et le contenu créé par des humains. Désormais, de nombreuses entreprises utilisent également le chatbot Bard de Google, qui utilise un modèle de langage différent.

Cependant, la prétendue précision des outils de détection de contenu d'IA, même les plus réputés, est âprement contestée et des affaires judiciaires entre des étudiants faussement accusés d'utiliser du contenu d'IA et de l'éducation se sont déjà matérialisées.

L'essentiel est le suivant : aucun outil dans cet espace n'est précis à 100 %, mais certains sont bien meilleurs que d'autres.

GPTZéro

GPTZero est un outil de détection de contenu d'IA populaire et gratuit qui prétend qu'il s'agit du "détecteur d'IA le plus précis dans les cas d'utilisation, vérifié par plusieurs sources indépendantes".

Cependant, en avril dernier, un étudiant en histoire de l'UC Davis a prouvé que GPTZero - un outil de détection de contenu d'IA utilisé par son professeur - était incorrect lorsqu'il a étiqueté son essai comme généré par l'IA.

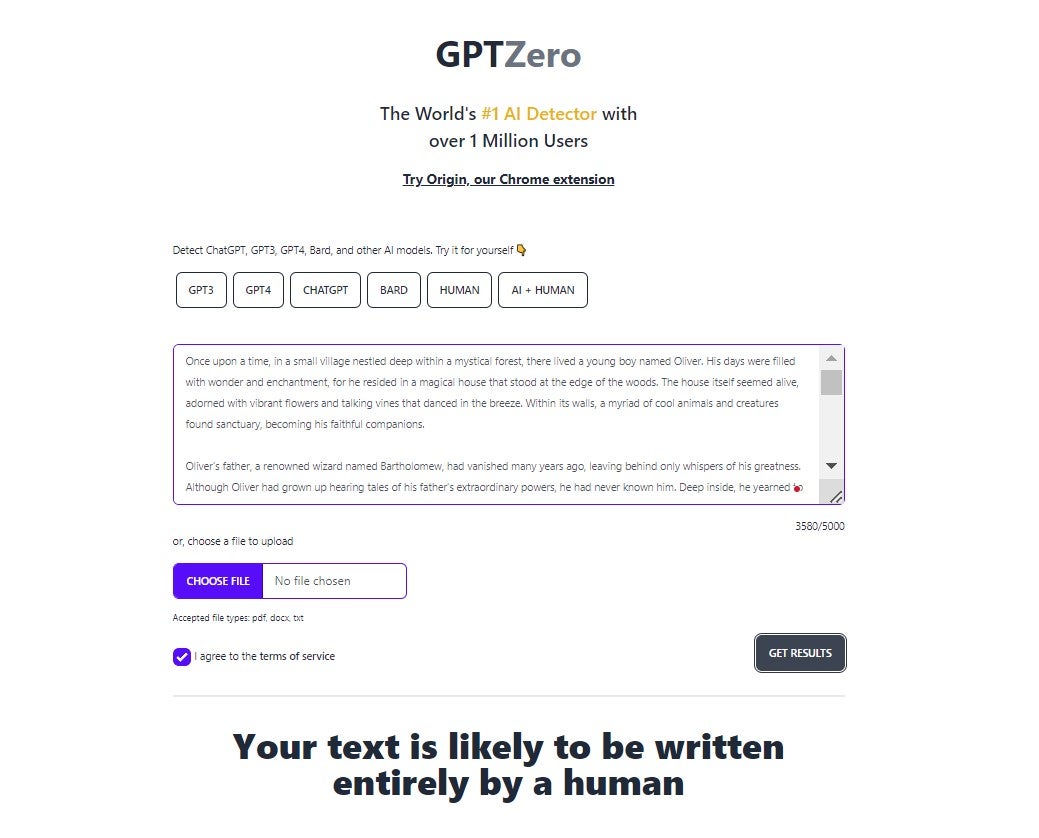

Nous avons testé GPTZero en demandant à ChatGPT d'écrire une courte histoire. GPTZero, malheureusement, n'a pas été en mesure de dire que le contenu a été écrit par un outil d'IA :

Originalité.ai

Originality.ai est certainement l'un des outils de détection de contenu IA les plus précis actuellement disponibles.

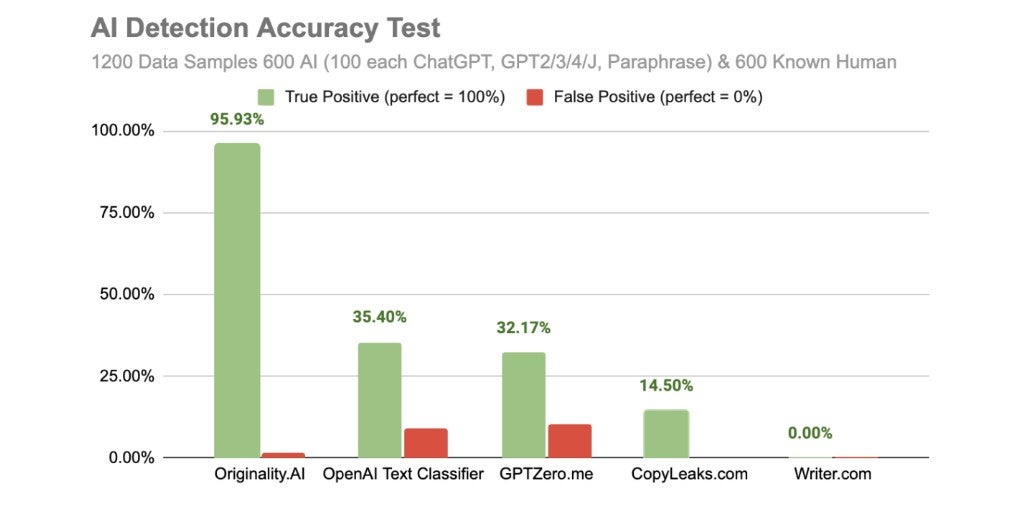

La société a mené sa propre étude sur les outils de détection de contenu d'IA en avril de cette année, dans le cadre de laquelle elle a alimenté 600 blocs de texte générés artificiellement et 600 générés par l'homme dans son propre système de détection de contenu, ainsi que d'autres outils populaires qui prétendent faire la même chose. .

Comme vous pouvez le voir dans les résultats ci-dessous, Originality.ai a surpassé tous les outils inclus dans le test :

Le seul inconvénient d'Originality.ai est qu'il n'y a pas de plan gratuit, et vous ne pouvez même pas le tester gratuitement comme vous le pouvez avec les autres applications incluses dans cet article. il en coûte 20 $ pour 2 000 crédits, ce qui vous permettra de vérifier 200 000 mots.

Détecteur de contenu IA Copyleaks

Copyleaks est un détecteur de contenu AI gratuit qui prétend être capable de faire la distinction entre la copie générée par l'homme et celle générée par l'IA avec une précision de 99,12 %.

Copyleaks vous indiquera également si des aspects spécifiques d'un document ou d'un passage sont écrits par l'IA, même si d'autres parties semblent avoir été écrites par un humain.

Copyleaks dit qu'il est capable de détecter le contenu généré par l'IA créé par "ChatGPT, GPT-4, GPT-3, Jasper et autres", et affirme même qu'"une fois que de nouveaux modèles sortiront, nous pourrons le détecter automatiquement".

CopyLeaks coûte 8,33 $ par mois pour 1 200 crédits (250 mots de copie par crédit).

Dans un test effectué par TechCrunch en février 2023, cependant, Copyleaks a classé à tort différents types de copies générées par l'IA, y compris un article de presse, une entrée d'encyclopédie et une lettre de motivation comme étant générés par l'homme.

De plus, l'étude d'Originality.ai référencée ci-dessus n'a trouvé qu'elle était exacte dans 14,50 % des cas, ce qui est bien loin de la déclaration d'exactitude de 99,12 % de CopyLeaks.

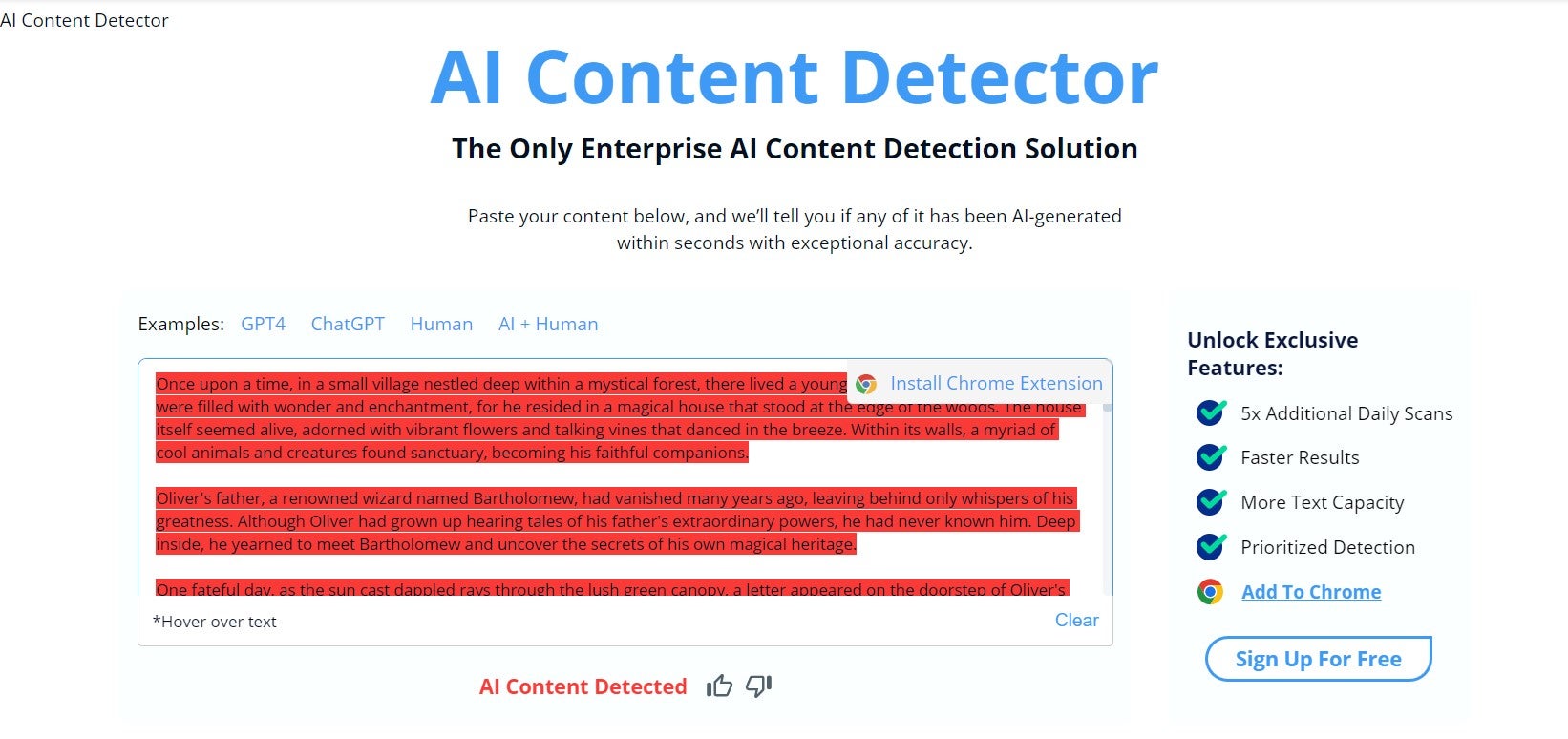

Cependant, lorsque nous l'avons testé, il a semblé être en mesure de détecter que le texte que nous avons saisi a été généré par ChatGPT :

Détecteur Turnitin AI

Turnitin est une société de détection de plagiat basée aux États-Unis qui est déployée par diverses universités pour analyser le travail de leurs étudiants. Turnitin est conçu pour détecter toutes sortes de plagiat, mais a révélé en avril qu'il investissait depuis un certain temps dans une équipe axée sur l'IA.

Turnitin dit qu'il peut "détecter la présence d'écriture d'IA avec une confiance de 98 % et un taux de faux positifs inférieur à 1 % dans notre environnement de laboratoire contrôlé".

Cependant, la société affirme également que le contenu, s'il signale un élément de contenu comme généré par l'IA, doit être traité comme une "indication, pas une accusation". La véritable précision du détecteur d'IA de Turnitin a été contestée par le Washington Post, ainsi que par d'autres sources.

Le logiciel de détection de contenu AI de Turnitin est actuellement gratuit, mais la société indique dans une FAQ sur son site Web qu'elle passe à un programme de licence payant en janvier 2024 - dont le prix n'est pas précisé.

Classificateur de texte OpenAI

Ne voulant pas être manipulés par des vérificateurs de contenu IA tiers, OpenAI a lui-même publié un logiciel conçu pour classer si le contenu a été généré par l'IA.

Le document ou le texte que vous saisissez doit comporter plus de 1 000 caractères. Une fois que vous avez entré votre document, OpenAI vous dira presque instantanément quelle est la probabilité qu'il ait été généré par des humains.

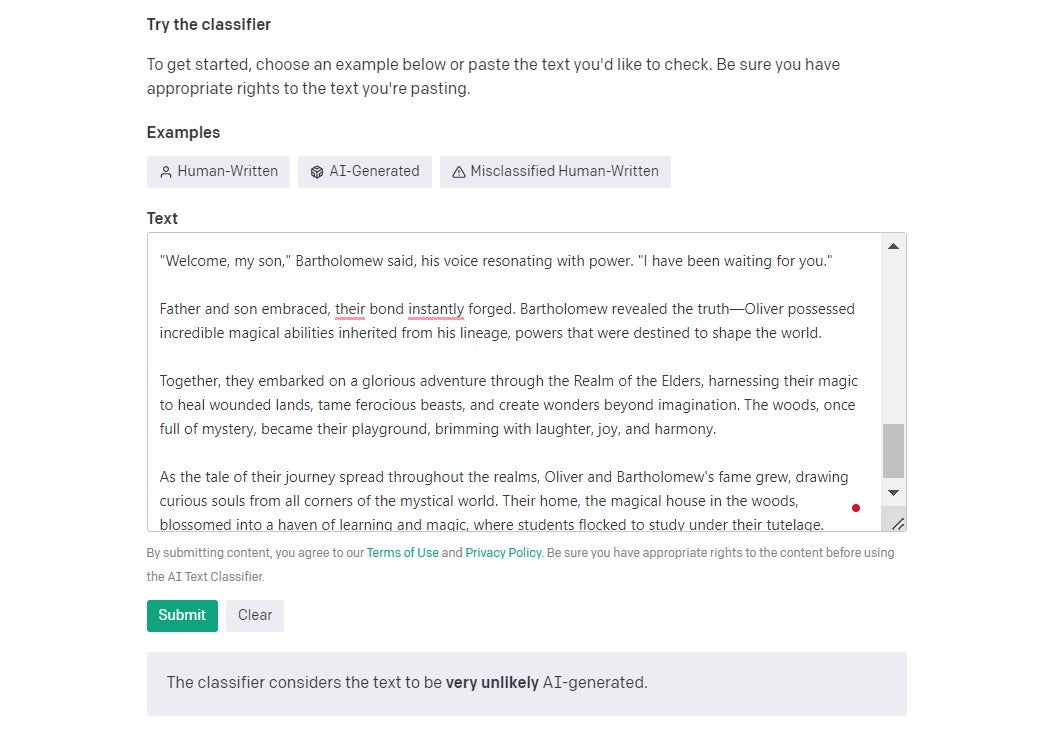

J'ai posté un extrait d'un article récent de Tech.co, écrit par un écrivain - qu'OpenAI a déterminé à juste titre qu'il était "très peu probable" d'avoir été écrit par AI.

Dans le même article TechCrunch auquel nous avons fait référence plus tôt, la publication indique qu'OpenAI estime que son classificateur de texte manque 74 % du contenu généré par l'IA. C'est une bonne chose qu'ils soient si honnêtes à ce sujet aussi - lorsque nous avons effectué un deuxième test, en utilisant une courte histoire générée par ChatGPT, il n'a pas relevé le fait qu'il était généré par l'IA :

La détection de contenu AI fonctionne-t-elle réellement ?

Aucun outil de détection de contenu IA n'est fiable à 100 % - nos tests le prouvent de manière assez retentissante.

Cependant, aucun des outils dont nous avons discuté aujourd'hui ne prétend réellement être précis à 100 %, et très peu prétendent être absolument exempts de faux positifs. D'autres, comme GPTZero, publient des avis de non-responsabilité sur le fait de prendre leurs résultats pour évangile.

Un certain nombre d'étudiants universitaires accusés d'utiliser l'intelligence artificielle pour produire des essais ont déjà été contraints de prouver que leur travail était original.

Au Texas, en mars, un professeur a faussement échoué une classe entière d'étudiants après les avoir accusés à tort d'utiliser ChatGPT pour rédiger des essais. Il existe également une collection de rapports - et d'études comme celle menée par Originality.ai - qui suggèrent que même les vérificateurs de plagiat les plus compétents ne sont pas aussi précis qu'ils le prétendent.

Même le détecteur de contenu AI de Turnitin n'est pas infaillible. Dans le récent test relativement petit effectué par le Washington Post dont nous avons parlé plus tôt, sa précision était bien en deçà des 98% qu'ils prétendent pouvoir produire.

Originality.ai, d'autre part, est certainement l'un des plus robustes disponibles - et même sa technologie de détection n'est pas correcte à chaque fois.

En outre, si des faux positifs existent à quelque titre que ce soit, les étudiants auront toujours la possibilité de prétendre que leur travail est original et qu'il a simplement été mal identifié.

Est-ce que ChatGPT ou Bard plagiat est utilisé ?

On peut se demander si ChatGPT est en fait du plagiat. Oxford Languages définit le plagiat comme "la pratique consistant à prendre le travail ou les idées de quelqu'un d'autre et à les faire passer pour les siens".

ChatGPT n'est pas une personne, et il ne s'agit pas simplement de reproduire le travail et les idées d'autres personnes lorsqu'il génère une réponse. Donc, selon la définition du dictionnaire, ce n'est pas du plagiat pur et simple.

Même si c'était le cas, si vous étiez honnête quant à son origine (c'est-à-dire ChatGPT), ce ne serait sans doute pas du plagiat de toute façon.

Cependant, certaines écoles et universités ont des règles de plagiat étendues et envisagent d'utiliser des chatbots pour rédiger des essais en tant que tels. Un étudiant de l'Université Furman a échoué son diplôme de philosophie en décembre après avoir utilisé ChatGPT pour rédiger son essai. Dans un autre cas, un professeur de la Northern Michigan University a rapporté avoir surpris deux étudiants en train d'utiliser le chatbot pour rédiger des essais pour leur classe.

Utiliser ChatGPT pour générer des essais, puis les faire passer pour votre propre travail est peut-être mieux décrit comme de la "tricherie" et est définitivement "malhonnête".

Le but de la rédaction d'un essai est de montrer que vous êtes capable de produire des pensées originales, de comprendre des concepts pertinents, d'examiner attentivement des arguments contradictoires, de présenter clairement des informations et de citer vos sources.

Il y a très peu de différence entre utiliser ChatGPT de cette manière et payer un autre étudiant pour qu'il rédige votre dissertation à votre place - ce qui, bien sûr, est de la triche.

En ce qui concerne Google's Bard, la réponse est un peu plus compliquée. La même ligne de logique utilisée ci-dessus s'applique à Bard comme à ChatGPT, mais Bard a été entaché d'accusations de plagiat et de citations incorrectes de choses qu'il tire d'Internet d'une manière que ChatGPT ne l'a pas fait. Ainsi, l'utilisation de Bard peut vous amener à plagier par inadvertance d'autres sources ( plus d'informations à ce sujet ci-dessous ).

Les dangers de la triche avec ChatGPT

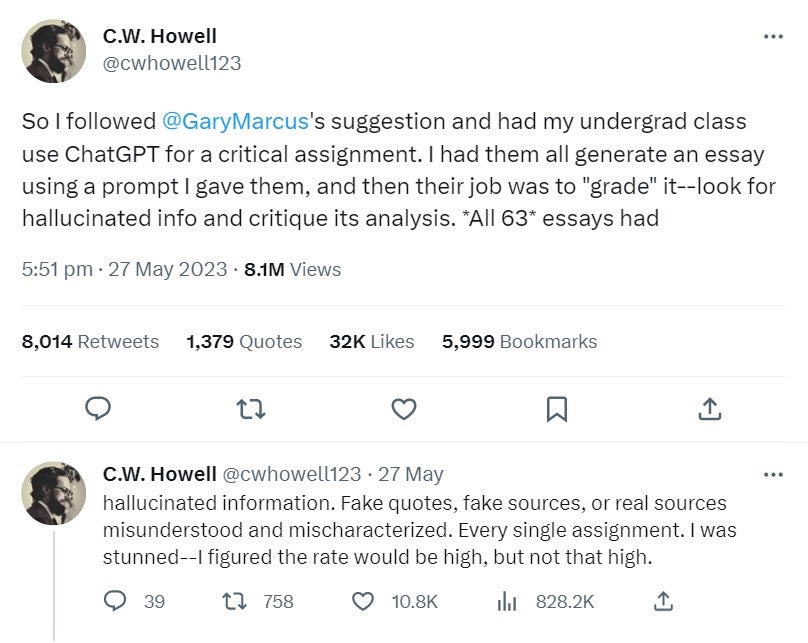

Christopher Howell, professeur adjoint adjoint à l'Université Elon, a récemment demandé à un groupe d'étudiants d'utiliser ChatGPT pour un devoir critique, puis de noter les essais qu'il a produits pour eux.

Il a rapporté dans un long fil Twitter (dont la première partie est illustrée ci-dessous) que les 63 étudiants qui ont participé ont trouvé une forme d '"hallucination" - y compris de fausses citations et des sources fausses et mal interprétées - dans leurs devoirs.

ChatGPT plagie-t-il dans ses réponses ?

Non - ChatGPT ne tire pas d'informations d'autres sources et ne les mélange pas simplement, phrase par phrase. Il s'agit d'un malentendu sur le fonctionnement des transformateurs pré-formés génératifs.

ChatGPT - ou plus précisément le modèle de langage GPT - est formé sur un énorme ensemble de données de documents, de matériel de site Web et d'autres textes.

Il utilise des algorithmes pour trouver des séquences et des modèles linguistiques dans ses ensembles de données. Des paragraphes, des phrases et des mots peuvent ensuite être générés en fonction de ce que le modèle de langage a appris sur le langage à partir des séquences de ces ensembles de données.

C'est pourquoi si vous posez la même question à ChatGPT en même temps à partir de deux appareils différents, ses réponses sont généralement extrêmement similaires - mais il y aura toujours des variations, et parfois, il offre des réponses complètement différentes.

Bard plagie-t-il dans ses réponses ?

Le plus grand rival de ChatGPT, Google's Bard a eu beaucoup plus de problèmes de plagiat de contenu depuis son lancement que son homologue plus populaire. Le site Web technologique Tom's Hardware a découvert que Bard avait plagié l'un de ses articles, puis s'est excusé lorsqu'un de ses employés l'a appelé.

Plus récemment, en mai 2023, PlagiarismCheck a déclaré à Yahoo News qu'ils avaient généré 35 textes avec Bard et qu'ils l'avaient trouvé plagié à plus de 5 % dans 25 d'entre eux en paraphrasant simplement le contenu existant déjà publié sur Internet.

Une grande différence entre Bard et ChatGPT qui peut peut-être expliquer cela est que Bard peut rechercher des réponses sur Internet, c'est pourquoi il a tendance à mieux traiter les questions relatives aux événements après 2021, avec lesquelles ChatGPT se débat. Cependant, cela semble également signifier qu'il extrait les données des sources d'une manière moins originale et cite ses sources plus souvent.

Ces exemples peuvent avoir été des blips, mais il est bon de connaître les risques si vous utilisez Bard pour un travail important.

Les autres outils d'IA plagient-ils ?

Malheureusement, oui - et certaines entreprises se sont déjà embarrassées en utilisant des outils d'IA qui ont plagié du contenu. Par exemple, CNET - l'un des plus grands sites technologiques au monde - s'est avéré utiliser un outil d'IA pour générer des articles, et n'était pas du tout transparent à ce sujet. Il a été constaté qu'environ la moitié des articles publiés par CNET à l'aide de l'IA contenaient des informations incorrectes.

Pour aggraver les choses, Futurism, qui a lancé une enquête sur le plagiat de l'IA de CNET, a déclaré que "le mauvais comportement du bot va de la copie textuelle à des modifications modérées en passant par des reformulations importantes, le tout sans créditer correctement l'original".

Les outils d'IA qui ne génèrent pas de contenu unique et original - qu'il s'agisse d'art ou de texte - ont le potentiel de plagier le contenu qui a déjà été publié sur Internet. Il est important de comprendre exactement comment fonctionne le modèle de langage utilisé par votre outil d'IA et de surveiller étroitement le contenu qu'il produit, sinon vous pourriez vous retrouver dans la même position que CNET.

Devriez-vous utiliser ChatGPT pour des essais ou du travail ?

Utilisation de ChatGPT pour les essais

Le fait que ChatGPT ne se contente pas de tirer des réponses d'autres sources et de mélanger des phrases signifie que les entreprises ont pu utiliser ChatGPT pour une variété de tâches différentes sans se soucier des problèmes de droits d'auteur.

Mais sa mécanique interne signifie aussi qu'il hallucine souvent et fait des erreurs. C'est loin, loin d'être parfait - et bien qu'il soit tentant de demander à ChatGPT de rédiger votre dissertation pour l'université ou le collège, nous vous le déconseillons.

Les directives de soumission spécifiques à chaque établissement d'enseignement seront légèrement différentes, bien sûr, mais il est fort probable que cela soit déjà considéré comme de la "tricherie" ou du plagiat dans votre université ou votre école. De plus, quelle que soit leur précision, les établissements d'enseignement utilisent des détecteurs de contenu IA, qui s'amélioreront avec le temps.

Utiliser ChatGPT au travail

Bien sûr, de nombreuses personnes utilisent déjà ChatGPT au travail - il s'avère utile dans un large éventail d'industries et aide les travailleurs dans toutes sortes de rôles à gagner un temps précieux sur les tâches quotidiennes.

Cependant, si vous utilisez ChatGPT au travail, nous vous conseillons d'en parler avec votre responsable ou votre superviseur, en particulier si vous l'utilisez pour des activités importantes telles que la rédaction de rapports pour des parties prenantes externes.

Nous vous conseillons également fortement de modifier fortement et d'examiner de près tout le travail que vous utilisez ChatGPT, Bard ou tout autre outil d'IA pour générer. Il n'est pas judicieux de mettre des informations personnelles ou d'entreprise sensibles dans un chatbot, car il n'y a pas beaucoup d'informations publiques sur l'endroit où ces chats sont stockés ou sur l'infrastructure de sécurité d'OpenAI.

Utilisation d'autres outils d'IA pour des essais ou des travaux

Bien sûr, Bard et ChatGPT ne sont pas les seuls chatbots IA disponibles. Cependant, nous hésiterions à apporter notre soutien à des outils d'IA plus petits qui ne sont pas soutenus par de puissants modèles de langage. Ils ne disposeront pas d'autant de ressources et il est peu probable que vous les trouviez aussi utiles si vous expérimentez leur utilisation pour le travail.

Cependant, les mêmes règles s'appliquent toujours - soyez ouvert avec votre responsable et obtenez son approbation pour les utiliser, ne saisissez aucune donnée sensible de l'entreprise et examinez toujours les réponses qui vous sont données.