Surmonter les biais dans l'annotation des données

Publié: 2024-11-22Juste un avertissement : si vous achetez quelque chose via nos liens, nous pouvons recevoir une petite part de la vente. C'est l'une des façons dont nous gardons les lumières allumées ici. Cliquez ici pour en savoir plus.

Dans l’IA, les données annotées façonnent directement la précision et l’équité des modèles d’apprentissage automatique. Cependant, les biais peuvent conduire à des résultats peu fiables et à de mauvaises performances des modèles d'apprentissage automatique.

Plongeons au cœur de ce défi et explorons des stratégies pratiques et exploitables pour surmonter les biais dans l'annotation des données.

Comprendre les biais dans l'annotation des données

Tout d’abord, qu’est-ce que l’annotation de données et comment les biais peuvent-ils l’affecter ?

L'annotation des données est le processus d'étiquetage des données, telles que des images, du texte ou des vidéos, pour entraîner des modèles d'apprentissage automatique.

Les biais dans ce processus se produisent lorsque les étiquettes sont influencées par des opinions personnelles ou des influences extérieures. Il s’agit d’un piège courant, et si rien n’est fait, il peut compromettre l’objectif même de l’apprentissage automatique.

Par exemple, si un modèle d’analyse des sentiments est entraîné avec des annotations qui évaluent systématiquement les expressions d’un dialecte particulier comme « négatives », il peut avoir de mauvais résultats sur les textes écrits dans ce dialecte.

Pire encore, cela pourrait renforcer les stéréotypes, entraînant des problèmes éthiques et des résultats erronés en matière d’IA.

Types de biais dans l'annotation des données

Les biais d’annotation des données ne se manifestent pas d’une seule manière ; ils prennent différentes formes en fonction de la source de données, des annotateurs et des instructions d'étiquetage. Voici quelques coupables courants :

Biais d'échantillonnage

Cela se produit lorsque les données collectées n'incluent pas toute la variété et la diversité de la population. Par exemple, l’entraînement d’un système de reconnaissance faciale sur des visages à peau principalement claire peut entraîner une moins bonne précision pour les peaux plus foncées.

Biais de l'annotateur

Cela découle des antécédents, des perspectives ou des idées préconçues des annotateurs. Deux annotateurs visualisant la même image ou le même texte peuvent l'interpréter différemment, surtout si des différences culturelles ou sociales sont impliquées.

Biais d’étiquetage

Souvent ancré dans des instructions d’étiquetage vagues ou subjectives, ce biais se produit lorsque les lignes directrices poussent les annotateurs vers une interprétation particulière.

Qualifier les images d’athlètes d’« hommes » malgré la représentation féminine, en raison de directives d’étiquetage fondées sur des stéréotypes, en est un exemple classique.

Stratégies pour minimiser les biais dans les annotations

Heureusement, les préjugés ne doivent pas être inévitables. Il existe des mesures concrètes que vous pouvez prendre pour éviter les préjugés, en garantissant que vos annotations de données restent aussi neutres et représentatives que possible.

Élaborer des lignes directrices claires et neutres

Commencez par élaborer des directives techniques d’annotation des données qui laissent peu de place à l’interprétation subjective.

Imaginez annoter des critiques de films si « négatif » et « positif » sont les seules catégories, mais qu'aucune indication spécifique n'est fournie, les annotateurs peuvent classer les critiques neutres ou sarcastiques de manière incorrecte.

Au lieu de cela, proposez des descriptions explicites et des exemples pour chaque étiquette, y compris même les cas extrêmes.

Assembler un pool d'annotateurs diversifié

Considérez vos annotateurs comme la lentille à travers laquelle votre modèle verra le monde. Une optique étroite conduit à des informations étroites, de sorte qu'un pool d'annotateurs homogène est susceptible d'injecter des perspectives étroites.

En incorporant un groupe diversifié d'annotateurs issus d'horizons variés, vous êtes plus susceptible de capturer un large éventail de points de vue.

Fournir une formation et des commentaires réguliers

La formation n'est pas réservée aux machines. Les annotateurs humains bénéficient également d’un recalibrage périodique via des sessions de formation et des boucles de rétroaction.

Des commentaires cohérents et structurés, ainsi que des examens des annotations de données sous différents angles, peuvent les aider à reconnaître les préjugés involontaires dans leur travail.

De plus, l'organisation d'ateliers de sensibilisation aux préjugés forme les annotateurs à repérer leurs propres inclinations et à prendre des décisions impartiales.

Tout comme un langage qui devient plus nuancé avec la pratique, les compétences d'étiquetage des annotateurs peuvent devenir plus pointues et plus objectives avec des conseils appropriés.

Utiliser des mécanismes d’annotation croisée et de consensus

Soyons réalistes : personne n’est parfait. Même l’annotateur le plus assidu peut parfois rater sa cible. C'est là que les annotations croisées s'avèrent utiles.

En faisant travailler plusieurs annotateurs sur les mêmes points de données, vous pouvez identifier les divergences et parvenir à un consensus sur les cas ambigus.

Cela équilibre non seulement les biais individuels, mais vous donne également un ensemble d'étiquettes plus fiable.

Cette approche est particulièrement utile pour les catégories subjectives, comme la détection des émotions, où les opinions personnelles s'infiltrent souvent dans les annotations.

Tirer parti de la technologie pour lutter contre les préjugés

L’effort humain à lui seul ne peut pas détecter tous les biais, en particulier dans les projets d’annotation à grande échelle. C'est là que la technologie et l'expertise d'une société d'annotation de données peuvent vous aider à repérer et à corriger les préjugés qui pourraient échapper à la surveillance humaine.

Outils de contrôle qualité automatisés

Les outils de contrôle qualité automatisés sont comme les inspecteurs qualité de la ligne d’annotation. Ces outils examinent les données étiquetées à la recherche d'incohérences, signalant des modèles pouvant indiquer un biais.

Détection d'anomalies basée sur l'IA

Les techniques de détection des anomalies offrent un autre niveau de protection. Ces algorithmes détectent les valeurs aberrantes dans vos données annotées, signalant les points de données qui s'écartent considérablement de la norme.

En examinant les cas signalés, vous pouvez détecter des modèles d'étiquetage inhabituels qui peuvent indiquer un parti pris, comme le fait de surétiqueter certains sentiments dans des textes provenant de données démographiques particulières.

Cadres d’audit de biais

Plusieurs cadres sont conçus spécifiquement pour auditer les ensembles de données afin de détecter les biais potentiels. Les outils d'audit de biais analysent les données à la recherche de classes surreprésentées ou sous-représentées, vous aidant ainsi à obtenir une répartition équilibrée.

Considérez-le comme un projecteur qui met en lumière les domaines dans lesquels vos données peuvent être inégales. L'exécution périodique de ces audits permet de contrôler votre ensemble de données et de l'aligner sur les objectifs éthiques de l'IA.

Récapitulatif des bonnes pratiques

Surmonter les biais dans les annotations d’experts est un processus continu. Vous trouverez ci-dessous quelques bonnes pratiques que vous pouvez revoir pour maintenir un niveau élevé d’objectivité dans vos données :

- Des directives claires : des instructions précises et bien définies avec des exemples aident à éliminer toute ambiguïté.

- Annotateurs diversifiés : assurez-vous que votre équipe d'annotateurs est aussi représentative que possible pour capturer des perspectives variées.

- Annotation croisée : employez plusieurs annotateurs sur des cas ambigus pour équilibrer la subjectivité.

- Boucles de rétroaction : la formation continue et les commentaires affinent la compréhension des annotateurs et réduisent les biais au fil du temps.

- Aides technologiques : les outils de contrôle de la qualité, la détection des anomalies et les cadres d'audit des biais contribuent tous à garantir l'impartialité des données.

| Stratégie | Objectif | Exemple de cas d'utilisation |

| Des directives claires | Minimiser l’interprétation subjective | Règles détaillées pour l'étiquetage des sentiments |

| Divers annotateurs | Capturez de larges perspectives | Équipe multiculturelle pour les projets PNL |

| Annotation croisée | Équilibrer les préjugés individuels | Consensus sur les cas ambigus en détection d'émotions |

| Boucles de rétroaction | Réduire les préjugés grâce à l’amélioration continue | Ateliers pour reconnaître les préjugés implicites |

| Aides technologiques | Détecter les modèles de biais dans de grands ensembles de données | Outils automatisés de contrôle qualité et de détection des anomalies |

Pensées finales

Les biais dans l'annotation des données constituent un défi, mais il peut être résolu grâce à une planification minutieuse et aux outils appropriés. En créant un cadre solide composé de perspectives diverses, de directives claires et de technologies avancées, vous établissez votre modèle d'apprentissage automatique sur une base solide et objective.

Chaque effort compte, et à mesure que vous affinez votre approche de l'annotation, vous améliorez non seulement la précision du modèle, mais vous contribuez également à l'objectif plus large d'une IA éthique et impartiale.

Après tout, le succès de votre système d’IA dépend de la fiabilité des données dont il tire les leçons : veillez donc à ce que ces données soient aussi justes et équilibrées que possible.

Avez-vous des idées à ce sujet ? Écrivez-nous ci-dessous dans les commentaires ou portez la discussion sur notre Twitter ou Facebook.

Recommandations des rédacteurs :

Black Friday : détecteur de fuite d'eau GoveeLife (pack de 3) à 45 % de réduction

Des données aux insights : automatiser la collecte de données en ligne à grande échelle

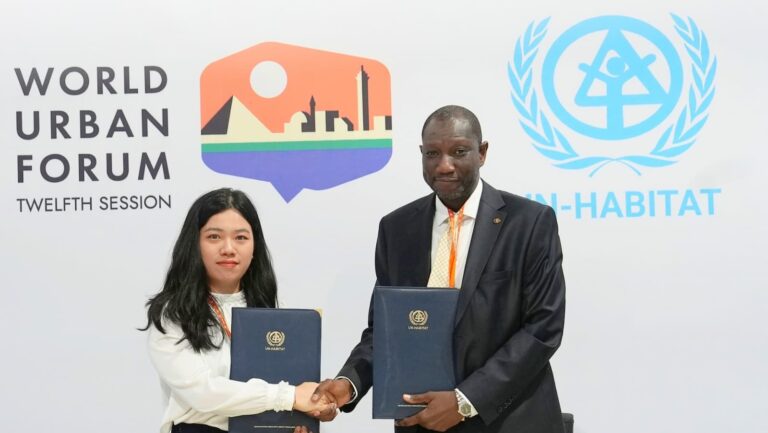

Bluetti et ONU-Habitat s'associent pour stimuler l'énergie propre en Afrique

Divulgation : il s'agit d'un article sponsorisé. Cependant, nos avis, critiques et autres contenus éditoriaux ne sont pas influencés par le parrainage et restent objectifs .