Des données aux insights : automatiser la collecte de données en ligne à grande échelle

Publié: 2024-11-18Juste un avertissement : si vous achetez quelque chose via nos liens, nous pouvons recevoir une petite part de la vente. C'est l'une des façons dont nous gardons les lumières allumées ici. Cliquez ici pour en savoir plus.

Pour surpasser vos concurrents, vous devez connaître leurs performances.

Pour proposer des produits et services à votre public cible, vous devez savoir ce qu'il recherche. Pour prédire les tendances du marché, vous devez connaître les conditions actuelles du marché.

Quels que soient vos buts et objectifs, si vous souhaitez que votre entreprise prospère, vous devez accéder à des données pertinentes, de haute qualité et en temps opportun.

Après tout, ce n'est qu'avec des données précises que vous pouvez générer des informations qui vous aideront à prendre de meilleures décisions basées sur les données.

Si la qualité des données est essentielle, la quantité ne doit pas être négligée. Heureusement, vous pouvez automatiser la collecte de données à grande échelle et profiter des deux avantages avec des outils comme l'API Scraper. Apprenez-en davantage ci-dessous.

L’importance de la collecte de données pour les entreprises

La collecte de données est essentielle pour les entreprises de toutes tailles, car elle vous aide à accélérer votre expansion et à améliorer vos processus décisionnels.

Il offre une gamme d’avantages qui peuvent aider votre entreprise à pérenniser :

- Améliore la génération de leads ;

- Améliore la fidélisation des clients ;

- Minimise les risques ;

- Prédit la demande ;

- Améliore la compréhension des comportements des clients ;

- Prédit l'activité des concurrents ;

- Améliore les stratégies de marketing ;

- Débloque des opportunités de croissance.

Sans données pertinentes, toute décision que vous prendrez sera simplement basée sur votre intuition, vous exposant à des risques inutiles et augmentant vos chances d’échec.

Grâce à une collecte de données complète et à une analyse approfondie, vous pouvez en tirer des informations précieuses pour améliorer vos performances et garantir votre succès.

Utiliser le web scraping pour rationaliser les processus de collecte de données

Bien qu'il existe d'innombrables méthodes de collecte de données, notamment des entretiens et des groupes de discussion, des enquêtes et des formulaires, l'extraction de données en ligne vous donne accès aux plus grands volumes de données.

L'extraction de données en ligne consiste à visiter tous les sites Web pertinents de votre secteur et à collecter tous les points de données dont votre entreprise a besoin.

Vous pouvez collecter des statistiques pertinentes sur des sites Web de haute autorité dans votre niche, des avis d'utilisateurs sur des sites Web tiers, des informations sur les prix sur les sites Web de concurrents, et bien plus encore.

Au cours des prochaines années, la création mondiale de données devrait atteindre plus de 180 zettaoctets, vous donnant accès à de nombreuses sources et à d’abondants volumes de données.

Le seul problème est que la collecte manuelle de toutes les données nécessaires peut s’avérer plus complexe que ce que vous pouvez imaginer.

Pour la collecte de données en ligne à grande échelle, vous devrez automatiser vos processus et, heureusement, vous pouvez facilement le faire grâce au web scraping.

Le web scraping implique l’utilisation de robots scrapers pour l’extraction de données.

Tout ce que vous aurez à faire est de programmer ces robots pour qu'ils explorent n'importe quelle page Web dont vous avez besoin, de spécifier le type de données que vous souhaitez qu'ils extraient et de définir votre format d'extraction préféré. À partir de là, ils s’occupent de tout le reste.

Les scrapers Web peuvent parcourir des centaines de pages Web en un rien de temps, offrant ainsi une vitesse et une efficacité maximales.

Ils éliminent les risques d’erreur humaine, minimisent les dépenses et fournissent des résultats précis et de haute qualité dès que vous en avez besoin.

Les deux meilleurs outils de web scraping

Lorsque vous choisissez des web scrapers pour la collecte et l'extraction de données, vous aurez plusieurs options, notamment les web scrapers traditionnels, tels que l'API Scraper ou les scrapers sans code.

Les deux présentent des avantages et des inconvénients uniques qui peuvent vous aider à déterminer la meilleure solution.

Les scrapers Web traditionnels nécessitent des compétences en codage, car vous devrez interagir avec eux via un langage de programmation.

Cependant, leur vitesse, leur efficacité, leur capacité à gérer la technologie anti-bot, leurs pages Web dynamiques, leur personnalisation, etc. les distinguent des scrapers sans code.

Avantages des scrapers Web traditionnels :

- Flexible;

- Efficace;

- Personnalisable.

Inconvénients du scraper Web traditionnel :

- Exiger des compétences en codage ;

En raison du codage approfondi requis, les web scrapers traditionnels sont mieux adaptés aux entreprises qui ont besoin de scraping à grande échelle.

Ce sont des outils puissants mais qui nécessiteront des investissements en temps plus importants.

La bonne nouvelle est qu’ils peuvent facilement être intégrés à votre infrastructure existante et sont parfaitement personnalisables pour répondre à vos besoins uniques.

Les scrapers sans code sont généralement beaucoup plus simples à utiliser.

Comme leur nom l’indique, ils ne nécessitent aucune compétence en codage de votre part. Ils sont entièrement automatisés dès le départ et vous pouvez immédiatement commencer à les utiliser.

Avantages du scraper sans code :

- Entièrement automatisé ;

- Ne nécessite aucune compétence en codage ;

- Aucun entretien.

Inconvénients du grattoir sans code :

- Non personnalisable ;

En raison de leur facilité d'utilisation, les scrapers sans code sont généralement mieux adaptés aux particuliers et aux petites entreprises n'ayant pas de besoins étendus en matière de collecte de données.

Même s’ils peuvent être efficaces à plus petite échelle, ils peuvent devenir limitants à mesure que vos besoins en données augmentent.

Comment et quand utiliser ces web scrapers

En fonction de vos besoins, les scrapers traditionnels et sans code peuvent être utiles car ils ont tendance à avoir des cas d'utilisation différents.

Les scrapers Web traditionnels comme l'API Scraper sont le plus souvent utilisés pour :

- Recherche d'audience ;

- Étude de marché;

- Analyse des concurrents.

D'un autre côté, les scrapers Web sans code sont le plus souvent utilisés pour :

- Comparaisons de prix ;

- Suivi des revues ;

- Gestion de la réputation.

En règle générale, il est préférable d'utiliser des scrapers traditionnels pour gérer de gros volumes de données quantitatives et qualitatives. Les scrapers sans code peuvent être utiles pour de plus petits volumes de données quantitatives.

Conclusion

L'automatisation de la collecte de données à grande échelle est essentielle pour rester au courant des tendances du marché, vous familiariser avec votre public cible et surpasser vos concurrents.

Vous pouvez générer des informations précieuses qui peuvent faire progresser votre entreprise uniquement avec des données précises et opportunes.

Avez-vous des idées à ce sujet ? Écrivez-nous ci-dessous dans les commentaires ou portez la discussion sur notre Twitter ou Facebook.

Recommandations des rédacteurs :

Bluetti et ONU-Habitat s'associent pour stimuler l'énergie propre en Afrique

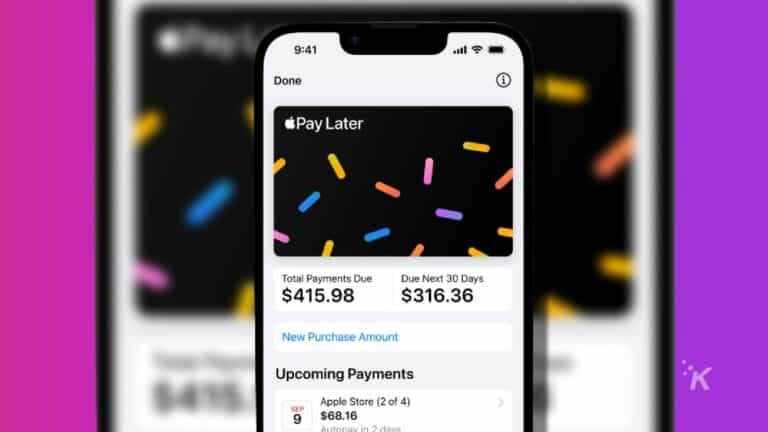

Pourquoi utiliser les applications Acheter maintenant, payer plus tard en 2024 ?

Débloquez la centrale électrique toute-puissante Elite 200 V2 pendant la vente Black Friday de BLUETTI

Divulgation : il s'agit d'un article sponsorisé. Cependant, nos avis, critiques et autres contenus éditoriaux ne sont pas influencés par le parrainage et restent objectifs .