Mengapa Chatbots Terapi AI Merupakan Dilema Etis Utama

Diterbitkan: 2023-10-31Chatbot AI generatif seperti ChatGPT digunakan untuk menyederhanakan proses di tempat kerja, menulis kode, dan bahkan menulis skrip untuk set komedi stand-up. Di AS, dimana kasus kecemasan dan depresi mencapai rekor tertinggi, dan dukungan profesional masih terus meningkat, tidak mengherankan jika pengguna juga memanfaatkan teknologi ini untuk membantu mengelola kesehatan mental mereka.

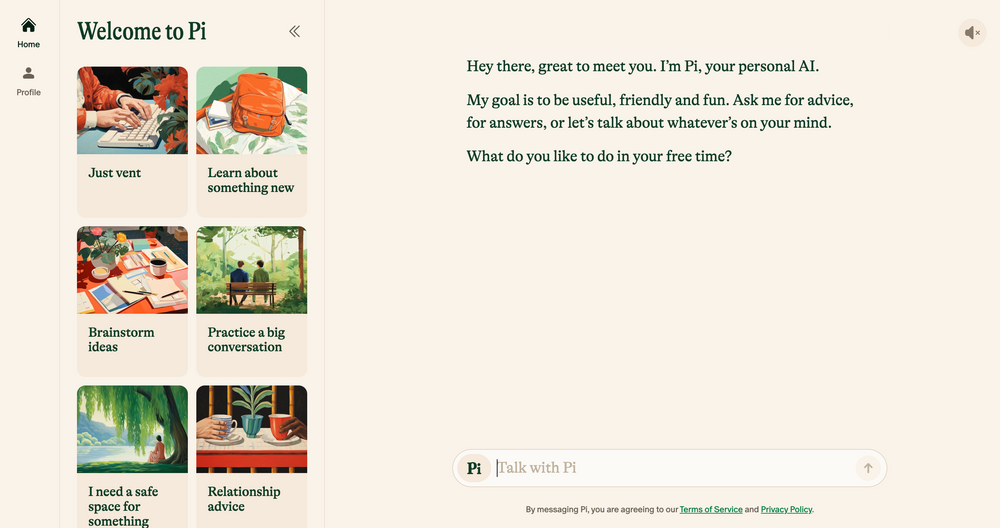

Chatbot AI seperti Elomia, Pi, dan Woebot menawarkan dukungan yang terjangkau dan dipersonalisasi 24/7, berdasarkan teknik terapi yang telah teruji. Mulai dari membantu pengguna melewati daftar tunggu yang panjang hingga mengurangi stigma dalam mengakses bantuan, manfaatnya sangat besar. Bisakah AI generatif – yang masih rentan terhadap kesalahan, halusinasi , dan bias – bisa dibandingkan dengan empati telinga manusia?

Kami berbicara dengan akademisi, psikolog, dan terapis untuk menjelaskan bagaimana teknologi baru ini kemungkinan besar akan membentuk masa depan terapi. Kami juga membahas sisi lain dari terapi AI dan menunjukkan masalah etika mana yang perlu ditangani saat ini. Inilah yang kami temukan.

AI Chatbots: Terapis Robot Generasi Baru

Sejak chatbot ChatGPT OpenAI pertama kali diluncurkan pada bulan November lalu, sejumlah peniru chatbot telah bermunculan di toko aplikasi – mulai dari aplikasi penggunaan umum seperti Google Bard dan Claude AI hingga simulator karakter Marvel yang kurang konvensional.

Pasar yang sedang berkembang ini juga menyebabkan munculnya chatbot terapi AI – aplikasi yang menggunakan AI generatif untuk meniru saran dan panduan yang diberikan oleh terapis berkualifikasi dan profesional kesehatan mental.

Ingin menjelajahi web secara pribadi? Atau tampak seolah-olah Anda berada di negara lain?

Ingin menjelajahi web secara pribadi? Atau tampak seolah-olah Anda berada di negara lain?

Dapatkan diskon besar 86% untuk Surfshark dengan penawaran Tech.co Black Friday ini. ![]()

Contoh utama termasuk Pi yang memproklamirkan diri sebagai “teman ngobrol yang ramah” yang bertindak sebagai pembicara dan menawarkan dukungan emosional; Replika, program chatbot yang meniru gaya berbicara dan kepribadian penggunanya; dan Earkick, pelacak kecemasan yang dirancang untuk membantu Anda mencatat dan mengatasi emosi yang sulit.

“Platform berbasis AI menawarkan privasi, mengurangi stigma yang sering dikaitkan dengan pencarian bantuan untuk masalah kesehatan mental.” – Ryan Sultan, Psikiater Bersertifikat dan Profesor di Universitas Columbia

Seperti aplikasi kesehatan mental terbaik , banyak dari aplikasi ini sudah memiliki unduhan sebanyak enam digit – dan popularitasnya tidak mengejutkan. Karena kurangnya psikolog, psikiater, dan pekerja sosial yang berkualifikasi, ditambah lonjakan permintaan layanan di seluruh negeri, AS saat ini sedang bergulat dengan salah satu krisis kesehatan mental terburuk yang pernah tercatat.

Mahalnya biaya terapi tradisional dan tabu seputar kesehatan mental juga menghalangi banyak orang untuk melakukan pilihan konvensional, sehingga menciptakan kesenjangan untuk mencari alternatif yang lebih bijaksana dan terjangkau.

Bukti awal menunjukkan bahwa cara ini juga efektif. Temuan Earkick dari AI Chatbot mengungkapkan bahwa suasana hati penggunanya meningkat sebesar 34% dan tingkat kecemasan turun sebesar 32% setelah menggunakan aplikasi ini selama lima bulan. Namun, meskipun aplikasi ini berhasil meredakan kecemasan kecil, aplikasi ini jelas bukan obat mujarab untuk kesehatan mental yang kita tunggu-tunggu.

AI Chatbots Tidak Cocok untuk Kondisi Kesehatan Mental yang Serius

Menerima saran yang masuk akal dan disetujui oleh terapis dari chatbot berukuran saku pasti akan bermanfaat bagi banyak orang. Namun, mereka yang menderita kondisi kesehatan mental yang parah seperti depresi, skizofrenia, dan gangguan bipolar kemungkinan besar tidak akan mendapatkan perubahan.

Gangguan mental itu kompleks, sangat beragam, dan unik pada setiap orang yang terkena dampaknya. Dalam beberapa kasus, penyakit ini paling baik ditangani dengan obat-obatan yang hanya dapat diresepkan dengan benar oleh profesional medis yang berkualifikasi. Meskipun model bahasa besar (LLM) telah berkembang pesat dalam beberapa tahun terakhir, keluarannya tidak akan pernah mampu menggantikan keahlian klinis, empati, dan kasih sayang yang diberikan oleh psikiater, psikolog, dan terapis.

“Saya mengapresiasi kemajuan algoritme, namun pada akhirnya menurut saya algoritme tersebut tidak akan mampu mengatasi realitas sosial yang semakin kacau saat orang-orang mencari bantuan,” – Julia Brown, profesor antropologi di Universitas California, San Francisco

Penyembuh psikis strategis Aanant Bisht juga percaya bahwa AI, dalam kondisi saat ini, tidak akan mampu membantu perjalanan penyembuhan kompleks setiap pengguna. “Penting juga untuk menghindari penyederhanaan masalah kesehatan mental yang kompleks dan mendorong pengguna untuk mencari bantuan profesional bila diperlukan,” kata Bisht kepada Tech.co.

Kekhawatiran umum lainnya yang diungkapkan oleh para ahli yang kami ajak bicara adalah kesalahan diagnosis medis. Komunitas kesehatan mental memiliki masalah yang sudah lama ada dalam mengidentifikasi gangguan kejiwaan yang kompleks dan parah dengan benar, dan ketergantungan yang besar pada AI kemungkinan besar dapat memperburuk masalah ini, karena keterbatasan teknologi, kumpulan data yang tidak representatif, dan ketidakmampuan untuk menafsirkan nuansa manusia.

Hasil dari hal ini juga bisa sangat nyata. Kesalahan diagnosis kesehatan mental sering kali menyebabkan pengobatan dan dukungan yang tidak memadai, tekanan mental tambahan, dan skeptisisme jangka panjang terhadap sistem medis. Ini bukan satu-satunya alasan mengapa kecerdasan buatan tidak mampu mengambil alih kursi terapis dalam bentuknya saat ini.

AI memiliki Cacat dan Terselubung dalam Tantangan Etis

Pesatnya peningkatan AI generatif bukannya tanpa konsekuensi. Ketika teknologi terus berkembang dengan kecepatan yang sangat tinggi, peraturan seputar penggunaannya berjalan lambat, sehingga berkontribusi terhadap serangkaian tantangan etika terkait privasi data, bias yang melekat, dan penyalahgunaan.

Kekhawatiran ini tidak hanya terjadi pada terapi, namun sifat sensitif dari kesehatan mental berarti bahwa kerangka etika adalah inti dari setiap hubungan terapeutik yang baik. Dengan tidak adanya kode etik AI resmi saat ini, pengguna yang mengandalkan chatbot dibandingkan profesional berkualifikasi untuk konseling atau dukungan kesehatan mental lainnya akan sangat bermasalah.

Privasi data adalah salah satu masalah utama. Chatbots seperti ChatGPT sering kali mendapat masalah karena gagal melindungi data pengguna . Agar pengguna merasa nyaman mendiskusikan informasi pribadi, perusahaan AI perlu memiliki strategi perlindungan data yang sangat mudah dan memprioritaskan kerahasiaan.

“ Sifat percakapan terapeutik yang intim dan sensitif menuntut tingkat perlindungan data yang tak tertandingi.” – Dr. Langham, psikolog di Terapi Impuls

Faktor penting lainnya yang harus diperhatikan adalah bias pembelajaran mesin. Semua sistem AI mengandalkan data pelatihan yang telah ditentukan sebelumnya, yang sering kali menyertakan bias manusia yang tertanam meskipun variabel sensitif seperti ras dan gender dihilangkan.

Menurut Bayu Prihandito, CEO perusahaan life coach Life Architekture , jika AI dilatih berdasarkan data yang bias, “hal ini mungkin melanggengkan atau memperburuk bias yang ada, sehingga menghasilkan rekomendasi pengobatan yang tidak adil”. Prasangka yang tertanam ini kemungkinan besar juga akan berdampak lebih besar pada kelompok minoritas, sehingga menyoroti pentingnya pengawasan manusia dan kumpulan data pelatihan yang beragam dan representatif.

AI sebagai Asisten Terapis, Bukan Pengganti

Teman ramah seperti Pi dan Woebot akan semakin populer karena pengguna terus mencari cara yang dapat diakses untuk meningkatkan kesehatan mental mereka. Namun, karena berbagai masalah etika, kecerdasan buatan belum siap menggantikan peran terapi tradisional, dan seharusnya tidak demikian.

Namun hal ini tidak berarti bahwa teknologi baru ini tidak akan memberikan dampak besar terhadap praktik secara keseluruhan. Sebagian besar praktisi yang kami ajak bicara percaya bahwa dengan melakukan pekerjaan penting seperti triase, alat AI akan dapat memberi mereka lebih banyak waktu dan energi untuk melakukan praktik lainnya.

“Meskipun hal ini tidak dapat menggantikan hubungan mendalam antarmanusia yang ditawarkan oleh terapis, hal ini dapat berfungsi sebagai alat yang saling melengkapi.” – Aanant Bish, pelatih psikis bisnis

“AI dapat menangani penilaian awal, pemantauan berkelanjutan, dan memberikan dukungan untuk kasus-kasus yang tidak terlalu rumit, sehingga memungkinkan kita untuk fokus pada situasi yang lebih parah atau rumit,” kata Bayu Prihandito kepada Tech.co, sambil menambahkan “ Ini seperti memiliki seperangkat tangan ekstra yang selalu tersedia."

Profesor Columbia dan psikiater bersertifikat Sultan setuju, mengatakan kepada Tech.co bahwa dalam waktu lima tahun, AI kemungkinan akan melengkapi terapi tradisional dengan menyederhanakan tugas-tugas administratif, membantu praktisi membuat rencana perawatan yang lebih personal, dan “ menciptakan model hibrida yang menggabungkan keahlian manusia dengan AI- alat yang didorong untuk meningkatkan pengobatan”.

Hal ini menunjukkan bahwa alih-alih menguras praktik kemanusiaannya, AI sebenarnya memiliki kekuatan untuk melepaskan keterampilan manusia seperti empati, koneksi, dan kasih sayang, sehingga membantu klien mendapatkan lebih banyak manfaat dari layanan tersebut.

Namun, menjaga kesehatan mental adalah hal yang serius dan sering kali menjadi persoalan hidup dan mati. Sebelum AI menjadi asisten setiap terapis, atau bahkan menggantikannya, peraturan ketat seputar penerapan dan penggunaannya perlu dipertimbangkan.

Sampai saat itu tiba, potensi yang jelas dari chatbot AI untuk meningkatkan akses terhadap dukungan kesehatan mental tidak dapat sepenuhnya diselaraskan dengan risiko yang ditimbulkannya. Di dunia di mana dilema etika sering kali terjadi, dilema ini terlalu besar untuk diabaikan.