Penipuan Kloning Suara AI: 1 dari 4 Orang Dewasa Sudah Menjadi Target

Diterbitkan: 2023-05-02Menurut Anda, apakah Anda dapat membedakan antara pesan suara dari seseorang yang Anda cintai, dan pesan suara yang dibuat oleh AI? Nah, scammers yang menggunakan teknologi kloning suara AI untuk menipu korban yang tidak menaruh curiga pasti berharap Anda tidak bisa – dan sekarang, mereka lebih aktif sekarang dari sebelumnya.

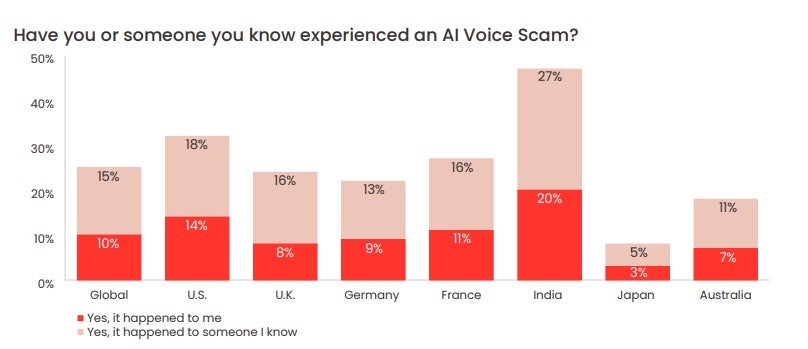

Sebuah survei yang baru-baru ini dilakukan oleh McAfee menemukan bahwa seperempat orang dewasa telah menjadi sasaran penipuan suara AI, dengan sebagian besar kehilangan uang hasil jerih payah sebagai akibatnya. Juga terungkap bahwa mayoritas orang dewasa berbagi suara mereka di platform media sosial dan ruang online lainnya setidaknya seminggu sekali – yang memberi pelaku ancaman apa yang mereka butuhkan untuk melakukan penipuan semacam ini berulang kali.

Jadi, bagaimana sebenarnya penipuan kloning suara AI bekerja, seberapa umum itu, dan bagaimana Anda bisa menemukan penipuan kloning suara AI? Kami melihat lebih dekat.

- Apa Itu Scam Kloning Suara AI?

- Bagaimana Sebenarnya Kloning Suara AI Bekerja

- Seberapa Umum Penipuan AI Voice Clone?

- Bagaimana Mengenalinya Jika Sebuah Pesan Adalah Scam Klon Suara AI

Apa Itu Scam Kloning Suara AI?

Penipuan kloning suara AI adalah penipuan apa pun yang menggunakan file audio yang dibuat secara artifisial untuk menipu korban agar mengira orang yang mereka cintai dalam bahaya, atau membutuhkan bantuan keuangan mendesak dan telah menghubungi mereka untuk meminta bantuan.

Dalam penipuan semacam ini, penipu akan memutar klip pembicaraan subjek – sering diambil dari media sosial – melalui generator suara AI. Menggunakan pembelajaran mesin, generator akan menganalisis irama, nada, dan nada klip awal, dan kemudian memungkinkan penipu menghasilkan audio asli yang unik yang meniru suara subjek hampir sempurna.

Scammer kemudian akan mengirimkan rekaman ini ke teman dan kerabat subjek melalui aplikasi seperti WhatsApp, berharap mereka tidak dapat membedakan antara orang yang mereka cintai dan versi suara mereka yang dihasilkan AI.

Seperti yang biasa terjadi pada penipuan online lainnya , penipu akan mencoba dan menyuntikkan rasa urgensi dan kesusahan ke dalam korespondensi mereka, untuk mendorong target agar bertindak gegabah atau tidak menentu.

Dalam satu kasus baru-baru ini, seorang penipu suara AI mencoba meyakinkan seorang ibu di AS bahwa putrinya telah diculik dengan mengkloning suara anak tersebut.

Yang memprihatinkan, scammer pemula tidak akan kesulitan menemukan file audio yang mereka perlukan untuk menargetkan korban – faktanya, mereka cenderung dimanja oleh pilihan.

Survei Mei 2023 yang diterbitkan oleh McAfee yang melibatkan lebih dari 7.000 orang dari tujuh negara berbeda menemukan bahwa 53% responden survei mengatakan bahwa mereka berbagi suara secara online setidaknya sekali seminggu. Di India, angka ini adalah 86%.

Cara Kerja Kloning Suara Sebenarnya

Kloning suara AI hanya dimungkinkan dengan alat AI yang disebut generator suara AI. Singkatnya, generator suara AI mengubah file teks menjadi ucapan (sering disebut alat "text to speech" atau "TTS").

Generator suara AI menggunakan pembelajaran mesin untuk belajar berbicara dengan cara tertentu dengan menganalisis informasi dari file audio orang yang berbicara. Generator kemudian menerapkan apa yang telah mereka pelajari untuk membaca file teks yang disediakan oleh pengguna dan menghasilkan konten audio asli.

Banyak dari generator ini memiliki suara khusus yang dapat Anda pilih untuk membaca teks Anda, serta suara selebritas untuk dipilih – tetapi yang lain memungkinkan Anda merekam suara Anda sendiri dan membuat konten audio selanjutnya.

Alat text-to-speech Descript.com menawarkan "generator suara canggih yang dideskripsikan sendiri yang menciptakan klon ultra-realistis dari suara Anda sendiri".

Generator suara AI sekarang tersedia secara luas untuk semua jenis perangkat. Program-program ini memberikan banyak nilai bagi orang-orang yang kesulitan membaca, atau hanya belajar lebih baik saat mendengarkan audio daripada membaca kata-kata tertulis.

Mereka juga digunakan oleh perusahaan periklanan yang tidak memiliki anggaran untuk menyewa artis sulih suara yang mahal untuk konten pemasaran mereka.

Keberhasilan dan meluasnya penggunaan ChatGPT telah menempatkan fokus baru pada alat AI dalam segala bentuk dan ukuran, termasuk yang dapat digunakan untuk kloning audio. Terlepas dari kegunaannya yang mulia, sekarang ada ekosistem kecil alat AI TTS yang, sayangnya, dapat disalahgunakan untuk tujuan jahat, termasuk menipu orang.

Seberapa Umum Penipuan AI Voice Clone?

Dalam survei McAfee yang baru-baru ini dirilis, raksasa keamanan siber menemukan bahwa 1 dari 4 orang dewasa yang disurvei pernah mengalami penipuan suara AI.

77% dari mereka yang ditargetkan melaporkan bahwa mereka kehilangan uang karena penipuan tersebut. McAfee melaporkan bahwa dari 77% tersebut, “lebih dari sepertiganya kehilangan lebih dari $1.000, sementara 7% ditipu antara $5.000 dan $15.000”.

Korban di AS paling banyak kehilangan, survei mengungkapkan. 11% korban AS yang kehilangan uang melalui penipuan kloning suara AI kehilangan antara $5.000–$15.000.

Bagaimana Mengenalinya Jika Pesan adalah Scam Klon Suara AI

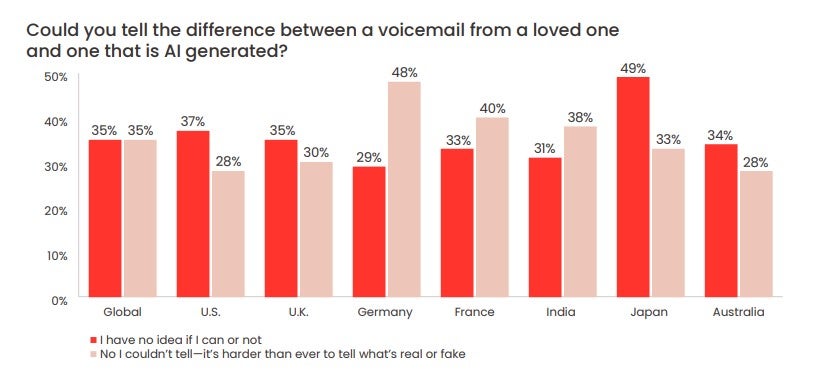

Survei McAfee juga menemukan bahwa 70% orang mengatakan mereka "tidak yakin" apakah mereka dapat membedakan antara suara AI dan suara manusia.

Hampir sepertiga (28%) responden AS mengatakan mereka tidak dapat membedakan antara pesan suara yang ditinggalkan oleh "Penipu Buatan", seperti yang dikatakan McAfee, dan orang yang dicintai.

Ingat, penipu mungkin dapat meniru suara orang yang dicintai – tetapi mengendalikan nomor atau akun WhatsApp orang yang Anda cintai jauh lebih sulit.

Akan sulit untuk bersikap tenang saat terdengar seperti salah satu kerabat atau teman Anda sedang dalam kesulitan. Tetapi dengan penipuan suara AI yang semakin umum, penting bagi Anda untuk melakukannya. Ada beberapa tanda bahwa pesan suara AI mungkin merupakan penipuan:

- Metode kontak yang tidak biasa (misalnya nomor tak dikenal)

- Permintaan segera untuk sejumlah besar uang

- Permintaan uang untuk ditransfer melalui cara yang tidak biasa (misalnya kartu hadiah atau kripto)

- Permintaan agar Anda tidak memberi tahu siapa pun tentang panggilan/insiden tersebut

Dengan mengingat hal itu, inilah saran FTC yang harus Anda lakukan:

- Panggil nomor yang meninggalkan pesan untuk Anda untuk memverifikasi siapa itu

- Hubungi kekasih atau teman Anda di nomor pribadinya

- Pesan keluarga dan teman dekat orang yang dimaksud

Jika Anda tidak dapat melakukan kontak, penting bagi Anda untuk segera memberi tahu penegak hukum. Bagi Anda yang belum menjadi sasaran salah satu penipuan ini tetapi ingin memastikan Anda tidak menjadi korbannya, buat kata aman dengan keluarga dan teman Anda.

Ini adalah kode yang berarti Anda dan orang yang Anda cintai dapat mengidentifikasi diri Anda satu sama lain adalah salah satu cara terbaik untuk memastikan Anda tidak menjadi korban penipuan suara AI. Ini akan sangat berguna untuk anggota keluarga lanjut usia, dan jika tidak pernah ditulis, dapat dibuat sederhana.

Penting juga untuk mengikuti metode, teknik, dan format terbaru yang digunakan penipu suara AI untuk memeras korban. Selain waspada dan memperlakukan panggilan dari nomor yang tidak dikenal dengan sangat hati-hati, menjaga agar telinga tetap rendah sering kali merupakan hal terbaik yang dapat Anda lakukan.