Perché i chatbot per terapia AI sono l’ultimo dilemma etico

Pubblicato: 2023-10-31I chatbot generativi con intelligenza artificiale come ChatGPT vengono utilizzati per semplificare i processi sul posto di lavoro, scrivere codice e persino scrivere script per set di cabaret. Negli Stati Uniti, dove i casi di ansia e depressione stanno raggiungendo livelli record e il supporto professionale resta limitato, non sorprende che anche gli utenti utilizzino la tecnologia per gestire la propria salute mentale.

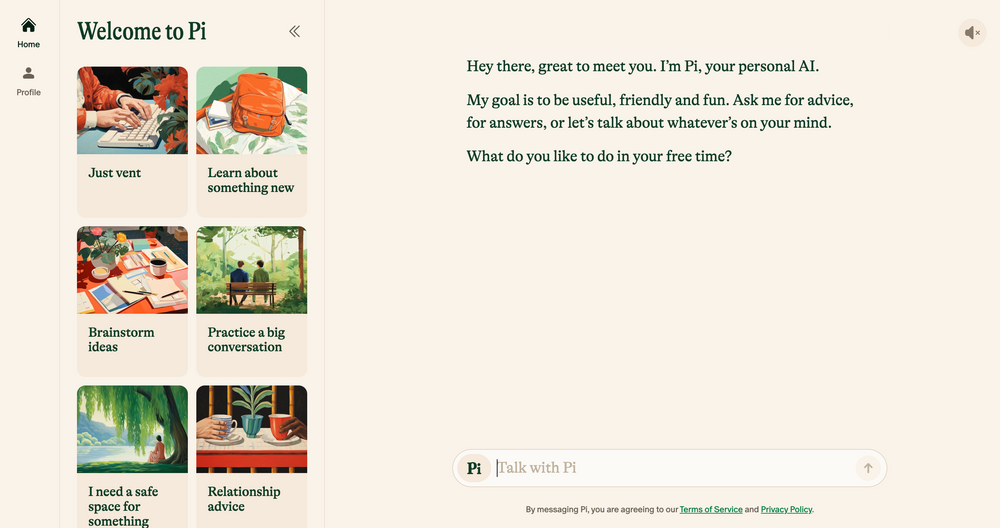

I chatbot basati sull'intelligenza artificiale come Elomia, Pi e Woebot offrono un supporto personalizzato conveniente 24 ore su 24, 7 giorni su 7, basato su tecniche terapeutiche collaudate. Dall'aiutare gli utenti a evitare lunghe liste d'attesa alla riduzione dello stigma relativo all'accesso all'aiuto, i vantaggi sono enormi. L’intelligenza artificiale generativa – che è ancora soggetta a errori, allucinazioni e pregiudizi – potrà mai essere paragonata all’empatia dell’orecchio umano?

Abbiamo parlato con accademici, psicologi e terapisti praticanti per far luce su come la tecnologia emergente potrebbe modellare il futuro della terapia. Discutiamo anche del lato più oscuro della terapia con intelligenza artificiale e individuiamo quali preoccupazioni etiche devono essere affrontate oggi. Ecco cosa abbiamo trovato.

Chatbot AI: la nuova generazione di terapisti robot

Da quando il chatbot ChatGPT di OpenAI è stato lanciato per la prima volta lo scorso novembre, un esercito di imitatori di chatbot è spuntato negli app store: dalle app di uso generale come Google Bard e Claude AI ai simulatori di personaggi Marvel meno convenzionali.

Questo mercato in espansione ha portato anche alla crescita dei chatbot per la terapia dell’intelligenza artificiale, app che utilizzano l’intelligenza artificiale generativa per imitare i consigli e la guida offerti da terapisti qualificati e professionisti della salute mentale.

Vuoi navigare sul Web in privato? O apparire come se fossi in un altro paese?

Vuoi navigare sul Web in privato? O apparire come se fossi in un altro paese?

Ottieni un enorme sconto dell'86% su Surfshark con questa offerta del Black Friday di Tech.co. ![]()

Gli esempi principali includono Pi, un autoproclamato "compagno di chat amichevole" che funge da cassa di risonanza e offre supporto emotivo; Replika, un programma chatbot che imita lo stile di parola e la personalità dei suoi utenti; ed Earkick, un rilevatore di ansia progettato per aiutarti a registrare e superare le emozioni difficili.

“Le piattaforme basate sull’intelligenza artificiale offrono privacy, riducendo lo stigma spesso associato alla ricerca di aiuto per problemi di salute mentale”. – Ryan Sultan, psichiatra certificato e professore alla Columbia University

Come le migliori app per la salute mentale , molte di queste app vantano già download a sei cifre e la loro popolarità non sorprende. A causa della carenza di psicologi, psichiatri e assistenti sociali qualificati, oltre a un picco nella domanda di servizi in tutto il paese, gli Stati Uniti sono attualmente alle prese con una delle peggiori crisi di salute mentale mai registrate.

L’alto costo della terapia tradizionale e i tabù sulla salute mentale stanno inoltre dissuadendo molti dal perseguire le opzioni convenzionali, creando un divario per alternative più discrete e convenienti.

Le prime prove suggeriscono che sono anche efficaci. I risultati di Earkick di AI Chatbot hanno rivelato che l'umore degli utenti è migliorato del 34% e i livelli di ansia sono diminuiti del 32% dopo aver utilizzato l'app per cinque mesi. Tuttavia, per quanto queste app possano avere successo nel sedare ansie minori, sicuramente non sono la panacea per la salute mentale che tutti stavamo aspettando.

Chatbot IA inadatti a gravi condizioni di salute mentale

Ricevere consigli sensati e approvati dal terapista da un chatbot tascabile sarà senza dubbio utile per molti. Tuttavia, coloro che soffrono di gravi condizioni di salute mentale come depressione, schizofrenia e disturbo bipolare probabilmente rimarranno invariati.

I disturbi mentali sono complessi, fortemente sfumati e unici per ciascuna persona che li colpisce. In alcuni casi, è meglio gestirli con farmaci che possono essere prescritti correttamente solo da professionisti medici qualificati. Sebbene i modelli linguistici di grandi dimensioni (LLM) abbiano fatto passi da gigante negli ultimi anni, i loro risultati non saranno mai in grado di sostituire l’esperienza clinica, l’empatia e la compassione fornite da psichiatri, psicologi e terapisti.

"Apprezzo che gli algoritmi siano migliorati, ma alla fine non credo che affronteranno le realtà sociali più caotiche in cui si trovano le persone quando cercano aiuto", - Julia Brown, professoressa di antropologia presso l'Università della California, San Francisco

Il guaritore psichico strategico Aanant Bisht ritiene inoltre che l'intelligenza artificiale, nel suo stato attuale, non sarà in grado di aiutare il complesso percorso di guarigione di ogni utente. "È inoltre essenziale evitare la semplificazione eccessiva di problemi complessi di salute mentale e incoraggiare gli utenti a cercare un aiuto professionale quando richiesto", afferma Bisht a Tech.co.

Un’altra preoccupazione comune espressa dagli esperti con cui abbiamo parlato è la diagnosi medica errata. La comunità della salute mentale ha un problema di lunga data nell’identificare correttamente i disturbi psichiatrici complessi e gravi, e un forte affidamento sull’intelligenza artificiale potrebbe probabilmente esacerbare questo problema, a causa delle tecnologie limitate, dei set di dati non rappresentativi e dell’incapacità di interpretare le sfumature umane.

Anche i risultati di questo possono essere duri. Una diagnosi errata della salute mentale spesso porta a cure e supporto inadeguati, ulteriori pressioni mentali e scetticismo a lungo termine nei confronti del sistema medico. Questo non è l’unico motivo per cui l’intelligenza artificiale non è adatta a prendere il posto del terapeuta nella sua forma attuale.

L’intelligenza artificiale è difettosa e avvolta da sfide etiche

La rapida ascesa dell’intelligenza artificiale generativa non è avvenuta senza conseguenze. Mentre la tecnologia continua a svilupparsi a una velocità vertiginosa, la regolamentazione sul suo utilizzo è stata lenta a recuperare il ritardo, contribuendo a una serie di sfide etiche relative alla privacy dei dati, ai pregiudizi incorporati e all’uso improprio.

Queste preoccupazioni non riguardano esclusivamente la terapia, ma la natura sensibile della salute mentale fa sì che i quadri etici siano al centro di ogni buona relazione terapeutica. Con un codice etico ufficiale sull’intelligenza artificiale attualmente inesistente, gli utenti che si affidano ai chatbot invece che a professionisti qualificati per la consulenza o altro supporto per la salute mentale sono altamente problematici.

La privacy dei dati è una questione importante. Chatbot come ChatGPT si sono spesso ritrovati nei guai per non aver protetto i dati degli utenti . Affinché gli utenti si sentano a proprio agio nel discutere informazioni private e personali, le società di intelligenza artificiale dovranno disporre di una strategia di protezione dei dati infallibile che dia priorità alla riservatezza.

“La natura intima e sensibile delle conversazioni terapeutiche richiede un livello senza precedenti di protezione dei dati”. – Dr. Langham, psicologo della Terapia a Impulsi

Un altro fattore importante di cui essere consapevoli è il bias dell’apprendimento automatico. Tutti i sistemi di intelligenza artificiale si basano su dati di addestramento predeterminati, che spesso includono pregiudizi umani incorporati anche se vengono rimosse variabili sensibili come razza e genere.

Secondo Bayu Prihandito, amministratore delegato della società di life coach Life Architekture , se l’intelligenza artificiale fosse addestrata su dati distorti, “potrebbe perpetuare o esacerbare i pregiudizi esistenti, portando a raccomandazioni di trattamento ingiuste”. È probabile che questi pregiudizi intrinseci abbiano un impatto maggiore anche sulle persone appartenenti a gruppi minoritari, evidenziando l’importanza della supervisione umana e di set di dati di formazione diversi e rappresentativi.

L'intelligenza artificiale come assistente del terapista, non come sostituto

Compagni amichevoli come Pi e Woebot non potranno che crescere in popolarità man mano che gli utenti continueranno a cercare modi accessibili per integrare il proprio benessere mentale. Tuttavia, a causa di una vasta gamma di preoccupazioni etiche, l’intelligenza artificiale non è pronta a sostituire il ruolo della terapia tradizionale, né dovrebbe mai farlo.

Questo non vuol dire però che la tecnologia emergente non avrà un impatto enorme sulla pratica nel suo insieme. La maggior parte dei professionisti con cui abbiamo parlato ritiene che, svolgendo il lavoro duro come il triage, gli strumenti di intelligenza artificiale saranno in grado di dare loro più tempo ed energia da dedicare ad altre aree della pratica.

“Sebbene non possa sostituire la profonda connessione umana offerta dai terapeuti, può fungere da strumento complementare”. – Aanant Bish, coach sensitivo aziendale

"L'intelligenza artificiale potrebbe gestire valutazioni iniziali, monitoraggio continuo e fornire supporto per casi meno complessi, permettendoci di concentrarci su situazioni più gravi o delicate", ha detto Bayu Prihandito a Tech.co, aggiungendo " È come avere un paio di mani in più che sono sempre disponibile."

Il professore della Columbia e psichiatra certificato Sultan è d'accordo, dicendo a Tech.co che tra cinque anni, l'intelligenza artificiale probabilmente integrerà la terapia tradizionale semplificando i compiti amministrativi, aiutando i professionisti a creare piani di trattamento più personalizzati e " creando modelli ibridi che combinano l'esperienza umana con l'intelligenza artificiale". strumenti guidati per migliorare il trattamento”.

Ciò suggerisce che, lungi dal prosciugare la pratica della sua umanità, l’intelligenza artificiale ha in realtà il potere di liberare abilità umane come l’empatia, la connessione e la compassione, aiutando i clienti a ottenere ancora di più dal servizio.

Tuttavia, prendersi cura della salute mentale è una cosa seria e spesso può essere una questione di vita o di morte. Prima che l’intelligenza artificiale diventi l’assistente di ogni terapista, o addirittura lo sostituisca, è necessario prendere in considerazione norme rigorose sulla sua implementazione e utilizzo.

Fino a quando non arriverà quel momento, l’evidente potenziale dei chatbot basati sull’intelligenza artificiale di migliorare l’accesso al supporto per la salute mentale non può essere pienamente conciliato con i rischi che comportano. In un mondo in cui i dilemmi etici sono spesso la norma, questo è semplicemente troppo grande per essere ignorato.