Truffe di clonazione vocale AI: 1 adulto su 4 già preso di mira

Pubblicato: 2023-05-02Pensi di poter distinguere tra un messaggio vocale di qualcuno che ami e un messaggio vocale generato dall'intelligenza artificiale? Ebbene, i truffatori che utilizzano la tecnologia di clonazione vocale AI per frodare vittime ignare sperano sicuramente che tu non possa farlo - e ora sono più attivi che mai.

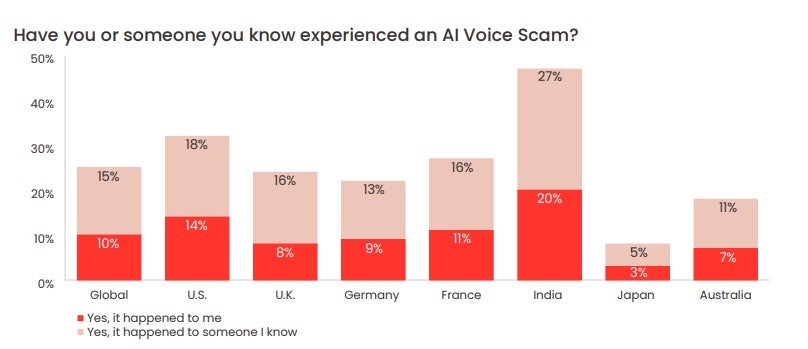

Un sondaggio recentemente condotto da McAfee ha rilevato che un quarto degli adulti è già stato preso di mira da truffe vocali basate sull'intelligenza artificiale, con la stragrande maggioranza che ha perso soldi guadagnati duramente. Ha anche rivelato che la maggior parte degli adulti condivide la propria voce su piattaforme di social media e altri spazi online almeno una volta alla settimana, il che offre agli attori delle minacce esattamente ciò di cui hanno bisogno per eseguire ripetutamente questo tipo di truffa.

Quindi, come funzionano effettivamente le truffe di clonazione vocale AI, quanto è comune e come puoi individuare una truffa di clonazione vocale AI? Diamo un'occhiata più da vicino.

- Che cos'è una truffa di clonazione vocale AI?

- Come funziona effettivamente la clonazione vocale AI

- Quanto sono comuni le truffe di clonazione vocale AI?

- Come sapere se un messaggio è una truffa di clonazione vocale AI

Che cos'è una truffa di clonazione vocale AI?

Una truffa di clonazione vocale AI è qualsiasi truffa che utilizza file audio generati artificialmente per indurre le vittime a pensare che i loro cari siano in pericolo o abbiano bisogno di assistenza finanziaria urgente e li abbiano contattati per chiedere aiuto.

In una truffa di questo tipo, un truffatore eseguirà una clip di un soggetto che parla - spesso raschiato dai social media - attraverso un generatore vocale AI. Utilizzando l'apprendimento automatico, il generatore analizzerà la cadenza, il tono e il tono della clip iniziale, quindi consentirà al truffatore di produrre un audio unico e originale che imita perfettamente la voce dei soggetti.

Il truffatore invierà quindi queste registrazioni ad amici e parenti del soggetto tramite app come WhatsApp, sperando che non siano in grado di distinguere tra la persona amata e una versione della sua voce generata dall'intelligenza artificiale.

Come è comune ad altre truffe online , il truffatore cercherà di iniettare un senso di urgenza e angoscia nella loro corrispondenza, al fine di spingere il bersaglio ad agire in modo avventato o irregolare.

In un caso recente, un truffatore vocale AI ha cercato di convincere una madre negli Stati Uniti che sua figlia era stata rapita clonando la voce della bambina.

Preoccupante, un truffatore in erba non avrà difficoltà a portare alla luce i file audio di cui avrà bisogno per prendere di mira una vittima - in effetti, è probabile che abbia solo l'imbarazzo della scelta.

Un sondaggio del maggio 2023 pubblicato da McAfee che ha coinvolto oltre 7.000 persone provenienti da sette paesi diversi ha rilevato che il 53% degli intervistati ha affermato di condividere la propria voce online almeno una volta alla settimana. In India, questa cifra era dell'86%.

Come funziona effettivamente la clonazione vocale

La clonazione della voce AI è possibile solo con uno strumento AI chiamato generatore di voce AI. In poche parole, i generatori di voci AI trasformano i file di testo in parlato (spesso chiamato strumento "text to speech" o "TTS").

I generatori di voci AI utilizzano l'apprendimento automatico per insegnare a se stessi a parlare in modi specifici analizzando le informazioni dai file audio delle persone che parlano. I generatori applicano quindi ciò che hanno appreso per leggere i file di testo forniti dagli utenti e generare contenuti audio originali.

Molti di questi generatori hanno voci personalizzate che puoi selezionare per leggere il tuo testo, così come voci di celebrità tra cui scegliere, ma altri ti permetteranno di registrare la tua voce e creare successivi contenuti audio.

Lo strumento di sintesi vocale Descript.com offre un "generatore vocale all'avanguardia che crea un clone ultra realistico della tua stessa voce".

I generatori vocali AI sono ora ampiamente disponibili per tutti i tipi di dispositivi. Questi programmi offrono molto valore alle persone che hanno difficoltà a leggere o semplicemente imparano meglio ascoltando l'audio piuttosto che leggendo la parola scritta.

Sono anche utilizzati dalle società pubblicitarie che non hanno un budget per assumere un costoso doppiatore per i loro contenuti di marketing.

Il successo e l'uso diffuso di ChatGPT ha posto una rinnovata attenzione sugli strumenti AI di tutte le forme e dimensioni, compresi quelli che possono essere utilizzati per la clonazione audio. Nonostante i loro usi nobili, ora esiste un piccolo ecosistema di strumenti di intelligenza artificiale TTS che, sfortunatamente, può essere abusato per fini nefasti, tra cui truffare le persone.

Quanto sono comuni le truffe di clonazione vocale AI?

Nel sondaggio McAfee pubblicato di recente, il gigante della sicurezza informatica ha scoperto che 1 adulto su 4 intervistato ha subito una truffa vocale AI.

Il 77% delle persone prese di mira ha riferito di aver perso denaro a causa della truffa. McAfee riferisce che di quel 77%, "più di un terzo ha perso oltre $ 1.000, mentre il 7% è stato ingannato tra $ 5.000 e $ 15.000".

Le vittime negli Stati Uniti perdono di più, rivela il sondaggio. L'11% delle vittime statunitensi che hanno perso denaro a causa di truffe di clonazione vocale AI ha perso tra $ 5.000 e $ 15.000.

Come sapere se un messaggio è una truffa di clonazione vocale AI

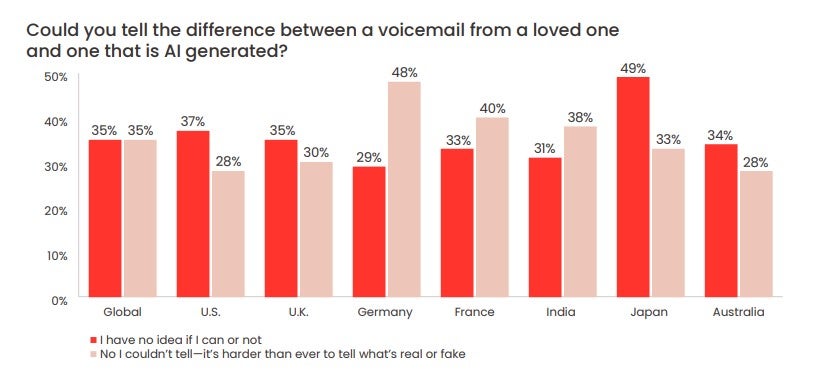

Il sondaggio McAfee ha anche rilevato che il 70% delle persone ha affermato di non essere "sicuro" se sarebbe stato in grado di distinguere tra una voce AI e una voce umana.

Quasi un terzo (28%) degli intervistati statunitensi ha affermato di non essere in grado di distinguere tra un messaggio vocale lasciato da un "impostore artificiale", come afferma McAfee, e una persona cara.

Ricorda, i truffatori possono essere in grado di replicare la voce di una persona cara, ma assumere il controllo del numero della persona amata o dell'account WhatsApp è molto più difficile.

Può essere difficile agire con calma quando sembra che uno dei tuoi parenti o amici sia in difficoltà. Ma con le truffe vocali AI che diventano sempre più comuni, è importante che tu lo faccia. Ci sono alcuni segni che un messaggio vocale AI potrebbe essere una truffa:

- Un metodo di contatto insolito (ad es. un numero sconosciuto)

- Richieste immediate per ingenti somme di denaro

- Richieste di trasferimento di denaro tramite mezzi insoliti (es. buoni regalo o criptovalute)

- Una richiesta di non dire a nessuno della chiamata/incidente

Con questo in mente, ecco cosa consiglia la FTC di fare:

- Chiama il numero che ti ha lasciato il messaggio per verificare chi è

- Chiama la persona amata o un amico sul loro numero personale

- Invia un messaggio alla famiglia e agli amici intimi della persona in questione

Se non riesci a metterti in contatto, è importante che informi immediatamente le forze dell'ordine. Per quelli di voi che non sono ancora stati presi di mira da una di queste truffe ma vogliono assicurarsi di non caderne vittime, stabilite una safeword con la vostra famiglia e i vostri amici.

Questo è un codice che significa che tu e i tuoi cari potete identificarvi l'un l'altro è uno dei modi migliori per assicurarvi di non cadere vittima di una truffa vocale AI. Questo sarà particolarmente utile per i membri anziani della famiglia e, se non viene mai scritto, può essere mantenuto abbastanza semplice.

È anche importante tenere il passo con i metodi, le tecniche e i formati più recenti che i truffatori vocali di intelligenza artificiale utilizzano per estorcere le vittime. Oltre a essere vigili e trattare le chiamate da numeri sconosciuti con estrema cautela, tenere l'orecchio a terra è spesso la cosa migliore che puoi fare.