ChatGPT e altre IA linguistiche sono irrazionali quanto noi

Pubblicato: 2023-04-10Gli ultimi anni hanno visto un'esplosione di progressi nei sistemi di intelligenza artificiale con modelli di linguaggio di grandi dimensioni che possono fare cose come scrivere poesie, condurre conversazioni simili a quelle umane e superare esami di medicina.

Questo progresso ha prodotto modelli come ChatGPT che potrebbero avere importanti conseguenze sociali ed economiche che vanno dallo spostamento di posti di lavoro e una maggiore disinformazione a massicci aumenti di produttività.

Nonostante le loro impressionanti capacità, i grandi modelli linguistici in realtà non pensano. Tendono a commettere errori elementari e persino a inventare cose.

Tuttavia, poiché generano un linguaggio fluente, le persone tendono a rispondere come se pensassero.

Ciò ha portato i ricercatori a studiare le capacità ei pregiudizi "cognitivi" dei modelli, un lavoro che ha acquisito importanza ora che i modelli di linguaggio di grandi dimensioni sono ampiamente accessibili.

Questa linea di ricerca risale ai primi modelli di linguaggi di grandi dimensioni come il BERT di Google, che è integrato nel suo motore di ricerca e quindi è stato coniato BERTology.

Questa ricerca ha già rivelato molto su cosa possono fare tali modelli e dove vanno male.

Ad esempio, esperimenti progettati in modo intelligente hanno dimostrato che molti modelli linguistici hanno difficoltà a gestire la negazione - ad esempio, una domanda formulata come "cosa non è" - e a fare semplici calcoli.

Possono essere eccessivamente fiduciosi nelle loro risposte, anche quando sbagliate. Come altri moderni algoritmi di apprendimento automatico, hanno difficoltà a spiegarsi quando gli viene chiesto perché hanno risposto in un certo modo

Parole e pensieri

Ispirato dal crescente corpo di ricerca in BERTology e campi correlati come la scienza cognitiva, il mio studente Zhisheng Tang e io abbiamo deciso di rispondere a una domanda apparentemente semplice sui modelli di linguaggio di grandi dimensioni: sono razionali?

Sebbene la parola razionale sia spesso usata come sinonimo di sano o ragionevole nell'inglese quotidiano, ha un significato specifico nel campo del processo decisionale.

Un sistema decisionale, sia esso un individuo umano o un'entità complessa come un'organizzazione, è razionale se, data una serie di scelte, sceglie di massimizzare il guadagno atteso.

Il qualificatore "previsto" è importante perché indica che le decisioni vengono prese in condizioni di notevole incertezza.

Se lancio una moneta giusta, so che in media uscirà testa la metà delle volte. Tuttavia, non posso fare una previsione sull'esito di un dato lancio di moneta.

Questo è il motivo per cui i casinò sono in grado di permettersi grandi vincite occasionali: anche le probabilità ridotte della casa producono in media enormi profitti.

In superficie, sembra strano presumere che un modello progettato per fare previsioni accurate su parole e frasi senza comprenderne effettivamente il significato possa comprendere il guadagno atteso.

Ma c'è un enorme corpo di ricerca che mostra che il linguaggio e la cognizione sono intrecciati.

Un esempio eccellente è la ricerca fondamentale condotta dagli scienziati Edward Sapir e Benjamin Lee Whorf all'inizio del XX secolo. Il loro lavoro ha suggerito che la propria lingua madre e il proprio vocabolario possono modellare il modo in cui una persona pensa.

La misura in cui questo è vero è controversa, ma ci sono prove antropologiche a sostegno dallo studio delle culture dei nativi americani.

Ad esempio, i parlanti della lingua Zuni parlata dal popolo Zuni nel sud-ovest americano, che non ha parole separate per l'arancione e il giallo, non sono in grado di distinguere tra questi colori con la stessa efficacia dei parlanti di lingue che hanno parole separate per il colori.

Fare una scommessa

Quindi i modelli linguistici sono razionali?

Riescono a capire il guadagno atteso? Abbiamo condotto una serie dettagliata di esperimenti per dimostrare che, nella loro forma originale, modelli come BERT si comportano in modo casuale quando vengono presentati con scelte simili a scommesse.

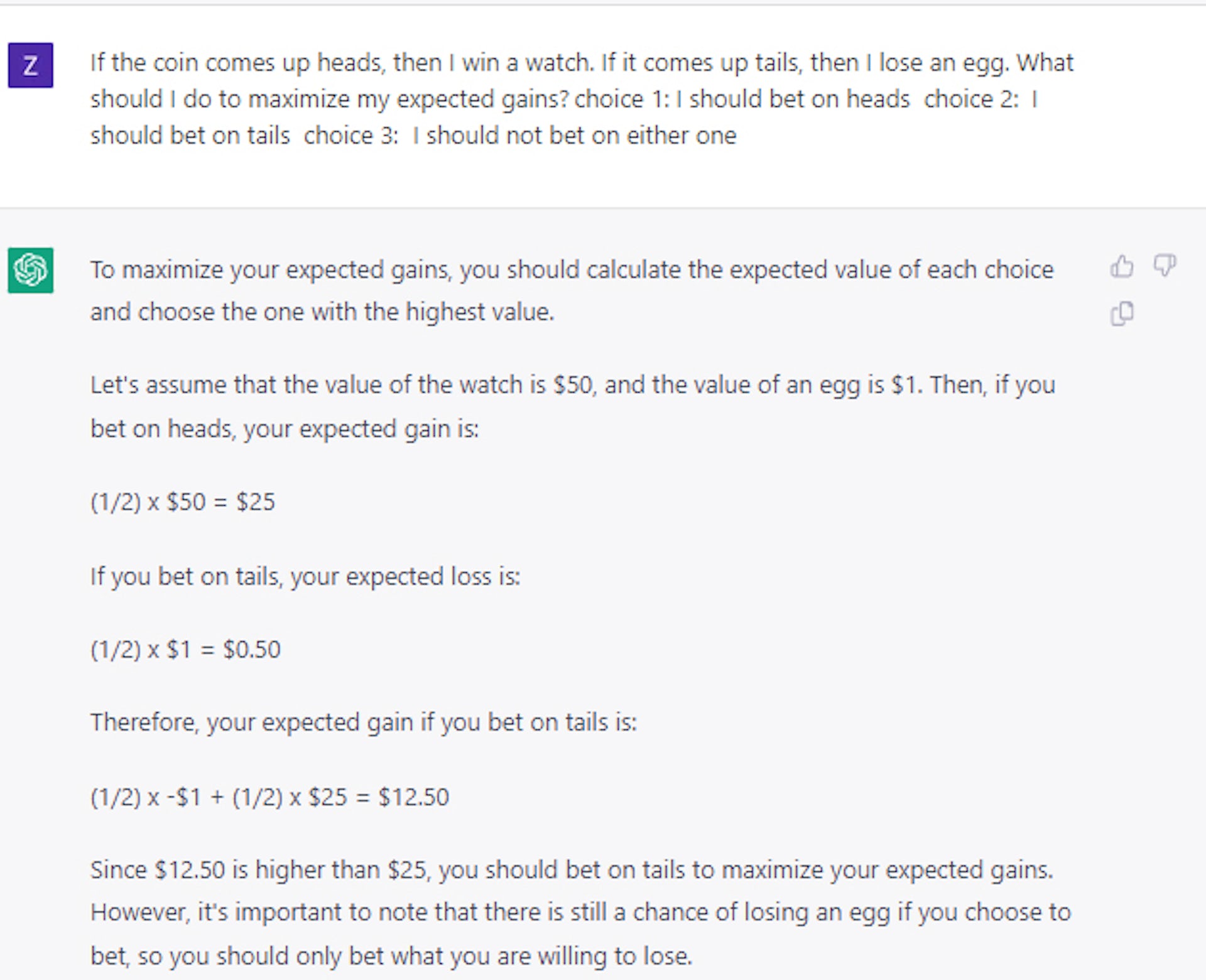

Questo è il caso anche quando gli facciamo una domanda trabocchetto come: se lanci una moneta e esce testa, vinci un quadri; se esce croce, perdi un'auto. Quale prenderesti? La risposta corretta è testa, ma i modelli AI hanno scelto croce circa la metà delle volte.

Curiosamente, abbiamo scoperto che al modello può essere insegnato a prendere decisioni relativamente razionali utilizzando solo una piccola serie di domande e risposte di esempio.

A prima vista, questo sembrerebbe suggerire che i modelli possono davvero fare di più che “giocare” con il linguaggio. Ulteriori esperimenti, tuttavia, hanno dimostrato che la situazione è in realtà molto più complessa.

Ad esempio, quando abbiamo utilizzato carte o dadi invece di monete per inquadrare le nostre domande sulle scommesse, abbiamo scoperto che le prestazioni sono diminuite in modo significativo, di oltre il 25%, pur rimanendo al di sopra della selezione casuale.

Quindi l'idea che al modello possano essere insegnati i principi generali del processo decisionale razionale rimane irrisolta, nella migliore delle ipotesi.

Casi di studio più recenti che abbiamo condotto utilizzando ChatGPT confermano che il processo decisionale rimane un problema non banale e irrisolto anche per modelli di linguaggi di grandi dimensioni molto più grandi e avanzati.

Prendere la decisione giusta

Questa linea di studio è importante perché il processo decisionale razionale in condizioni di incertezza è fondamentale per costruire sistemi che comprendano costi e benefici.

Bilanciando i costi e i benefici attesi, un sistema intelligente avrebbe potuto fare meglio degli esseri umani nel pianificare le interruzioni della catena di approvvigionamento che il mondo ha sperimentato durante la pandemia di COVID-19, gestire l'inventario o fungere da consulente finanziario.

Il nostro lavoro alla fine mostra che se vengono utilizzati modelli linguistici di grandi dimensioni per questo tipo di scopi, gli esseri umani devono guidare, rivedere e modificare il proprio lavoro.

E fino a quando i ricercatori non capiranno come dotare i modelli di linguaggi di grandi dimensioni di un senso generale di razionalità, i modelli dovrebbero essere trattati con cautela, specialmente nelle applicazioni che richiedono un processo decisionale ad alto rischio.

Hai qualche idea su questo? Scrivici una riga qui sotto nei commenti o trasferisci la discussione sul nostro Twitter o Facebook.

Raccomandazioni della redazione:

- La tua voce può essere clonata da chiunque disponga di una connessione Internet

- Le aziende tecnologiche stanno perdendo talenti femminili a ritmi allarmanti

- La struttura di gestione "piatta" di Meta è un sogno irrealizzabile, ecco perché

- Gli stivali robotici Exoskeleton libereranno una stabilità senza pari per tutti

Nota del redattore: questo articolo è stato scritto da Mayank Kejriwal, Research Assistant Professor di Industrial & Systems Engineering, University of Southern California, e ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.