Come eseguire DeepSeek AI localmente su Android: una guida passo-passo

Pubblicato: 2025-02-14Dal suo lancio, Chatgpt è diventato rapidamente uno dei migliori modelli. Google ha raggiunto il suo modello Gemini e quasi tutte le società nel 2025 hanno integrato l'intelligenza artificiale nelle loro app e creato servizi attorno ad esso.

Anche questo ha un costo. Openi ha riversato miliardi di dollari nello sviluppo di Chatgpt; Tuttavia, una società di intelligenza artificiale cinese, con il suo modello DeepSeek, che corrisponde quasi alla capacità del modello di ragionamento di CHATGPT, apparentemente è stata sviluppata a una frazione del costo.

Questo ha colpito il mercato statunitense e ci ha fatto ripensare lo sviluppo di chatbot e LLM AI. DeepSeek è così dirompente che ora puoi eseguire modelli di ragionamento LLM noti per le loro capacità di pensiero prima di rispondere alle tue domande a livello locale sul tuo dispositivo. Abbiamo già una guida dettagliata su come eseguire DeepSeek localmente su Windows e Mac. In questa guida, esamineremo l'installazione e l'esecuzione del modello DeepSeek R1 localmente sul tuo smartphone Android.

Sommario

Requisiti minimi del dispositivo per installare ed eseguire DeepSeek localmente sul dispositivo

Poiché LLM richiede risorse per funzionare, sono presenti requisiti minimi di sistema per l'installazione e l'utilizzo di DeepSeek R1 localmente sul dispositivo. Ricorda, questi sono requisiti di sistema per il modello più piccolo da 1,5b. Un modello da 7,8,32b e 70 miliardi di 70 miliardi richiede anche requisiti di sistema più elevati.

| Specifiche | Specifiche minime |

| RAM | 8 GB o più |

| Processore | Snapdragon 8 Gen 2 o equivalente |

| Magazzinaggio | Almeno 12 GB di spazio libero |

| Sistema operativo | Android 12 o successivo |

Con questo in mente, se si desidera uno smartphone di flagship Android con i requisiti di sistema, andiamo alla guida passo-passo e installiamo ed eseguiamo DeepSeek AI sul tuo dispositivo.

Guida passo-passo per eseguire DeepSeek localmente sul tuo dispositivo

Puoi installare ed eseguire Deep Seek AI localmente sul tuo dispositivo in diversi modi. In questo post, imparerai come utilizzare Termun per installare ed eseguire modelli AI locali a livello locale. Tuttavia, ciò richiede di lavorare con il terminale; Se desideri un metodo facile, puoi utilizzare l'app DocketPal AI. Vedere il secondo metodo.

Passaggio 1: installa Termux

Passaggio 1.1: Scarica l' app Termux dalla pagina GitHub ufficiale.

Termux è un'app Android emulatore del terminale che porta la sua riga di comando su dispositivi mobili come Android. Ti consente di eseguire programmi di comando, installare pacchetti Linux, eseguire comandi shell e consente di installare strumenti come Python e SSH sul dispositivo. Ancora più importante, a differenza di molte app, non richiede l'accesso alla root, il che significa che chiunque può installare questa app senza il root o il jailbreaking del dispositivo, rendendolo sicuro e facile da usare per le aziende.

L'app non è disponibile su Google Play Store o App Store dopo che è stato rimosso dal Play Store. Tuttavia, è possibile installarlo facilmente da fonti di terze parti e siti Web come GitHub. Abbiamo anche una guida dettagliata su collegamenti ufficiali e sicuri per Termux. Puoi visitare la nostra guida e installare l'ultimo APK.

Per questa guida, è possibile installare Termux dalla pagina GitHub.

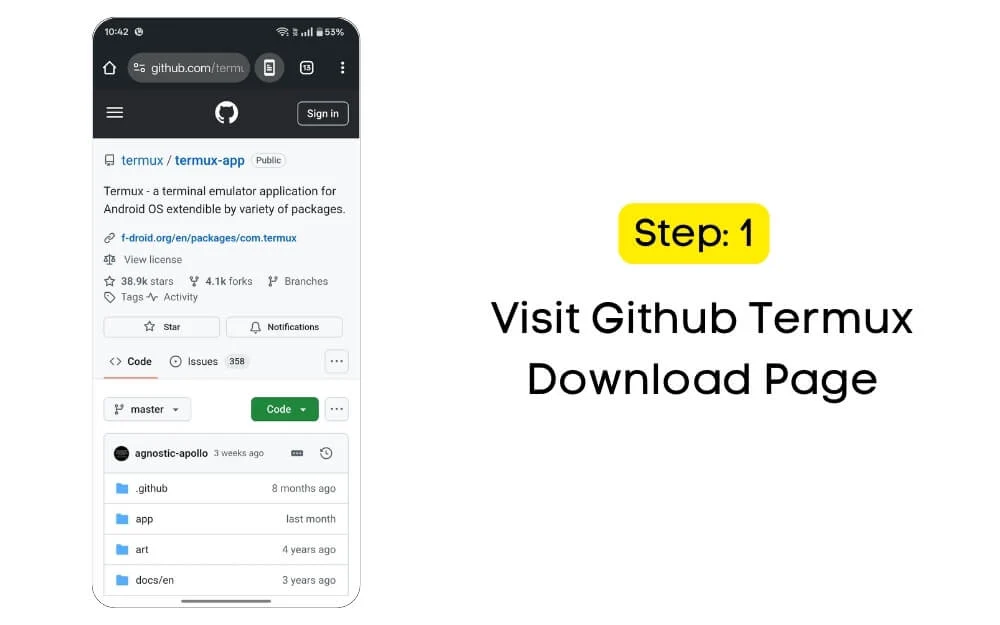

Passaggio 1.2: visitare la pagina di download di GitHub Termux

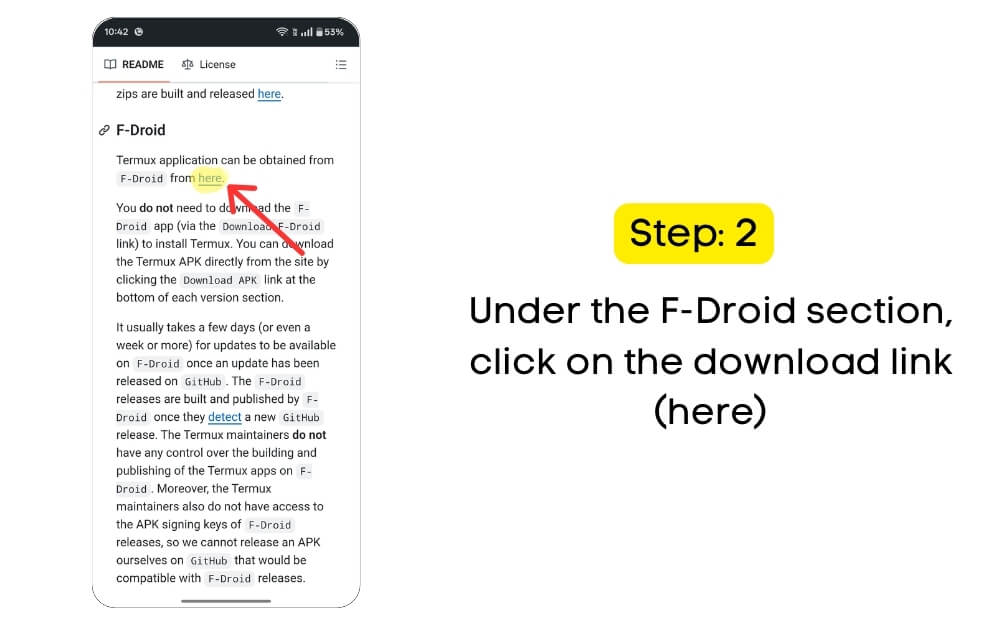

Passaggio 1.3: Scorri verso il basso e nella sezione F-DRIOD , fare clic sul collegamento Download (qui) oppure è possibile utilizzare questo link per il download diretto per visitare la pagina F-Drop.

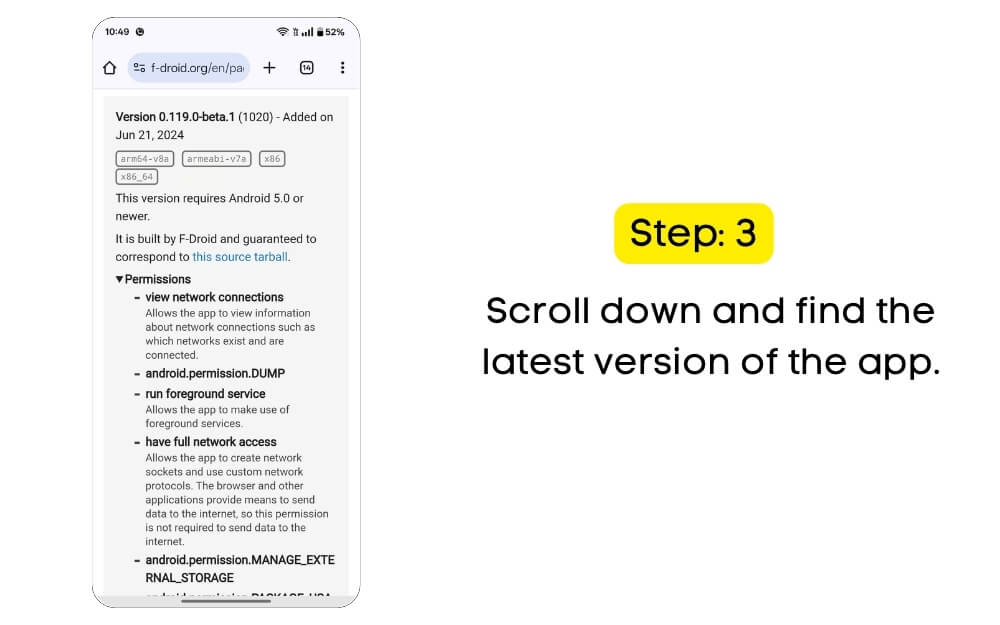

Passaggio 1.4: scorri verso il basso e trova l'ultima versione dell'app (al momento della stesura di questo articolo, l'ultima versione è 0.119.0-beta.1 (1020); ha funzionato bene per me; se hai problemi, puoi scaricare la versione stabile.

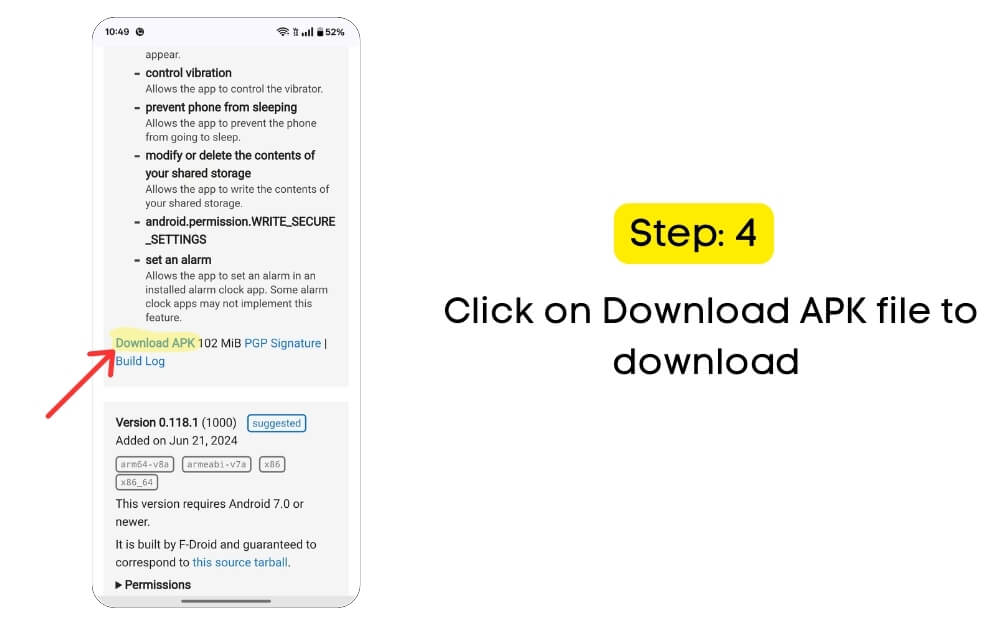

Passaggio 1.5: fare clic sul file APK Scarica per scaricare.

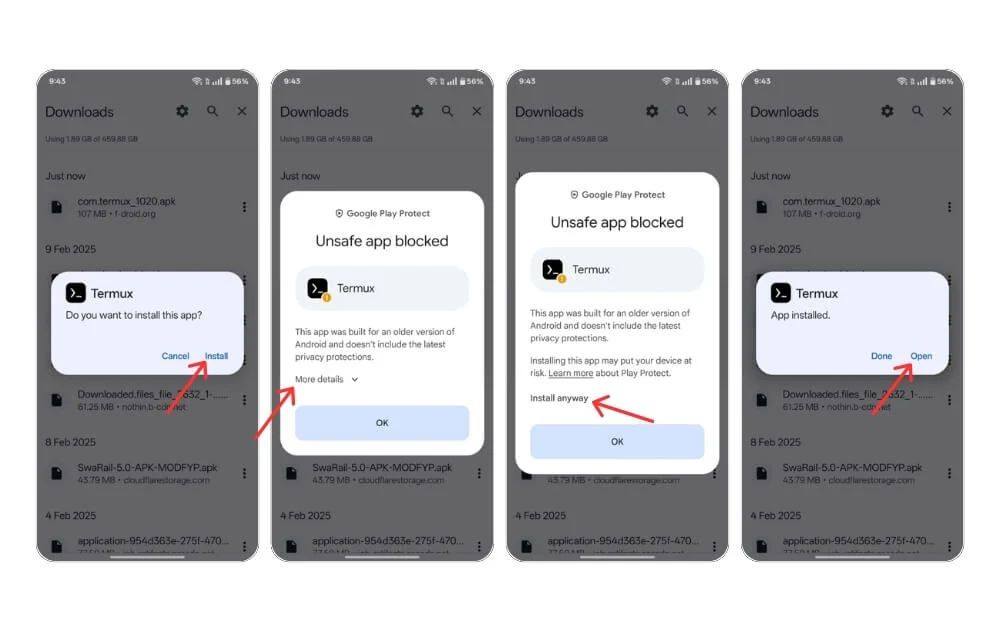

Passaggio 1.6 : vai al file scaricato e fai clic sull'installazione . Se hai bisogno di autorizzazioni, abilita ' installare da fonti sconosciute' nelle impostazioni Android. Installa e apri Termux sul dispositivo.

Passaggio 1.7: se è presente un prompt di sicurezza, fare clic sull'opzione più e toccare l'opzione Installa comunque e l'app verrà installata correttamente sul dispositivo.

Passaggio 1.7: se è presente un prompt di sicurezza, fare clic sull'opzione più e toccare l'opzione Installa comunque e l'app verrà installata correttamente sul dispositivo.

Passaggio 2: ora impostiamo Termux

Una volta lì, è necessario impostare Termux per essere eseguito sul dispositivo.

Per fare ciò, aprire l'app e concedere l'autorizzazione di archiviazione. Per impostazione predefinita, Termux non ha il permesso di accedere ai file del telefono dopo aver installato l'app. Utilizzando questo comando, è possibile concedere l'autorizzazione per accedere ai file Android, leggere e archiviare i dati e utilizzare i comandi di gestione dei file.

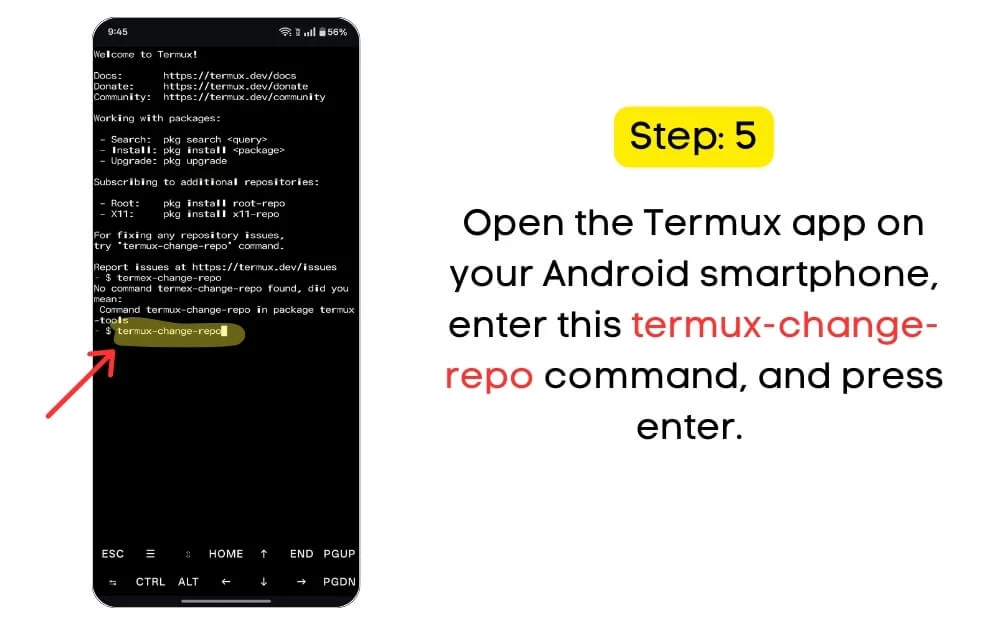

Passaggio 2.1: aprire l' app Termux sul tuo smartphone Android, immettere questo comando e premere Invio. Termux-Change-Repo

Tuttavia, pur facendo ciò, potresti riscontrare errori comuni come l'errore "autorizzazione negata", che si verifica quando Android nega la concessione dell'autorizzazione. Vai su Impostazioni> Autorizzazione dell'app S per correggere questo e abilitare manualmente le autorizzazioni di archiviazione.

Un altro errore comune che gli utenti devono affrontare è l'errore " nessun file o directory ", il che significa che l'archiviazione non è inizializzata. In questo caso, chiudere l' app Termux , riaprirla, fermarlo e riaprirla dopo aver eseguito il comando.

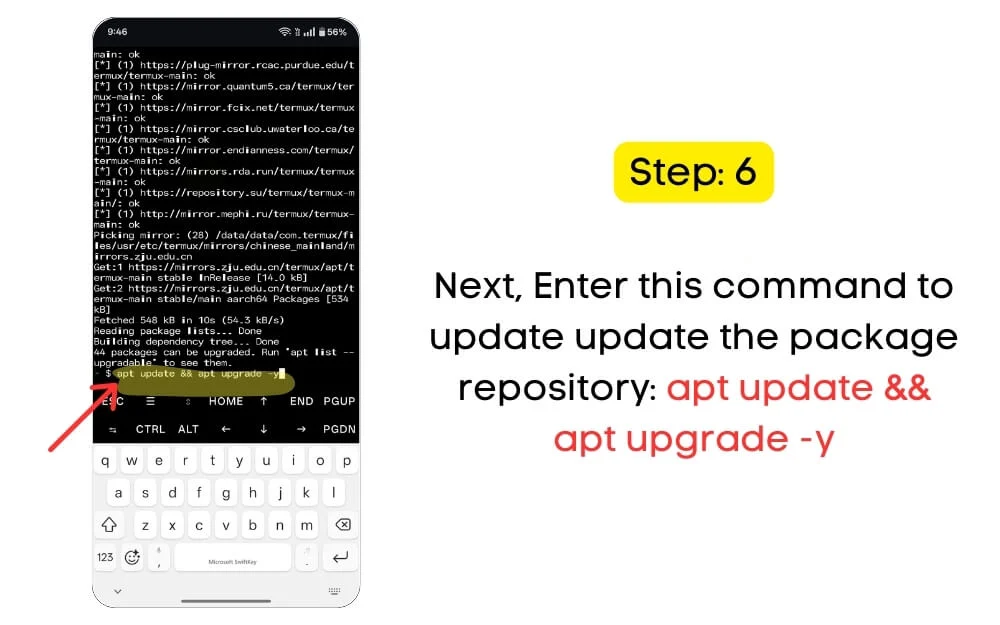

Passaggio 2.2: Successivamente, è necessario aggiornare il repository dei pacchetti. È possibile utilizzare il comando qui sotto per aggiornare il repository pacchetto. Nell'app Termux, immettere questo comando: Apt Update && Apt Upgrade -y

È necessario aggiornare il repository Termux per aggiornare tutti i pacchetti. Questo ti aiuterà a ottenere le ultime patch di sicurezza e prevenire problemi di compatibilità. Tuttavia, quando lo fai, assicurati di avere una connessione Internet attiva per recuperare i pacchetti più recenti dal server e installarli sulla tua app Termux.

Passaggio 3. Successivamente, installa Proot Distro & Debian 12

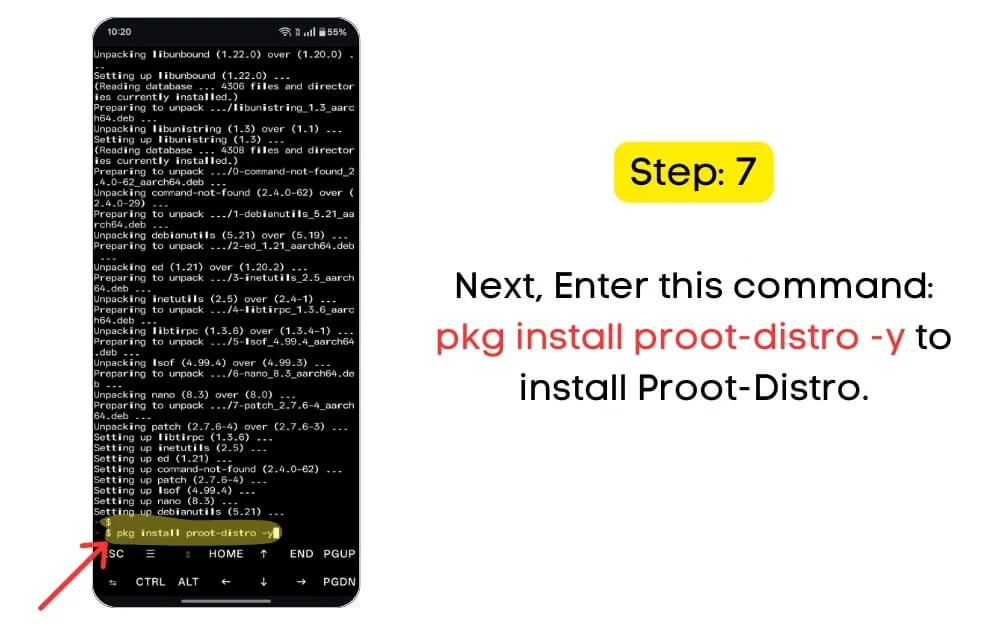

Successivamente, devi installare Proot-Distro e Debian all'interno di Termux. Il pacchetto ProoT consente di eseguire distribuzioni Linux come Debian o Ubuntu all'interno di Termux.

Passaggio 3.1: Per installare Proot Distral , immettere questo comando: PKG Installa Proot -Distro -y nell'app Termux e premere Invio.

Mentre lo fa, incontrare un errore " pacchetto non trovato" significa che Termux non è stato aggiornato. Ancora una volta, esegui Apt Update && Apt Upgrade -y Comando e assicurati anche di avere una connessione Internet attiva durante l'utilizzo di questo comando.

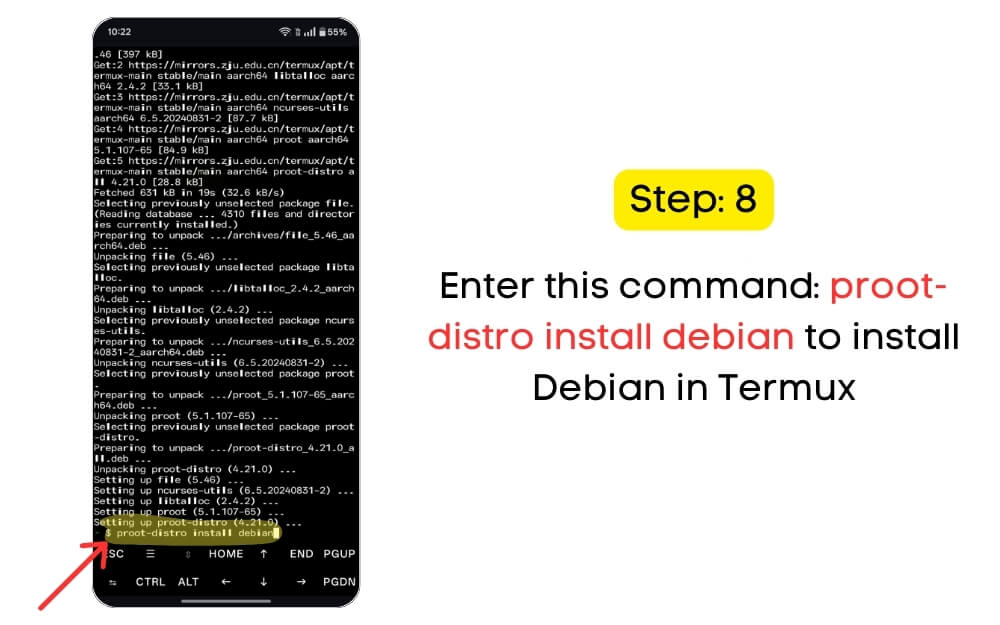

Successivamente, devi installare Debian in Termux. Debian è una distribuzione Linux gratuita e open source che è leggera e funziona sul tuo Android utilizzando Proot-Distro. È possibile installare l'ultima versione di Debian utilizzando il seguente comando di seguito. Inoltre, assicurati di avere sufficiente spazio di archiviazione sul tuo dispositivo e una connessione Internet stabile.

Passaggio 3.2: Immettere questo comando nel terminale: Proot-Distro Installa Debian

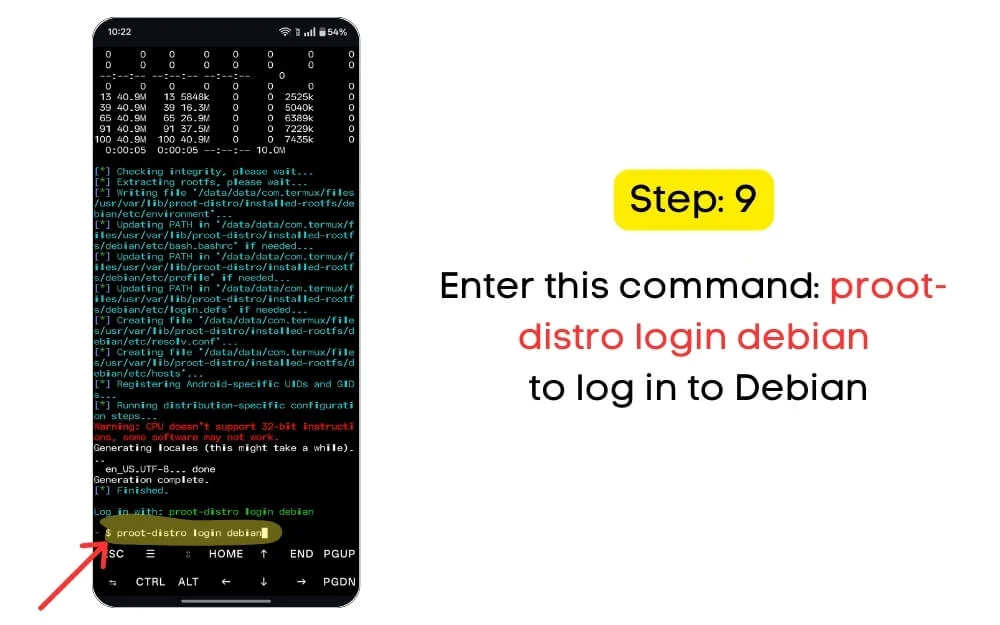

Passaggio 3.3: Successivamente, è necessario accedere a Debian usando il seguente comando: Proot-Distro Accesso Debian.

Passaggio 4. Installa TMUX & Ollama per installare e utilizzare DeepSeek R1

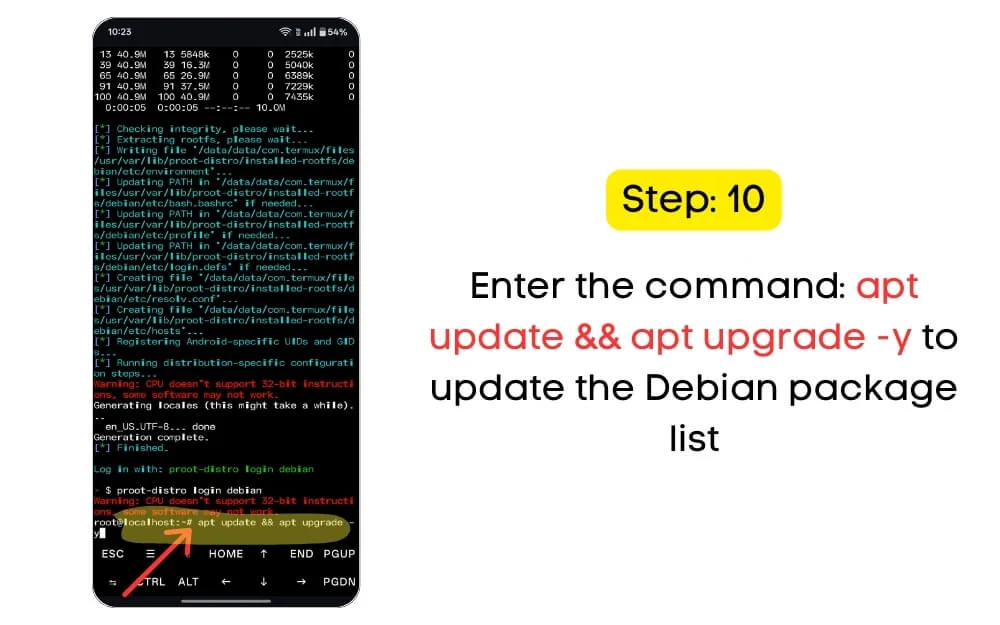

Successivamente, è necessario installare TMUX e Ollama sul tuo dispositivo per eseguire DeepSeek R1 a livello locale. Per fare ciò, devi prima aggiornare l'elenco dei pacchetti Debian. È possibile utilizzare il seguente comando per aggiornare tutti gli elenchi dei pacchetti Debian alle versioni più recenti.

Passaggio 4.1: immettere il seguente comando: Apt Update && Apt Upgrade -y per aggiornare l'elenco dei pacchetti Debian.

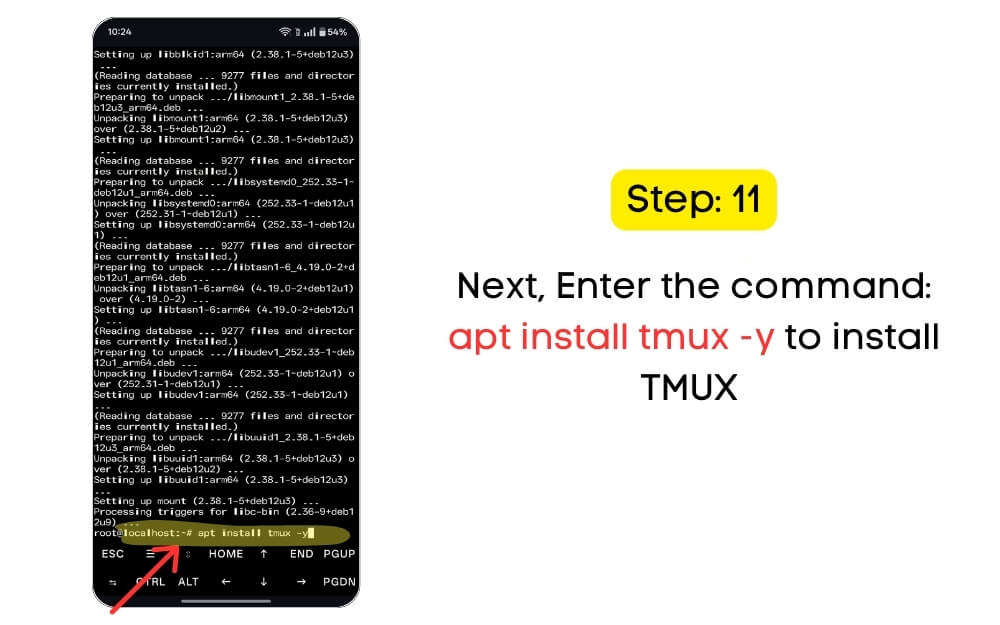

Successivamente, è necessario installare TMUX per gestire più sessioni di terminale. TMUX consente di eseguire più sessioni di terminale all'interno di una singola finestra. Il motivo principale per l'installazione di TMUX è che ti aiuta a mantenere il modello di intelligenza artificiale in esecuzione in background, anche se ti disconnetti accidentalmente. Viene inoltre fornito con altri vantaggi, come la divisione del terminale in più vetri per un migliore multitasking e eseguire più attività contemporaneamente.

Passaggio 4.2: Utilizzare il seguente comando: APT Installa tmux -y per installare TMUX

Successivamente, devi installare Ollama, uno strumento progettato per Android che ti consente di eseguire modelli AI localmente sul tuo dispositivo. Puoi eseguire DeepSeek R1 e Meta Llama localmente sul tuo dispositivo utilizzando questo strumento. Supporta anche interfacce AI offline come Chatgpt.

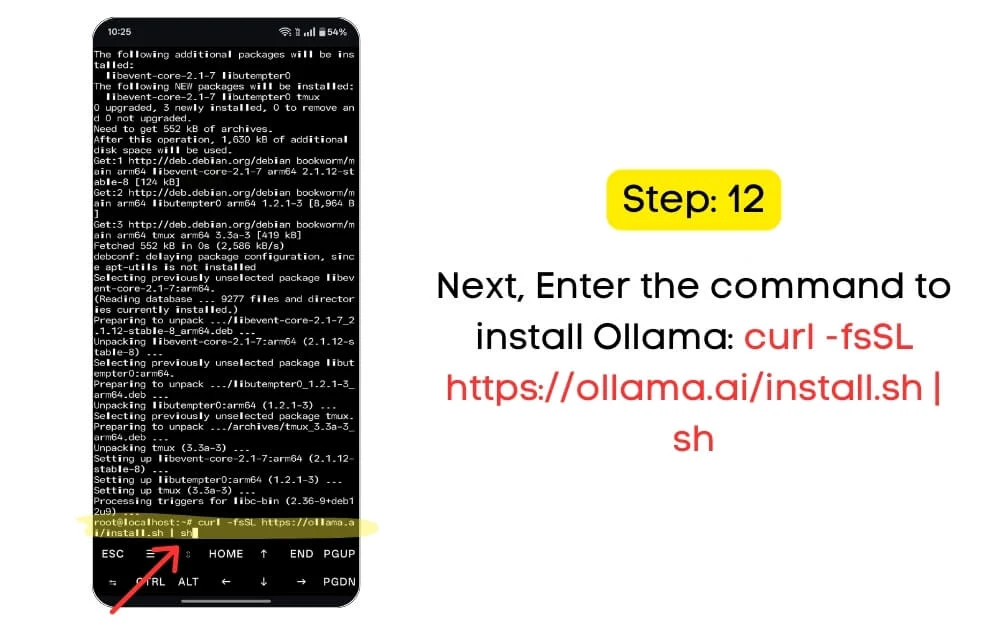

Passaggio 4.3: una volta fatto tutto questo, è necessario installare ed eseguire DeepSeek R1 localmente sul tuo dispositivo. Usa il seguente comando per installare Ollama: Curl -fssl https://ollama.ai/install.sh | sh

Passaggio 5. Installa e esegui DeepSeek R1

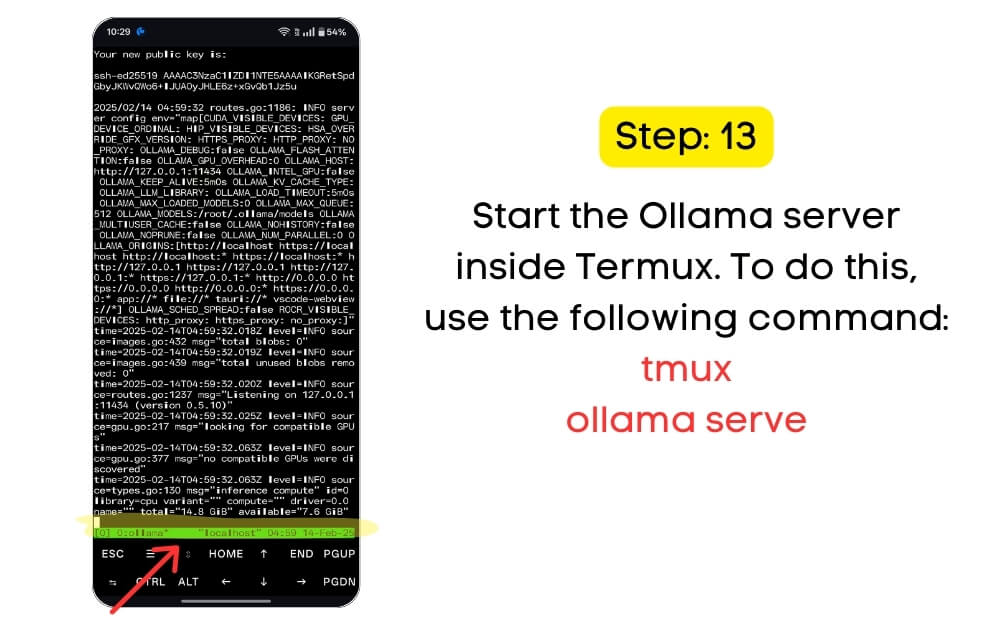

Successivamente, devi avviare il server Ollama all'interno di Termux. Per fare ciò, usa il seguente comando:

Passaggio 5.1: passaggio Server Ollama Start all'interno di TMUX: TMUX OLLAMA SERVE

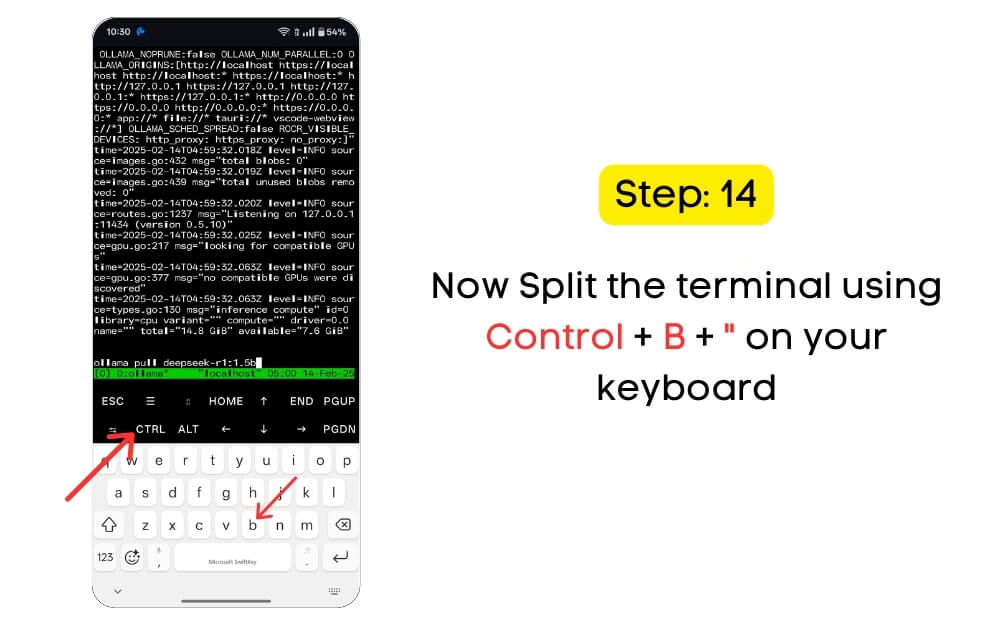

Passaggio 5.2: aprire una nuova finestra TMUX e dividere il terminale in più vetri. Ciò può essere utile quando si esegue il modello AI in un riquadro, monitora i registri o si inseriscono comandi in un altro terminale. Utilizzare il collegamento seguente per dividere i terminali: fare clic sul controllo+b+"

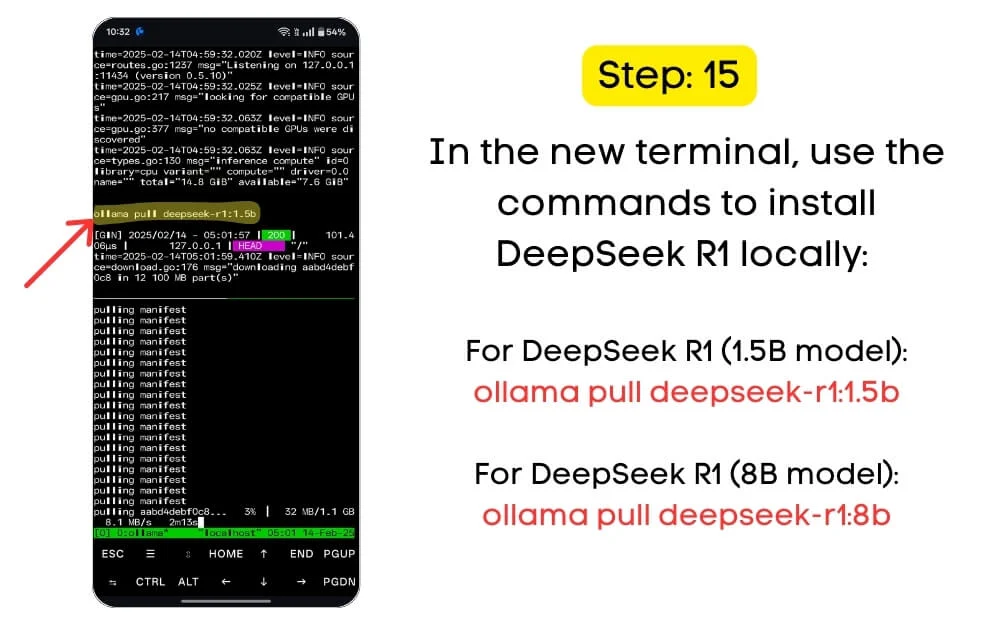

Successivamente, è necessario installare il modello DeepSeek R1 1.5B localmente sul dispositivo. Esistono diversi modelli per i modelli DeepSeek R1. Poiché Android ha risorse limitate e l'esecuzione di questi modelli a livello locale richiede molte risorse, il modello da 1,5b è il modello più affidabile per la maggior parte dei dispositivi Android. Ecco un elenco di modelli che DeepSeek R1 supporta.

Variante modello | Requisito di archiviazione | Requisiti min |

|---|---|---|

DeepSeek-R1: 1.5b | 1,1 GB | RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

DeepSeek-R1: 7b | 4.4 GB | - RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

DeepSeek-R1: 8b | 4,9 GB | RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

DeepSeek-R1: 14B | 9,0 GB | - RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

DeepSeek-R1: 32b | 22 GB | - RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

DeepSeek-R1: 70B | 43 GB | - RAM: 8 GB - Processore: Snapdragon 8 Gen 2 o equivalente - Archiviazione: spazio libero da 12 GB |

Scarica il modello locale di DeepSeek R1 1.5b del tuo dispositivo utilizzando il seguente comando. Questo scarica e lo salva sul tuo dispositivo. Assicurati che il tuo dispositivo abbia un minimo di archiviazione richiesta per ciascun modello.

Passaggio 5.3: Nel nuovo Termux Windows, utilizzare il comando per installare DeepSeek R1 (modello 1.5b): Ollama Pull DeepSeek-R1: 1.5b

È possibile installare il modello 8B utilizzando lo stesso comando se si dispone di un dispositivo di punta di fascia alta. Allo stesso modo, se si dispone di altri dispositivi di fascia alta, è possibile installare localmente il modello di parametri 15B sul dispositivo.

Per le tue informazioni, più parametri del modello, più è capace il modello. Per la maggior parte dei casi d'uso, il modello di parametri 1.5B è una scelta facile solo per le conversazioni. Tuttavia, il modello di parametri 8B è ragionevole e spesso consigliato se si desidera più conoscenze e prestazioni migliori.

Questo è tutto. Ora, hai installato con successo DeepSeek R1 sul tuo dispositivo. Ora che DeepSeek R1 è installato, è possibile utilizzare Termux per eseguirlo localmente sul dispositivo.

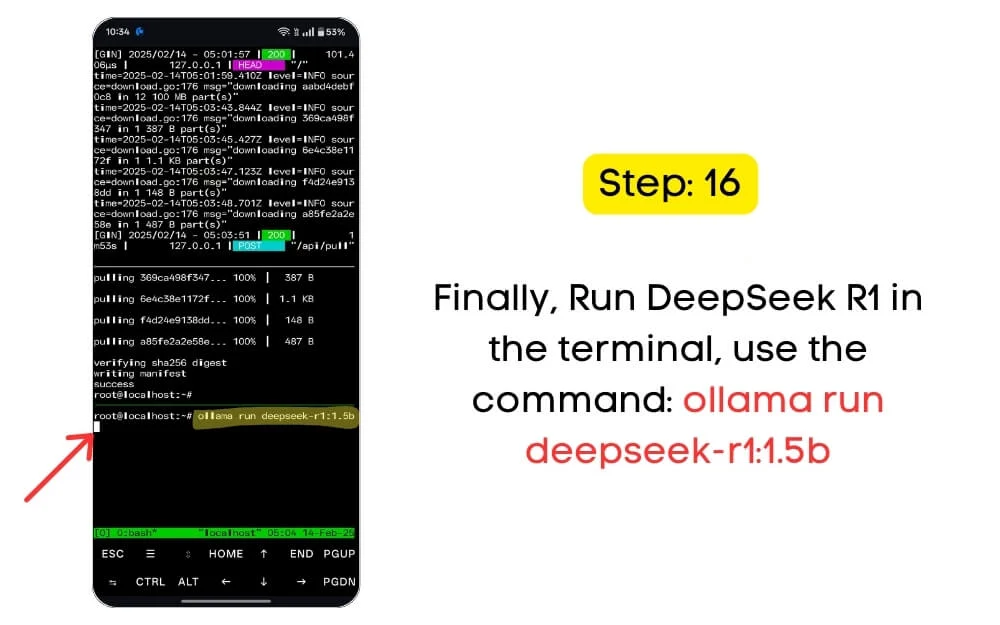

Passaggio 6. Esegui DeepSeek localmente sul tuo dispositivo

Passaggio 6.1: Per eseguire DeepSeek R1 nel terminale, utilizzare il comando: Ollama eseguire DeepSeek-R1: 1.5b.

Assicurati di utilizzare il numero di modello corretto nel comando. Se hai installato il modello 1.5B, utilizzare lo stesso nome del modello nel comando. Se hai installato il modello 8B, utilizzare il comando.

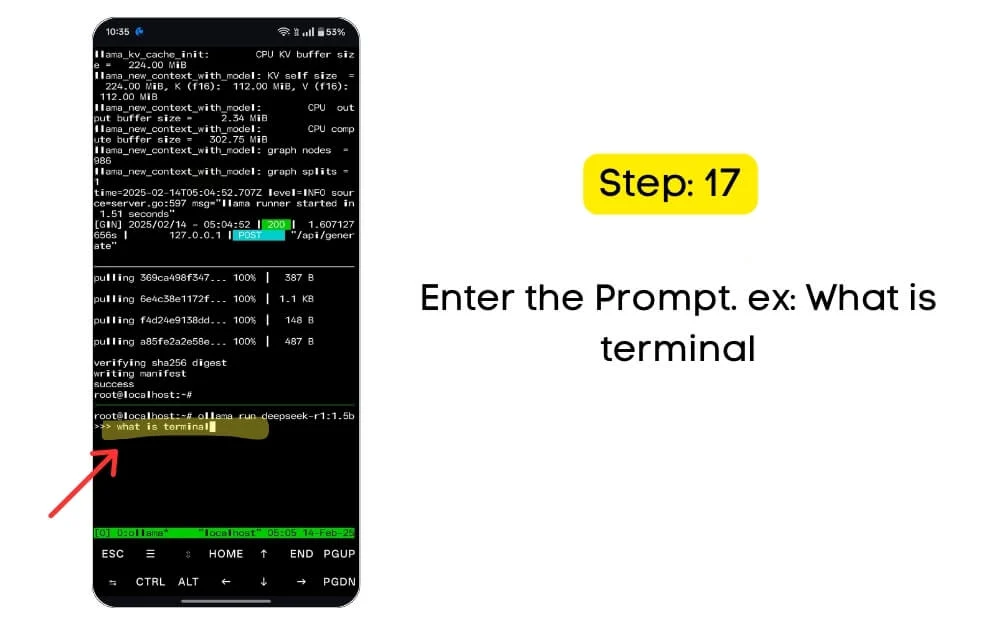

Ora puoi provare a interagire con il modello usando l'input di testo. Poiché tutto scorre attraverso il terminale, non ci sarà GUI (interfaccia utente grafica) per interagire con il chatgpt; È possibile utilizzare l'input di testo e ottenere risultati nello stesso terminale.

A seconda della potenza di archiviazione e elaborazione locale del dispositivo, il modello genererà output in base alle risorse disponibili. Ecco le scorciatoie Termux più comuni per gestire localmente le sessioni di intelligenza artificiale sul tuo dispositivo. È possibile utilizzare CTRL + C per fermare il modello AI, Ctrl + D per uscire, tornare al modello e altro ancora.

Usa DocketPal per eseguire DeepSeek R1 localmente sul dispositivo

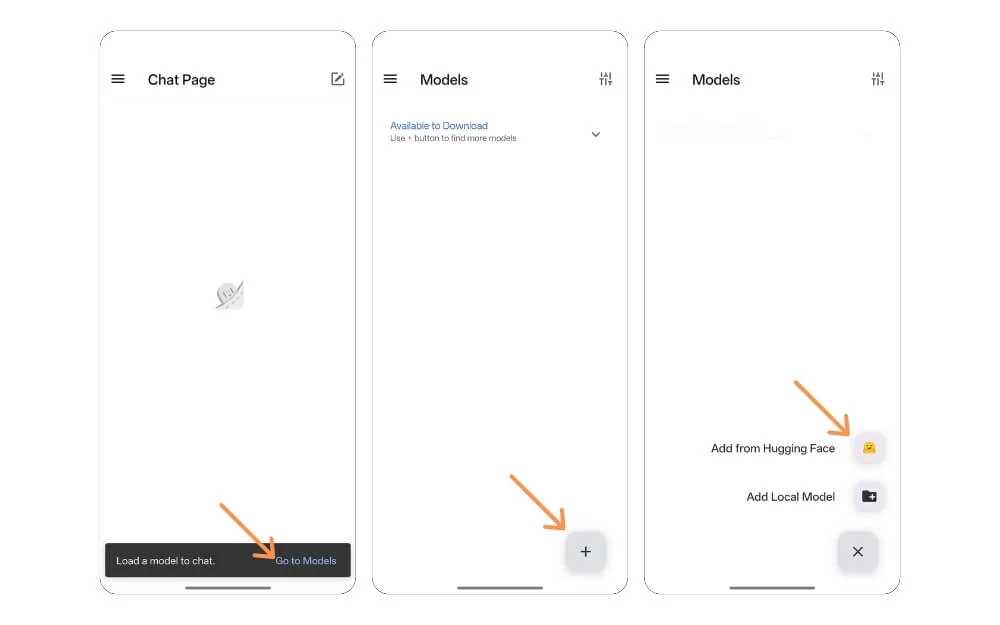

Se trovi schiacciante il metodo sopra, puoi utilizzare AI PocketPal, un'app gratuita che installa ed esegue modelli AI localmente sul tuo dispositivo. Seguire i passaggi seguenti.

Passaggio 1: installare l' app PocketPal dal Google Play Store.

Passaggio 2: apri l'app e vai ai modelli

Passaggio 3: fai clic sull'icona più e tocca Aggiungi la faccia abbracciata.

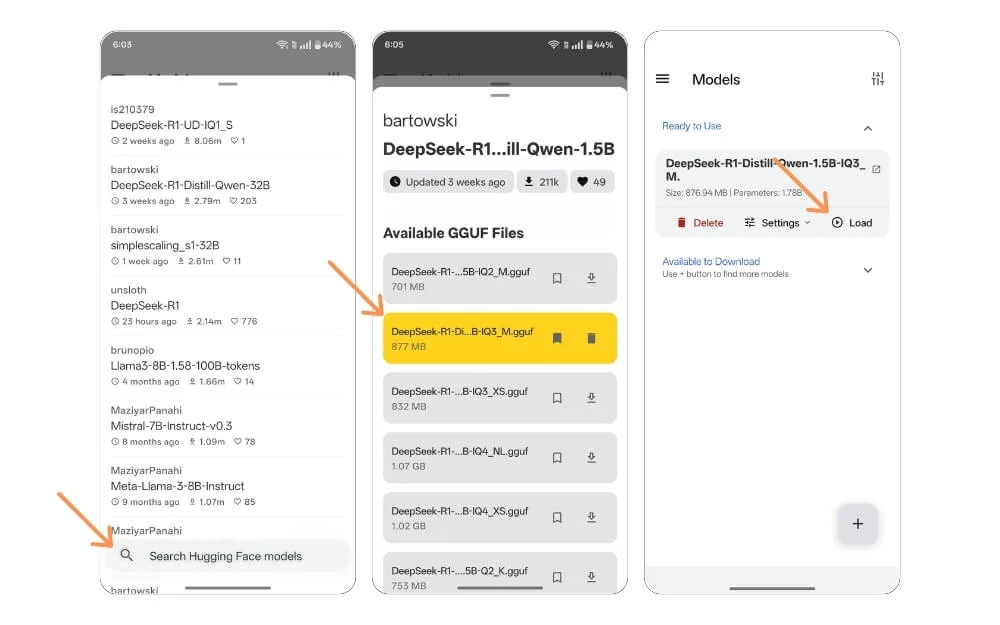

Passaggio 4: utilizzare la barra di ricerca nel pulsante e cercare i modelli DeepSeek R1.

Passaggio 5: selezionare il modello in base al limite di archiviazione del dispositivo e fare clic sull'icona di download . Aspetta il download del modello.

Passaggio 6: una volta scaricato, tornare alla schermata Home, selezionare il modello e fare clic sul carico.

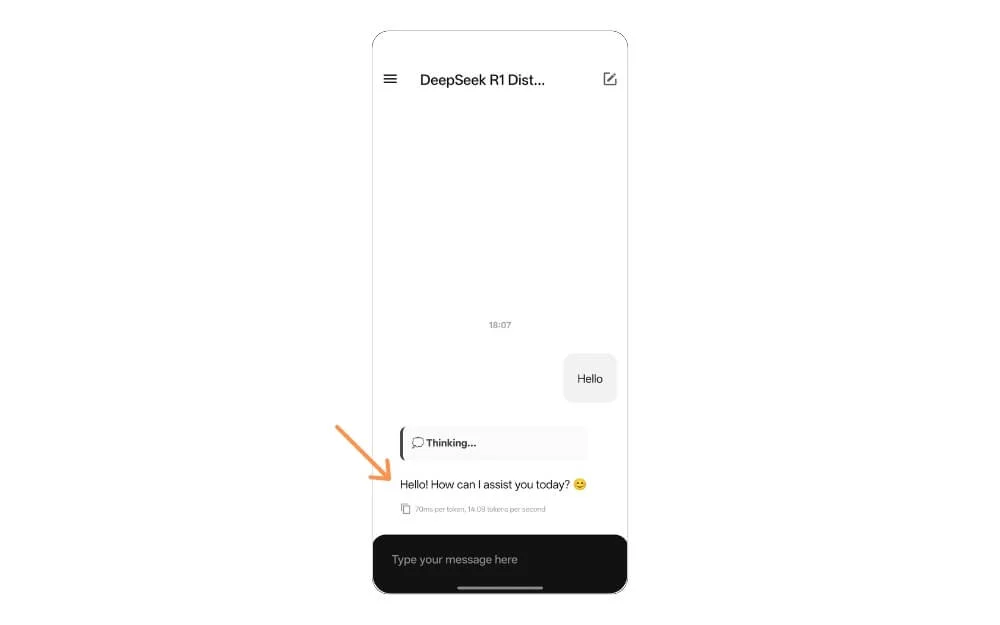

Questo caricherà DeepSeek R1 localmente sul tuo dispositivo. A differenza del metodo sopra, ti dà un'interfaccia grafica di chat per interagire con il modello. Puoi anche disattivare la connessione Internet se necessario.

Esegui il modello AI localmente sul tuo cellulare

Anche se DeepSeek è dirompente e molto vantaggioso per il consumatore, diversi rapporti affermano che DeepSeek può inviare dati alle società cinesi. Con questo modello in esecuzione sul dispositivo localmente, i dati rimangono sul dispositivo. Inoltre, se hai buone specifiche per uno smartphone di punta, DeepSeek è più veloce e non ha tempi di caricamento lenti per rispondere, il che è generalmente il caso dei modelli cloud. Tutto ciò rende DeepSeek R1 una grande risorsa per l'installazione, l'esecuzione e l'utilizzo di LLM localmente sul dispositivo.

Ho condiviso il tuo aiuto dettagliato e completo passo-passo. Se riscontri ancora problemi o errori durante l'installazione, puoi commentare di seguito e cercherò di aiutarti. Spero che tu trovi questa guida utile. Inoltre, controlla la nostra guida sull'installazione di DeepSeek localmente sul tuo Mac e Windows; Sarebbe molto utile per i tuoi compiti di lavoro professionale e studentesco.