Superare i bias nell'annotazione dei dati

Pubblicato: 2024-11-22Solo un avvertimento: se acquisti qualcosa tramite i nostri link, potremmo ottenere una piccola quota della vendita. È uno dei modi in cui manteniamo le luci accese qui. Clicca qui per ulteriori informazioni.

Nell'intelligenza artificiale, i dati annotati determinano direttamente l'accuratezza e l'equità dei modelli di machine learning. Tuttavia, i bias possono portare a risultati inaffidabili e a scarse prestazioni dei modelli di machine learning.

Immergiamoci nel cuore di questa sfida ed esploriamo strategie pratiche e attuabili per superare i pregiudizi nell'annotazione dei dati.

Comprendere i bias nell'annotazione dei dati

Innanzitutto, cos'è l'annotazione dei dati e in che modo i pregiudizi possono influenzarla?

L'annotazione dei dati è il processo di etichettatura dei dati, come immagini, testo o video, per addestrare modelli di machine learning.

I pregiudizi in questo processo si verificano quando le etichette sono influenzate da opinioni personali o influenze esterne. È una trappola comune e, se lasciata senza controllo, può compromettere l'intero scopo dell'apprendimento automatico.

Ad esempio, se un modello di analisi del sentiment viene addestrato con annotazioni che valutano costantemente le frasi di un particolare dialetto come “negative”, potrebbe funzionare male su testi scritti in quel dialetto.

Ancor peggio, potrebbe rafforzare gli stereotipi, portando a preoccupazioni etiche e a risultati errati dell’IA.

Tipi di bias nell'annotazione dei dati

I pregiudizi nell'annotazione dei dati non si manifestano in un solo modo; assumono forme diverse a seconda dell'origine dati, degli annotatori e delle istruzioni di etichettatura. Ecco alcuni colpevoli comuni:

Bias di campionamento

Ciò accade quando i dati raccolti non includono tutta la varietà e diversità della popolazione. Ad esempio, addestrare un sistema di riconoscimento facciale su volti prevalentemente dalla pelle chiara può comportare una minore precisione per le tonalità della pelle più scure.

Bias dell'annotatore

Ciò deriva dal background, dalle prospettive o dai preconcetti degli annotatori. Due annotatori che visualizzano la stessa immagine o testo possono interpretarlo in modo diverso, soprattutto se sono coinvolte differenze culturali o sociali.

Distorsione da etichettatura

Spesso radicato in istruzioni di etichettatura vaghe o soggettive, questo pregiudizio si verifica quando le linee guida spingono gli annotatori verso una particolare interpretazione.

Etichettare le immagini degli atleti come “uomini” nonostante la rappresentanza femminile, a causa delle linee guida di etichettatura guidate dagli stereotipi, è un classico esempio.

Strategie per ridurre al minimo le distorsioni nell'annotazione

Per fortuna, i pregiudizi non devono essere inevitabili. Esistono misure concrete che puoi adottare per tenere a bada i pregiudizi, assicurando che l'annotazione dei dati rimanga il più neutrale e rappresentativa possibile.

Sviluppare linee guida chiare e neutrali

Inizia creando linee guida tecniche per l'annotazione dei dati che lascino uno spazio minimo all'interpretazione soggettiva.

Immagina di annotare le recensioni dei film se "negativo" e "positivo" sono le uniche categorie, ma non viene fornita alcuna guida specifica, gli annotatori potrebbero classificare in modo errato le recensioni neutre o sarcastiche.

Offri invece descrizioni ed esempi espliciti per ciascuna etichetta, includendo anche i casi limite.

Assemblare un pool di annotatori diversificato

Pensa ai tuoi annotatori come alla lente attraverso la quale il tuo modello vedrà il mondo. Una lente ristretta porta a intuizioni ristrette, quindi è probabile che un pool omogeneo di annotatori inietti prospettive ristrette.

Incorporando un gruppo eterogeneo di annotatori provenienti da contesti diversi, è più probabile che catturi un ampio spettro di opinioni.

Fornire formazione e feedback regolari

La formazione non riguarda solo le macchine. Anche gli annotatori umani traggono vantaggio dalla ricalibrazione periodica attraverso sessioni di formazione e cicli di feedback.

Un feedback coerente e strutturato, insieme alle revisioni delle annotazioni dei dati da diverse prospettive, possono aiutarli a riconoscere i pregiudizi involontari nel loro lavoro.

Inoltre, lo svolgimento di seminari sulla consapevolezza dei pregiudizi insegna agli annotatori a individuare le proprie inclinazioni e a prendere decisioni imparziali.

Proprio come un linguaggio che diventa più sfumato con la pratica, le capacità di etichettatura degli annotatori possono diventare più acute e obiettive con una guida adeguata.

Utilizzare meccanismi di annotazione incrociata e di consenso

Diciamolo chiaro: nessuno è perfetto. Anche l’annotatore più diligente a volte può mancare il bersaglio. È qui che l'annotazione incrociata torna utile.

Facendo lavorare più annotatori sugli stessi punti dati, puoi identificare le discrepanze e raggiungere un consenso sui casi ambigui.

Ciò non solo bilancia i pregiudizi individuali, ma fornisce anche un set di etichette più affidabile.

Questo approccio è particolarmente utile per le categorie soggettive, come il rilevamento delle emozioni, in cui le opinioni personali spesso penetrano nelle annotazioni.

Sfruttare la tecnologia per combattere i pregiudizi

Il solo sforzo umano potrebbe non riuscire a cogliere tutti i casi di pregiudizio, soprattutto nei progetti di annotazione su larga scala. È qui che la tecnologia e l'esperienza di un'azienda di annotazione dati possono aiutarti a individuare e affrontare i pregiudizi che potrebbero sfuggire alla supervisione umana.

Strumenti automatizzati di controllo qualità

Gli strumenti automatizzati di controllo qualità sono come gli ispettori della qualità della linea di annotazione. Questi strumenti esaminano i dati etichettati per individuare eventuali incongruenze, segnalando modelli che potrebbero indicare errori.

Rilevamento delle anomalie basato sull'intelligenza artificiale

Le tecniche di rilevamento delle anomalie offrono un ulteriore livello di protezione. Questi algoritmi rilevano valori anomali nei dati annotati, segnalando i punti dati che si discostano in modo significativo dalla norma.

Esaminando i casi segnalati, puoi individuare modelli di etichettatura insoliti che potrebbero indicare pregiudizi, come l'etichettatura eccessiva di determinati sentimenti nei testi provenienti da particolari dati demografici.

Quadri di controllo dei pregiudizi

Diversi framework sono progettati specificamente per verificare la presenza di potenziali errori nei set di dati. Gli strumenti di controllo dei bias analizzano i dati per individuare classi sovrarappresentate o sottorappresentate, aiutandoti a raggiungere una distribuzione equilibrata.

Consideralo come un riflettore che punta sulle aree in cui i tuoi dati potrebbero non essere uniformi. L'esecuzione periodica di questi audit mantiene sotto controllo il set di dati e lo allinea agli obiettivi etici dell'IA.

Riepilogo delle migliori pratiche

Il superamento dei pregiudizi nell’annotazione degli esperti è un processo continuo. Di seguito sono riportate alcune best practice che puoi rivisitare per mantenere un elevato standard di obiettività nei tuoi dati:

- Linee guida chiare : istruzioni precise e ben definite con esempi aiutano a eliminare le ambiguità.

- Annotatori diversi : assicurati che il tuo team di annotatori sia il più rappresentativo possibile per catturare prospettive diverse.

- Annotazione incrociata : impiega più annotatori su casi ambigui per bilanciare la soggettività.

- Cicli di feedback : la formazione continua e il feedback affinano la comprensione degli annotatori e riducono i pregiudizi nel tempo.

- Ausili tecnologici : gli strumenti di controllo della qualità, il rilevamento delle anomalie e i sistemi di controllo dei bias funzionano tutti per mantenere i dati imparziali.

| Strategia | Obiettivo | Caso d'uso di esempio |

| Linee guida chiare | Ridurre al minimo l'interpretazione soggettiva | Regole dettagliate per l'etichettatura del sentiment |

| Annotatori diversi | Cattura prospettive ampie | Team multiculturale per progetti di PNL |

| Annotazione incrociata | Bilanciare i pregiudizi individuali | Consenso sui casi ambigui nel rilevamento delle emozioni |

| Cicli di feedback | Ridurre i pregiudizi attraverso il miglioramento continuo | Workshop per riconoscere i bias impliciti |

| Ausili tecnologici | Rileva modelli di bias in set di dati di grandi dimensioni | Strumenti automatizzati di controllo qualità e rilevamento anomalie |

Considerazioni finali

I pregiudizi nell'annotazione dei dati rappresentano una sfida, ma possono essere affrontati con un'attenta pianificazione e gli strumenti giusti. Costruendo una solida struttura di prospettive diverse, linee guida chiare e tecnologie avanzate, stai impostando il tuo modello di machine learning su basi solide e obiettive.

Ogni sforzo conta e, man mano che perfezioni il tuo approccio all'annotazione, non solo migliori l'accuratezza del modello, ma contribuisci anche all'obiettivo più ampio di un'intelligenza artificiale etica e imparziale.

Dopotutto, il successo del tuo sistema di intelligenza artificiale è affidabile quanto lo sono i dati da cui apprende, quindi rendi tali dati il più equi ed equilibrati possibile.

Hai qualche idea su questo? Mandaci una riga qui sotto nei commenti o porta la discussione sul nostro Twitter o Facebook.

Raccomandazioni degli editori:

Black Friday: rilevatore di perdite d'acqua GoveeLife (confezione da 3) con uno sconto del 45%.

Dai dati agli insight: automatizzare la raccolta dati online su larga scala

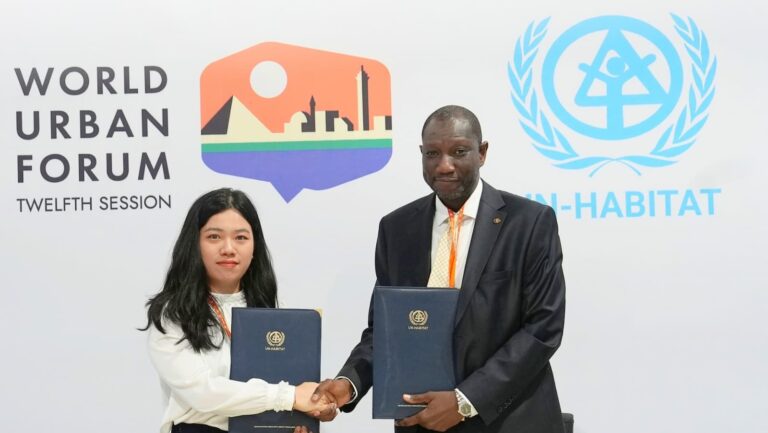

Bluetti e UN-Habitat collaborano per promuovere l’energia pulita in Africa

Divulgazione: questo è un post sponsorizzato. Tuttavia, le nostre opinioni, recensioni e altri contenuti editoriali non sono influenzati dalla sponsorizzazione e rimangono obiettivi .