Dai dati agli insight: automatizzare la raccolta dati online su larga scala

Pubblicato: 2024-11-18Solo un avvertimento: se acquisti qualcosa tramite i nostri link, potremmo ottenere una piccola quota della vendita. È uno dei modi in cui manteniamo le luci accese qui. Clicca qui per ulteriori informazioni.

Per sovraperformare i tuoi concorrenti, devi sapere come si comportano.

Per fornire prodotti e servizi che il tuo pubblico target utilizzerà, devi sapere cosa sta cercando. Per prevedere le tendenze del mercato, è necessario conoscere le attuali condizioni di mercato.

Qualunque siano i tuoi scopi e obiettivi, se vuoi che la tua azienda prosperi, devi accedere a dati di alta qualità, tempestivi e pertinenti.

Dopotutto, è solo con dati accurati che puoi generare insight che ti aiutino a prendere decisioni migliori basate sui dati.

Sebbene la qualità dei dati sia fondamentale, la quantità non dovrebbe essere trascurata. Fortunatamente, puoi automatizzare la raccolta dati su larga scala e usufruire di entrambi i vantaggi con strumenti come l'API Scraper. Scopri di più di seguito.

L’importanza della raccolta dati per le imprese

La raccolta dei dati è essenziale per le aziende di tutte le dimensioni poiché consente di accelerare l'espansione aziendale e migliorare i processi decisionali.

Offre una serie di vantaggi che possono aiutarti a rendere la tua attività a prova di futuro:

- Migliora la generazione di lead;

- Migliora la fidelizzazione dei clienti;

- Minimizza i rischi;

- Prevede la domanda;

- Migliora la comprensione dei comportamenti dei clienti;

- Prevede l'attività della concorrenza;

- Migliora le strategie di marketing;

- Sblocca opportunità di crescita.

Senza dati rilevanti, qualsiasi decisione che prenderai si baserà semplicemente sul tuo istinto, esponendoti a rischi inutili e aumentando le tue possibilità di fallimento.

Attraverso una raccolta dati completa e un'analisi approfondita, puoi trarre informazioni preziose per migliorare le tue prestazioni e garantire il tuo successo.

Utilizzo del web scraping per semplificare i processi di raccolta dati

Sebbene esistano innumerevoli metodi di raccolta dati, tra cui interviste e focus group, sondaggi e moduli, l'estrazione dei dati online ti dà accesso ai maggiori volumi di dati.

L'estrazione dei dati online è il processo di visita di tutti i siti Web rilevanti nel tuo settore e di raccolta di tutti i dati di cui la tua azienda ha bisogno.

Potresti raccogliere statistiche approfondite da siti Web di alta autorità nella tua nicchia, recensioni degli utenti da siti Web di terze parti, informazioni sui prezzi da siti Web della concorrenza e altro ancora.

Nei prossimi anni, si prevede che la creazione globale di dati aumenterà fino a superare i 180 zettabyte, dandoti accesso a molte fonti e abbondanti volumi di dati.

L'unico problema è che raccogliere manualmente tutti i dati necessari potrebbe essere un boccone più grande di quanto tu possa masticare.

Per la raccolta dati online su larga scala, dovrai automatizzare i tuoi processi e, fortunatamente, puoi farlo facilmente tramite il web scraping.

Il web scraping prevede l'uso di robot scraper per l'estrazione dei dati.

Tutto quello che dovrai fare è programmare questi bot affinché eseguano la scansione di qualsiasi pagina web di cui hai bisogno, specificare il tipo di dati che desideri che estraggano e impostare il formato di estrazione preferito. Da lì si occupano di tutto il resto.

I web scraper possono eseguire la scansione di centinaia di pagine Web praticamente in pochissimo tempo, offrendo la massima velocità ed efficienza.

Eliminano i rischi di errore umano, riducono al minimo le spese e forniscono risultati accurati e di alta qualità non appena ne hai bisogno.

I due migliori strumenti di web scraping

Quando scegli i web scraper per la raccolta e l'estrazione dei dati, avrai diverse opzioni, in particolare i tradizionali web scraper, come l'API Scraper o i web scraper senza codice.

Entrambi hanno pro e contro unici che possono aiutarti a determinare la soluzione migliore.

I web scraper tradizionali richiedono competenze di codifica, poiché dovrai interagire con loro attraverso un linguaggio programmatico.

Tuttavia, la loro velocità, efficienza, capacità di gestire la tecnologia anti-bot, le pagine Web dinamiche, la personalizzazione e altro ancora li distinguono dagli scraper senza codice.

Professionisti dei web scraper tradizionali:

- Flessibile;

- Efficiente;

- Personalizzabile.

Contro del web scraper tradizionale:

- Richiedere capacità di codifica;

A causa dell'ampia codifica richiesta, i tradizionali web scraper sono più adatti alle aziende che richiedono scraping su larga scala.

Sono strumenti potenti ma richiederanno investimenti di tempo più significativi.

La buona notizia è che possono essere facilmente integrati nella tua infrastruttura esistente e sono perfettamente personalizzabili per soddisfare le tue esigenze specifiche.

I raschiatori senza codice sono generalmente molto più semplici da usare.

Come suggerisce il nome, non richiedono competenze di codifica da parte tua. Sono completamente automatizzati fin dall'inizio e puoi iniziare immediatamente a utilizzarli.

Professionisti del raschietto senza codice:

- Completamente automatizzato;

- Non richiede competenze di codifica;

- Nessuna manutenzione.

Contro raschietto senza codice:

- Non personalizzabile;

Grazie alla loro facilità d'uso, gli scraper senza codice sono generalmente più adatti a privati e piccole imprese senza esigenze estese di raccolta dati.

Sebbene possano essere efficienti su scala ridotta, possono diventare limitanti man mano che le esigenze di dati crescono.

Come e quando utilizzare questi raschiatori web

A seconda delle esigenze, gli scraper tradizionali e senza codice possono essere preziosi poiché tendono ad avere casi d'uso diversi.

I web scraper tradizionali come l'API Scraper sono più comunemente utilizzati per:

- Ricerca sul pubblico;

- Ricerche di mercato;

- Analisi della concorrenza.

D'altra parte, i web scraper senza codice sono più comunemente utilizzati per:

- Confronti di prezzi;

- Revisione del monitoraggio;

- Gestione della reputazione.

Come regola generale, sarà meglio utilizzare i raschiatori tradizionali per gestire grandi volumi di dati quantitativi e qualitativi. Gli scraper senza codice possono essere utili per volumi più piccoli di dati quantitativi.

Conclusione

Automatizzare la raccolta dati su larga scala è fondamentale per rimanere al passo con le tendenze del mercato, familiarizzare con il pubblico target e sovraperformare la concorrenza.

Puoi generare informazioni preziose che possono far avanzare la tua attività solo con dati accurati e tempestivi.

Hai qualche idea su questo? Mandaci una riga qui sotto nei commenti o porta la discussione sul nostro Twitter o Facebook.

Raccomandazioni degli editori:

Bluetti e UN-Habitat collaborano per promuovere l’energia pulita in Africa

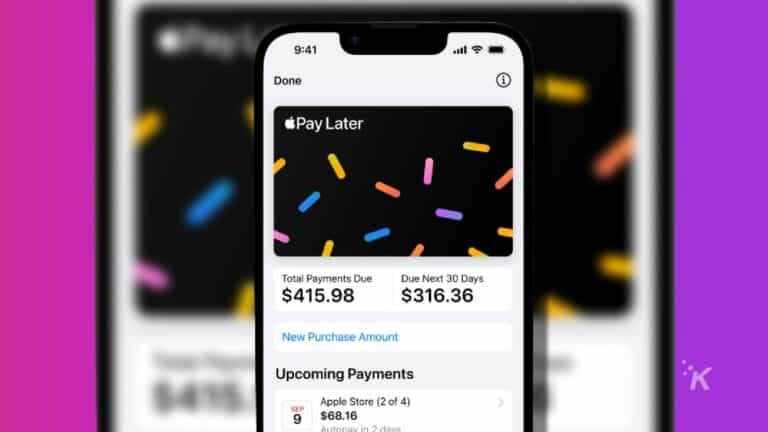

Perché utilizzare le app Acquista ora, paga più tardi nel 2024?

Sblocca la potentissima centrale elettrica Elite 200 V2 durante i saldi del Black Friday di BLUETTI

Divulgazione: questo è un post sponsorizzato. Tuttavia, le nostre opinioni, recensioni e altri contenuti editoriali non sono influenzati dalla sponsorizzazione e rimangono obiettivi .