AndroidでDeepseek AIをローカルに実行する方法:ステップバイステップガイド

公開: 2025-02-14発売以来、ChatGptはすぐにトップモデルの1つになりました。 GoogleはGeminiモデルに追いついており、2025年のほぼすべての企業がAIをアプリに統合し、その周りにサービスを構築しました。

これにも費用がかかります。 Openaiは、ChatGpt開発に数十億ドルを注ぎ込んでいます。ただし、ChatGpt Top Reasoningモデルの能力とほぼ一致するDeepSeekモデルを備えた中国のAI企業の1つは、明らかにコストの一部で開発されているようです。

これにより、米国市場に衝突し、AIチャットボットとLLMSの開発を再考しました。 Deepseekは非常に破壊的であるため、デバイスで地元で質問に答える前に、思考機能で知られているLLM Reasoningモデルを実行できます。 WindowsとMacで局所的にDeepseekを実行する方法に関する詳細なガイドがすでにあります。このガイドでは、AndroidスマートフォンにDeepSeek R1モデルのインストールと実行を検討します。

目次

デバイスにローカルにDeepSeekをインストールおよび実行するための最小デバイス要件

LLMは機能するためにリソースを必要とするため、デバイスにDeepSeek R1をローカルにインストールして使用するための最小システム要件が設定されています。これらは、より小さな1.5Bモデルのシステム要件であることを忘れないでください。 7,8,32B、700億モデルには、システム要件が高くなる必要があります。

| 仕様 | 最小仕様 |

| ラム | 8GB以上 |

| プロセッサ | Snapdragon 8 Gen 2または同等 |

| ストレージ | 少なくとも12GBの空きスペース |

| OS | Android 12以降 |

それを念頭に置いて、システム要件を備えたAndroidフラッグシップスマートフォンが必要な場合は、ステップバイステップガイドにアクセスして、デバイスにDeepSeek AIをインストールして実行します。

デバイスでローカルにDeepSeekを実行するための段階的なガイド

いくつかの方法で、デバイスにAIをローカルにインストールして実行できます。この投稿では、Termunを使用してローカルAIモデルをローカルでインストールおよび実行する方法を学びます。ただし、これには端末を操作する必要があります。簡単な方法が必要な場合は、PocketPal AIアプリを使用できます。 2番目の方法を参照してください。

ステップ1:Termuxをインストールします

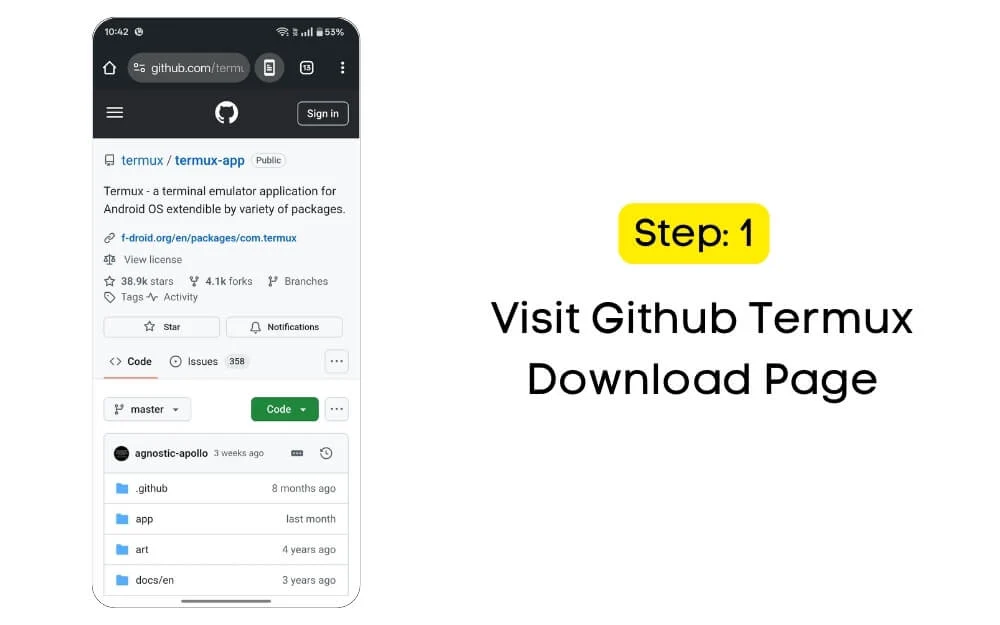

ステップ1.1:公式GithubページからTermuxアプリをダウンロードします。

Termuxは、AndroidなどのモバイルデバイスにコマンドラインをもたらすターミナルエミュレーターAndroidアプリです。コマンドラインプログラムを実行し、Linuxパッケージをインストールし、シェルコマンドを実行し、デバイスにPythonやSSHなどのツールをインストールできるようにします。最も重要なことは、多くのアプリとは異なり、ルートアクセスを必要としないことです。つまり、誰でもデバイスをルート化したり、デバイスを操作したりせずにこのアプリをインストールして、ビジネスで安全で使いやすくすることができます。

このアプリは、Play Storeから削除された後、Google Playストアやアプリストアでは利用できません。ただし、GitHubのようなサードパーティのソースやWebサイトから簡単にインストールできます。また、Termuxの公式および安全なリンクに関する詳細なガイドもあります。ガイドにアクセスして、最新のAPKをインストールできます。

このガイドでは、githubページからtermuxをインストールできます。

ステップ1.2: GitHub Termuxのダウンロードページにアクセスしてください

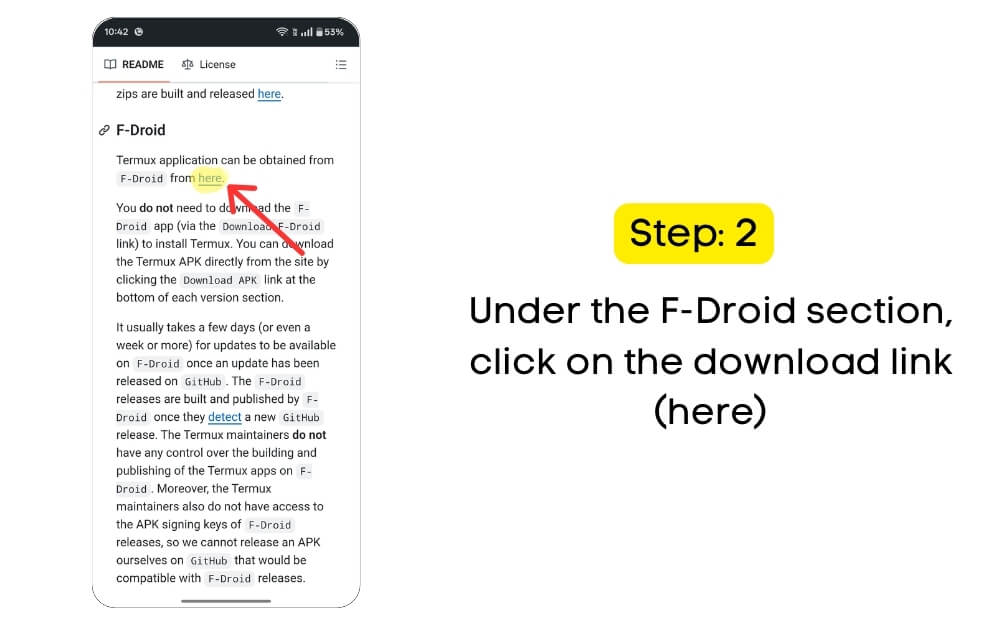

ステップ1.3:下にスクロールし、 F-driodセクションの下で、ダウンロードリンク(こちら)をクリックするか、この直接ダウンロードリンクを使用してF-Dropページにアクセスできます。

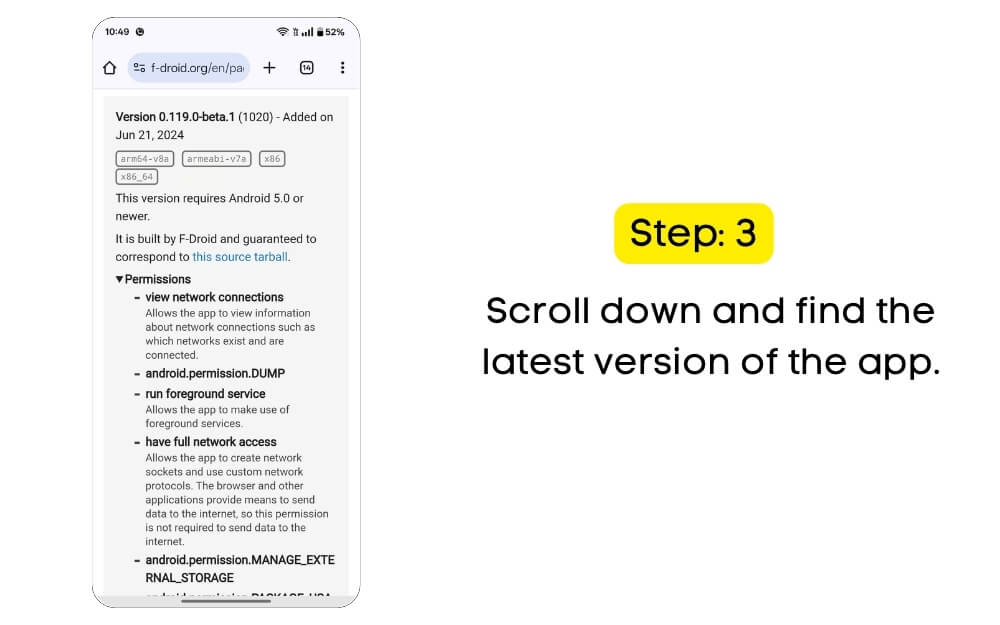

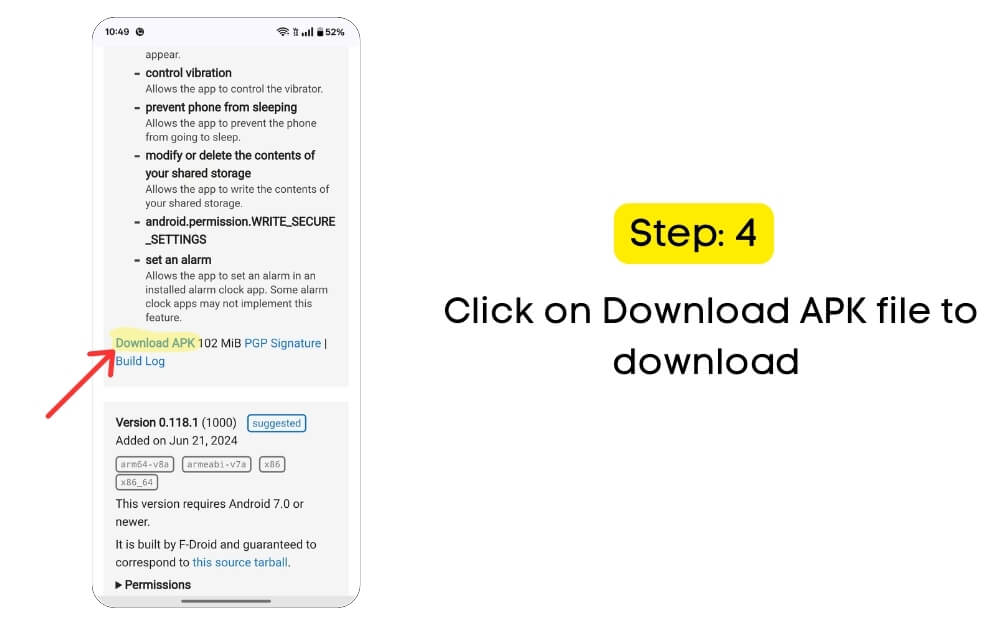

ステップ1.4:下にスクロールしてアプリの最新バージョンを見つけます(この記事を書いている時点で、最新バージョンは0.119.0-Beta.1(1020)です。私にとってはうまくいきました。問題が発生している場合は、ダウンロードできます。安定したバージョンは、バージョン0.118.1(1000)バージョンを下げてインストールします。

ステップ1.5:ダウンロードするAPKファイルをクリックしてダウンロードします。

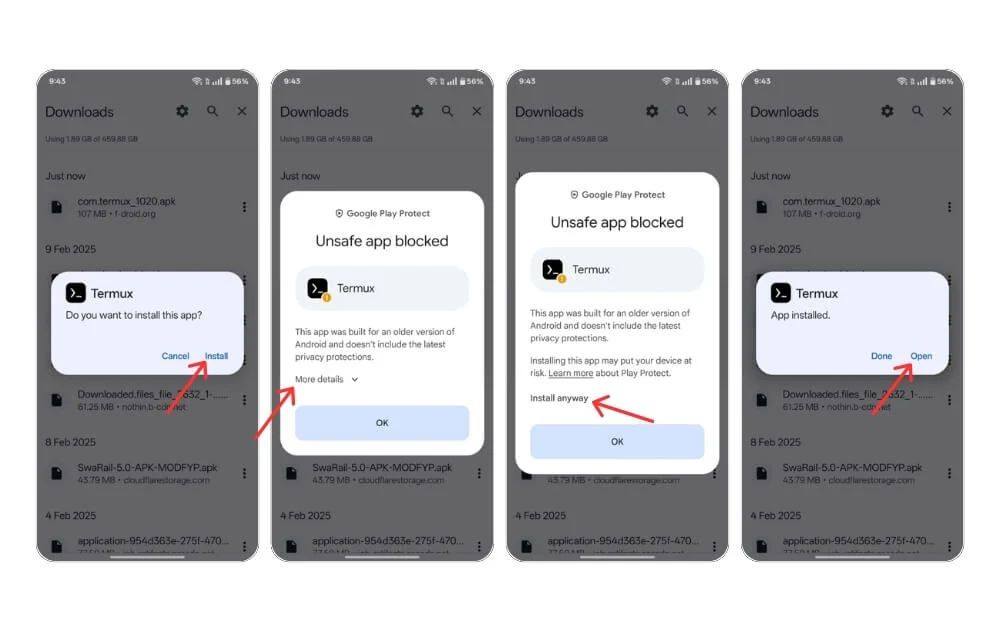

ステップ1.6 :ダウンロードしたファイルに移動し、インストールをクリックします。許可が必要な場合は、Android設定で「不明なソースからインストール」を有効にします。デバイスにTermuxをインストールして開きます。

ステップ1.7:セキュリティプロンプトがある場合は、より多くのオプションをクリックして、とにかくインストールオプションをタップすると、アプリがデバイスに正常にインストールされます。

ステップ1.7:セキュリティプロンプトがある場合は、より多くのオプションをクリックして、とにかくインストールオプションをタップすると、アプリがデバイスに正常にインストールされます。

ステップ2:次に、Termuxを設定しましょう

そこに着いたら、デバイスで実行するためにTermuxを設定する必要があります。

これを行うには、アプリを開き、ストレージの許可を付与します。デフォルトでは、Termuxにはアプリをインストールした後、電話ファイルにアクセスする許可がありません。このコマンドを使用して、Androidファイルにアクセスし、データを読み取り、保存し、ファイル管理コマンドを使用する許可を付与できます。

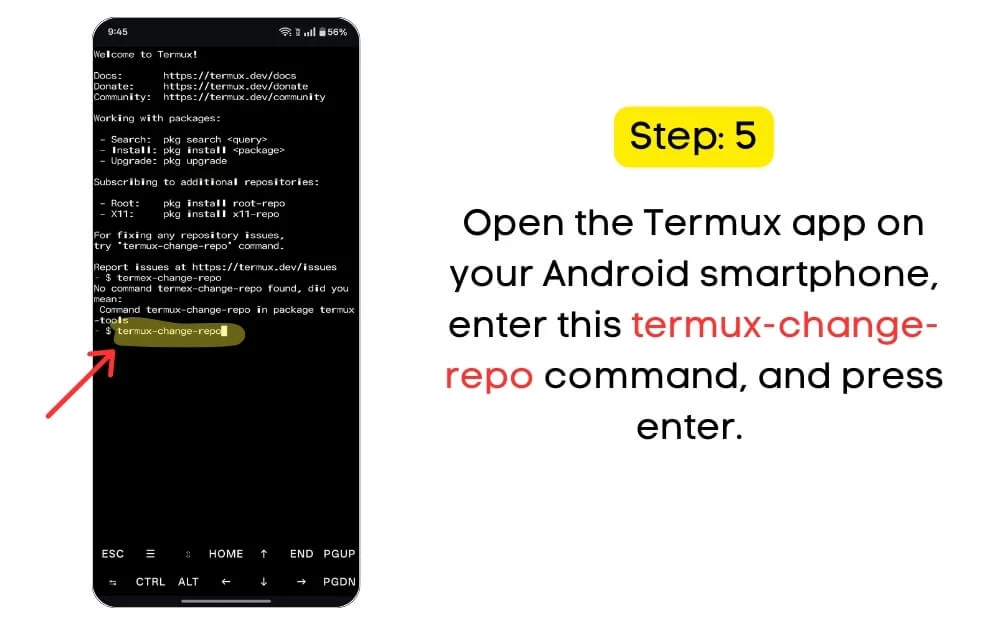

ステップ2.1: AndroidスマートフォンでTermuxアプリを開き、このコマンドを入力してEnterを押します。 Termux-change-repo

ただし、これを行うと、Androidが許可を与えているときに発生する「許可を拒否された」エラーなどの一般的なエラーが発生する可能性があります。 [設定]> [アプリの許可]に移動して、これを修正し、ストレージ権限を手動で有効にします。

ユーザーが直面する別の一般的なエラーは、「そのようなファイルまたはディレクトリ」エラーです。つまり、ストレージは初期化されていません。この場合、 Termuxアプリを閉じ、再び開き、強制停止し、コマンドを実行した後に再開します。

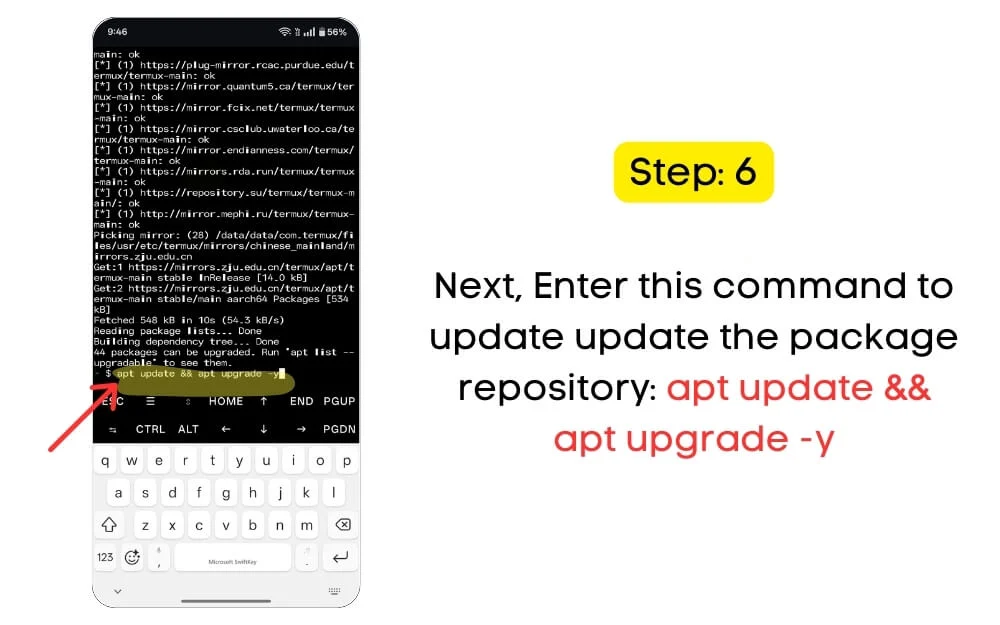

ステップ2.2:次に、パッケージリポジトリを更新する必要があります。以下のコマンドを使用して、パッケージリポジトリを更新できます。 Termuxアプリで、このコマンドを入力してください: apt update && apt upgrade -y

Termuxリポジトリを更新して、すべてのパッケージを更新する必要があります。これは、最新のセキュリティパッチを取得し、互換性の問題を防ぐのに役立ちます。ただし、これを行うときは、サーバーから最新のパッケージを取得し、Termuxアプリにインストールするためのアクティブなインターネット接続があることを確認してください。

ステップ3。次に、Proet Distro&Debian 12をインストールします

次に、Termux内にPROOT-DISTROとDEBIANをインストールする必要があります。 PROOTパッケージを使用すると、Termux内のDebianやUbuntuなどのLinuxディストリビューションを実行できます。

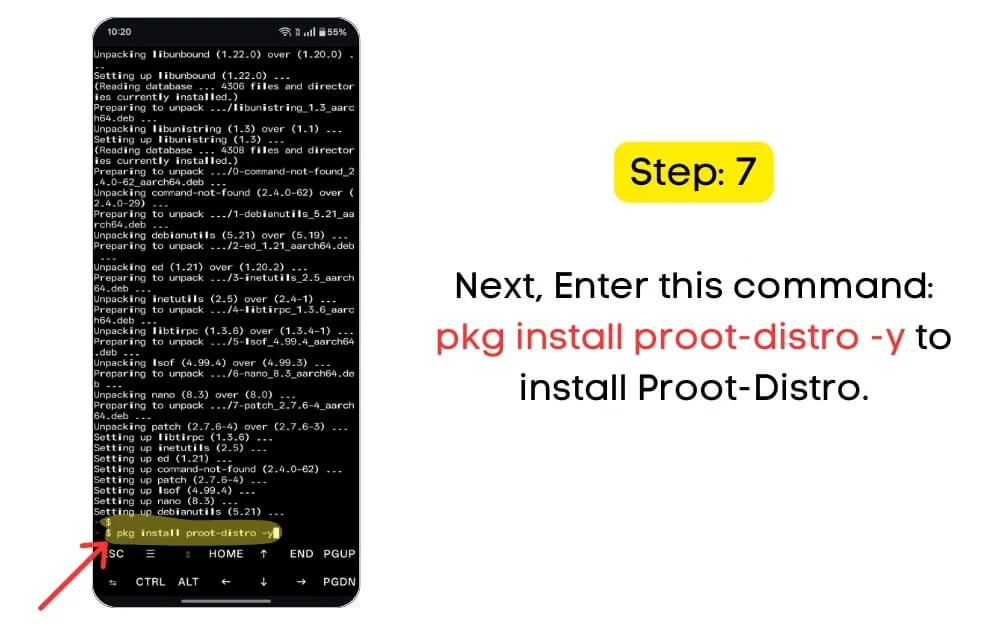

ステップ3.1: PROOTディストリビューションをインストールするには、このコマンドを入力してください。PKGTermuxアプリにPROOT -DISTRO -Yをインストールし、Enterを押します。

これを行っている間、「パッケージが見つからない」エラーに遭遇すると、Termuxが更新されていません。繰り返しますが、 apt update && apt upgrade -yコマンドを実行し、このコマンドを使用している間にアクティブなインターネット接続があることを確認します。

次に、TermuxにDebianをインストールする必要があります。 Debianは無料でオープンソースのLinuxディストリビューションで、軽量で、Proet-Distroを使用してAndroidで実行されます。以下の次のコマンドを使用して、Debianの最新バージョンをインストールできます。また、デバイスに十分なストレージと安定したインターネット接続があることを確認してください。

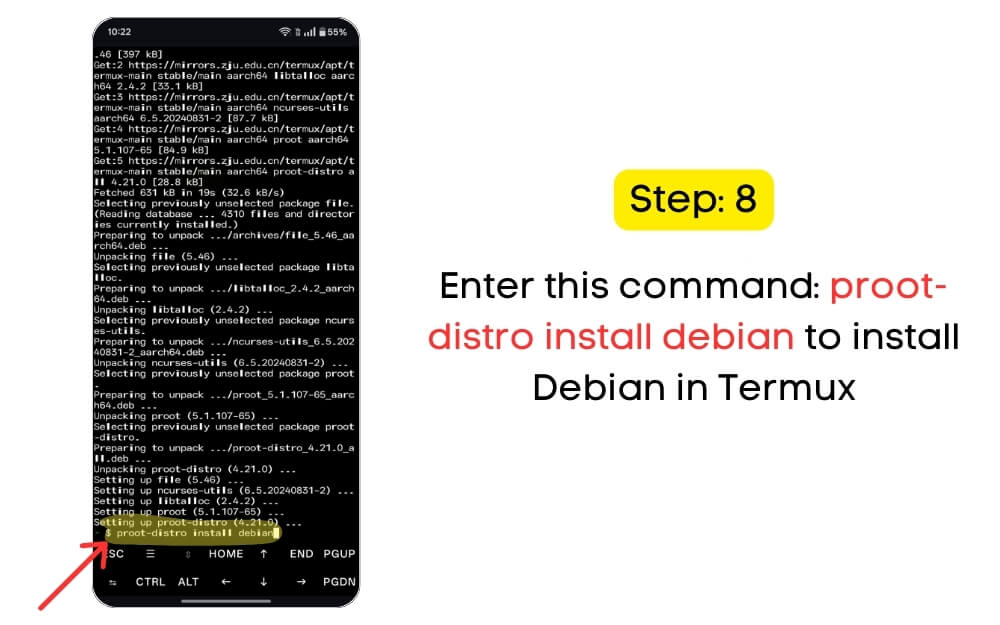

ステップ3.2:ターミナルにこのコマンドを入力します: PROOT-DISTROインストールDebian

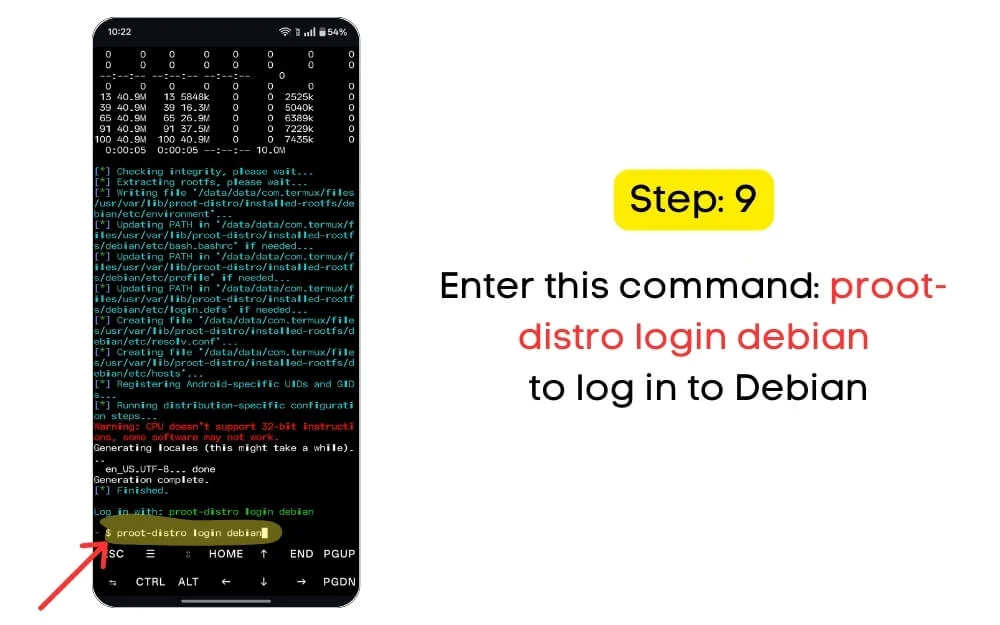

ステップ3.3:次に、次のコマンドを使用してDebianにログインする必要があります。Proet -Distro Login Debian。

ステップ4。TMUX&Ollamaをインストールして、Deepseek R1をインストールして使用します

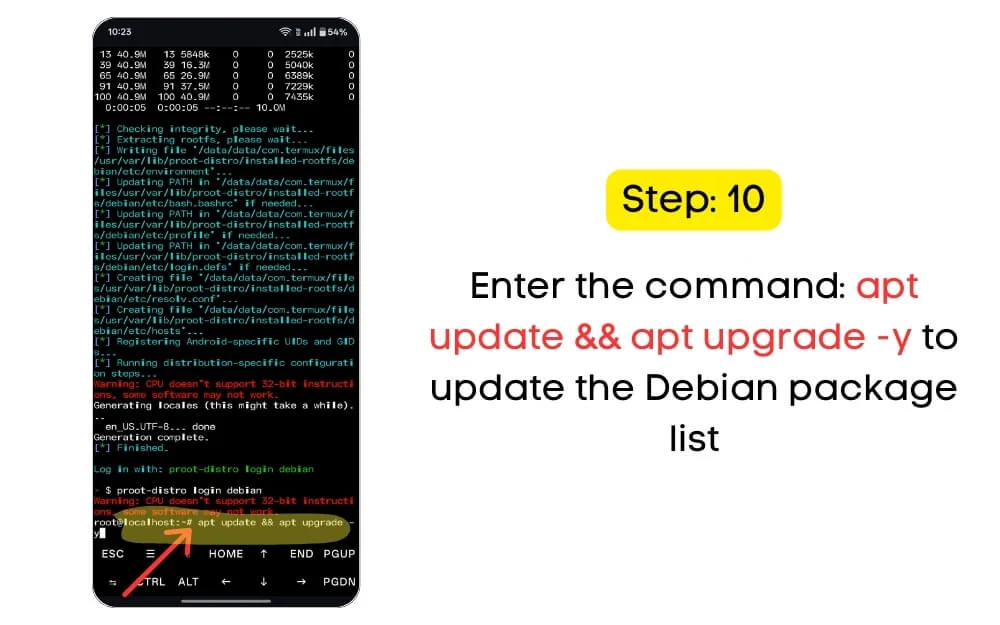

次に、DeepSeek R1をローカルに実行するには、デバイスにTMuxとOllamaをインストールする必要があります。これを行うには、最初にDebianパッケージリストを更新する必要があります。次のコマンドを使用して、すべてのDebianパッケージリストを最新バージョンに更新できます。

ステップ4.1:次のコマンドを入力します。APTアップデート&& aptアップグレード-Yにdebianパッケージリストを更新します。

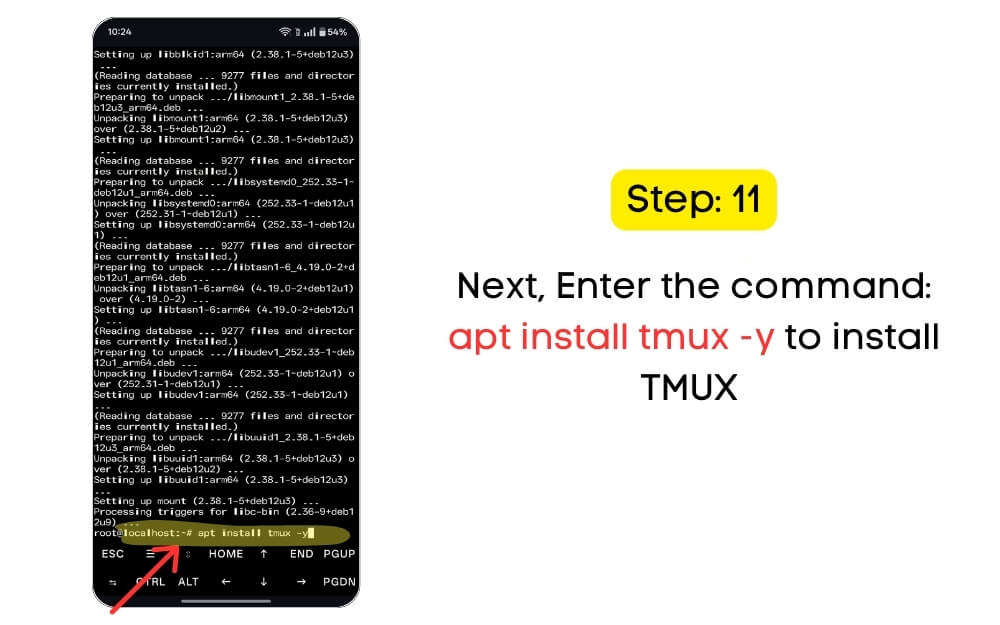

次に、複数のターミナルセッションを管理するためにTMUXをインストールする必要があります。 TMUXを使用すると、単一のウィンドウ内で複数のターミナルセッションを実行できます。 TMUXをインストールする主な理由は、誤って切断されたとしても、AIモデルを背景で実行し続けるのに役立つことです。また、ターミナルを複数のペインに分割してマルチタスクを改善し、複数のタスクを同時に実行するなど、他の利点も付属しています。

ステップ4.2:次のコマンドを使用します: aptインストールtmux -y

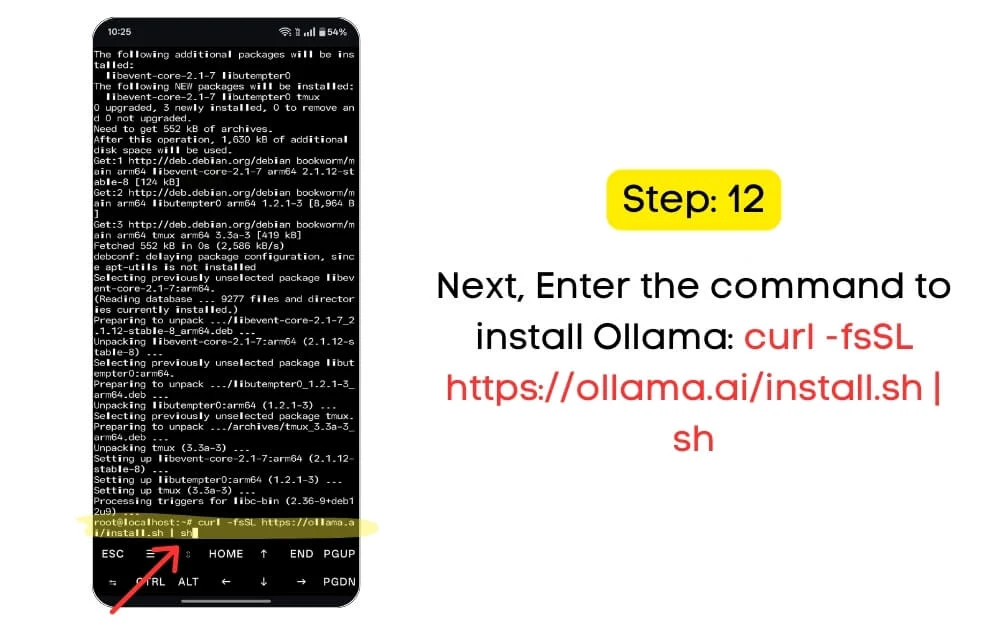

次に、Android向けに設計されたツールであるOllamaをインストールする必要があります。これにより、デバイスでAIモデルをローカルに実行できます。このツールを使用して、DeepSeek R1とメタラマをデバイスでローカルに実行できます。また、ChatGptのようなオフラインAIインターフェイスもサポートしています。

ステップ4.3:これをすべて実行したら、デバイスにdeepseek R1をローカルにインストールして実行する必要があります。次のコマンドを使用してオラマをインストールします。 sh

ステップ5。DeepSeek R1をインストールして実行します

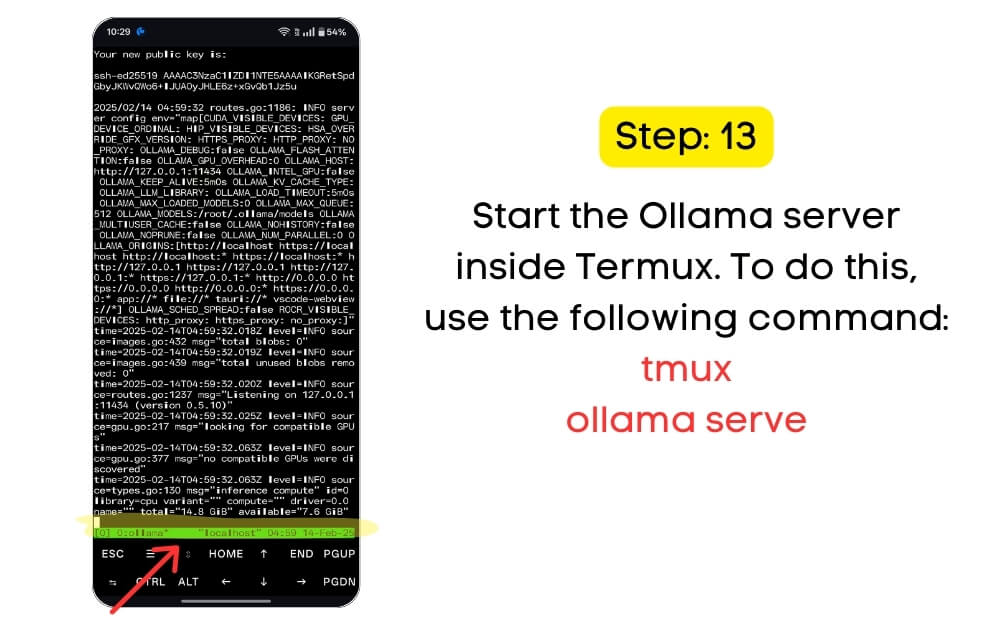

次に、Termux内でOllamaサーバーを起動する必要があります。これを行うには、次のコマンドを使用します。

ステップ5.1:ステップスタートOllamaサーバー内のtmux: tmux ollama surf

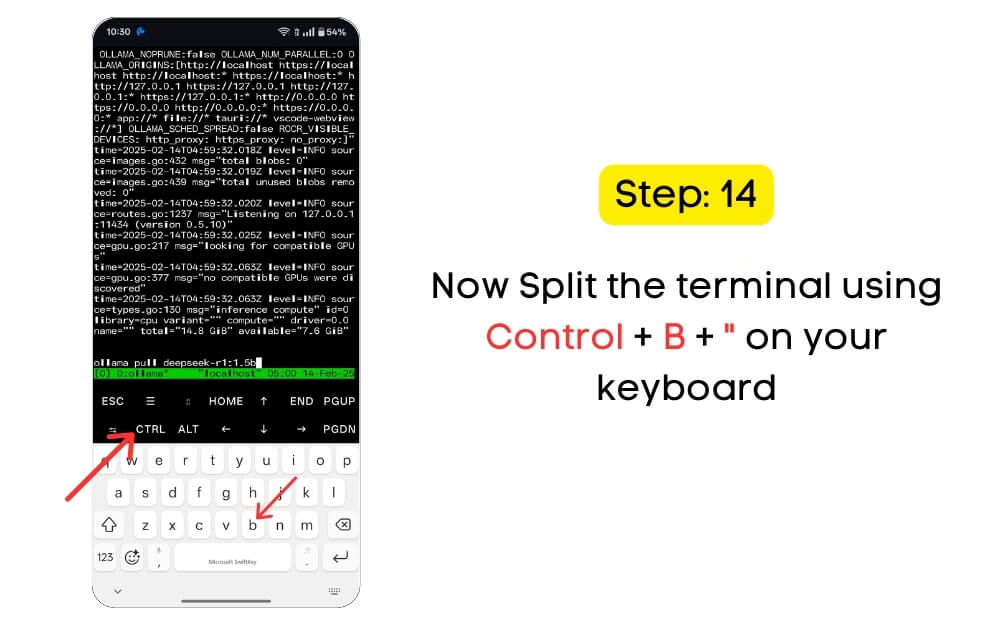

ステップ5.2:新しいTMUXウィンドウを開き、端子を複数のペインに分割します。これは、AIモデルを1つのペインで実行したり、ログを監視したり、別の端末にコマンドを入力したりする場合に役立ちます。次のショートカットを使用して端子を分割します。コントロールをクリック+B+」

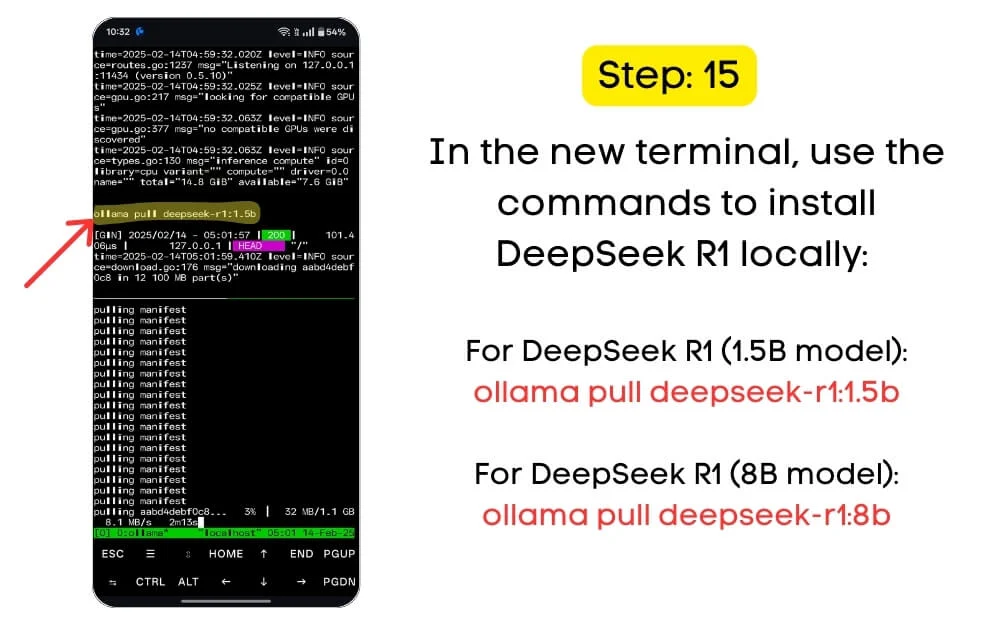

次に、DeepSeek R1 1.5Bモデルをデバイスにローカルにインストールする必要があります。 DeepSeek R1モデルにはいくつかのモデルがあります。 Androidにはリソースが限られており、これらのモデルをローカルに実行するには多くのリソースが必要なため、1.5BモデルはほとんどのAndroidデバイスで最も信頼性の高いモデルです。 DeepSeek R1がサポートするモデルのリストを以下に示します。

モデルバリアント | ストレージ要件 | 最小要件 |

|---|---|---|

DeepSeek-R1:1.5b | 1.1 GB | RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

DeepSeek-R1:7b | 4.4 GB | - RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

DeepSeek-R1:8b | 4.9 GB | RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

Deepseek-R1:14b | 9.0 GB | - RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

DeepSeek-R1:32b | 22 GB | - RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

DeepSeek-R1:70b | 43 GB | - RAM:8 GB - プロセッサ:Snapdragon 8 Gen 2または同等 - ストレージ:12 GBの空きスペース |

次のコマンドを使用して、デバイスのDeepSeek R1 1.5Bローカルモデルをダウンロードします。これにより、デバイスにダウンロードして保存します。デバイスには、各モデルに必要なストレージが最小限に抑えられていることを確認してください。

ステップ5.3:新しいTermux Windowsで、コマンドを使用してDeepSeek R1(1.5Bモデル)をインストールします: Ollama Pull Deepseek-R1:1.5b

ハイエンドのフラッグシップデバイスがある場合、同じコマンドを使用して8Bモデルをインストールできます。同様に、他のハイエンドデバイスがある場合は、15Bパラメーターモデルをデバイスにローカルにインストールできます。

あなたの情報については、モデルパラメーターが多いほど、モデルの能力が高くなります。ほとんどのユースケースでは、1.5Bパラメーターモデルは、会話だけで簡単な選択です。ただし、8Bパラメーターモデルは合理的であり、より多くの知識とより良いパフォーマンスを必要とする場合は、多くの場合推奨されます。

それでおしまい。これで、デバイスにDeepSeek R1を正常にインストールしました。 DeepSeek R1がインストールされたので、Termuxを使用してデバイスでローカルに実行できます。

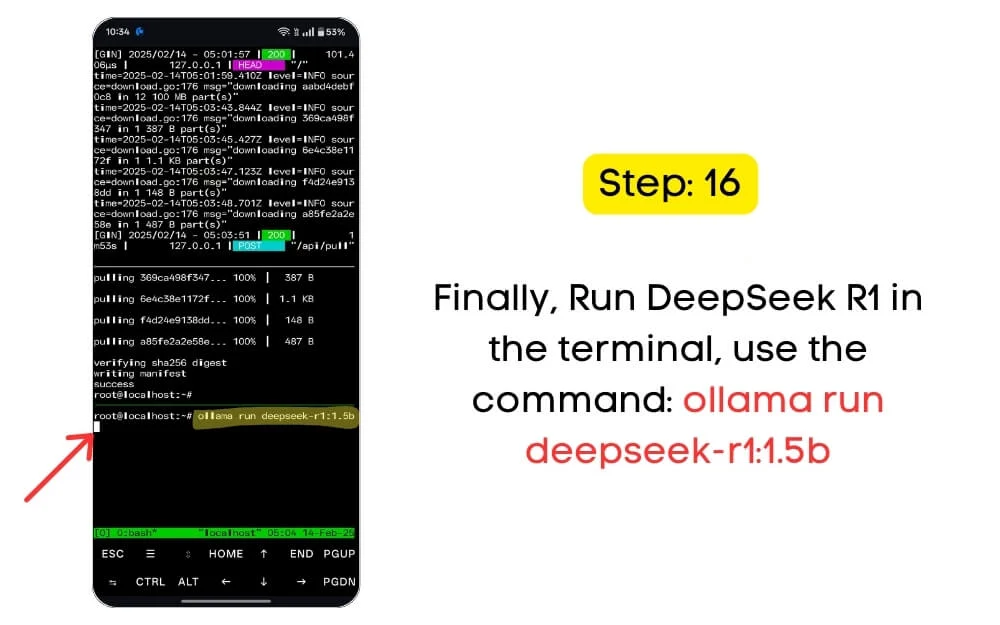

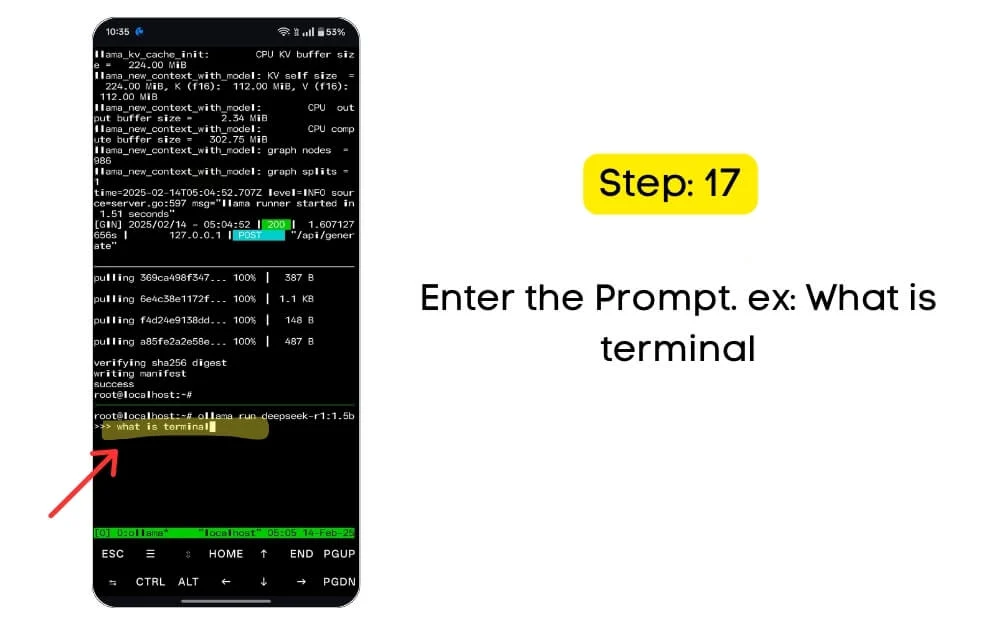

ステップ6。デバイスでdeepseekをローカルに実行します

ステップ6.1:端末でDeepSeek R1を実行するには、コマンドを使用します。OllamaRunDeepseek -R1:1.5b。

コマンドで正しいモデル番号を使用していることを確認してください。 1.5Bモデルをインストールした場合は、コマンドに同じモデル名を使用します。 8Bモデルをインストールした場合は、コマンドを使用します。

これで、テキスト入力を使用してモデルと対話することを試みることができます。すべてが端末を通過するため、ChatGPTと対話するGUI(グラフィカルユーザーインターフェイス)はありません。テキスト入力を使用して、同じ端末で結果を取得できます。

デバイスのローカルストレージと処理能力に応じて、モデルは利用可能なリソースに基づいて出力を生成します。以下は、デバイスでAIセッションをローカルに管理するための最も一般的なTermuxショートカットです。 Ctrl + Cを使用して、AIモデル、Ctrl + Dを停止して終了し、モデルに戻ることができます。

ポケットパルを使用して、デバイスでdeepseek R1をローカルに実行します

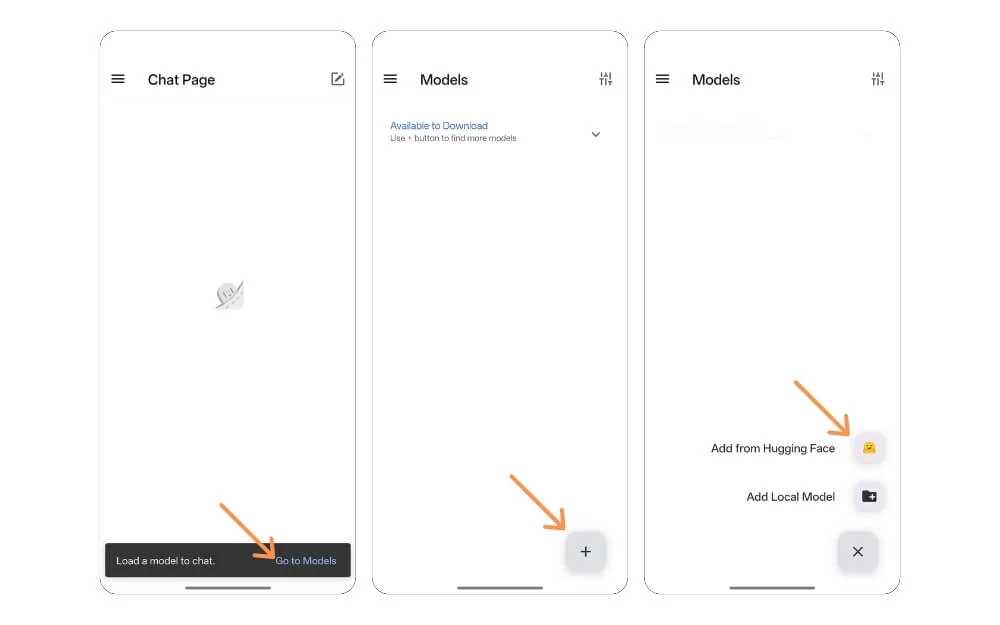

上記の方法が圧倒的であることがわかった場合は、デバイスにAIモデルをインストールおよび実行する無料のアプリであるPocketPal AIを使用できます。以下の手順に従ってください。

ステップ1: Google PlayストアからPocketPalアプリをインストールします。

ステップ2:アプリを開き、モデルに移動します

ステップ3:プラスアイコンをクリックして、抱きしめる顔の追加をタップします。

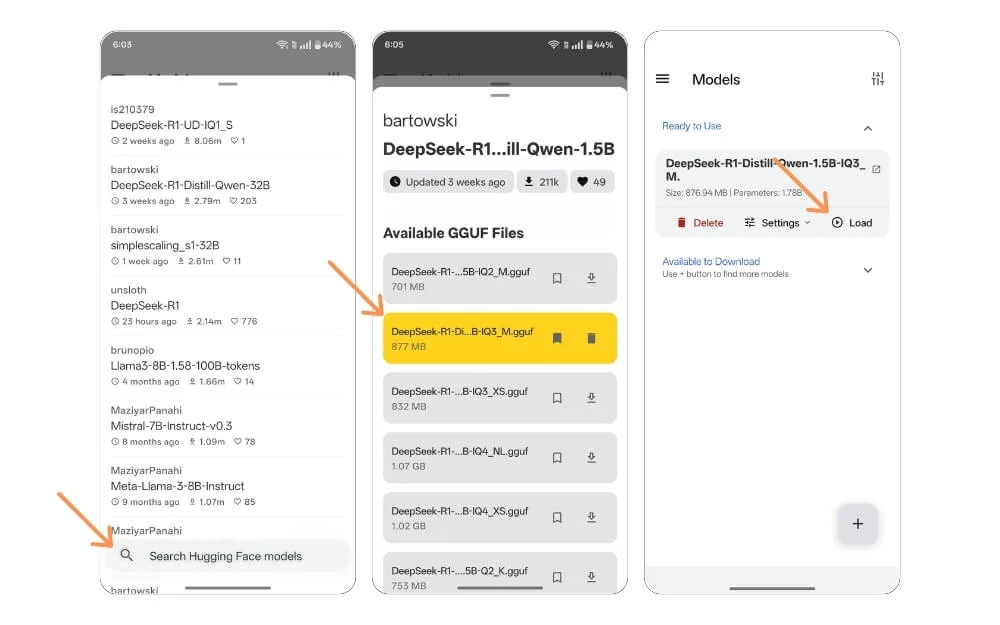

ステップ4:ボタンの検索バーを使用して、 DeepSeek R1モデルを検索します。

ステップ5:デバイスのストレージ制限に基づいてモデルを選択し、ダウンロードアイコンをクリックします。モデルがダウンロードされるのを待ちます。

ステップ6:ダウンロードしたら、ホーム画面に戻り、モデルを選択し、 [ロード]をクリックします。

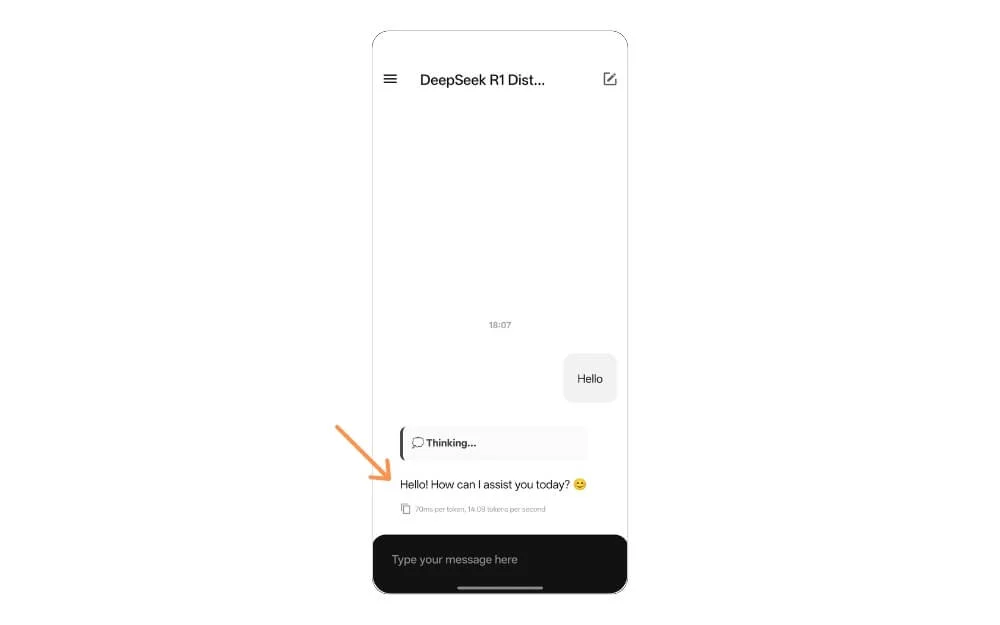

これにより、DeepSeek R1はデバイスにローカルにロードされます。上記の方法とは異なり、モデルと対話するチャットグラフィカルインターフェイスが提供されます。必要に応じて、インターネット接続をオフにすることもできます。

AIモデルをモバイルでローカルに実行します

Deepseekは消費者にとって破壊的で非常に有益ですが、いくつかのレポートは、Deepseekが中国企業にデータを送信できると主張しています。このモデルがローカルでデバイスで実行されると、データはデバイスにとどまります。さらに、フラッグシップスマートフォンの適切な仕様がある場合、DeepSeekはより速く、応答するのが遅い時間はありません。これは一般的にクラウドモデルの場合です。これにより、DeepSeek R1は、デバイスにLLMをローカルにインストール、実行、および使用するための優れたリソースになります。

私はあなたの詳細で包括的なステップバイステップのヘルプを共有しました。インストール中に問題やエラーがまだ遭遇した場合は、以下にコメントできます。私はあなたを助けようとします。このガイドが役立つことを願っています。また、MacとWindowsにDeepseekをローカルにインストールするガイドをご覧ください。それはあなたの専門家や学生の仕事の仕事に非常に役立ちます。