AI 음성 복제 사기: 성인 4명 중 1명 이미 표적

게시 됨: 2023-05-02사랑하는 사람의 음성 메일과 AI가 생성한 음성 메일을 구분할 수 있다고 생각하시나요? 의심하지 않는 피해자를 속이기 위해 AI 음성 복제 기술을 사용하는 사기꾼은 확실히 당신이 사기를 칠 수 없기를 바랍니다. 그리고 이제 그들은 그 어느 때보다 활발해졌습니다.

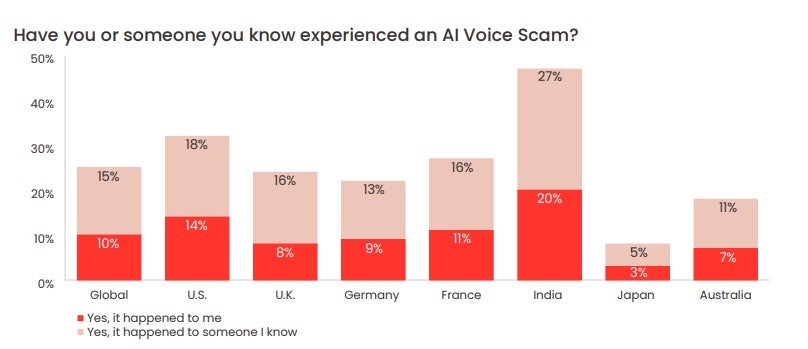

McAfee가 최근 실시한 설문 조사에 따르면 성인의 4분의 1이 이미 AI 음성 사기의 표적이 되었으며 그 결과 압도적 다수가 힘들게 번 돈을 잃었습니다. 또한 대다수의 성인이 적어도 일주일에 한 번 소셜 미디어 플랫폼 및 기타 온라인 공간에서 자신의 목소리를 공유한다고 밝혔습니다. 이는 위협 행위자가 이러한 종류의 사기를 반복해서 수행하는 데 필요한 것을 정확하게 제공합니다.

그렇다면 AI 음성 복제 사기는 실제로 어떻게 작동하고 얼마나 흔하며 AI 음성 복제 사기를 어떻게 발견할 수 있습니까? 자세히 살펴 보겠습니다.

- AI 음성 복제 사기란?

- AI 음성 복제가 실제로 작동하는 방식

- AI 보이스 클론 사기는 얼마나 흔한가요?

- 메시지가 AI 음성 복제 사기인지 확인하는 방법

AI 음성 복제 사기란?

AI 음성 복제 사기는 인위적으로 생성된 오디오 파일을 사용하여 피해자를 속여 사랑하는 사람이 위험에 처해 있다고 생각하거나 긴급한 재정 지원이 필요하고 도움을 요청하는 사기입니다.

이런 종류의 사기에서 사기꾼은 AI 음성 생성기를 통해 종종 소셜 미디어에서 스크랩한 주제가 말하는 클립을 실행합니다. 기계 학습을 사용하여 생성기는 초기 클립의 케이던스, 톤 및 피치를 분석한 다음 사기꾼이 대상의 목소리를 거의 완벽하게 모방하는 고유한 원본 오디오를 생성할 수 있도록 합니다.

그런 다음 사기꾼은 WhatsApp과 같은 앱을 통해 대상의 친구 및 친척에게 이러한 녹음을 보내며 사랑하는 사람과 AI가 생성한 음성 버전을 구별할 수 없기를 바랍니다.

다른 온라인 사기 에서 흔히 볼 수 있듯이 사기꾼은 상대방이 성급하게 또는 변덕스럽게 행동하도록 유도하기 위해 서신에 긴박감과 고통을 불어넣으려고 합니다.

최근 한 AI 음성 사기꾼은 미국에 있는 한 어머니에게 아이의 목소리를 복제해 딸이 납치됐다고 설득하려 했습니다.

우려되는 점은 신진 사기꾼이 피해자를 표적으로 삼는 데 필요한 오디오 파일을 찾는 것이 어렵지 않을 것입니다.

2023년 5월 McAfee에서 7개 국가의 7,000명 이상이 참여한 설문 조사에 따르면 설문 응답자의 53%가 일주일에 한 번 이상 온라인에서 자신의 목소리를 공유한다고 답했습니다. 인도에서는 이 수치가 86%였습니다.

음성 복제가 실제로 작동하는 방식

AI 음성 복제는 AI 음성 생성기라는 AI 도구를 통해서만 가능합니다. 간단히 말해서 AI 음성 생성기는 텍스트 파일을 음성으로 변환합니다(종종 "텍스트 음성 변환" 또는 "TTS" 도구라고 함).

AI 음성 생성기는 기계 학습을 사용하여 말하는 사람의 오디오 파일에서 정보를 분석하여 특정 방식으로 말하는 방법을 스스로 학습합니다. 그런 다음 생성기는 학습한 내용을 적용하여 사용자가 제공한 텍스트 파일을 읽고 원본 오디오 콘텐츠를 생성합니다.

이러한 생성기 중 다수는 텍스트를 읽기 위해 선택할 수 있는 사용자 지정 음성과 선택할 수 있는 유명인의 음성을 가지고 있지만 다른 생성기에서는 자신의 음성을 녹음하고 후속 오디오 콘텐츠를 만들 수 있습니다.

텍스트 음성 변환 도구 Descript.com은 자칭 "자신의 목소리를 매우 사실적으로 복제하는 최첨단 음성 생성기"를 제공합니다.

AI 음성 생성기는 이제 모든 종류의 장치에서 널리 사용할 수 있습니다. 이러한 프로그램은 읽기에 어려움이 있는 사람들에게 많은 가치를 제공하거나 서면 단어를 읽는 것보다 오디오를 들을 때 더 잘 배울 수 있습니다.

또한 마케팅 콘텐츠를 위해 값비싼 성우를 고용할 예산이 없는 광고 회사에서도 사용합니다.

ChatGPT 의 성공과 광범위한 사용은 오디오 복제에 사용할 수 있는 도구를 포함하여 모든 모양과 크기의 AI 도구에 새롭게 초점을 맞췄습니다. 그들의 고귀한 용도에도 불구하고, 불행히도 사람들을 사기를 치는 것을 포함하여 악의적인 목적을 위해 남용될 수 있는 TTS AI 도구의 작은 생태계가 있습니다.

AI 보이스 클론 사기는 얼마나 흔한가요?

최근 발표된 McAfee 설문 조사에서 사이버 보안 대기업은 설문 조사에 참여한 성인 4명 중 1명이 AI 음성 사기를 경험한 것으로 나타났습니다.

표적이 된 사람들의 77%는 사기로 인해 돈을 잃었다고 보고했습니다. McAfee는 그 77% 중 "1/3 이상이 $1,000 이상을 잃었고, 7%는 $5,000에서 $15,000 사이에서 속았다"고 보고했습니다.

설문 조사에 따르면 미국의 피해자가 가장 큰 피해를 입었습니다. AI 음성 복제 사기로 돈을 잃은 미국 피해자의 11%는 $5,000~$15,000를 잃었습니다.

메시지가 AI 음성 복제 사기인지 확인하는 방법

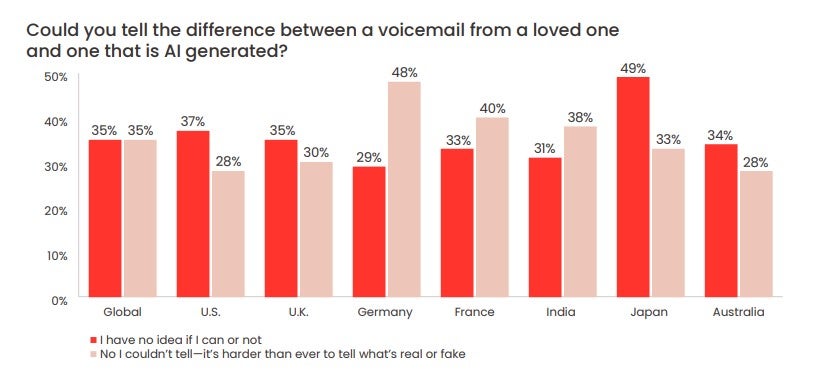

McAfee 설문 조사에서는 또한 70%의 사람들이 AI 음성과 인간의 음성을 구분할 수 있을지 "확실하지 않다"고 답했습니다.

미국 응답자의 약 1/3(28%)은 McAfee가 표현한 "인공 사기꾼"이 남긴 음성 메일과 사랑하는 사람 사이의 차이를 구분할 수 없을 것이라고 말했습니다.

기억하세요. 사기꾼은 사랑하는 사람의 목소리를 복제할 수 있지만 사랑하는 사람의 전화번호나 WhatsApp 계정을 제어하는 것은 훨씬 더 어렵습니다.

친척이나 친구 중 한 명이 곤경에 처한 것처럼 들리면 침착하게 행동하기 어려울 수 있습니다. 그러나 AI 음성 사기가 점점 보편화됨에 따라 그렇게 하는 것이 중요합니다. AI 음성 메시지가 사기일 수 있다는 몇 가지 징후가 있습니다.

- 비정상적인 연락 방법(예: 알 수 없는 번호)

- 거액의 즉각적인 요구

- 비정상적인 수단(예: 기프트 카드 또는 암호화폐)을 통한 송금 요청

- 통화/사건에 대해 아무에게도 말하지 말라는 요구

이를 염두에 두고 FTC에서 권장하는 조치는 다음과 같습니다.

- 메시지를 남긴 번호로 전화를 걸어 누구인지 확인

- 사랑하는 사람이나 친구의 개인 번호로 전화를 겁니다.

- 본인의 가족 및 가까운 지인들에게 메시지 보내기

연락할 수 없는 경우 즉시 법 집행 기관에 알리는 것이 중요합니다. 아직 이러한 사기 중 하나의 표적이 되지 않았지만 이러한 사기의 피해자가 되지 않으려면 가족 및 친구와 함께 세이프워드를 설정하십시오 .

이것은 귀하와 귀하의 사랑하는 사람이 서로를 식별할 수 있음을 의미하는 코드이며 AI 음성 사기의 피해자가 되지 않도록 하는 가장 좋은 방법 중 하나입니다. 이것은 연로한 가족 구성원에게 특히 유용할 것이며, 적어 두지 않으면 매우 간단하게 유지할 수 있습니다.

AI 음성 사기꾼이 피해자를 갈취하는 데 사용하는 최신 방법, 기술 및 형식을 파악하는 것도 중요합니다. 경계를 늦추지 않고 알 수 없는 번호로 걸려오는 전화를 매우 조심스럽게 처리하는 것과 함께 귀를 땅에 대고 있는 것이 종종 할 수 있는 최선의 방법입니다.