Dlaczego chatboty terapii AI stanowią ostateczny dylemat etyczny

Opublikowany: 2023-10-31Generacyjne chatboty AI, takie jak ChatGPT , są wykorzystywane do usprawniania procesów w miejscu pracy, pisania kodu, a nawet pisania scenariuszy do stand-upów. W Stanach Zjednoczonych, gdzie liczba przypadków lęku i depresji osiąga rekordową liczbę przypadków, a poziom profesjonalnego wsparcia jest nadal ograniczony, nie jest zaskoczeniem, że użytkownicy korzystają z tej technologii również w celu kontrolowania swojego zdrowia psychicznego.

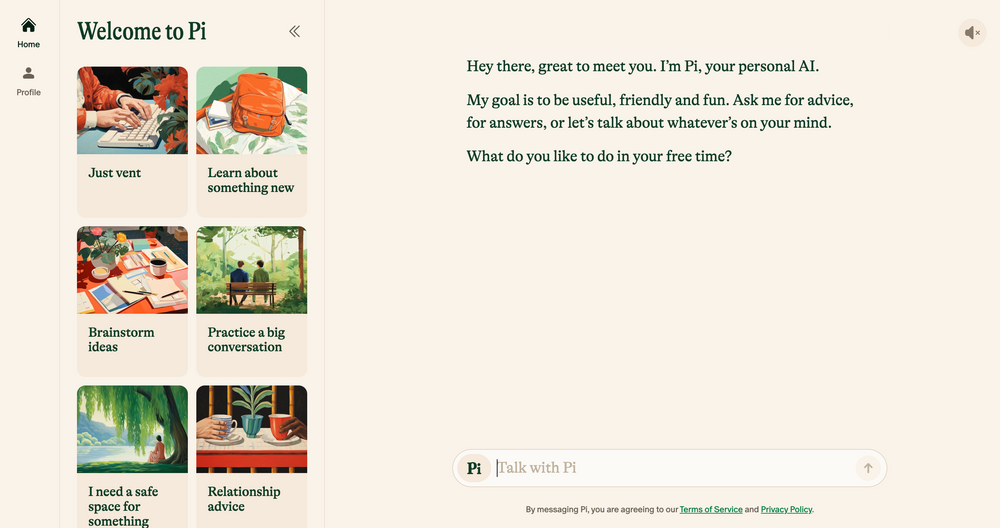

Chatboty AI, takie jak Elomia, Pi i Woebot, oferują niedrogie, spersonalizowane wsparcie 24 godziny na dobę, 7 dni w tygodniu, w oparciu o wypróbowane i przetestowane techniki terapeutyczne. Od pomocy użytkownikom w ominięciu długich list oczekujących po zmniejszenie piętna wokół dostępu do pomocy – korzyści z nich są ogromne. Czy generatywna sztuczna inteligencja – która wciąż jest podatna na błędy, halucynacje i uprzedzenia – może kiedykolwiek równać się z empatią ludzkiego ucha?

Rozmawialiśmy z naukowcami, psychologami i praktykującymi terapeutami, aby rzucić światło na to, w jaki sposób pojawiające się technologie prawdopodobnie ukształtują przyszłość terapii. Omawiamy także ciemniejszą stronę terapii AI i wskazujemy, którymi kwestiami etycznymi należy się dzisiaj zająć. Oto, co znaleźliśmy.

Chatboty AI: nowa generacja robotów-terapeutów

Od czasu premiery chatbota ChatGPT OpenAI w listopadzie zeszłego roku w sklepach z aplikacjami pojawiła się armia naśladowców chatbotów – od aplikacji ogólnego użytku, takich jak Google Bard i Claude AI , po mniej konwencjonalne symulatory postaci Marvela.

Ten rozwijający się rynek doprowadził również do powstania chatbotów terapeutycznych AI – aplikacji wykorzystujących generatywną sztuczną inteligencję do naśladowania porad i wskazówek oferowanych przez wykwalifikowanych terapeutów i specjalistów w dziedzinie zdrowia psychicznego.

Chcesz przeglądać internet prywatnie? Lub sprawiać wrażenie, jakbyś był w innym kraju?

Chcesz przeglądać internet prywatnie? Lub sprawiać wrażenie, jakbyś był w innym kraju?

Skorzystaj z ogromnej zniżki 86% na Surfshark dzięki ofercie Tech.co na Czarny Piątek. ![]()

Do najważniejszych przykładów można zaliczyć Pi, samozwańczego „przyjaznego towarzysza rozmów”, który pełni rolę rezonansu i oferuje wsparcie emocjonalne; Replika, program typu chatbot naśladujący styl mówienia i osobowość swoich użytkowników; oraz Earkick, narzędzie do śledzenia lęku, które ma pomóc Ci rejestrować i pracować nad trudnymi emocjami.

„Platformy oparte na sztucznej inteligencji zapewniają prywatność, zmniejszając piętno często kojarzone z szukaniem pomocy w przypadku problemów ze zdrowiem psychicznym”. – Ryan Sultan, certyfikowany psychiatra i profesor na Uniwersytecie Columbia

Podobnie jak najlepsze aplikacje dotyczące zdrowia psychicznego , wiele z tych aplikacji może już poszczycić się sześciocyfrową liczbą pobrań, a ich popularność nie jest zaskakująca. Ze względu na niedostatek wykwalifikowanych psychologów, psychiatrów i pracowników socjalnych, a także gwałtowny wzrost popytu na usługi w całym kraju, Stany Zjednoczone zmagają się obecnie z jednym z najgorszych w historii kryzysów zdrowia psychicznego.

Wysoki koszt tradycyjnej terapii i tabu dotyczące zdrowia psychicznego również zniechęcają wiele osób do korzystania z konwencjonalnych opcji, tworząc lukę dla bardziej dyskretnych i niedrogich alternatyw.

Wczesne dowody sugerują, że są one również skuteczne. Z własnych ustaleń Earkicka AI Chatbot wynika, że po pięciu miesiącach korzystania z aplikacji nastrój użytkownika poprawił się o 34%, a poziom niepokoju spadł o 32%. Mimo że te aplikacje mogą skutecznie łagodzić drobne lęki, zdecydowanie nie są panaceum na zdrowie psychiczne, na które wszyscy czekaliśmy.

Chatboty AI nieodpowiednie w przypadku poważnych schorzeń psychicznych

Otrzymanie rozsądnych, zatwierdzonych przez terapeutę porad od kieszonkowego chatbota niewątpliwie będzie dla wielu pomocne. Jednak osoby cierpiące na poważne schorzenia psychiczne, takie jak depresja, schizofrenia i choroba afektywna dwubiegunowa, prawdopodobnie nie zostaną zmienione.

Zaburzenia psychiczne są złożone, bardzo zróżnicowane i unikalne dla każdej osoby, na którą wpływają. W niektórych przypadkach najlepiej leczyć je za pomocą leków, które mogą być prawidłowo przepisane wyłącznie przez wykwalifikowanych lekarzy. Chociaż w ostatnich latach duże modele językowe (LLM) ewoluowały w zawrotnym tempie, ich wyniki nigdy nie będą w stanie zastąpić wiedzy klinicznej, empatii i współczucia zapewnianych przez psychiatrów, psychologów i terapeutów.

„Doceniam poprawę algorytmów, ale ostatecznie nie sądzę, że zajmą się bardziej chaotyczną rzeczywistością społeczną, w której znajdują się ludzie, którzy szukają pomocy” – Julia Brown, profesor antropologii na Uniwersytecie Kalifornijskim w San Francisco

Strategiczny uzdrowiciel psychiczny Aanant Bisht wierzy również, że sztuczna inteligencja w obecnym stanie nie będzie w stanie pomóc każdemu użytkownikowi w złożonej podróży uzdrawiającej. „Ważne jest również, aby unikać nadmiernego upraszczania złożonych problemów zdrowia psychicznego i zachęcać użytkowników do szukania profesjonalnej pomocy, gdy jest to konieczne” – mówi Bisht Tech.co.

Inną częstą obawą wyrażaną przez ekspertów, z którymi rozmawialiśmy, jest błędna diagnoza lekarska. Społeczność zajmująca się zdrowiem psychicznym od dawna ma problem z prawidłową identyfikacją złożonych i poważnych zaburzeń psychicznych, a nadmierne poleganie na sztucznej inteligencji może prawdopodobnie zaostrzyć ten problem ze względu na ograniczone technologie, niereprezentatywne zbiory danych i niemożność interpretacji ludzkich niuansów.

Skutki tego również mogą być surowe. Błędna diagnoza zdrowia psychicznego często prowadzi do nieodpowiedniego leczenia i wsparcia, dodatkowej presji psychicznej i długotrwałego sceptycyzmu wobec systemu medycznego. To nie jedyny powód, dla którego sztuczna inteligencja nie jest w stanie dogonić fotela terapeuty w obecnej formie.

Sztuczna inteligencja ma wady i jest owiana wyzwaniami etycznymi

Szybki rozwój generatywnej sztucznej inteligencji nie pozostał bez konsekwencji. Ponieważ technologia rozwija się w zawrotnym tempie, regulacje dotyczące jej stosowania powoli nadrabiają zaległości, co przyczynia się do szeregu wyzwań etycznych związanych z prywatnością danych, wrodzoną uprzedzeniami i niewłaściwym wykorzystaniem.

Obawy te nie dotyczą wyłącznie terapii, ale delikatny charakter zdrowia psychicznego oznacza, że ramy etyczne stanowią podstawę każdej dobrej relacji terapeutycznej. Ponieważ oficjalny kodeks etyczny sztucznej inteligencji obecnie nie istnieje, korzystanie przez użytkowników z chatbotów zamiast z wykwalifikowanych specjalistów w zakresie poradnictwa lub innego wsparcia w zakresie zdrowia psychicznego jest bardzo problematyczne.

Prywatność danych to jedna z głównych kwestii. Chatboty takie jak ChatGPT często wpadały w kłopoty z powodu braku ochrony danych użytkowników . Aby użytkownicy czuli się komfortowo, omawiając prywatne dane osobowe, firmy zajmujące się sztuczną inteligencją będą musiały posiadać niezawodną strategię ochrony danych, w której priorytetem będzie poufność.

„Intymny i wrażliwy charakter rozmów terapeutycznych wymaga niezrównanego poziomu ochrony danych”. – dr Langham, psycholog w Impulse Therapy

Kolejnym ważnym czynnikiem, o którym należy pamiętać, jest stronniczość uczenia maszynowego. Wszystkie systemy sztucznej inteligencji opierają się na z góry określonych danych szkoleniowych, które często zawierają wbudowane ludzkie uprzedzenia, nawet jeśli usunięte zostaną wrażliwe zmienne, takie jak rasa i płeć.

Według Bayu Prihandito, dyrektora generalnego firmy Life Architekture, zajmującej się trenerami życia , jeśli sztuczna inteligencja będzie szkolona w oparciu o stronnicze dane, „może utrwalić lub zaostrzyć istniejące uprzedzenia, prowadząc do niesprawiedliwych zaleceń dotyczących leczenia”. Te wbudowane uprzedzenia prawdopodobnie w większym stopniu będą miały wpływ również na osoby z grup mniejszościowych, podkreślając znaczenie ludzkiego nadzoru oraz zróżnicowanych i reprezentatywnych zbiorów danych szkoleniowych.

Sztuczna inteligencja jako asystent terapeuty, a nie zamiennik

Przyjaźni towarzysze, tacy jak Pi i Woebot, będą zyskiwać na popularności jedynie w miarę, jak użytkownicy będą nadal szukać dostępnych sposobów na uzupełnienie swojego dobrego samopoczucia psychicznego. Jednak ze względu na szeroki zakres problemów etycznych sztuczna inteligencja nie jest gotowa zastąpić roli tradycyjnej terapii i nigdy nie powinna.

Nie oznacza to jednak, że powstająca technologia nie będzie miała ogromnego wpływu na praktykę jako całość. Większość praktyków, z którymi rozmawialiśmy, wierzy, że wykonując podstawowe prace, takie jak triaging, narzędzia AI będą w stanie zapewnić im więcej czasu i energii do wykorzystania w innych obszarach praktyki.

„Chociaż nie może zastąpić głębokiej więzi międzyludzkiej oferowanej przez terapeutów, może służyć jako narzędzie uzupełniające”. – Aanant Bish, trener psychiczny biznesu

„Sztuczna inteligencja mogłaby poradzić sobie ze wstępnymi ocenami, bieżącym monitorowaniem i zapewnić wsparcie w mniej skomplikowanych przypadkach, pozwalając nam skupić się na poważniejszych lub delikatnych sytuacjach” – powiedział Bayu Prihandito Tech.co, dodając „ To jak mieć dodatkową parę rąk, które zawsze są dostępny."

Profesor Uniwersytetu Columbia i certyfikowany psychiatra Sultan zgadza się z tym, mówiąc Tech.co, że za pięć lat sztuczna inteligencja prawdopodobnie uzupełni tradycyjną terapię , usprawniając zadania administracyjne, pomagając lekarzom w tworzeniu bardziej spersonalizowanych planów leczenia oraz „ tworząc modele hybrydowe, które łączą ludzką wiedzę z sztuczną inteligencją”. napędzane narzędzia usprawniające leczenie”.

Sugeruje to, że sztuczna inteligencja nie tylko nie wyczerpuje człowieczeństwa, ale ma moc uwalniania ludzkich umiejętności, takich jak empatia, więź i współczucie, pomagając klientom uzyskać jeszcze więcej korzyści z usługi.

Jednakże dbanie o zdrowie psychiczne to poważna sprawa i często może decydować o życiu i śmierci. Zanim sztuczna inteligencja stanie się asystentem każdego terapeuty lub w ogóle ją zastąpi, należy rozważyć rygorystyczne regulacje dotyczące jej wdrożenia i stosowania.

Dopóki ten czas nie nadejdzie, nie da się w pełni pogodzić oczywistego potencjału chatbotów AI w zakresie poprawy dostępu do wsparcia w zakresie zdrowia psychicznego z zagrożeniami, jakie stwarzają. W świecie, w którym dylematy etyczne są często na porządku dziennym, ten jest po prostu zbyt poważny, aby go zignorować.