Oszustwa związane z klonowaniem głosu AI: 1 na 4 osoby dorosłe są już celem ataków

Opublikowany: 2023-05-02Czy myślisz, że potrafisz odróżnić wiadomość głosową od kogoś, kogo kochasz, od poczty głosowej wygenerowanej przez sztuczną inteligencję? Cóż, oszuści wykorzystujący technologię klonowania głosu AI do oszukiwania niczego niepodejrzewających ofiar z pewnością mają nadzieję, że nie możesz – a teraz są bardziej aktywni niż kiedykolwiek.

Ankieta przeprowadzona niedawno przez firmę McAfee wykazała, że jedna czwarta dorosłych padła już ofiarą oszustw głosowych wykorzystujących sztuczną inteligencję, a przytłaczająca większość traci w rezultacie ciężko zarobione pieniądze. Ujawniono również, że większość dorosłych co najmniej raz w tygodniu dzieli się swoim głosem na platformach mediów społecznościowych i innych przestrzeniach internetowych, co daje cyberprzestępcom dokładnie to, czego potrzebują do przeprowadzania tego rodzaju oszustw w kółko.

Jak więc faktycznie działają oszustwa związane z klonowaniem głosu AI, jak powszechne jest to zjawisko i jak można wykryć oszustwo polegające na klonowaniu głosu AI? Przyjrzymy się bliżej.

- Co to jest oszustwo związane z klonowaniem głosu AI?

- Jak faktycznie działa klonowanie głosu AI

- Jak powszechne są oszustwa AI Voice Clone?

- Jak sprawdzić, czy wiadomość jest oszustwem związanym z sztucznym klonowaniem głosu

Co to jest oszustwo związane z klonowaniem głosu AI?

Oszustwo związane z klonowaniem głosu AI to każde oszustwo, które wykorzystuje sztucznie wygenerowane pliki audio, aby oszukać ofiary, aby pomyślały, że ich bliscy są w niebezpieczeństwie lub potrzebują pilnej pomocy finansowej i skontaktowali się z nimi w celu uzyskania pomocy.

W tego rodzaju oszustwie oszust uruchamia klip przedstawiający przemawiającą osobę – często zaczerpnięty z mediów społecznościowych – przez generator głosu AI. Korzystając z uczenia maszynowego, generator przeanalizuje kadencję, ton i ton początkowego klipu, a następnie umożliwi oszustowi wyprodukowanie unikalnego, oryginalnego dźwięku, który niemal idealnie naśladuje głos badanych.

Oszuści następnie wyślą te nagrania znajomym i krewnym osoby za pośrednictwem aplikacji takich jak WhatsApp, mając nadzieję, że nie będą w stanie odróżnić swojej ukochanej osoby od wersji jej głosu wygenerowanej przez sztuczną inteligencję.

Jak to zwykle bywa w przypadku innych oszustw internetowych , oszust będzie próbował nadać swojej korespondencji poczucie pilności i niepokoju, aby skłonić ofiarę do pochopnego lub chaotycznego działania.

W jednym z niedawnych przypadków oszust głosowy wykorzystujący sztuczną inteligencję próbował przekonać matkę w USA, że jej córka została porwana przez sklonowanie głosu dziecka.

Co ciekawe, początkujący oszust nie będzie miał trudności z odnalezieniem plików audio potrzebnych do namierzenia ofiary – w rzeczywistości prawdopodobnie będzie miał duży wybór.

Ankieta opublikowana przez firmę McAfee w maju 2023 r., w której wzięło udział ponad 7000 osób z siedmiu różnych krajów, wykazała, że 53% respondentów stwierdziło, że przynajmniej raz w tygodniu udostępnia swój głos online. W Indiach odsetek ten wynosił 86%.

Jak faktycznie działa klonowanie głosu

Klonowanie głosu AI jest możliwe tylko za pomocą narzędzia AI zwanego generatorem głosu AI. W skrócie, generatory głosu AI zamieniają pliki tekstowe na mowę (często nazywane narzędziem „tekst na mowę” lub „TTS”).

Generatory głosu AI wykorzystują uczenie maszynowe, aby nauczyć się mówić w określony sposób, analizując informacje z plików audio mówiących osób. Następnie generatory wykorzystują to, czego się nauczyły, do odczytywania plików tekstowych dostarczonych przez użytkowników i generowania oryginalnych treści audio.

Wiele z tych generatorów ma niestandardowe głosy, które możesz wybrać, aby przeczytać swój tekst, a także głosy celebrytów do wyboru – ale inne pozwalają na nagranie własnego głosu i tworzenie kolejnych treści audio.

Narzędzie zamiany tekstu na mowę Descript.com oferuje samozwańczy „najnowocześniejszy generator głosu, który tworzy ultrarealistyczny klon własnego głosu”.

Generatory głosu AI są obecnie powszechnie dostępne dla wszelkiego rodzaju urządzeń. Programy te są bardzo przydatne dla osób, które mają trudności z czytaniem lub po prostu lepiej uczą się, słuchając dźwięku niż czytając słowo pisane.

Są również używane przez firmy reklamowe, które nie mają budżetu na zatrudnienie drogiego lektora do swoich treści marketingowych.

Sukces i szerokie wykorzystanie ChatGPT sprawiły, że ponownie skupiono się na narzędziach AI o różnych kształtach i rozmiarach, w tym takich, które można wykorzystać do klonowania dźwięku. Pomimo ich szlachetnych zastosowań, istnieje obecnie mały ekosystem narzędzi TTS AI, które niestety mogą być wykorzystywane do niecnych celów, w tym do oszukiwania ludzi.

Jak powszechne są oszustwa AI Voice Clone?

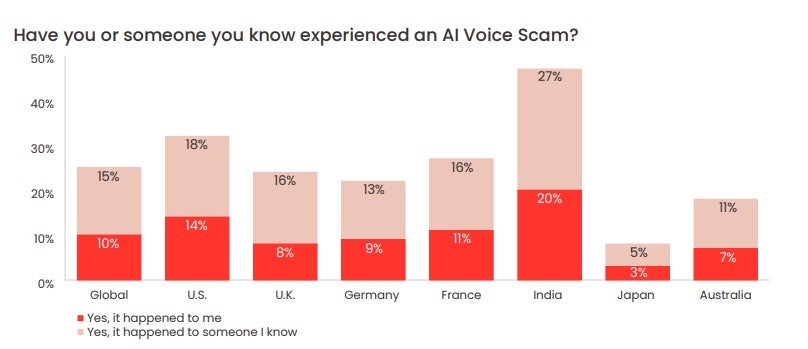

W niedawno opublikowanej ankiecie McAfee gigant cyberbezpieczeństwa stwierdził, że 1 na 4 ankietowanych dorosłych doświadczyło oszustwa głosowego AI.

77% docelowych osób zgłosiło, że straciło pieniądze z powodu oszustwa. McAfee podaje, że z tych 77% „ponad jedna trzecia straciła ponad 1000 USD, podczas gdy 7% zostało oszukanych w przedziale od 5 000 do 15 000 USD”.

Z badania wynika, że ofiary w USA tracą najwięcej. 11% ofiar w USA, które straciły pieniądze w wyniku oszustw związanych z klonowaniem głosu przez sztuczną inteligencję, straciło od 5 000 do 15 000 USD.

Jak stwierdzić, czy wiadomość jest oszustwem związanym z sztucznym klonowaniem głosu

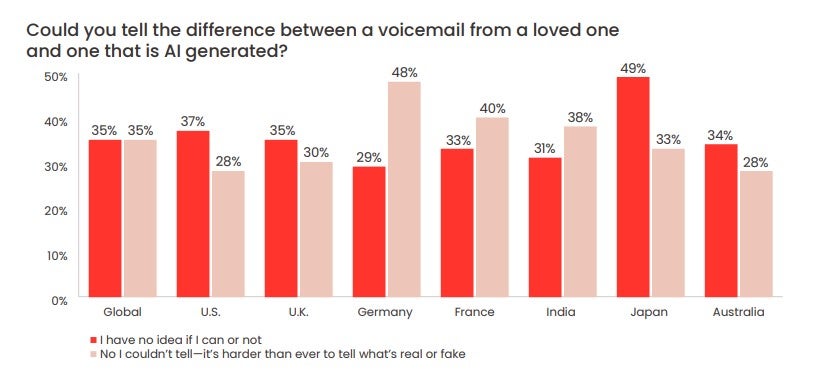

Ankieta McAfee wykazała również, że 70% osób stwierdziło, że „nie są pewni”, czy będą w stanie odróżnić głos sztucznej inteligencji od ludzkiego.

Prawie jedna trzecia (28%) respondentów w USA stwierdziła, że nie byłaby w stanie odróżnić wiadomości głosowej pozostawionej przez „sztucznego oszusta”, jak to ujął McAfee, od ukochanej osoby.

Pamiętaj, że oszuści mogą być w stanie odtworzyć głos ukochanej osoby – ale przejęcie kontroli nad numerem ukochanej osoby lub kontem WhatsApp jest o wiele trudniejsze.

Może być trudno zachowywać się spokojnie, gdy wydaje się, że jeden z twoich krewnych lub przyjaciół jest w niebezpieczeństwie. Ale ponieważ oszustwa głosowe AI stają się coraz bardziej powszechne, ważne jest, abyś to zrobił. Istnieją pewne oznaki, że wiadomość głosowa AI może być oszustwem:

- Nietypowy sposób kontaktu (np. nieznany numer)

- Natychmiastowe prośby o duże sumy pieniędzy

- Prośby o przekazanie pieniędzy w nietypowy sposób (np. karty podarunkowe lub kryptowaluty)

- Żądanie, aby nikomu nie mówić o rozmowie/incydencie

Mając to na uwadze, oto, co FTC zaleca:

- Zadzwoń pod numer, z którego otrzymałeś wiadomość, aby sprawdzić, kto to jest

- Zadzwoń do ukochanej osoby lub przyjaciela na jej osobisty numer

- Wyślij wiadomość do rodziny i bliskich przyjaciół danej osoby

Jeśli nie możesz nawiązać kontaktu, ważne jest, abyś natychmiast poinformował organy ścigania. Dla tych z Was, którzy nie padli jeszcze celem żadnego z tych oszustw, ale chcą się upewnić, że nie padną ich ofiarą, ustalcie słowo bezpieczeństwa z rodziną i przyjaciółmi.

Jest to kod, który oznacza, że ty i twoi bliscy możecie się nawzajem zidentyfikować. Jest to jeden z najlepszych sposobów, aby upewnić się, że nie padniesz ofiarą oszustwa głosowego AI. Będzie to szczególnie przydatne dla starszych członków rodziny, a jeśli nigdy nie zostanie spisane, może być dość proste.

Ważne jest również, aby być na bieżąco z najnowszymi metodami, technikami i formatami, których oszuści głosowi wykorzystujący sztuczną inteligencję używają do wyłudzania ofiar. Wraz z zachowaniem czujności i traktowaniem połączeń z nieznanych numerów z najwyższą ostrożnością, trzymanie ucha przy ziemi jest często najlepszą rzeczą, jaką możesz zrobić.