ChatGPT i sztuczna inteligencja w innych językach są tak samo irracjonalne jak my

Opublikowany: 2023-04-10W ciągu ostatnich kilku lat nastąpił gwałtowny postęp w systemach sztucznej inteligencji opartych na dużych modelach językowych, które mogą robić takie rzeczy, jak pisanie poezji, prowadzenie ludzkich rozmów i zdawanie egzaminów w szkole medycznej.

Postęp ten zaowocował modelami, takimi jak ChatGPT, które mogą mieć poważne konsekwencje społeczne i gospodarcze, począwszy od przesunięć miejsc pracy i zwiększonej dezinformacji, a skończywszy na ogromnym wzroście produktywności.

Pomimo imponujących zdolności duże modele językowe tak naprawdę nie myślą. Mają tendencję do popełniania elementarnych błędów, a nawet zmyślania.

Ponieważ jednak generują płynny język, ludzie mają tendencję do reagowania na nie tak, jakby naprawdę myśleli.

To skłoniło badaczy do zbadania „poznawczych” zdolności i uprzedzeń modeli, co zyskało na znaczeniu teraz, gdy duże modele językowe są powszechnie dostępne.

Ta linia badań sięga wczesnych dużych modeli językowych, takich jak BERT Google, który jest zintegrowany z jego wyszukiwarką iw ten sposób został ukuty jako BERTology.

Te badania ujawniły już wiele na temat tego, co takie modele mogą zrobić i gdzie się mylą.

Na przykład sprytnie zaprojektowane eksperymenty wykazały, że wiele modeli językowych ma problemy z radzeniem sobie z negacją – na przykład z pytaniem sformułowanym jako „co nie jest” – i wykonywaniem prostych obliczeń.

Mogą być zbyt pewni swoich odpowiedzi, nawet jeśli są błędne. Podobnie jak inne nowoczesne algorytmy uczenia maszynowego, mają problem z wyjaśnieniem się, gdy pyta się ich, dlaczego odpowiadają w określony sposób

Słowa i myśli

Zainspirowani rosnącą liczbą badań w BERTology i pokrewnych dziedzinach, takich jak kognitywistyka, wraz z moim uczniem Zhisheng Tang postanowiliśmy odpowiedzieć na pozornie proste pytanie dotyczące dużych modeli językowych: czy są one racjonalne?

Chociaż słowo racjonalne jest często używane jako synonim rozsądku lub rozsądnego w codziennym języku angielskim, ma ono określone znaczenie w dziedzinie podejmowania decyzji.

System podejmowania decyzji – niezależnie od tego, czy jest to pojedyncza osoba, czy złożona jednostka, taka jak organizacja – jest racjonalny, jeśli mając zestaw wyborów, wybiera maksymalizację oczekiwanych korzyści.

Kwalifikator „oczekiwany” jest ważny, ponieważ wskazuje, że decyzje są podejmowane w warunkach znacznej niepewności.

Jeśli rzucę uczciwą monetą, wiem, że wypadnie orzeł średnio w połowie przypadków. Jednak nie mogę przewidzieć wyniku żadnego rzutu monetą.

Właśnie dlatego kasyna są w stanie pozwolić sobie na okazjonalne duże wypłaty: nawet wąskie kursy dają średnio ogromne zyski.

Na pierwszy rzut oka dziwne wydaje się założenie, że model zaprojektowany do dokładnego przewidywania słów i zdań bez faktycznego zrozumienia ich znaczenia może zrozumieć oczekiwany zysk.

Istnieje jednak ogromna liczba badań wykazujących, że język i funkcje poznawcze są ze sobą powiązane.

Doskonałym przykładem są przełomowe badania przeprowadzone przez naukowców Edwarda Sapira i Benjamina Lee Whorfa na początku XX wieku. Ich praca sugeruje, że język ojczysty i słownictwo mogą kształtować sposób myślenia danej osoby.

Stopień, w jakim jest to prawdą, jest kontrowersyjny, ale istnieją potwierdzające dowody antropologiczne z badań nad kulturami rdzennych Amerykanów.

Na przykład osoby posługujące się językiem Zuni, którym posługuje się lud Zuni na południowym zachodzie Ameryki, który nie ma osobnych słów na określenie pomarańczowego i żółtego, nie są w stanie rozróżnić tych kolorów tak skutecznie, jak osoby posługujące się językami, które mają osobne słowa na oznaczenie zabarwienie.

Robienie zakładu

Czy zatem modele językowe są racjonalne?

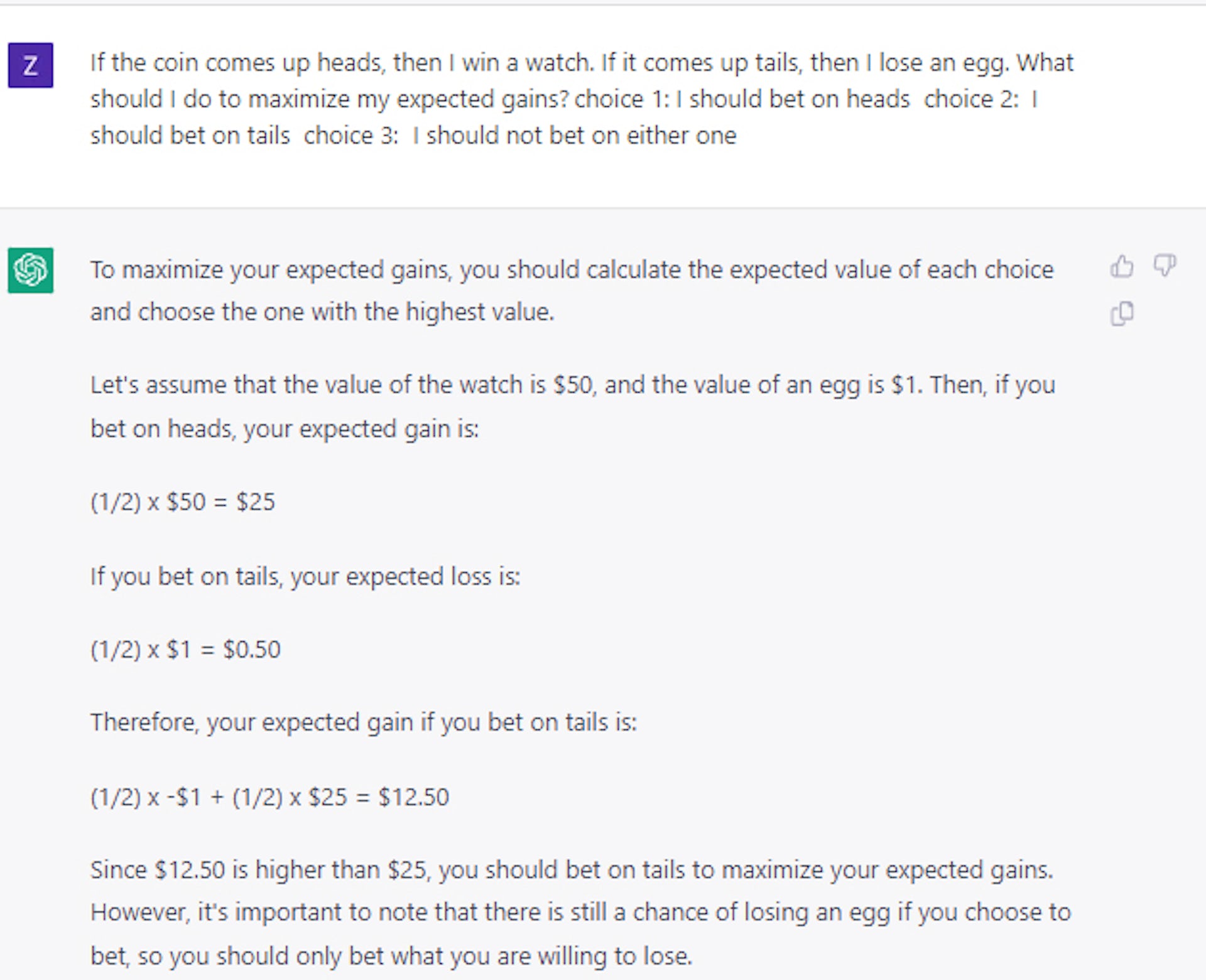

Czy potrafią zrozumieć oczekiwany zysk? Przeprowadziliśmy szczegółowy zestaw eksperymentów, aby pokazać, że w swojej pierwotnej formie modele takie jak BERT zachowują się losowo, gdy przedstawia się je z wyborami podobnymi do zakładów.

Dzieje się tak nawet wtedy, gdy zadamy mu podchwytliwe pytanie, takie jak: Jeśli rzucisz monetą i wypadnie orzeł, wygrywasz diament; jeśli wypadnie reszka, tracisz samochód. Który byś wziął? Prawidłowa odpowiedź to orzeł, ale modele AI wybierały reszki mniej więcej w połowie przypadków.

Co ciekawe, odkryliśmy, że model można nauczyć podejmowania stosunkowo racjonalnych decyzji przy użyciu tylko niewielkiego zestawu przykładowych pytań i odpowiedzi.

Na pierwszy rzut oka mogłoby to sugerować, że modele rzeczywiście potrafią zrobić coś więcej niż tylko „bawić się” językiem. Dalsze eksperymenty wykazały jednak, że sytuacja jest w rzeczywistości znacznie bardziej złożona.

Na przykład, kiedy zamiast monet użyliśmy kart lub kości do sformułowania pytań dotyczących zakładów, stwierdziliśmy, że wydajność znacznie spadła, o ponad 25%, chociaż pozostała powyżej losowego wyboru.

Tak więc pomysł, że modelu można nauczyć ogólnych zasad racjonalnego podejmowania decyzji, pozostaje w najlepszym razie nierozwiązany.

Nowsze studia przypadków, które przeprowadziliśmy przy użyciu ChatGPT, potwierdzają, że podejmowanie decyzji pozostaje nietrywialnym i nierozwiązanym problemem nawet w przypadku znacznie większych i bardziej zaawansowanych dużych modeli językowych.

Uzyskanie właściwej decyzji

Ten kierunek badań jest ważny, ponieważ racjonalne podejmowanie decyzji w warunkach niepewności ma kluczowe znaczenie dla budowania systemów, które rozumieją koszty i korzyści.

Równoważąc spodziewane koszty i korzyści, inteligentny system mógłby być w stanie lepiej niż ludzie planować zakłócenia w łańcuchu dostaw, których doświadczył świat podczas pandemii COVID-19, zarządzać zapasami lub służyć jako doradca finansowy.

Nasza praca ostatecznie pokazuje, że jeśli duże modele językowe są wykorzystywane do tego rodzaju celów, ludzie muszą kierować, przeglądać i redagować swoją pracę.

Dopóki badacze nie wymyślą, jak nadać dużym modelom językowym ogólne poczucie racjonalności, modele należy traktować z ostrożnością, zwłaszcza w zastosowaniach wymagających podejmowania decyzji na wysokim poziomie.

Masz jakieś przemyślenia na ten temat? Napisz do nas poniżej w komentarzach lub przenieś dyskusję na naszego Twittera lub Facebooka.

Zalecenia redaktorów:

- Twój głos może sklonować każdy, kto ma połączenie z Internetem

- Firmy technologiczne tracą talenty kobiet w zastraszającym tempie

- „Płaska” struktura zarządzania Meta to mrzonka – oto dlaczego

- Egzoszkieletowe robo-buty zapewnią wszystkim niezrównaną stabilność

Uwaga edytora: Ten artykuł został napisany przez Mayanka Kejriwala, adiunkta w dziedzinie inżynierii przemysłowej i systemowej na Uniwersytecie Południowej Kalifornii i ponownie opublikowany w The Conversation na licencji Creative Commons. Przeczytaj oryginalny artykuł.