Czy sztuczna inteligencja postaci zapisuje czaty i czy sztuczna inteligencja postaci jest bezpieczna?

Opublikowany: 2023-06-28Istnieje wiele alternatyw ChatGPT , a jedną z najpopularniejszych jest sztuczna inteligencja postaci, która pozwoli ci tworzyć własne chatboty i wchodzić w interakcje z innymi użytkownikami. Możesz nawet porozmawiać z chatbotem, który naśladuje celebrytę lub inną znaną osobę publiczną. Stało się tak popularne, że firma niedawno otrzymała wycenę na 1 miliard dolarów.

Sztuczna inteligencja postaci zapisuje rozmowy , chociaż istnieją poważne pytania, czy sztuczna inteligencja postaci jest bezpieczna. Wielu użytkowników Character AI angażuje się w rozmowy, które zawierają wysoce prywatne, wrażliwe i poufne informacje, a polityka prywatności sugeruje, że personel i programiści Character AI mogą w rzeczywistości monitorować to, co piszesz.

W tym przewodniku omawiamy wszystko, co musisz wiedzieć o sztucznej inteligencji postaci, abyś mógł podejmować świadome decyzje dotyczące treści rozmów z chatbotem. pokrywamy:

- Czy sztuczna inteligencja postaci zapisuje czaty?

- Polityka prywatności Character AI: Jakie dane zapisuje AI postaci?

- Czy sztuczna inteligencja postaci jest bezpieczna?

- Czy możesz prywatnie używać sztucznej inteligencji postaci?

- Dlaczego sztuczna inteligencja postaci jest taka wolna?

- Czy powinienem używać AI postaci?

Krótka odpowiedź brzmi: tak, sztuczna inteligencja postaci zapisze historię czatu i możesz wznowić rozmowę z dowolną postacią, z którą rozmawiałeś wcześniej.

Każdy czat, który zainicjujesz z postacią w Sztucznej Inteligencji postaci, teoretycznie może być dostępny i czytany przez pracowników firmy . Czaty AI postaci nie są szyfrowane, jak wiadomości wysyłane przez aplikacje, takie jak WhatsApp.

Wspomniano o tym w polityce prywatności AI postaci, którą omówimy bardziej szczegółowo w następnej sekcji.

Polityka prywatności Character AI: Jakie dane zapisuje AI postaci?

Podczas zakładania konta Character AI musisz podać istniejący adres e-mail i hasło. Następnie musisz potwierdzić swój adres e-mail i utworzyć nazwę użytkownika. Zgodnie z polityką prywatności firmy, inne informacje zbierane przez Character AI obejmują:

- Informacje dotyczące komunikacji (prośby o wsparcie itp.)

- Dane dziennika (adres IP, nazwa urządzenia itp.)

- Pliki cookie witryny (w tym trwałe pliki cookie)

- Informacje o użytkowaniu (jak korzystasz z usługi)

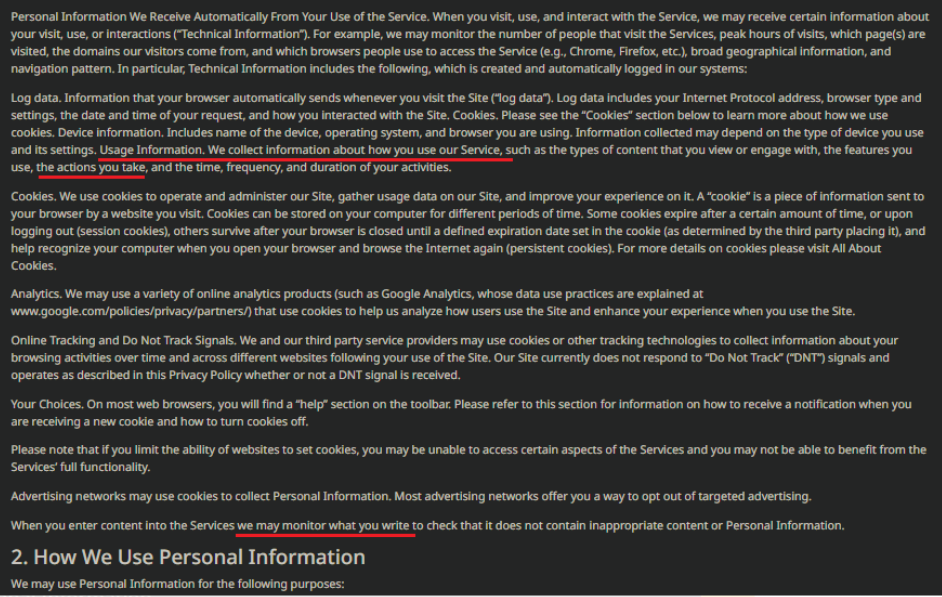

„Informacje o użytkowaniu” są tym, co AI postaci definiuje jako „informacje o tym, jak korzystasz z naszej usługi”. O dziwo, w przeciwieństwie do innych sekcji, jest to starannie schowane w akapicie „dane dziennika”, zamiast mieć własne miejsce w polityce prywatności.

Informacje o użytkowaniu obejmują „rodzaje treści, które przeglądasz lub z którymi się angażujesz, funkcje, z których korzystasz, podejmowane działania oraz czas, częstotliwość i czas trwania twoich działań”.

Postać AI mówi również, że „Kiedy wprowadzasz treści do Usług, możemy monitorować to, co piszesz, aby sprawdzić, czy nie zawiera nieodpowiednich treści lub Danych Osobowych”.

Sztuczna inteligencja postaci: myląca polityka prywatności?

Jest co najmniej kilka interesujących aspektów tej polityki prywatności. Ogólnie rzecz biorąc, zdecydowanie mogłoby być jaśniej.

Pierwszym z nich jest niejasny termin „działania, które podejmujesz” wymienione w informacjach o użytkowaniu. Nic nie wyjaśnia, co sztuczna inteligencja postaci rozumie przez „akcje”. Czy słowo „działania” odnosi się do czatów lub innych działań? Nie jest to od razu oczywiste.

Porównanie ich polityki prywatności z polityką prywatności ChatGPT pozostawiłoby wiele pytań dotyczących wykorzystania danych czatu przez sztuczną inteligencję postaci. W polityce prywatności Character AI:

- Nie określa wprost, czy szkolą boty przy użyciu danych czatu.

- Nie zawiera informacji o tym, czy personel jest szkolony z danymi czatu.

- Niewiele jest informacji na temat szyfrowania lub sposobu zabezpieczania danych czatu.

Wydaje się, że sztuczna inteligencja postaci klasyfikuje wszystkie wymienione kategorie informacji, które zbiera (dane dziennika, informacje o komunikacji, informacje o użytkowaniu) jako „dane osobowe”. Wszystkie są zawarte w sekcji polityki prywatności zatytułowanej „Dane osobowe, które zbieramy”, która zawiera również wiersz, w którym Character AI stwierdza, że może monitorować to, co piszesz.

Następnie w sekcji zatytułowanej „Jak wykorzystujemy dane osobowe” czytamy, że firma „może wykorzystywać dane osobowe do następujących celów… w celu utrzymania, ulepszenia lub naprawy dowolnego aspektu Usług, które mogą pozostać wewnętrzne lub mogą być udostępniane w razie potrzeby ze stronami trzecimi.”

Czy sztuczna inteligencja postaci jest bezpieczna?

Nie możemy powiedzieć z dużą dozą pewności, że sztuczna inteligencja postaci jest „bezpieczna”. Jest bardzo mało informacji publicznych na przykład na temat bezpieczeństwa serwera i sieci lub miejsca przechowywania informacji.

Użytkownik, który utworzył chatbota, nie może przeglądać czatów innych użytkowników z jego chatbotem, ale jak już opisaliśmy, personel Character AI może czytać dowolne czaty, które im się podobają, ponieważ nie są one szyfrowane. Należy o tym pamiętać podczas inicjowania czatów z chatbotami.

Jednak jeden użytkownik Reddit zgłosił w listopadzie, że „wystąpił błąd, w wyniku którego czaty ludzi losowo przeciekały do czatów innych osób”.

Tech.co nie było w stanie samodzielnie zweryfikować tego raportu, ale nawet ChatGPT miał problemy z ujawnianiem tytułów rozmów, więc nie jest to wykluczone.

Chociaż sztuczna inteligencja postaci stosuje rygorystyczne filtry NSFW, aby powstrzymać chatboty przed odpowiadaniem na nieodpowiednie żądania, istnieją doniesienia o postaciach wysyłających użytkownikom niesforne, brutalne i obraźliwe wiadomości.

Wydaje się to rzadkością, ale użytkownicy, którzy mogą znaleźć tego rodzaju treści, powinni uważać na charakter czatów, które inicjują z postaciami na stronie.

Wielu użytkowników próbuje ominąć filtry chatbota — petycja o utworzenie przełącznika NSFW dla witryny zgromadziła ponad 5000 podpisów.

(brak) ustawień bezpieczeństwa AI postaci

Niestety, Character AI nie zapewnia opcji uwierzytelniania dwu- lub wieloskładnikowego , co byłoby pomocną drugą linią bezpieczeństwa dla użytkowników (chociaż prawdopodobnie wymagałoby to dodania numeru telefonu do kont).

Co więcej, wymaga również od użytkowników tworzenia haseł o długości 6 znaków i nie ma żadnych reguł dotyczących znaków specjalnych — co jest dość niskim poziomem dla haseł.

Radzimy używać silnego, unikalnego i wystarczająco złożonego hasła do konta AI postaci, szczególnie jeśli wprowadzasz poufne lub prywatne dane do chatbota, czego zdecydowanie odradzamy, niezależnie od chatbota, z którego korzystasz za pomocą.

Czy możesz prywatnie używać sztucznej inteligencji postaci?

Jest rzeczą oczywistą, że tak naprawdę nie powinieneś wprowadzać prywatnych, wrażliwych lub innych poufnych informacji do żadnego chatbota AI — czy to Bard, ChatGPT, czy sztuczna inteligencja postaci.

Jednak w przeciwieństwie do ChatGPT, sztuczna inteligencja postaci nie pyta o numer telefonu podczas zakładania konta. Oznacza to, że można go używać w nieco bardziej prywatny sposób niż ChatGPT.

Sztuczna inteligencja postaci wymaga tylko adresu e-mail i hasła, aby się zarejestrować, więc jeśli masz obawy dotyczące prywatności związane z sztuczną inteligencją postaci, utworzenie adresu e-mail od podstaw, a następnie użycie VPN do zamaskowania adresu IP pomoże ci korzystać z usługi tak prywatnie, jak to możliwe.

Warto wiedzieć, że naruszysz Warunki korzystania z usługi, jeśli spróbujesz użyć VPN do obejścia blokady lub bana nałożonego przez witrynę na Twój adres IP.

Ale jak już powiedzieliśmy, to, co piszesz, może równie dobrze być monitorowane i nagrywane. W tym sensie nie można więc przeprowadzić prawdziwie prywatnej rozmowy z chatbotem AI postaci. To samo dotyczy ChatGPT.

Dlaczego sztuczna inteligencja postaci jest taka wolna?

Sztuczna inteligencja postaci może być powolna z kilku powodów.

Tak jak każda inna strona internetowa, jeśli AI postaci ma do czynienia ze znaczną liczbą zapytań do swoich serwerów (innymi słowy, wiele osób używa chatbotów), może to spowolnić. Nie byłoby w tym nic dziwnego, biorąc pod uwagę, że aplikacja mobilna została pobrana 1,7 miliona razy w tygodniu następującym po jej wydaniu.

Może również nie działać z powodu konserwacji lub problemów technicznych. Niestety niewiele możesz zrobić, aby to zmienić — ale możesz sprawdzić stan serwera witryny, jeśli chcesz wiedzieć, czy serwer nie działa.

Jeśli sztuczna inteligencja postaci działa dobrze, problemem może być twoje urządzenie lub połączenie internetowe. Jeśli sztuczna inteligencja postaci działa tak wolno, że jest trudna w użyciu, najpierw przetestuj swoje połączenie internetowe. Może wymagać prostego ponownego uruchomienia, aby ponownie zacząć działać.

Jeśli korzystasz z VPN , usługi proxy lub innego narzędzia, które może mieć wpływ na łączenie urządzenia z Internetem, zalecamy rozłączenie i ponowne nawiązanie połączenia — po prostu zamknij najpierw otwarte okna przeglądarki.

Czy powinienem używać AI postaci?

Sztuczna inteligencja postaci to dziwaczny chatbot, z którym możesz się dobrze bawić. Jednak, jak prawdopodobnie można stwierdzić po przeczytaniu tego artykułu, zaleca się podjęcie pewnych środków ostrożności podczas korzystania z niego, aby zapewnić sobie bezpieczeństwo. Obejmują one:

- Używanie długiego, złożonego i unikalnego hasła do konta.

- Nie wprowadzanie poufnych danych do sztucznej inteligencji postaci.

- Nieużywanie służbowego adresu e-mail ani innych informacji podczas rejestracji.

- Pamiętaj, że personel AI postaci może monitorować twoje czaty.

Zalecamy przestrzeganie tych samych środków ostrożności podczas korzystania z ChatGPT lub Bard , a także z każdym innym popularnym chatbotem. Mogą być sprytne i przydatne, ale powierzenie im prywatnych danych po prostu nie jest warte ryzyka.