Por que os chatbots de terapia de IA são o maior dilema ético

Publicados: 2023-10-31Chatbots de IA generativos, como o ChatGPT, estão sendo usados para agilizar processos no local de trabalho, escrever códigos e até mesmo escrever roteiros para sets de comédia stand-up. Nos EUA, onde os casos de ansiedade e depressão atingem níveis recordes e o apoio profissional continua limitado, não é surpresa que os utilizadores também utilizem a tecnologia para ajudar a gerir a sua saúde mental.

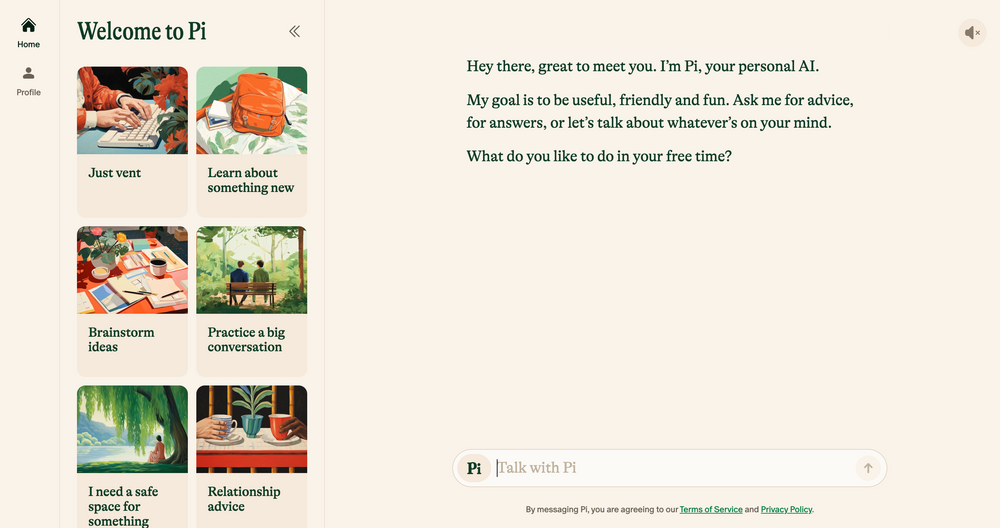

Chatbots de IA como Elomia, Pi e Woebot oferecem suporte personalizado e acessível 24 horas por dia, 7 dias por semana, com base em técnicas de terapia testadas e comprovadas. Desde ajudar os usuários a evitar longas listas de espera até reduzir o estigma em torno do acesso à ajuda, seus benefícios são enormes. Poderá a IA generativa – que ainda é propensa a erros, alucinações e preconceitos – comparar-se à empatia do ouvido humano?

Conversamos com acadêmicos, psicólogos e terapeutas praticantes para esclarecer como a tecnologia emergente provavelmente moldará o futuro da terapia. Também discutimos o lado mais sombrio da terapia de IA e identificamos quais questões éticas precisam ser abordadas hoje. Aqui está o que encontramos.

AI Chatbots: a nova geração de robôs terapeutas

Desde que o chatbot ChatGPT da OpenAI foi lançado em novembro passado, um exército de imitadores de chatbots surgiu nas lojas de aplicativos – desde aplicativos de uso geral como Google Bard e Claude AI até simuladores de personagens Marvel menos convencionais.

Este mercado em expansão também levou ao surgimento de chatbots de terapia de IA – aplicações que utilizam IA generativa para imitar conselhos e orientações oferecidos por terapeutas qualificados e profissionais de saúde mental.

Quer navegar na web com privacidade? Ou parecer que você está em outro país?

Quer navegar na web com privacidade? Ou parecer que você está em outro país?

Obtenha um grande desconto de 86% no Surfshark com esta oferta da Tech.co Black Friday. ![]()

Os principais exemplos incluem Pi, um autoproclamado “companheiro de bate-papo amigável” que atua como caixa de ressonância e oferece apoio emocional; Replika, um programa de chatbot que imita o estilo de fala e a personalidade de seus usuários; e Earkick, um rastreador de ansiedade projetado para ajudá-lo a registrar e lidar com emoções difíceis.

“As plataformas baseadas em IA oferecem privacidade, reduzindo o estigma frequentemente associado à procura de ajuda para problemas de saúde mental.” – Ryan Sultan, psiquiatra certificado e professor da Universidade de Columbia

Como os melhores aplicativos de saúde mental , muitos desses aplicativos já possuem downloads de seis dígitos – e sua popularidade não surpreende. Devido à escassez de psicólogos, psiquiatras e assistentes sociais qualificados, além de um aumento na procura de serviços em todo o país, os EUA enfrentam actualmente uma das piores crises de saúde mental de que há registo.

O elevado custo da terapia tradicional e os tabus em torno da saúde mental também estão a dissuadir muitos de prosseguirem opções convencionais, criando uma lacuna para alternativas mais discretas e acessíveis.

As primeiras evidências sugerem que eles também são eficazes. As próprias descobertas do Earkick do AI Chatbot revelaram que o humor do usuário melhorou 34% e os níveis de ansiedade caíram 32% depois de usar o aplicativo por cinco meses. No entanto, por mais bem-sucedidos que esses aplicativos possam ter em suprimir pequenas ansiedades, eles definitivamente não são a panacéia para a saúde mental que todos esperávamos.

AI Chatbots inadequados para condições graves de saúde mental

Receber conselhos sensatos e aprovados por terapeutas de um chatbot de bolso será, sem dúvida, útil para muitos. No entanto, aqueles que sofrem de problemas graves de saúde mental, como depressão, esquizofrenia e transtorno bipolar, provavelmente ficarão em desvantagem.

Os transtornos mentais são complexos, com muitas nuances e únicos para cada pessoa que afetam. Em alguns casos, são melhor tratados com medicamentos que só podem ser prescritos corretamente por profissionais médicos qualificados. Embora os grandes modelos de linguagem (LLMs) tenham evoluído a passos largos nos últimos anos, a sua produção nunca será capaz de substituir a experiência clínica, a empatia e a compaixão fornecidas por psiquiatras, psicólogos e terapeutas.

“Agradeço que os algoritmos tenham melhorado, mas, em última análise, não creio que eles vão abordar as realidades sociais mais confusas em que as pessoas enfrentam quando procuram ajuda” – Julia Brown, professora de antropologia da Universidade da Califórnia, São Francisco

O curandeiro psíquico estratégico Aanant Bisht também acredita que a IA, em seu estado atual, será incapaz de ajudar na complexa jornada de cura de cada usuário. “Também é essencial evitar a simplificação excessiva de problemas complexos de saúde mental e incentivar os usuários a procurar ajuda profissional quando necessário”, disse Bisht ao Tech.co.

Outra preocupação comum expressada pelos especialistas com quem conversamos é o diagnóstico médico incorreto. A comunidade de saúde mental tem um problema de longa data com a identificação correta de transtornos psiquiátricos complexos e graves, e a forte dependência da IA poderia provavelmente exacerbar este problema, devido às tecnologias limitadas, aos conjuntos de dados não representativos e à incapacidade de interpretar as nuances humanas.

Os resultados disso também podem ser nítidos. O diagnóstico incorreto de saúde mental muitas vezes leva a tratamento e apoio inadequados, pressões mentais adicionais e ceticismo de longo prazo em relação ao sistema médico. Esta não é a única razão pela qual a inteligência artificial não está apta a ultrapassar a cadeira do terapeuta na sua forma atual.

A IA é falha e envolta em desafios éticos

A rápida ascensão da IA generativa não veio sem consequências. À medida que a tecnologia continua a desenvolver-se a uma velocidade vertiginosa, a regulamentação em torno da sua utilização tem sido lenta a recuperar, contribuindo para uma série de desafios éticos relacionados com a privacidade dos dados, preconceitos incorporados e utilização indevida.

Estas preocupações não são exclusivas da terapia, mas a natureza sensível da saúde mental significa que os enquadramentos éticos estão no centro de qualquer boa relação terapêutica. Com um código de ética oficial de IA atualmente inexistente, os usuários que dependem de chatbots em vez de profissionais qualificados para aconselhamento ou outro suporte de saúde mental são altamente problemáticos.

A privacidade dos dados é uma questão importante. Chatbots como o ChatGPT frequentemente caem em maus lençóis por não protegerem os dados do usuário . Para que os usuários se sintam confortáveis ao discutir informações pessoais e privadas, as empresas de IA precisarão ter uma estratégia de proteção de dados infalível que priorize a confidencialidade.

“A natureza íntima e sensível das conversas terapêuticas exige um nível incomparável de proteção de dados.” – Dr. Langham, psicólogo da Impuls Therapy

Outro fator importante a ser observado é o viés do aprendizado de máquina. Todos os sistemas de IA dependem de dados de treino predeterminados, que muitas vezes incluem preconceitos humanos incorporados, mesmo que variáveis sensíveis como raça e género sejam removidas.

De acordo com Bayu Prihandito, CEO da empresa de coaching de vida Life Architekture , se a IA for treinada com base em dados tendenciosos, “pode perpetuar ou exacerbar os preconceitos existentes, levando a recomendações de tratamento injustas”. É provável que estes preconceitos intrínsecos tenham também um maior impacto nas pessoas de grupos minoritários, destacando a importância da supervisão humana e de conjuntos de dados de formação diversificados e representativos.

IA como assistente de terapeutas, não como substituto

Companheiros amigáveis como Pi e Woebot só crescerão em popularidade à medida que os usuários continuarem a buscar maneiras acessíveis de complementar seu bem-estar mental. No entanto, devido a uma ampla gama de preocupações éticas, a inteligência artificial não está pronta para substituir o papel da terapia tradicional, nem deveria nunca.

Isso não quer dizer que a tecnologia emergente não terá um impacto enorme na prática como um todo. A maioria dos profissionais com quem falamos acredita que, ao realizar o trabalho pesado, como a triagem, as ferramentas de IA serão capazes de dar-lhes mais tempo e energia para investir em outras áreas da prática.

“Embora não possa substituir a profunda conexão humana que os terapeutas oferecem, pode servir como uma ferramenta complementar.” – Aanant Bish, treinador psíquico de negócios

“A IA poderia lidar com avaliações iniciais, monitoramento contínuo e fornecer suporte para casos menos complexos, permitindo-nos focar em situações mais graves ou delicadas”, disse Bayu Prihandito ao Tech.co, acrescentando “ É como ter um par extra de mãos que estão sempre disponível."

O professor de Columbia e psiquiatra certificado Sultan concorda, dizendo ao Tech.co que dentro de cinco anos, a IA provavelmente complementará a terapia tradicional , simplificando as tarefas administrativas, ajudando os profissionais a criar planos de tratamento mais personalizados e “ criando modelos híbridos que combinam a experiência humana com a IA- ferramentas orientadas para melhorar o tratamento”.

Isto sugere que, longe de esgotar a humanidade da prática, a IA tem, na verdade, o poder de libertar competências humanas como empatia, ligação e compaixão, ajudando os clientes a tirar ainda mais partido do serviço.

No entanto, cuidar da saúde mental é algo sério e muitas vezes pode ser uma questão de vida ou morte. Antes que a IA se torne assistente de todos os terapeutas, ou mesmo os substitua, é necessário considerar regulamentos rigorosos em torno da sua implantação e utilização.

Até que esse momento chegue, o claro potencial dos chatbots de IA para melhorar o acesso ao apoio à saúde mental não pode ser totalmente conciliado com os riscos que representam. Num mundo onde os dilemas éticos são muitas vezes normais, este é simplesmente grande demais para ser ignorado.