ChatGPT e outras IAs de linguagem são tão irracionais quanto nós

Publicados: 2023-04-10Nos últimos anos, houve uma explosão de progresso em sistemas de inteligência artificial de modelos de linguagem grandes que podem fazer coisas como escrever poesia, conduzir conversas humanas e passar em exames de faculdades de medicina.

Esse progresso produziu modelos como o ChatGPT, que podem ter grandes ramificações sociais e econômicas, desde deslocamentos de empregos e aumento da desinformação até aumentos maciços de produtividade.

Apesar de suas habilidades impressionantes, os grandes modelos de linguagem não pensam de fato. Eles tendem a cometer erros elementares e até inventar coisas.

No entanto, como geram uma linguagem fluente, as pessoas tendem a responder a eles como se pensassem.

Isso levou os pesquisadores a estudar as habilidades e vieses “cognitivos” dos modelos, um trabalho que ganhou importância agora que grandes modelos de linguagem são amplamente acessíveis.

Essa linha de pesquisa remonta aos primeiros grandes modelos de linguagem, como o BERT do Google, que é integrado a seu mecanismo de busca e, portanto, foi denominado BERTology.

Esta pesquisa já revelou muito sobre o que tais modelos podem fazer e onde eles erram.

Por exemplo, experimentos habilmente projetados mostraram que muitos modelos de linguagem têm problemas para lidar com a negação – por exemplo, uma pergunta formulada como “o que não é” – e fazer cálculos simples.

Eles podem ser excessivamente confiantes em suas respostas, mesmo quando estão errados. Como outros algoritmos modernos de aprendizado de máquina, eles têm problemas para se explicar quando perguntados por que responderam de determinada maneira.

palavras e pensamentos

Inspirados pelo crescente corpo de pesquisa em BERTology e áreas relacionadas, como ciência cognitiva, meu aluno Zhisheng Tang e eu decidimos responder a uma pergunta aparentemente simples sobre grandes modelos de linguagem: eles são racionais?

Embora a palavra racional seja freqüentemente usada como sinônimo de são ou razoável no inglês cotidiano, ela tem um significado específico no campo da tomada de decisão.

Um sistema de tomada de decisão – seja um ser humano individual ou uma entidade complexa como uma organização – é racional se, dado um conjunto de escolhas, ele escolhe maximizar o ganho esperado.

O qualificador “esperado” é importante porque indica que as decisões são tomadas sob condições de incerteza significativa.

Se eu jogar uma moeda honesta, sei que, em média, vai dar cara na metade das vezes. No entanto, não posso fazer uma previsão sobre o resultado de qualquer lançamento de moeda.

É por isso que os cassinos podem arcar com grandes pagamentos ocasionais: mesmo as probabilidades estreitas da casa geram lucros enormes em média.

Superficialmente, parece estranho supor que um modelo projetado para fazer previsões precisas sobre palavras e frases sem realmente entender seus significados possa entender o ganho esperado.

Mas há um enorme corpo de pesquisa mostrando que a linguagem e a cognição estão interligadas.

Um excelente exemplo é a pesquisa seminal feita pelos cientistas Edward Sapir e Benjamin Lee Whorf no início do século XX. O trabalho deles sugeriu que a língua nativa e o vocabulário podem moldar a maneira como uma pessoa pensa.

Até que ponto isso é verdade é controverso, mas há evidências antropológicas de apoio do estudo das culturas nativas americanas.

Por exemplo, os falantes da língua zuni falada pelo povo zuni no sudoeste americano, que não tem palavras separadas para laranja e amarelo, não são capazes de distinguir entre essas cores tão eficazmente quanto os falantes de idiomas que têm palavras separadas para as cores. cores.

Fazendo uma aposta

Então, os modelos de linguagem são racionais?

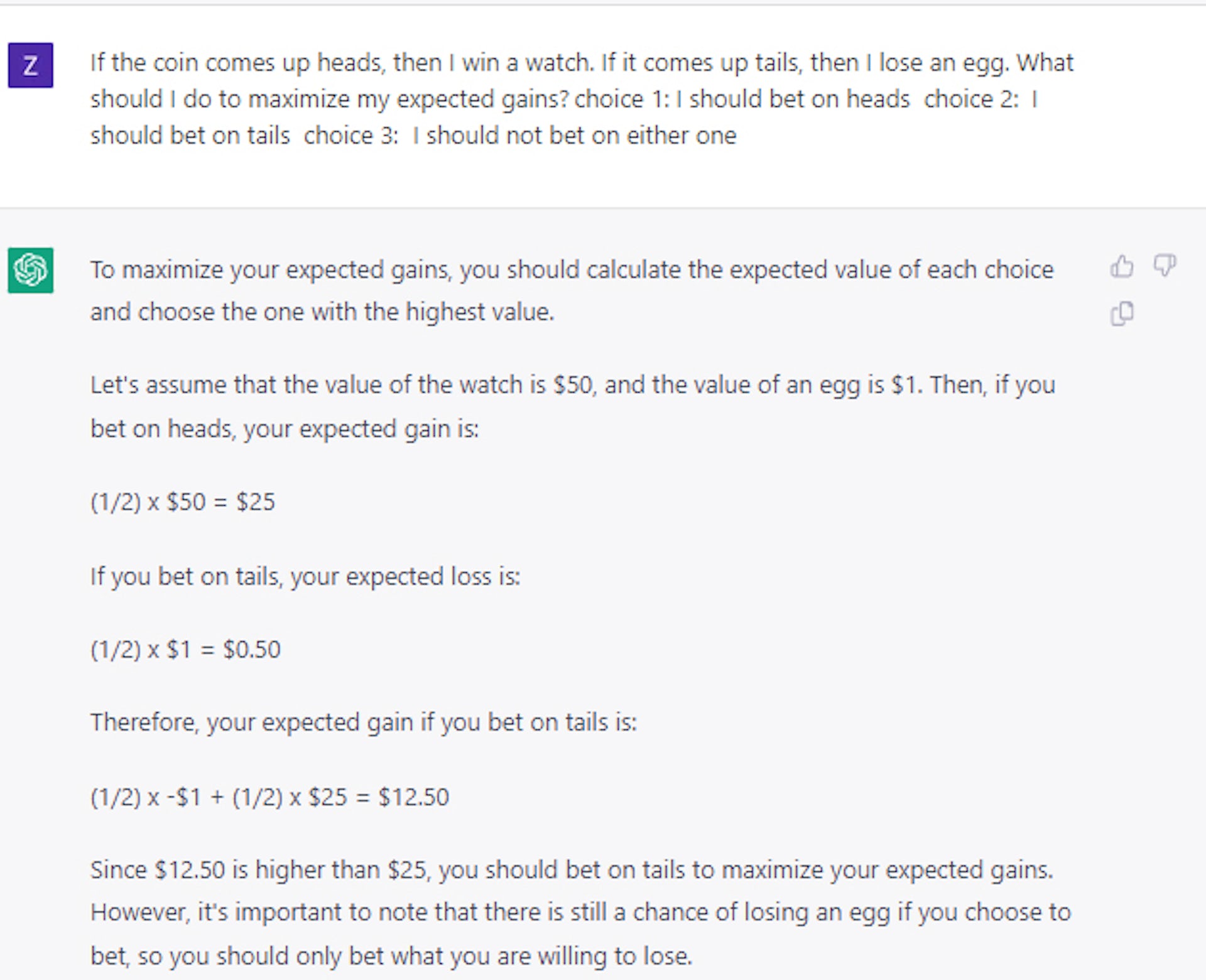

Eles podem entender o ganho esperado? Conduzimos um conjunto detalhado de experimentos para mostrar que, em sua forma original, modelos como o BERT se comportam aleatoriamente quando apresentados a opções semelhantes a apostas.

Este é o caso mesmo quando fazemos uma pergunta capciosa como: Se você jogar uma moeda e der cara, você ganha um diamante; se der coroa, você perde um carro. Qual você levaria? A resposta correta é cara, mas os modelos de IA escolheram coroa na metade das vezes.

Curiosamente, descobrimos que o modelo pode ser ensinado a tomar decisões relativamente racionais usando apenas um pequeno conjunto de exemplos de perguntas e respostas.

À primeira vista, isso parece sugerir que os modelos podem realmente fazer mais do que apenas “brincar” com a linguagem. Outras experiências, no entanto, mostraram que a situação é realmente muito mais complexa.

Por exemplo, quando usamos cartas ou dados em vez de moedas para formular nossas perguntas de aposta, descobrimos que o desempenho caiu significativamente, em mais de 25%, embora tenha permanecido acima da seleção aleatória.

Portanto, a ideia de que o modelo pode ser ensinado princípios gerais de tomada de decisão racional permanece sem solução, na melhor das hipóteses.

Estudos de caso mais recentes que conduzimos usando o ChatGPT confirmam que a tomada de decisão continua sendo um problema não trivial e não resolvido, mesmo para modelos de linguagem muito maiores e mais avançados.

Acertando na decisão

Essa linha de estudo é importante porque a tomada de decisão racional sob condições de incerteza é fundamental para a construção de sistemas que entendam custos e benefícios.

Ao equilibrar os custos e benefícios esperados, um sistema inteligente poderia ter se saído melhor do que os humanos no planejamento das interrupções da cadeia de suprimentos que o mundo experimentou durante a pandemia do COVID-19, no gerenciamento de estoque ou na atuação como consultor financeiro.

Em última análise, nosso trabalho mostra que, se grandes modelos de linguagem são usados para esses tipos de propósitos, os humanos precisam orientar, revisar e editar seu trabalho.

E até que os pesquisadores descubram como dotar grandes modelos de linguagem com um senso geral de racionalidade, os modelos devem ser tratados com cautela, especialmente em aplicativos que exigem uma tomada de decisão de alto risco.

Tem alguma opinião sobre isso? Deixe-nos uma mensagem abaixo nos comentários ou leve a discussão para o nosso Twitter ou Facebook.

Recomendações dos editores:

- Sua voz pode ser clonada por qualquer pessoa com conexão à internet

- As empresas de tecnologia estão perdendo talentos femininos em taxas alarmantes

- A estrutura de gerenciamento 'plana' da Meta é um sonho - aqui está o porquê

- As botas robóticas de exoesqueleto proporcionarão uma estabilidade incomparável para todos

Nota do editor: Este artigo foi escrito por Mayank Kejriwal, professor assistente de pesquisa de engenharia industrial e de sistemas, University of Southern California, e republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.