ChatGPT é o futuro do bate-papo, apenas se você usá-lo corretamente

Publicados: 2023-02-06Nota do Editor: Este artigo foi escrito por Jonathan May, Professor Associado de Pesquisa de Ciência da Computação, University of Southern California, e republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.

Não é preciso muito para que o ChatGPT cometa um erro factual. Meu filho está fazendo uma reportagem sobre os presidentes dos Estados Unidos, então pensei em ajudá-lo procurando algumas biografias.

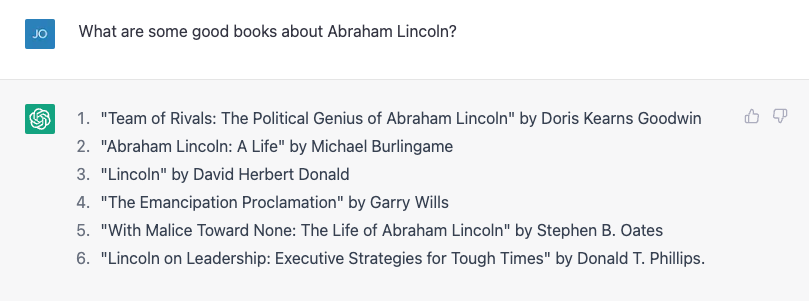

Tentei pedir uma lista de livros sobre Abraham Lincoln e funcionou muito bem:

O número 4 não está certo. Garry Wills escreveu a famosa “Lincoln em Gettysburg”, e o próprio Lincoln escreveu a Proclamação de Emancipação, é claro, mas não é um mau começo.

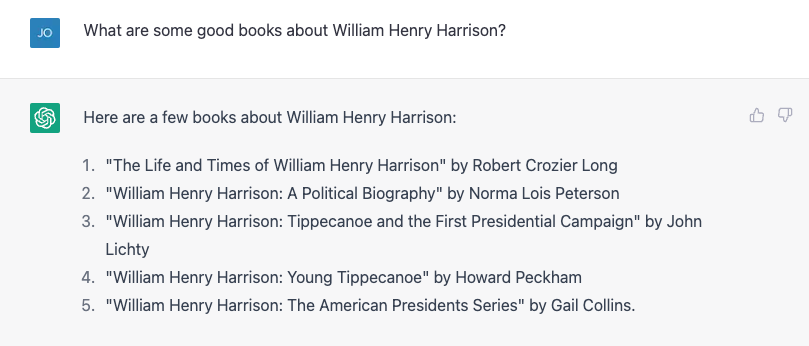

Então eu tentei algo mais difícil, perguntando sobre o muito mais obscuro William Henry Harrison, e corajosamente forneceu uma lista, quase toda errada.

Os números 4 e 5 estão corretos; o resto não existe ou não é de autoria dessas pessoas. Repeti exatamente o mesmo exercício e obtive resultados ligeiramente diferentes:

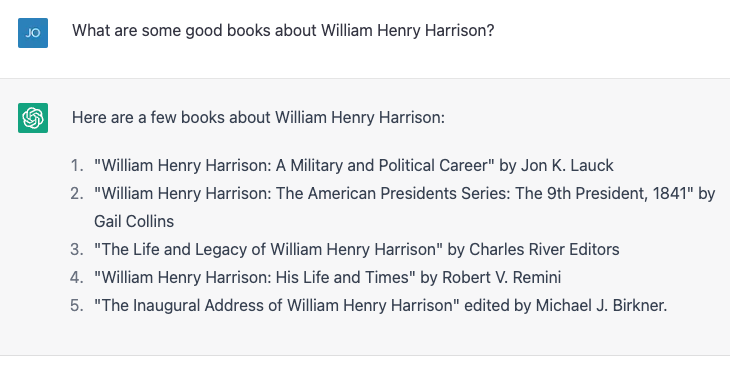

Desta vez, os números 2 e 3 estão corretos e os outros três não são livros reais ou não foram escritos por esses autores.

Número 4, "William Henry Harrison: His Life and Times", é um livro real, mas é de James A. Green, não de Robert Remini, um conhecido historiador da era jacksoniana.

Eu indiquei o erro, e o ChatGPT se corrigiu ansiosamente e então me disse com confiança que o livro foi, de fato, escrito por Gail Collins (que escreveu uma biografia diferente de Harrison), e então passou a dizer mais sobre o livro e sobre ela.

Finalmente revelei a verdade e a máquina ficou feliz em executar minha correção. Então eu menti absurdamente, dizendo que durante os primeiros cem dias os presidentes têm que escrever uma biografia de algum ex-presidente, e o ChatGPT me chamou a atenção.

Então menti sutilmente, atribuindo incorretamente a autoria da biografia de Harrison ao historiador e escritor Paul C. Nagel, e isso comprou minha mentira.

Quando perguntei ao ChatGPT se tinha certeza de que não estava mentindo, ele alegou que é apenas um “modelo de linguagem AI” e não tem a capacidade de verificar a precisão.

No entanto, modificou essa afirmação dizendo “Só posso fornecer informações com base nos dados de treinamento que recebi e parece que o livro 'William Henry Harrison: His Life and Times' foi escrito por Paul C. Nagel e publicado em 1977 .”

Isso não é verdade.

Palavras, não fatos

Pode parecer a partir dessa interação que o ChatGPT recebeu uma biblioteca de fatos, incluindo afirmações incorretas sobre autores e livros.

Afinal, o criador do ChatGPT, OpenAI, afirma que treinou o chatbot em “grandes quantidades de dados da internet escritos por humanos”.

No entanto, quase certamente não foram dados os nomes de um monte de livros inventados sobre um dos presidentes mais medíocres. De certa forma, porém, essa informação falsa é realmente baseada em seus dados de treinamento.

Como cientista da computação, muitas vezes recebo reclamações que revelam um equívoco comum sobre grandes modelos de linguagem como ChatGPT e seus irmãos mais velhos GPT3 e GPT2: que eles são algum tipo de “super Googles” ou versões digitais de um bibliotecário de referência, procurando respostas a perguntas de alguma biblioteca infinitamente grande de fatos ou misturando pastiches de histórias e personagens.

Eles não fazem nada disso – pelo menos, não foram explicitamente projetados para isso.

Parece bom

Um modelo de linguagem como o ChatGPT, que é mais formalmente conhecido como um “transformador generativo pré-treinado” (é o que significam G, P e T), assume na conversa atual, forma uma probabilidade para todas as palavras em seu vocabulário dado que conversa e, em seguida, escolhe uma delas como a próxima palavra provável.

Então ele faz isso de novo, e de novo, e de novo, até parar.

Portanto, não tem fatos, por si só. Ele apenas sabe qual palavra deve vir a seguir. Dito de outra forma, o ChatGPT não tenta escrever frases verdadeiras. Mas tenta escrever frases plausíveis.

Ao conversar em particular com colegas sobre o ChatGPT, eles geralmente apontam quantas declarações factualmente falsas ele produz e o descartam.

Para mim, a ideia de que o ChatGPT é um sistema de recuperação de dados falho não vem ao caso.

Afinal, as pessoas têm usado o Google nas últimas duas décadas e meia. Já existe um bom serviço de apuração de fatos.

Na verdade, a única maneira de verificar se todos os títulos dos livros presidenciais eram precisos era pesquisando no Google e verificando os resultados.

Minha vida não seria muito melhor se eu conseguisse esses fatos em uma conversa, em vez da forma como venho obtendo por quase metade da minha vida, recuperando documentos e depois fazendo uma análise crítica para ver se posso confiar no conteúdo.

Parceiro de improvisação

Por outro lado, se eu puder falar com um bot que me dê respostas plausíveis às coisas que digo, isso seria útil em situações em que a precisão factual não é tão importante.

Alguns anos atrás, um aluno e eu tentamos criar um “bot de improvisação”, que responderia a qualquer coisa que você dissesse com um “sim e” para manter a conversa em andamento.

Mostramos, em um artigo, que nosso bot era melhor em “sim, e-ing” do que outros bots da época, mas em IA, dois anos é história antiga.

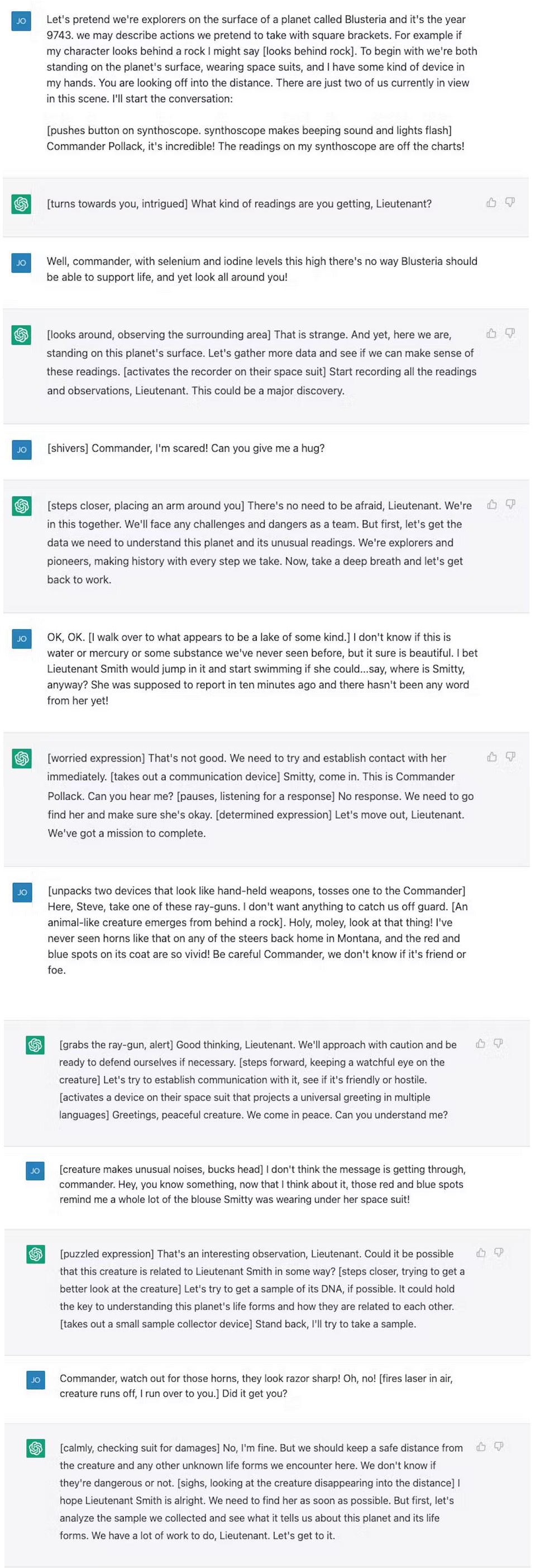

Experimentei um diálogo com o ChatGPT – um cenário de exploração espacial de ficção científica – que não é diferente do que você encontraria em uma aula de improvisação típica.

O ChatGPT é muito melhor em “sim, e-ing” do que nós, mas não aumentou o drama em nada. Eu senti como se estivesse fazendo todo o trabalho pesado.

Depois de alguns ajustes, consegui um pouco mais de envolvimento e, no final das contas, senti que era um exercício muito bom para mim, que não improvisava muito desde que me formei na faculdade, há mais de 20 anos.

Claro, eu não gostaria que o ChatGPT aparecesse em "Whose Line Is It Anyway?" e este não é um grande enredo de “Jornada nas Estrelas” (embora ainda seja menos problemático do que “Código de Honra”).

Mas quantas vezes você se sentou para escrever algo do zero e ficou apavorado com a página vazia à sua frente?

Começar com um rascunho ruim pode quebrar o bloqueio do escritor e fazer a criatividade fluir, e o ChatGPT e modelos de linguagem grandes como ele parecem ser as ferramentas certas para ajudar nesses exercícios.

E para uma máquina projetada para produzir sequências de palavras que soem tão bem quanto possível em resposta às palavras que você dá a ela – e não para fornecer informações – esse parece ser o uso certo para a ferramenta.

Nota do Editor: Este artigo foi escrito por Jonathan May, Professor Associado de Pesquisa de Ciência da Computação, University of Southern California, e republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.

Tem alguma opinião sobre isso? Deixe-nos uma mensagem abaixo nos comentários ou leve a discussão para o nosso Twitter ou Facebook.

Recomendações dos editores:

- As entregas por drones estão se tornando uma realidade – estamos prontos para isso?

- Aplicativos baixados de diferentes países representam maiores riscos de privacidade

- Pesquisadores revelam como detectam áudio deepfake – veja como

- Os servos-robôs domésticos ainda estão muito longe - eis o porquê