Dos dados aos insights: automatizando a coleta de dados online em grande escala

Publicados: 2024-11-18Só para avisar, se você comprar algo por meio de nossos links, poderemos receber uma pequena parte da venda. É uma das maneiras de mantermos as luzes acesas aqui. Clique aqui para mais informações.

Para superar seus concorrentes, você precisa saber como está o desempenho deles.

Para entregar produtos e serviços que seu público-alvo utilizará, você deve saber o que eles procuram. Para prever as tendências do mercado, você precisa conhecer as condições atuais do mercado.

Quaisquer que sejam suas metas e objetivos, se você deseja que seu negócio prospere, você precisa de acesso a dados relevantes, oportunos e de alta qualidade.

Afinal, é somente com dados precisos que você pode gerar insights para ajudá-lo a tomar melhores decisões baseadas em dados.

Embora a qualidade dos dados seja crítica, a quantidade não deve ser desconsiderada. Felizmente, você pode automatizar a coleta de dados em grande escala e aproveitar ambos os benefícios com ferramentas como a API Scraper. Saiba mais abaixo.

A importância da coleta de dados para as empresas

A coleta de dados é essencial para empresas de todos os tamanhos, ajudando você a acelerar a expansão dos negócios e a melhorar seus processos de tomada de decisão.

Ele oferece uma série de benefícios que podem ajudar a preparar sua empresa para o futuro:

- Melhora a geração de leads;

- Melhora a retenção de clientes;

- Minimiza riscos;

- Prevê a demanda;

- Melhora a compreensão do comportamento do cliente;

- Prevê a atividade do concorrente;

- Melhora as estratégias de marketing;

- Desbloqueia oportunidades de crescimento.

Sem dados relevantes, qualquer decisão que você tomar será simplesmente baseada em sua intuição, expondo-o a riscos desnecessários e aumentando suas chances de fracasso.

Por meio da coleta abrangente de dados e da análise minuciosa, você pode obter insights valiosos para impulsionar seu desempenho e garantir seu sucesso.

Usando web scraping para agilizar processos de coleta de dados

Embora existam inúmeros métodos de coleta de dados, incluindo entrevistas e grupos focais, pesquisas e formulários, a extração de dados on-line oferece acesso aos maiores volumes de dados.

A extração de dados online é o processo de visitar todos os sites relevantes do seu setor e coletar todos os pontos de dados de que sua empresa precisa.

Você pode coletar estatísticas criteriosas de sites de alta autoridade em seu nicho, avaliações de usuários de sites de terceiros, informações de preços de sites de concorrentes e muito mais.

Nos próximos anos, espera-se que a criação global de dados cresça para mais de 180 zettabytes, dando acesso a muitas fontes e volumes de dados abundantes.

O único problema é que coletar manualmente todos os dados necessários pode ser uma tarefa maior do que você pode mastigar.

Para coleta de dados on-line em grande escala, você precisará automatizar seus processos e, felizmente, pode fazer isso facilmente por meio de web scraping.

Web scraping envolve o uso de bots scraper para extração de dados.

Tudo o que você precisa fazer é programar esses bots para rastrear qualquer página da web que você precisar, especificar o tipo de dados que deseja extrair e definir seu formato de extração preferido. A partir daí, eles cuidam de todo o resto.

Os web scrapers podem rastrear centenas de páginas da web praticamente em nenhum momento, oferecendo a máxima velocidade e eficiência.

Eles eliminam riscos de erro humano, minimizam despesas e fornecem resultados precisos e de alta qualidade assim que você precisar deles.

As duas principais ferramentas de web scraping

Ao escolher web scrapers para coleta e extração de dados, você terá várias opções – mais notavelmente, web scrapers tradicionais, como Scraper API ou no-code scrapers.

Ambos têm prós e contras exclusivos que podem ajudá-lo a determinar a melhor solução.

Os web scrapers tradicionais exigem habilidades de codificação, pois você precisará interagir com eles por meio de uma linguagem programática.

No entanto, sua velocidade, eficiência, capacidade de lidar com tecnologia anti-bot, páginas da web dinâmicas, personalização e muito mais os diferenciam dos raspadores sem código.

Prós dos web scrapers tradicionais:

- Flexível;

- Eficiente;

- Customizável.

Contras do web scraper tradicional:

- Exigir habilidades de codificação;

Devido à extensa codificação necessária, os web scrapers tradicionais são mais adequados para empresas que exigem raspagem em grande escala.

São ferramentas potentes, mas exigirão investimentos de tempo mais significativos.

A boa notícia é que eles podem ser facilmente integrados à infraestrutura existente e são perfeitamente personalizáveis para atender às suas necessidades específicas.

Os raspadores sem código geralmente são muito mais simples de usar.

Como o nome sugere, eles não exigem habilidades de codificação de sua parte. Eles são totalmente automatizados desde o início e você pode começar a usá-los imediatamente.

Prós do raspador sem código:

- Totalmente automatizado;

- Não requer habilidades de codificação;

- Sem manutenção.

Contras do raspador sem código:

- Não personalizável;

Devido à sua facilidade de uso, os raspadores sem código geralmente são mais adequados para indivíduos e pequenas empresas sem grandes necessidades de coleta de dados.

Embora possam ser eficientes em menor escala, podem se tornar limitantes à medida que suas necessidades de dados aumentam.

Como e quando usar esses web scrapers

Dependendo de suas necessidades, raspadores tradicionais e sem código podem ser valiosos, pois tendem a ter casos de uso diferentes.

Web scrapers tradicionais, como Scraper API, são mais comumente usados para:

- Pesquisa de público;

- Pesquisa de mercado;

- Análise da concorrência.

Por outro lado, web scrapers sem código são mais comumente usados para:

- Comparações de preços;

- Monitoramento de revisão;

- Gestão de reputação.

Como regra geral, será melhor usar scrapers tradicionais para lidar com grandes volumes de dados quantitativos e qualitativos. Raspadores sem código podem ser úteis para volumes menores de dados quantitativos.

Conclusão

Automatizar a coleta de dados em grande escala é fundamental para ficar por dentro das tendências do mercado, familiarizar-se com seu público-alvo e superar os concorrentes.

Você pode gerar insights valiosos que podem impulsionar seus negócios somente com dados precisos e oportunos.

Tem alguma opinião sobre isso? Deixe-nos uma linha abaixo nos comentários ou leve a discussão para nosso Twitter ou Facebook.

Recomendações dos Editores:

Bluetti e ONU-Habitat fazem parceria para impulsionar a energia limpa em África

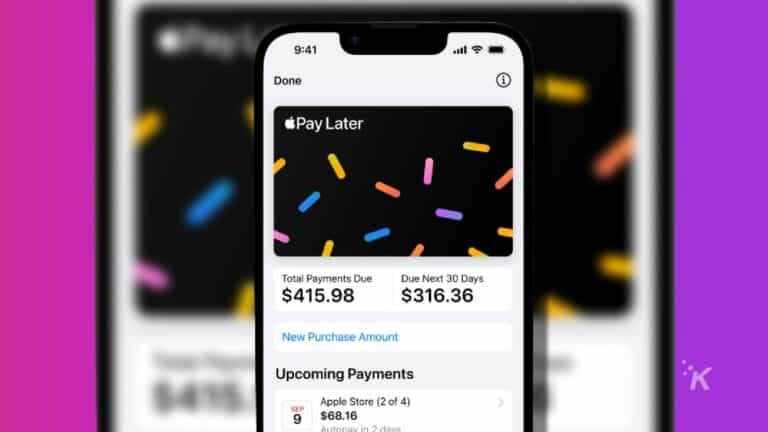

Por que usar aplicativos compre agora e pague depois em 2024?

Desbloqueie a poderosa central elétrica Elite 200 V2 durante a promoção da Black Friday da BLUETTI

Divulgação: Este é um post patrocinado. No entanto, nossas opiniões, análises e outros conteúdos editoriais não são influenciados pelo patrocínio e permanecem objetivos .