Escrocherii cu clonarea vocii AI: 1 din 4 adulți sunt deja vizați

Publicat: 2023-05-02Crezi că ai putea face diferența dintre un mesaj vocal de la cineva drag și un mesaj vocal generat de AI? Ei bine, escrocii care folosesc tehnologia de clonare a vocii AI pentru a frauda victime nebănuitoare speră cu siguranță că nu poți – iar acum, sunt mai activi acum ca niciodată.

Un sondaj realizat recent de McAfee a constatat că un sfert dintre adulți au fost deja vizați de escrocherii vocale AI, majoritatea covârșitoare pierzând banii câștigați cu greu. De asemenea, a dezvăluit că majoritatea adulților își împărtășesc vocea pe platformele de socializare și alte spații online cel puțin o dată pe săptămână – ceea ce oferă actorilor amenințărilor exact ceea ce au nevoie pentru a efectua acest tip de escrocherie din nou și din nou.

Deci, cum funcționează de fapt înșelătoriile de clonare a vocii AI, cât de comună este și cum puteți identifica o înșelătorie de clonare a vocii AI? Aruncăm o privire mai atentă.

- Ce este o înșelătorie de clonare a vocii AI?

- Cum funcționează de fapt clonarea vocii AI

- Cât de frecvente sunt înșelătoriile clonelor de voce AI?

- Cum să vă dați seama dacă un mesaj este o înșelătorie de clonă vocală AI

Ce este o înșelătorie de clonare a vocii AI?

O escrocherie cu clonarea vocii AI este orice înșelătorie care utilizează fișiere audio generate artificial pentru a înșela victimele să creadă că cei dragi sunt în pericol sau au nevoie de asistență financiară urgentă și le-a contactat pentru ajutor.

Într-o înșelătorie de acest tip, un fraudator va rula un clip al unui subiect care vorbește – adesea răzuit de pe rețelele sociale – printr-un generator de voce AI. Folosind învățarea automată, generatorul va analiza cadența, tonul și înălțimea clipului inițial, apoi va permite fraudatorului să producă un sunet unic, original, care imită aproape perfect vocea subiecților.

Escrocul va trimite apoi aceste înregistrări prietenilor și rudelor subiectului prin aplicații precum WhatsApp, în speranța că nu pot face distincția între persoana iubită și o versiune a vocii generată de AI.

Așa cum este obișnuit în cazul altor escrocherii online , escrocul va încerca să injecteze un sentiment de urgență și de suferință în corespondența lor, pentru a-l împinge pe țintă să acționeze imprudent sau neregulat.

Într-un caz recent, un escroc de voce AI a încercat să convingă o mamă din SUA că fiica ei a fost răpită prin clonarea vocii copilului.

În mod îngrijorător, unui escroc în devenire nu va fi dificil să descopere fișierele audio de care vor avea nevoie pentru a viza o victimă - de fapt, este probabil să aibă de ales.

Un sondaj din mai 2023 publicat de McAfee, care a implicat peste 7.000 de persoane din șapte țări diferite, a constatat că 53% dintre respondenții la sondaj au spus că își împărtășesc vocea online cel puțin o dată pe săptămână. În India, această cifră a fost de 86%.

Cum funcționează de fapt clonarea vocii

Clonarea vocii AI este posibilă numai cu un instrument AI numit generator de voce AI. Pe scurt, generatoarele de voce AI transformă fișierele text în vorbire (denumită adesea instrument „text to speech” sau „TTS”).

Generatorii de voce AI folosesc învățarea automată pentru a se învăța să vorbească în moduri specifice, analizând informațiile din fișierele audio ale persoanelor care vorbesc. Generatorii aplică apoi ceea ce au învățat pentru a citi fișierele text furnizate de utilizatori și pentru a genera conținut audio original.

Multe dintre aceste generatoare au voci personalizate pe care le puteți selecta pentru a vă citi textul, precum și voci celebrități din care să alegeți – dar altele vă vor permite să vă înregistrați propria voce și să creați conținut audio ulterior.

Instrumentul text-to-speech Descript.com oferă un „generator de voce de ultimă generație, auto-descris, care creează o clonă ultrarealistă a propriei voci”.

Generatoarele de voce AI sunt acum disponibile pe scară largă pentru tot felul de dispozitive. Aceste programe oferă o mare valoare persoanelor care au dificultăți de citit sau pur și simplu învață mai bine atunci când ascultă audio, mai degrabă decât citesc cuvântul scris.

Ele sunt, de asemenea, folosite de companiile de publicitate care nu au buget pentru a angaja un artist costisitor de voce off pentru conținutul lor de marketing.

Succesul și utilizarea pe scară largă a ChatGPT au pus un accent reînnoit pe instrumentele AI de toate formele și dimensiunile, inclusiv pe cele care pot fi folosite pentru clonarea audio. În ciuda utilizărilor lor nobile, există acum un mic ecosistem de instrumente AI TTS care, din păcate, poate fi abuzat în scopuri nefaste, inclusiv înșelătorie.

Cât de frecvente sunt înșelătoriile clonelor de voce AI?

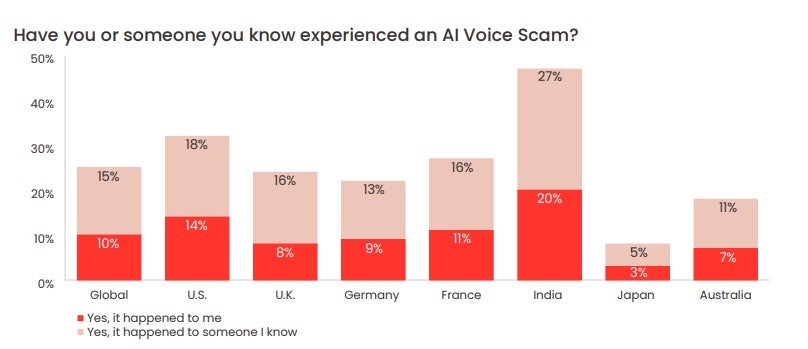

În sondajul recent lansat de McAfee, gigantul securității cibernetice a descoperit că 1 din 4 adulți chestionați s-au confruntat cu o înșelătorie vocală AI.

77% dintre cei vizați au raportat că au pierdut bani din cauza înșelătoriei. McAfee raportează că din cei 77%, „mai mult de o treime au pierdut peste 1.000 USD, în timp ce 7% au fost păcăliți între 5.000 și 15.000 USD”.

Victimele din SUA pierd cel mai mult, arată sondajul. 11% dintre victimele din SUA care au pierdut bani prin escrocherii cu clonarea vocii AI au pierdut între 5.000 și 15.000 USD.

Cum să-ți dai seama dacă un mesaj este o înșelătorie de clonă vocală AI

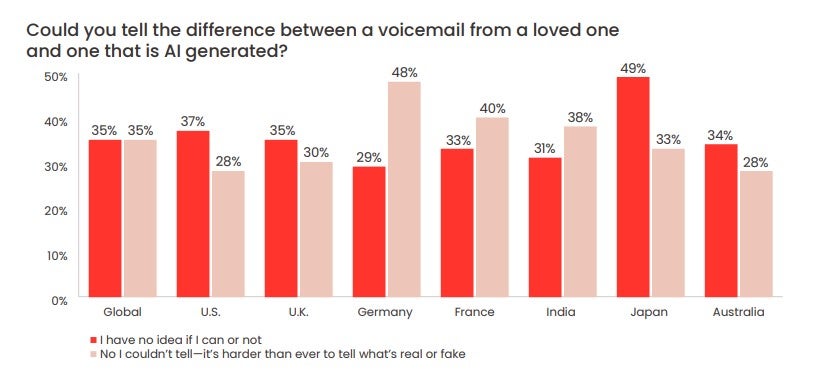

Sondajul McAfee a mai constatat că 70% dintre oameni au spus că nu sunt siguri dacă vor fi capabili să facă diferența dintre o voce AI și una umană.

Aproape o treime (28%) dintre respondenții din SUA au spus că nu ar putea face diferența dintre un mesaj vocal lăsat de un „impostor artificial”, așa cum spune McAfee, și o persoană dragă.

Amintiți-vă, escrocii pot fi capabili să reproducă vocea unei persoane dragi – dar să preluați controlul asupra numărului persoanei iubite sau asupra contului WhatsApp este mult mai dificil.

Poate fi greu să acționezi calm atunci când pare că una dintre rudele sau prietenii tăi este în dificultate. Dar, în condițiile în care înșelătoriile vocale AI devin din ce în ce mai frecvente, este important să faceți. Există câteva semne că un mesaj vocal AI ar putea fi o înșelătorie:

- O metodă de contact neobișnuită (de exemplu, un număr necunoscut)

- Solicitări imediate pentru sume mari de bani

- Solicitări ca bani să fie transferați prin mijloace neobișnuite (de exemplu, carduri cadou sau cripto)

- O cerere ca să nu spui nimănui despre apel/incident

Având în vedere acest lucru, iată ce recomandă FTC să faceți:

- Sună la numărul care ți-a lăsat mesajul pentru a verifica cine este

- Sună-ți persoana iubită sau prietenul tău pe numărul personal

- Trimite mesaje familiei și prietenilor apropiați ai persoanei în cauză

Dacă nu puteți contacta, este important să informați imediat forțele de ordine. Pentru cei dintre voi care nu au fost încă vizați de una dintre aceste escrocherii, dar care doresc să se asigure că nu sunteți victima uneia, stabiliți un cuvânt sigur cu familia și prietenii.

Acesta este un cod care înseamnă că tu și cei dragi vă puteți identifica unul față de celălalt este una dintre cele mai bune modalități de a vă asigura că nu cădeți victima unei escrocherii vocale AI. Acest lucru va fi deosebit de util pentru membrii în vârstă ai familiei și, dacă nu este niciodată scris, poate fi păstrat destul de simplu.

De asemenea, este important să țineți pasul cu cele mai recente metode, tehnici și formate pe care le folosesc escrocii vocali AI pentru a stoarce victimele. Pe lângă a fi vigilent și a trata apelurile de la numere necunoscute cu precauție extremă, a ține urechea la pământ este adesea cel mai bun lucru pe care îl poți face.