Почему чат-боты в области искусственного интеллекта являются главной этической дилеммой

Опубликовано: 2023-10-31Чат-боты с генеративным искусственным интеллектом, такие как ChatGPT , используются для оптимизации рабочих процессов, написания кода и даже сценариев для стендап-комедий. В США, где случаи тревоги и депрессии достигают рекордного уровня, а профессиональная поддержка остается ограниченной, неудивительно, что пользователи также используют эту технологию для управления своим психическим здоровьем.

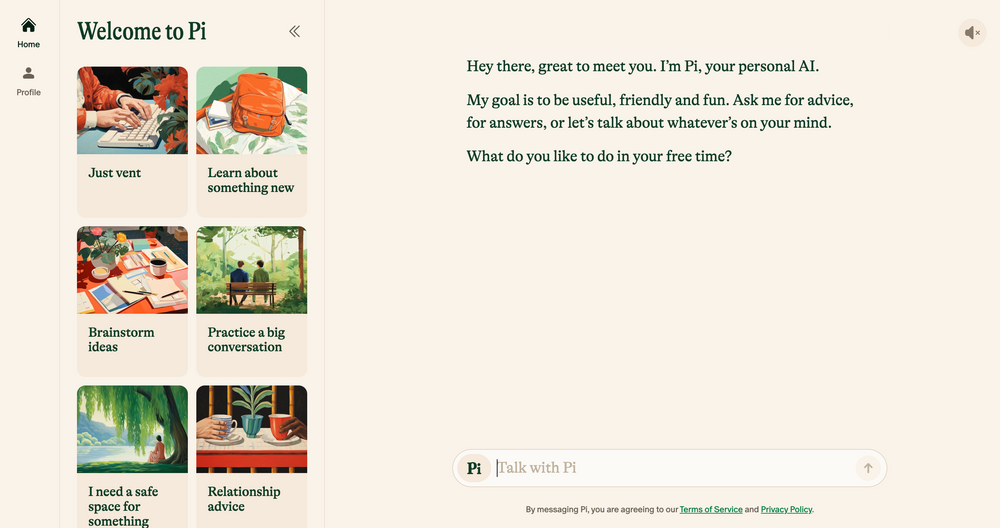

Чат-боты с искусственным интеллектом, такие как Elomia, Pi и Woebot, предлагают доступную персонализированную поддержку 24 часа в сутки, 7 дней в неделю, основанную на проверенных методах терапии. Их преимущества огромны: от помощи пользователям в обход длинных списков ожидания до снижения стигмы в отношении доступа к помощи. Может ли генеративный ИИ, который все еще склонен к ошибкам, галлюцинациям и предвзятости , когда-либо сравниться с эмпатией человеческого уха?

Мы поговорили с учеными, психологами и практикующими терапевтами, чтобы пролить свет на то, как новые технологии могут повлиять на будущее терапии. Мы также обсуждаем темную сторону ИИ-терапии и определяем, какие этические проблемы необходимо решить сегодня. Вот что мы нашли.

Чат-боты с искусственным интеллектом: новое поколение роботов-терапевтов

С тех пор, как в ноябре прошлого года впервые был запущен чат-бот ChatGPT компании OpenAI, в магазинах приложений появилась армия подражателей чат-ботов – от приложений общего назначения, таких как Google Bard и Claude AI , до менее традиционных симуляторов персонажей Marvel.

Этот растущий рынок также привел к появлению чат-ботов для терапии с использованием искусственного интеллекта — приложений, которые используют генеративный искусственный интеллект для имитации советов и указаний, предлагаемых квалифицированными терапевтами и специалистами в области психического здоровья.

Хотите просматривать веб-страницы конфиденциально? Или выглядеть так, будто вы находитесь в другой стране?

Хотите просматривать веб-страницы конфиденциально? Или выглядеть так, будто вы находитесь в другой стране?

Получите огромную скидку 86 % на Surfshark с этим предложением Tech.co в Черную пятницу. ![]()

Основные примеры включают Пи, самопровозглашенного «дружеского собеседника», который действует как резонатор и предлагает эмоциональную поддержку; Replika, программа-чат-бот, имитирующая стиль речи и индивидуальность своих пользователей; и Earkick, трекер тревоги, призванный помочь вам регистрировать и преодолевать сложные эмоции.

«Платформы на основе искусственного интеллекта обеспечивают конфиденциальность, уменьшая стигму, часто связанную с обращением за помощью по поводу проблем с психическим здоровьем». – Райан Султан, сертифицированный психиатр и профессор Колумбийского университета.

Как и лучшие приложения для психического здоровья , многие из этих приложений уже могут похвастаться шестизначными цифрами загрузок – и их популярность неудивительна. Из-за нехватки квалифицированных психологов, психиатров и социальных работников, а также резкого роста спроса на услуги по всей стране, США в настоящее время борются с одним из самых серьезных кризисов психического здоровья за всю историю.

Высокая стоимость традиционной терапии и табу в отношении психического здоровья также удерживают многих от использования традиционных вариантов, создавая пробел для более сдержанных и доступных альтернатив.

Первые данные свидетельствуют о том, что они тоже эффективны. Собственные выводы AI Chatbot’s Earkick показали, что настроение его пользователей улучшилось на 34%, а уровень тревожности снизился на 32% после использования приложения в течение пяти месяцев. Однако, какими бы успешными ни были эти приложения в подавлении незначительных тревог, они определенно не являются той панацеей для психического здоровья, которую мы все ждали.

Чат-боты с искусственным интеллектом не подходят для лечения серьезных психических заболеваний

Получение разумных, одобренных терапевтом советов от карманного чат-бота, несомненно, будет полезно для многих. Однако те, кто страдает от тяжелых психических заболеваний, таких как депрессия, шизофрения и биполярное расстройство, скорее всего, останутся без изменений.

Психические расстройства сложны, имеют множество нюансов и уникальны для каждого человека, которого они затрагивают. В некоторых случаях их лучше всего лечить с помощью лекарств, которые могут быть правильно назначены только квалифицированными медицинскими работниками. Хотя большие языковые модели (LLM) развивались семимильными шагами в последние годы, их результаты никогда не смогут заменить клинический опыт, эмпатию и сострадание, обеспечиваемые психиатрами, психологами и терапевтами.

«Я ценю, что алгоритмы улучшились, но в конечном итоге я не думаю, что они смогут справиться с более запутанными социальными реалиями, в которых находятся люди, когда обращаются за помощью», — Джулия Браун, профессор антропологии Калифорнийского университета в Сан-Франциско.

Стратегический целитель-экстрасенс Аанант Бишт также считает, что ИИ в его нынешнем состоянии не сможет помочь каждому пользователю в сложном пути исцеления. «Также важно избегать чрезмерного упрощения сложных проблем психического здоровья и поощрять пользователей обращаться за профессиональной помощью, когда это необходимо», — говорит Бишт Tech.co.

Еще одна распространенная проблема, выраженная экспертами, с которыми мы говорили, — это медицинский ошибочный диагноз. У сообщества психиатров есть давняя проблема с правильной идентификацией сложных и тяжелых психических расстройств, и сильная зависимость от искусственного интеллекта, вероятно, может усугубить эту проблему из-за ограниченных технологий, нерепрезентативных наборов данных и неспособности интерпретировать человеческие нюансы.

Результаты этого тоже могут быть поразительными. Ошибочный диагноз психического здоровья часто приводит к неадекватному лечению и поддержке, дополнительному психическому давлению и долгосрочному скептицизму по отношению к медицинской системе. Это не единственная причина, по которой искусственный интеллект не способен занять кресло терапевта в его нынешнем виде.

ИИ несовершенен и окутан этическими проблемами

Быстрый рост генеративного искусственного интеллекта не остался без последствий. Поскольку технология продолжает развиваться с головокружительной скоростью, регулирование ее использования отстает, что приводит к появлению ряда этических проблем, связанных с конфиденциальностью данных, встроенной предвзятостью и неправомерным использованием.

Эти проблемы характерны не только для терапии, но деликатная природа психического здоровья означает, что этические рамки лежат в основе любых хороших терапевтических отношений. Поскольку официального этического кодекса ИИ в настоящее время не существует, пользователи, полагающиеся на чат-ботов вместо квалифицированных специалистов для консультирования или другой поддержки психического здоровья, весьма проблематичны.

Конфиденциальность данных является одной из основных проблем. Чат-боты, такие как ChatGPT, часто попадают в неприятности из-за неспособности защитить пользовательские данные . Чтобы пользователи могли чувствовать себя комфортно при обсуждении частной, личной информации, компаниям, занимающимся искусственным интеллектом, необходимо иметь надежную стратегию защиты данных, отдающую приоритет конфиденциальности.

«Интимный и деликатный характер терапевтических бесед требует беспрецедентного уровня защиты данных». – Доктор Лэнгэм, психолог Impulse Therapy.

Еще один важный фактор, о котором следует помнить, — это предвзятость машинного обучения. Все системы искусственного интеллекта полагаются на заранее определенные данные обучения, которые часто включают в себя встроенные человеческие предубеждения, даже если исключить такие чувствительные переменные, как раса и пол.

По словам Баю Прихандито, генерального директора компании Life Architekture, занимающейся коучингом , если ИИ будет обучаться на предвзятых данных, «это может увековечить или усугубить существующие предубеждения, что приведет к несправедливым рекомендациям по лечению». Эти встроенные предрассудки, вероятно, также в большей степени повлияют на людей из групп меньшинств, подчеркивая важность человеческого контроля и разнообразных и репрезентативных наборов данных по обучению.

ИИ как помощник терапевта, а не замена

Популярность дружелюбных компаньонов, таких как Пи и Woebot, будет только расти, поскольку пользователи продолжают искать доступные способы улучшить свое психическое благополучие. Однако из-за широкого спектра этических проблем искусственный интеллект не готов заменить роль традиционной терапии и никогда не должен.

Однако это не означает, что новая технология не окажет огромного влияния на практику в целом. Большинство практиков, с которыми мы говорили, считают, что, выполняя тяжелую работу, такую как сортировка, инструменты ИИ смогут дать им больше времени и энергии для вложения в другие области практики.

«Хотя он не может заменить глубокую человеческую связь, которую предлагают терапевты, он может служить дополнительным инструментом». – Аанант Биш, бизнес-тренер-психолог.

«ИИ мог бы проводить первоначальные оценки, постоянный мониторинг и оказывать поддержку в менее сложных случаях, позволяя нам сосредоточиться на более серьезных или деликатных ситуациях», — сказал Баю Прихандито Tech.co, добавив: « Это похоже на наличие дополнительной пары рук, которые всегда готовы помочь». доступный."

Профессор Колумбийского университета и дипломированный психиатр Султан соглашается, сообщая Tech.co, что через пять лет ИИ, вероятно, дополнит традиционную терапию , упрощая административные задачи, помогая практикующим врачам создавать более персонализированные планы лечения и « создавая гибридные модели, сочетающие человеческий опыт с искусственным интеллектом». инструменты для улучшения лечения».

Это говорит о том, что ИИ не только не истощает человечность практики, но и способен высвободить человеческие навыки, такие как сочувствие, общение и сострадание, помогая клиентам получить еще больше от услуги.

Однако забота о психическом здоровье — дело серьезное и зачастую может быть вопросом жизни и смерти. Прежде чем ИИ станет помощником каждого терапевта или даже заменит его, необходимо рассмотреть строгие правила его применения и использования.

Пока такое время не наступит, явный потенциал чат-ботов с искусственным интеллектом для улучшения доступа к поддержке психического здоровья не может быть полностью согласован с рисками, которые они представляют. В мире, где этические дилеммы часто являются обычным явлением, эта проблема просто слишком сложна, чтобы ее игнорировать.