ChatGPT และ AI ภาษาอื่นๆ ก็ไร้เหตุผลพอๆ กับเรา

เผยแพร่แล้ว: 2023-04-10ในช่วงไม่กี่ปีที่ผ่านมามีความก้าวหน้าอย่างมากมายในระบบปัญญาประดิษฐ์แบบจำลองภาษาขนาดใหญ่ที่สามารถทำสิ่งต่างๆ เช่น เขียนบทกวี ทำการสนทนาแบบมนุษย์ และสอบผ่านโรงเรียนแพทย์

ความคืบหน้านี้ทำให้เกิดโมเดลเช่น ChatGPT ซึ่งอาจมีผลทางสังคมและเศรษฐกิจที่สำคัญตั้งแต่การเลิกจ้างงานและการเพิ่มข้อมูลที่ผิดไปจนถึงการเพิ่มผลผลิตจำนวนมาก

แม้จะมีความสามารถที่น่าประทับใจ แต่แบบจำลองภาษาขนาดใหญ่ไม่ได้คิดจริงๆ พวกเขามักจะทำผิดพลาดเบื้องต้นและแม้แต่สร้างสิ่งต่างๆ

อย่างไรก็ตาม เนื่องจากพวกเขาสร้างภาษาที่คล่องแคล่ว ผู้คนมักจะตอบสนองต่อพวกเขาราวกับว่าพวกเขาคิด

สิ่งนี้ทำให้นักวิจัยศึกษาความสามารถและอคติของ "ความรู้ความเข้าใจ" ของโมเดล ซึ่งเป็นงานที่มีความสำคัญมากขึ้นในขณะนี้ที่โมเดลภาษาขนาดใหญ่สามารถเข้าถึงได้อย่างกว้างขวาง

สายการวิจัยนี้ย้อนกลับไปถึงรูปแบบภาษาขนาดใหญ่ในยุคแรกๆ เช่น BERT ของ Google ซึ่งรวมเข้ากับเครื่องมือค้นหาของตน และได้รับการบัญญัติศัพท์ว่า BERTology

การวิจัยนี้ได้เปิดเผยมากมายเกี่ยวกับสิ่งที่โมเดลดังกล่าวสามารถทำได้และจุดที่ผิดพลาด

ตัวอย่างเช่น การทดลองที่ออกแบบมาอย่างชาญฉลาดได้แสดงให้เห็นว่าแบบจำลองทางภาษาจำนวนมากมีปัญหาในการจัดการกับคำปฏิเสธ ตัวอย่างเช่น คำถามที่ระบุว่า "อะไรไม่ใช่" และทำการคำนวณอย่างง่าย

พวกเขาสามารถมั่นใจมากเกินไปในคำตอบแม้ว่าจะตอบผิดก็ตาม เช่นเดียวกับอัลกอริทึมแมชชีนเลิร์นนิงสมัยใหม่อื่นๆ พวกเขามีปัญหาในการอธิบายตัวเองเมื่อถูกถามว่าทำไมพวกเขาถึงตอบแบบนั้น

คำพูดและความคิด

ด้วยแรงบันดาลใจจากการวิจัยที่เพิ่มขึ้นใน BERTology และสาขาที่เกี่ยวข้อง เช่น วิทยาศาสตร์การรู้คิด นักเรียนของฉัน Zhisheng Tang และฉันจึงตั้งใจที่จะตอบคำถามที่ดูเหมือนง่ายๆ เกี่ยวกับแบบจำลองภาษาขนาดใหญ่: พวกเขามีเหตุผลหรือไม่

แม้ว่าคำว่าเหตุผลมักใช้เป็นคำพ้องความหมายหรือสมเหตุสมผลในภาษาอังกฤษในชีวิตประจำวัน แต่ก็มีความหมายเฉพาะในด้านการตัดสินใจ

ระบบการตัดสินใจ - ไม่ว่าจะเป็นมนุษย์แต่ละคนหรือหน่วยงานที่ซับซ้อนเช่นองค์กร - นั้นมีเหตุผลหากได้รับตัวเลือกชุดหนึ่ง ระบบเลือกที่จะเพิ่มผลกำไรที่คาดหวังให้ได้สูงสุด

ตัวระบุ "คาดหวัง" มีความสำคัญเนื่องจากบ่งชี้ว่าการตัดสินใจเกิดขึ้นภายใต้เงื่อนไขของความไม่แน่นอนที่มีนัยสำคัญ

ถ้าฉันโยนเหรียญที่ยุติธรรม ฉันรู้ว่ามันจะออกหัวครึ่งหนึ่งของเวลาโดยเฉลี่ย อย่างไรก็ตาม ฉันไม่สามารถทำนายผลของการโยนเหรียญใด ๆ ได้

นี่คือเหตุผลที่คาสิโนสามารถจ่ายเงินก้อนใหญ่เป็นครั้งคราวได้: แม้แต่อัตราต่อรองเจ้ามือที่แคบก็ยังให้ผลกำไรมหาศาลโดยเฉลี่ย

ดูเผินๆ มันดูแปลกที่จะสันนิษฐานว่าแบบจำลองที่ออกแบบมาเพื่อคาดเดาคำและประโยคได้อย่างแม่นยำโดยไม่เข้าใจความหมายของคำและประโยคจริงๆ สามารถเข้าใจผลที่คาดหวังได้

แต่มีงานวิจัยจำนวนมากที่แสดงให้เห็นว่าภาษาและความรู้ความเข้าใจเกี่ยวพันกัน

ตัวอย่างที่ยอดเยี่ยมคือการวิจัยน้ำเชื้อที่ทำโดยนักวิทยาศาสตร์ Edward Sapir และ Benjamin Lee Whorf ในต้นศตวรรษที่ 20 งานของพวกเขาชี้ให้เห็นว่าภาษาพื้นเมืองและคำศัพท์สามารถกำหนดวิธีคิดของบุคคลได้

ขอบเขตที่เป็นความจริงยังเป็นที่ถกเถียงกันอยู่ แต่มีหลักฐานสนับสนุนทางมานุษยวิทยาจากการศึกษาวัฒนธรรมชนพื้นเมืองอเมริกัน

ตัวอย่างเช่น ผู้พูดภาษา Zuni ที่พูดโดยชาว Zuni ในภาคตะวันตกเฉียงใต้ของอเมริกา ซึ่งไม่มีคำแยกสำหรับสีส้มและสีเหลือง ไม่สามารถแยกความแตกต่างระหว่างสีเหล่านี้ได้อย่างมีประสิทธิภาพเท่ากับผู้พูดภาษาที่มีคำแยกต่างหากสำหรับ สี

การเดิมพัน

โมเดลภาษามีเหตุผลหรือไม่?

พวกเขาสามารถเข้าใจกำไรที่คาดหวังได้หรือไม่? เราได้จัดทำชุดการทดลองโดยละเอียดเพื่อแสดงให้เห็นว่า ในรูปแบบเดิม โมเดลอย่าง BERT จะทำงานแบบสุ่มเมื่อมีตัวเลือกแบบ betlike

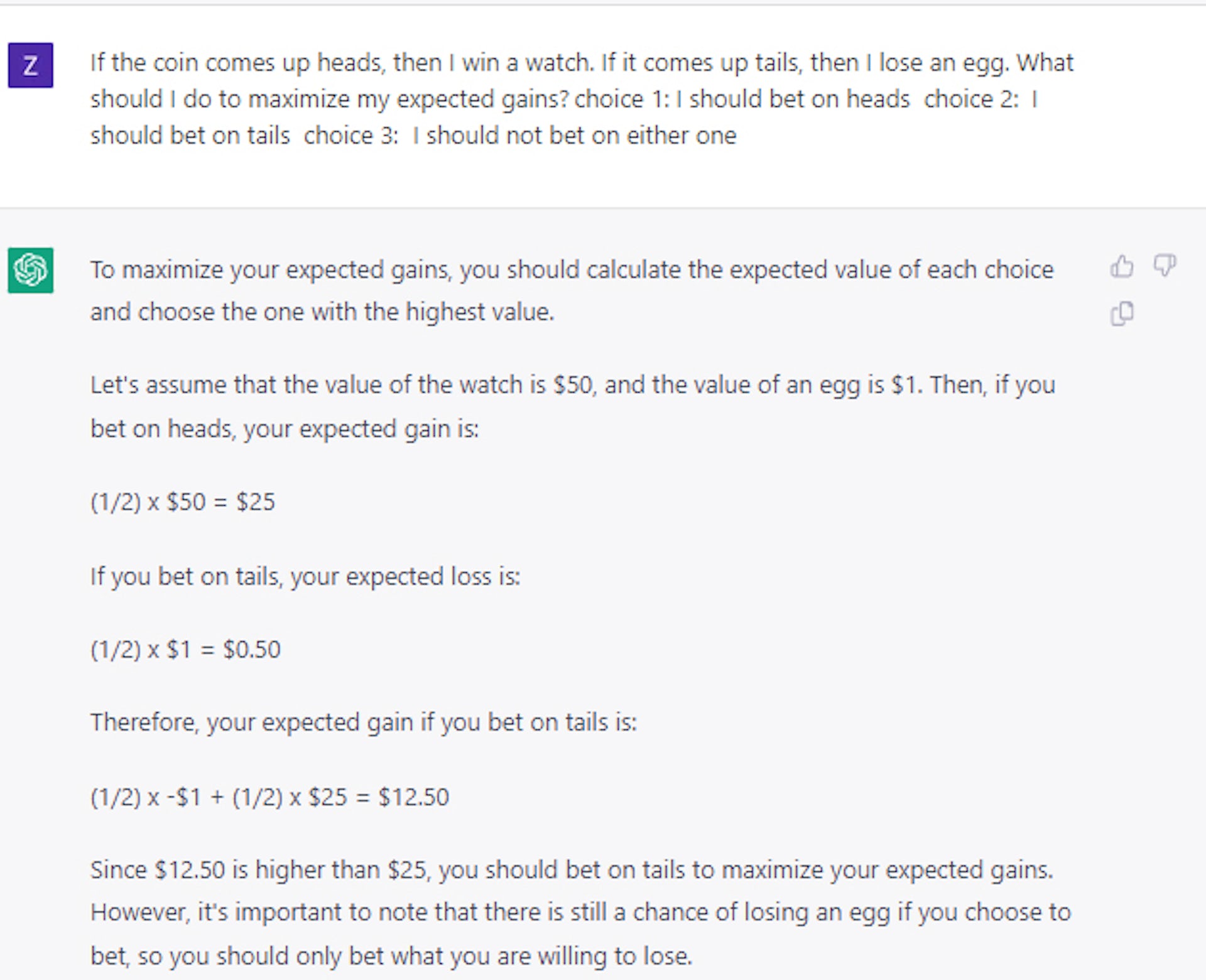

นี่เป็นกรณีแม้ว่าเราจะถามคำถามหลอกๆ เช่น: หากคุณโยนเหรียญแล้วเหรียญออกหัว คุณจะได้เพชร ถ้ามันขึ้นก้อยคุณเสียรถ คุณจะเอาอันไหน คำตอบที่ถูกต้องคือหัว แต่โมเดล AI เลือกก้อยประมาณครึ่งหนึ่ง

ที่น่าสนใจคือ เราพบว่าโมเดลสามารถสอนให้ตัดสินใจอย่างมีเหตุผลโดยใช้คำถามและคำตอบตัวอย่างชุดเล็กๆ เท่านั้น

เมื่อหน้าแดงในตอนแรก ดูเหมือนว่าจะชี้ให้เห็นว่านางแบบสามารถทำอะไรได้มากกว่าแค่ "เล่น" กับภาษา อย่างไรก็ตาม การทดลองเพิ่มเติมแสดงให้เห็นว่าสถานการณ์มีความซับซ้อนมากขึ้น

ตัวอย่างเช่น เมื่อเราใช้ไพ่หรือลูกเต๋าแทนเหรียญเพื่อวางกรอบคำถามเดิมพัน เราพบว่าประสิทธิภาพลดลงอย่างมากกว่า 25% แม้ว่าจะยังคงอยู่เหนือการเลือกแบบสุ่มก็ตาม

ดังนั้นแนวคิดที่ว่าแบบจำลองสามารถสอนหลักการทั่วไปของการตัดสินใจอย่างมีเหตุผลได้ดีที่สุด

กรณีศึกษาล่าสุดที่เราดำเนินการโดยใช้ ChatGPT ยืนยันว่าการตัดสินใจยังคงเป็นปัญหาที่ไม่ซับซ้อนและไม่ได้รับการแก้ไข แม้แต่สำหรับโมเดลภาษาขนาดใหญ่ที่ใหญ่กว่าและก้าวหน้ากว่ามาก

ตัดสินใจให้ถูกต้อง

แนวการศึกษานี้มีความสำคัญเนื่องจากการตัดสินใจอย่างมีเหตุผลภายใต้สภาวะความไม่แน่นอนมีความสำคัญต่อการสร้างระบบที่เข้าใจต้นทุนและผลประโยชน์

เมื่อสร้างสมดุลระหว่างต้นทุนและผลประโยชน์ที่คาดไว้ ระบบอัจฉริยะอาจทำได้ดีกว่ามนุษย์ในการวางแผนรับมือกับการหยุดชะงักของห่วงโซ่อุปทานที่โลกประสบระหว่างการระบาดใหญ่ของโควิด-19 จัดการสินค้าคงคลัง หรือทำหน้าที่เป็นที่ปรึกษาทางการเงิน

ท้ายที่สุดแล้ว งานของเราแสดงให้เห็นว่าหากมีการใช้แบบจำลองภาษาขนาดใหญ่เพื่อวัตถุประสงค์ประเภทนี้ มนุษย์จำเป็นต้องชี้แนะ ตรวจทาน และแก้ไขงานของตน

และจนกว่านักวิจัยจะหาวิธีสร้างโมเดลภาษาขนาดใหญ่ที่มีเหตุผลโดยทั่วไป โมเดลควรได้รับการปฏิบัติด้วยความระมัดระวัง โดยเฉพาะอย่างยิ่งในการใช้งานที่ต้องใช้การตัดสินใจเดิมพันสูง

มีความคิดเกี่ยวกับเรื่องนี้หรือไม่? วางบรรทัดด้านล่างในความคิดเห็นหรือส่งการสนทนาไปที่ Twitter หรือ Facebook ของเรา

คำแนะนำของบรรณาธิการ:

- ใครก็ตามที่มีการเชื่อมต่ออินเทอร์เน็ตสามารถโคลนเสียงของคุณได้

- บริษัทเทคโนโลยีกำลังสูญเสียผู้หญิงที่มีพรสวรรค์ในอัตราที่น่าตกใจ

- โครงสร้างการจัดการแบบ 'แบน' ของ Meta เป็นความฝันที่ไร้เหตุผล นี่คือเหตุผล

- Exoskeleton robo-boots จะปลดปล่อยความเสถียรที่ไม่มีใครเทียบได้สำหรับทุกคน

หมายเหตุบรรณาธิการ: บทความนี้เขียนโดย Mayank Kejriwal ผู้ช่วยศาสตราจารย์ด้านวิศวกรรมอุตสาหการและระบบ มหาวิทยาลัยเซาเทิร์นแคลิฟอร์เนีย และเผยแพร่ซ้ำจาก The Conversation ภายใต้สัญญาอนุญาตครีเอทีฟคอมมอนส์ อ่านบทความต้นฉบับ