为什么人工智能治疗聊天机器人是终极道德困境

已发表: 2023-10-31像ChatGPT这样的生成式人工智能聊天机器人被用来简化工作流程、编写代码,甚至为单口喜剧编写脚本。 在美国,焦虑和抑郁的病例创下历史新高,而专业支持仍然捉襟见肘,因此用户也利用该技术来帮助管理他们的心理健康也就不足为奇了。

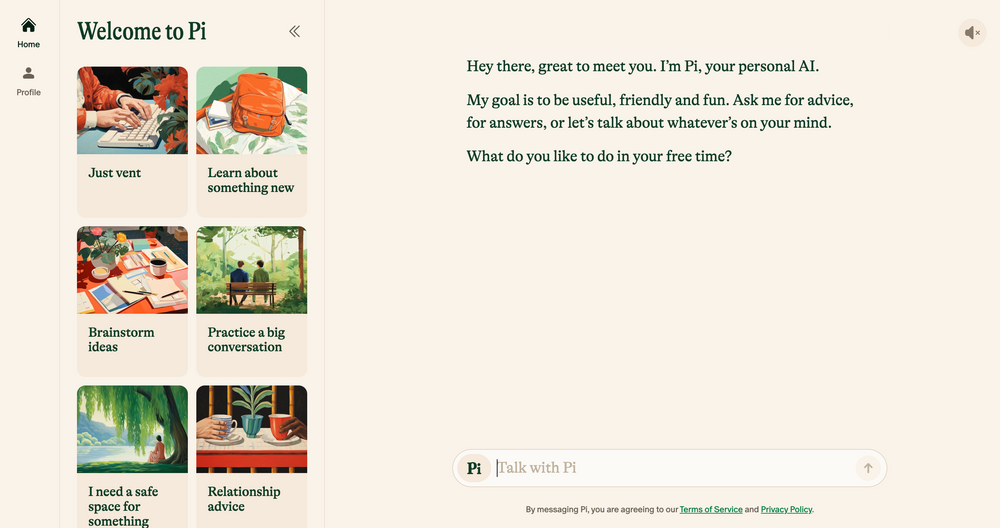

Elomia、Pi 和 Woebot 等 AI 聊天机器人基于久经考验的治疗技术,提供经济实惠的 24/7 个性化支持。 从帮助用户避开漫长的等待名单到减少获得帮助的耻辱,他们的好处是巨大的。 仍然容易出现错误、幻觉和偏见的生成式人工智能能否与人耳的同理心相比?

我们采访了学者、心理学家和执业治疗师,以阐明新兴技术将如何塑造治疗的未来。 我们还讨论了人工智能疗法的阴暗面,并指出当今需要解决哪些伦理问题。 这是我们发现的。

人工智能聊天机器人:新一代机器人治疗师

自 OpenAI 的聊天机器人 ChatGPT 去年 11 月首次推出以来,应用商店中出现了一批聊天机器人模仿者 - 从 Google Bard 和Claude AI等通用应用程序到不太传统的 Marvel 角色模拟器。

这个蓬勃发展的市场还导致了人工智能治疗聊天机器人的兴起,这些应用程序使用生成人工智能来模仿合格治疗师和心理健康专业人员提供的建议和指导。

想要私密地浏览网页吗? 或者看起来好像您在另一个国家?

想要私密地浏览网页吗? 或者看起来好像您在另一个国家?

通过 Tech.co 黑色星期五优惠,享受 Surfshark 86% 的巨额折扣。 ![]()

主要例子包括Pi,一个自称“友好的聊天伙伴”,充当参谋并提供情感支持的人; Replika,一个模仿用户说话风格和个性的聊天机器人程序; Earkick 是一款焦虑追踪器,旨在帮助您记录和处理困难情绪。

“基于人工智能的平台提供隐私,减少了因心理健康问题寻求帮助而带来的耻辱。” ——瑞安·苏丹 (Ryan Sultan),哥伦比亚大学注册精神病学家兼教授

与最好的心理健康应用程序一样,其中许多应用程序的下载量已经达到六位数 - 它们的受欢迎程度不足为奇。 由于缺乏合格的心理学家、精神病学家和社会工作者,加上全国范围内对服务的需求激增,美国目前正在应对有记录以来最严重的心理健康危机之一。

传统疗法的高昂成本和心理健康方面的禁忌也阻碍了许多人寻求传统疗法,从而为更谨慎、更实惠的替代疗法创造了缺口。

早期证据表明它们也有效。 AI Chatbot 的 Earkick 自己的研究结果显示,坚持使用该应用五个月后,用户的情绪改善了 34%,焦虑水平下降了 32%。 然而,尽管这些应用程序可能在平息轻微焦虑方面取得了成功,但它们绝对不是我们一直在等待的心理健康灵丹妙药。

人工智能聊天机器人不适合严重的心理健康状况

从袖珍聊天机器人那里获得明智的、经治疗师认可的建议无疑对许多人有帮助。 然而,那些患有抑郁症、精神分裂症和双相情感障碍等严重心理健康问题的人可能会陷入困境。

精神障碍是复杂的、非常微妙的,并且对每个受其影响的人来说都是独一无二的。 在某些情况下,最好的治疗方法是使用只有合格的医疗专业人员才能正确处方的药物。 尽管大型语言模型(LLM)近年来取得了突飞猛进的发展,但它们的成果永远无法取代精神病学家、心理学家和治疗师提供的临床专业知识、同理心和同情心。

“我很欣赏算法的改进,但最终我不认为它们能够解决人们在寻求帮助时所处的更加混乱的社会现实,”——加州大学旧金山分校人类学教授朱莉娅·布朗 (Julia Brown)

战略心灵治疗师 Aanant Bisht 也认为,在目前的状态下,人工智能将无法帮助每个用户复杂的治疗之旅。 “避免将复杂的心理健康问题过于简单化并鼓励用户在需要时寻求专业帮助也很重要,”Bisht 告诉 Tech.co。

我们采访的专家表达的另一个普遍担忧是医疗误诊。 心理健康界在正确识别复杂和严重的精神疾病方面长期存在问题,而由于技术有限、数据集不具有代表性以及无法解释人类的细微差别,对人工智能的严重依赖可能会加剧这个问题。

这样做的结果也可能是显而易见的。 心理健康误诊常常导致治疗和支持不足、额外的精神压力以及对医疗系统的长期怀疑。 这并不是人工智能不适合取代当前形式的治疗师椅子的唯一原因。

人工智能存在缺陷并面临道德挑战

生成式人工智能的快速崛起并非没有后果。 随着这项技术继续以惊人的速度发展,对其使用的监管却迟迟未能跟上,从而引发了一系列与数据隐私、嵌入偏见和滥用相关的道德挑战。

这些担忧并非治疗所独有,但心理健康的敏感性意味着道德框架是任何良好治疗关系的核心。 由于目前尚不存在官方的人工智能道德规范,用户依赖聊天机器人而不是合格的专业人员来提供咨询或其他心理健康支持是非常有问题的。

数据隐私是一个主要问题。 像 ChatGPT 这样的聊天机器人经常因为未能保护用户数据而陷入困境。 为了让用户能够放心地讨论私人信息,人工智能公司需要有一个万无一失的数据保护策略,优先考虑机密性。

“治疗对话的亲密性和敏感性需要无与伦比的数据保护水平。” – Langham 博士,脉冲疗法心理学家

另一个需要注意的重要因素是机器学习偏差。 所有人工智能系统都依赖于预定的训练数据,即使种族和性别等敏感变量被删除,这些数据通常也包含嵌入的人类偏见。

生活教练公司 Life Architekture 的首席执行官 Bayu Prihandito表示,如果人工智能接受有偏见的数据训练,“它可能会延续或加剧现有的偏见,导致不公平的治疗建议”。 这些内在的偏见也可能对少数群体的人产生更大的影响,凸显了人类监督和多样化且具有代表性的培训数据集的重要性。

人工智能作为治疗师的助手,而不是替代品

随着用户不断寻求可用的方法来补充他们的心理健康,像 Pi 和 Woebot 这样的友好伙伴只会越来越受欢迎。 然而,由于广泛的伦理问题,人工智能还没有准备好取代传统疗法的作用,也不应该取代。

但这并不是说新兴技术不会对整个实践产生巨大影响。 我们采访的大多数从业者都相信,通过执行分类等繁重工作,人工智能工具将能够让他们有更多的时间和精力投入到实践的其他领域。

“虽然它不能取代治疗师提供的深厚的人际关系,但它可以作为一种补充工具。” – Aanant Bish,商业心灵教练

Bayu Prihandito 告诉 Tech.co: “人工智能可以处理初步评估、持续监控,并为不太复杂的案例提供支持,使我们能够专注于更严重或更微妙的情况。”可用的。”

哥伦比亚大学教授、认证精神病学家 Sultan 对此表示同意,他告诉 Tech.co,五年后,人工智能可能会通过简化管理任务、帮助从业者制定更个性化的治疗计划以及“创建将人类专业知识与人工智能相结合的混合模型来补充传统疗法。加强治疗的驱动工具”。

这表明,人工智能非但没有耗尽人性实践,反而有能力释放同理心、联系和同情心等人类技能,帮助客户从服务中获得更多收益。

然而,照顾心理健康是一件严肃的事情,往往事关生死。 在人工智能成为每个治疗师的助手或真正取代他们之前,需要考虑对其部署和使用的严格规定。

在这一时刻到来之前,人工智能聊天机器人在改善心理健康支持方面的明显潜力与它们带来的风险无法完全协调。 在一个道德困境常常司空见惯的世界里,这个问题实在是太大了,不容忽视。