克服数据注释中的偏见

已发表: 2024-11-22请注意,如果您通过我们的链接购买商品,我们可能会获得一小部分销售份额。这是我们保持这里灯火通明的方式之一。单击此处了解更多信息。

在人工智能中,带注释的数据直接决定了机器学习模型的准确性和公平性。然而,偏差可能会导致机器学习模型的结果不可靠和性能不佳。

让我们深入探讨这一挑战的核心,并探索实用、可行的策略来克服数据注释中的偏见。

了解数据注释中的偏差

首先,什么是数据注释,偏差如何影响它?

数据注释是标记数据(例如图像、文本或视频)以训练机器学习模型的过程。

当标签受到个人观点或外部影响的影响时,这个过程中就会出现偏差。这是一个常见的陷阱,如果不加以控制,它可能会破坏机器学习的整个目的。

例如,如果使用始终将特定方言中的短语评为“负面”的注释来训练情感分析模型,则该模型在用该方言编写的文本上可能表现不佳。

更糟糕的是,它可能会强化刻板印象,导致道德担忧和人工智能结果有缺陷。

数据注释中的偏差类型

数据注释偏差不仅仅以一种方式表现出来;它们根据数据源、注释器和标签说明采取不同的形式。以下是一些常见的罪魁祸首:

抽样偏差

当收集的数据不包括人口的所有多样性时,就会发生这种情况。例如,在主要是浅肤色的面孔上训练面部识别系统可能会导致深色肤色的准确性较差。

注释者偏差

这源于注释者的背景、观点或先入之见。两个注释者查看相同的图像或文本可能会对其进行不同的解释,尤其是在涉及文化或社会差异的情况下。

标签偏差

这种偏见通常源于模糊或主观的标签说明,当指南将注释者推向特定的解释时,就会发生这种偏见。

由于刻板印象驱动的标签指南,尽管女性代表,但将运动员的形象标记为“男性”,就是一个典型的例子。

最小化注释偏差的策略

值得庆幸的是,偏见不一定是不可避免的。您可以采取一些具体步骤来避免偏见,确保您的数据注释尽可能保持中立和代表性。

制定明确和中立的指导方针

首先制定数据注释技术指南,为主观解释留下最小的空间。

想象一下,如果注释电影评论只有“负面”和“正面”类别,但没有提供具体指导,注释者可能会错误地对中性或讽刺性评论进行分类。

相反,为每个标签提供明确的描述和示例,甚至包括边缘情况。

组建多样化的注释器池

将注释器视为模型观察世界的镜头。狭隘的视角会导致狭隘的见解,因此同质的注释者池可能会注入狭隘的视角。

通过整合来自不同背景的不同注释者群体,您更有可能捕获广泛的观点。

提供定期培训和反馈

培训不仅仅针对机器。人类注释者也可以从通过培训课程和反馈循环进行的定期重新校准中受益。

一致的、结构化的反馈以及从不同角度进行的数据注释审查可以帮助他们认识到工作中无意识的偏见。

此外,举办偏见意识研讨会可以培训注释者发现自己的倾向并做出公正的决定。

就像语言通过练习变得更加细致一样,注释者的标注技能在适当的指导下也可以变得更加敏锐和客观。

使用交叉注释和共识机制

让我们面对现实:没有人是完美的。即使是最勤奋的注释者有时也可能会达不到目标。这就是交叉注释派上用场的地方。

通过让多个注释者处理相同的数据点,您可以识别差异并就不明确的情况达成共识。

这不仅平衡了个人偏见,还为您提供了更可靠的标签集。

这种方法对于主观类别特别有用,例如情绪检测,其中个人观点经常渗透到注释中。

利用技术消除偏见

仅靠人类的努力可能无法捕捉到所有偏见实例,尤其是在大规模注释项目中。这就是数据注释公司的技术和专业知识可以帮助您发现和解决可能逃脱人类监督的偏见的地方。

自动化质量控制工具

自动化质量控制工具就像注释线的质量检查员。这些工具会检查标记数据是否不一致,并标记可能表明存在偏差的模式。

人工智能驱动的异常检测

异常检测技术提供了另一层保护。这些算法检测注释数据中的异常值,标记显着偏离正常值的数据点。

通过查看标记的案例,您可以发现可能表明偏见的异常标签模式,例如过度标记特定人口统计文本中的某些情绪。

偏见审计框架

有几个框架是专门为审核数据集是否存在潜在偏差而设计的。偏差审核工具会扫描数据中代表性过高或代表性不足的类别,帮助您实现平衡分布。

将其视为聚光灯,照射在数据可能不均匀的区域。定期运行这些审核可以检查您的数据集,并使其与道德人工智能目标保持一致。

最佳实践回顾

克服专家注释中的偏见是一个持续的过程。您可以重新审视以下一些最佳实践,以保持数据的高标准客观性:

- 清晰的指导方针:精确、定义明确的说明和示例有助于消除歧义。

- 多样化的注释者:确保您的注释者团队尽可能具有代表性,以捕捉不同的观点。

- 交叉注释:在不明确的情况下使用多个注释器来平衡主观性。

- 反馈循环:随着时间的推移,持续的培训和反馈可以完善注释者的理解并减少偏见。

- 技术辅助:质量控制工具、异常检测和偏差审计框架都致力于保持数据公正。

| 战略 | 客观的 | 示例用例 |

| 明确的指导方针 | 尽量减少主观解释 | 情感标签的详细规则 |

| 多样化的注释者 | 捕捉广阔的视角 | NLP 项目的多元文化团队 |

| 交叉注释 | 平衡个人偏见 | 情绪检测中的歧义案例共识 |

| 反馈循环 | 通过持续改进减少偏见 | 识别隐性偏见的研讨会 |

| 技术辅助工具 | 检测大型数据集中的偏差模式 | 自动化质量控制和异常检测工具 |

最后的想法

数据注释中的偏差是一项挑战,但可以通过仔细的规划和正确的工具来解决。通过构建包含不同观点、清晰指南和先进技术的强大框架,您可以将机器学习模型建立在坚实、客观的基础上。

每一份努力都很重要,当您完善注释方法时,您不仅可以提高模型的准确性,还可以为道德、公正的人工智能这一更广泛的目标做出贡献。

毕竟,人工智能系统的成功取决于它所学习的数据的可靠性,因此要使数据尽可能公平和平衡。

对此有什么想法吗?请在下面的评论中给我们留言,或者将讨论转移到我们的 Twitter 或 Facebook。

编辑推荐:

黑色星期五:GoveeLife 漏水探测器(3 件装)45% 折扣

从数据到洞察:自动化大规模在线数据收集

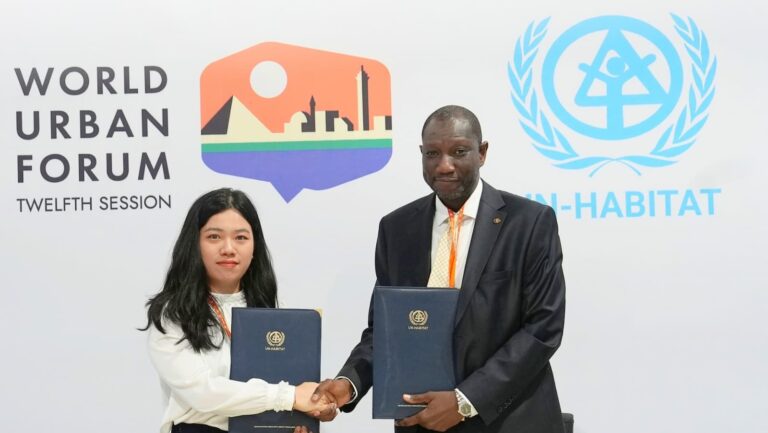

Bluetti 与联合国人居署合作推动非洲清洁能源发展

披露:这是一个赞助帖子。然而,我们的观点、评论和其他编辑内容不受赞助的影响,保持客观。