為什麼人工智慧治療聊天機器人是終極道德困境

已發表: 2023-10-31像ChatGPT這樣的生成式人工智慧聊天機器人被用來簡化工作流程、編寫程式碼,甚至為單口喜劇編寫腳本。 在美國,焦慮和憂鬱的病例創下歷史新高,而專業支援仍然捉襟見肘,因此用戶也利用該技術來幫助管理他們的心理健康也就不足為奇了。

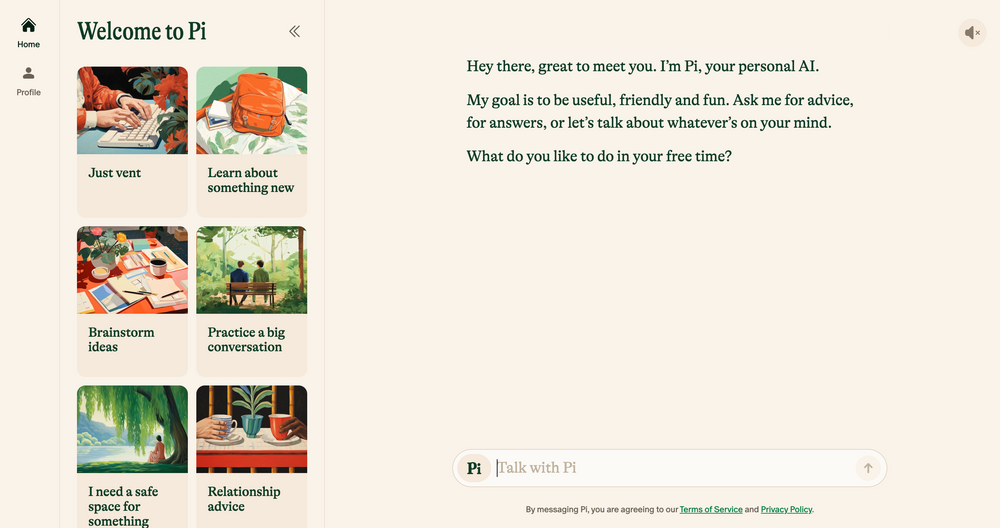

Elomia、Pi 和 Woebot 等 AI 聊天機器人基於久經考驗的治療技術,提供經濟實惠的 24/7 個人化支援。 從幫助用戶避開漫長的等待名單到減少獲得幫助的恥辱,他們的好處是巨大的。 仍然容易出現錯誤、幻覺和偏見的生成式人工智慧能否與人耳的同理心相比?

我們採訪了學者、心理學家和執業治療師,以闡明新興技術將如何塑造治療的未來。 我們也討論了人工智慧療法的陰暗面,並指出當今需要解決哪些倫理問題。 這是我們發現的。

人工智慧聊天機器人:新一代機器人治療師

自 OpenAI 的聊天機器人 ChatGPT 去年 11 月首次推出以來,應用程式商店中出現了一批聊天機器人模仿者 - 從 Google Bard 和Claude AI等通用應用程式到不太傳統的 Marvel 角色模擬器。

這個蓬勃發展的市場也導致了人工智慧治療聊天機器人的興起,這些應用程式使用生成人工智慧來模仿合格治療師和心理健康專業人員提供的建議和指導。

想要私密地瀏覽網頁嗎? 或看起來好像您在另一個國家?

想要私密地瀏覽網頁嗎? 或看起來好像您在另一個國家?

透過 Tech.co 黑色星期五優惠,享受 Surfshark 86% 的巨額折扣。 ![]()

主要例子包括Pi,一個自稱“友好的聊天夥伴”,充當參謀並提供情感支持的人; Replika,一個模仿使用者說話風格和個性的聊天機器人程式; Earkick 是一款焦慮追蹤器,旨在幫助您記錄和處理困難情緒。

“基於人工智慧的平台提供隱私,減少了因心理健康問題尋求幫助而帶來的恥辱。” ——瑞安‧蘇丹 (Ryan Sultan),哥倫比亞大學註冊精神科醫師兼教授

與最好的心理健康應用程式一樣,其中許多應用程式的下載量已經達到六位數 - 它們的受歡迎程度不足為奇。 由於缺乏合格的心理學家、精神科醫生和社會工作者,加上全國範圍內對服務的需求激增,美國目前正在應對有史以來最嚴重的心理健康危機之一。

傳統療法的高昂成本和心理健康方面的禁忌也阻礙了許多人尋求傳統療法,從而為更謹慎、更實惠的替代療法創造了缺口。

早期證據表明它們也有效。 AI Chatbot 的 Earkick 自己的研究結果顯示,堅持使用該應用程式五個月後,使用者的情緒改善了 34%,焦慮程度下降了 32%。 然而,儘管這些應用程式可能在平息輕微焦慮方面取得了成功,但它們絕對不是我們一直在等待的心理健康靈丹妙藥。

人工智慧聊天機器人不適合嚴重的心理健康狀況

從袖珍聊天機器人那裡獲得明智的、經治療師認可的建議無疑對許多人有幫助。 然而,那些患有憂鬱症、精神分裂症和躁鬱症等嚴重心理健康問題的人可能會陷入困境。

精神障礙是複雜的、非常微妙的,並且對每個受其影響的人來說都是獨一無二的。 在某些情況下,最好的治療方法是使用只有合格的醫療專業人員才能正確處方的藥物。 儘管大型語言模式(LLM)近年來取得了突飛猛進的發展,但它們的成果永遠無法取代精神科醫師、心理學家和治療師提供的臨床專業知識、同理心和同情心。

「我很欣賞演算法的改進,但最終我不認為它們能夠解決人們在尋求幫助時所處的更混亂的社會現實,」——加州大學舊金山分校人類學教授朱莉婭·布朗 (Julia Brown)

戰略心靈治療師 Aanant Bisht 也認為,在目前的狀態下,人工智慧將無法幫助每個使用者複雜的治療之旅。 「避免將複雜的心理健康問題過於簡單化並鼓勵用戶在需要時尋求專業幫助也很重要,」Bisht 告訴 Tech.co。

我們採訪的專家表達的另一個普遍擔憂是醫療誤診。 心理健康界在正確識別複雜和嚴重的精神疾病方面長期存在問題,而由於技術有限、數據集不具有代表性以及無法解釋人類的細微差別,對人工智慧的嚴重依賴可能會加劇這個問題。

這樣做的結果也可能是顯而易見的。 心理健康誤診常常導致治療和支持不足、額外的精神壓力以及對醫療系統的長期懷疑。 這並不是人工智慧不適合取代目前形式的治療師椅子的唯一原因。

人工智慧存在缺陷並面臨道德挑戰

生成式人工智慧的快速崛起並非沒有後果。 隨著這項技術繼續以驚人的速度發展,對其使用的監管卻遲遲未能跟上,引發了一系列與資料隱私、嵌入偏見和濫用相關的道德挑戰。

這些擔憂並非治療所獨有,但心理健康的敏感度意味著道德框架是任何良好治療關係的核心。 由於目前尚不存在官方的人工智慧道德規範,使用者依賴聊天機器人而不是合格的專業人員來提供諮詢或其他心理健康支援是非常有問題的。

資料隱私是一個主要問題。 像 ChatGPT 這樣的聊天機器人經常因為未能保護用戶資料而陷入困境。 為了讓用戶能夠放心地討論私人訊息,人工智慧公司需要有一個萬無一失的資料保護策略,優先考慮機密性。

“治療對話的親密性和敏感性需要無與倫比的數據保護水平。” – Langham 博士,脈衝療法心理學家

另一個需要注意的重要因素是機器學習偏差。 所有人工智慧系統都依賴預定的訓練數據,即使種族和性別等敏感變數被刪除,這些數據通常也包含嵌入的人類偏見。

生活教練公司 Life Architekture 的執行長 Bayu Prihandito表示,如果人工智慧接受有偏見的數據訓練,「它可能會延續或加劇現有的偏見,導致不公平的治療建議」。 這些內在的偏見也可能對少數群體的人產生更大的影響,凸顯了人類監督和多樣化且代表性的培訓資料集的重要性。

人工智慧作為治療師的助手,而不是替代品

隨著用戶不斷尋求可用的方法來補充他們的心理健康,像 Pi 和 Woebot 這樣的友善夥伴只會越來越受歡迎。 然而,由於廣泛的倫理問題,人工智慧還沒有準備好取代傳統療法的作用,也不應該取代。

但這並不是說新興科技不會對整個實踐產生巨大影響。 我們採訪的大多數從業者都相信,透過執行分類等繁重工作,人工智慧工具將能夠讓他們有更多的時間和精力投入實踐的其他領域。

“雖然它不能取代治療師提供的深厚的人際關係,但它可以作為一種補充工具。” – Aanant Bish,商業心靈教練

Bayu Prihandito 告訴 Tech.co: “人工智慧可以處理初步評估、持續監控,並為不太複雜的案例提供支持,使我們能夠專注於更嚴重或更微妙的情況。”可用的。”

哥倫比亞大學教授、認證精神病學家 Sultan 對此表示同意,他告訴 Tech.co,五年後,人工智慧可能會透過簡化管理任務、幫助從業者制定更個性化的治療計劃以及「創建將人類專業知識與人工智慧結合的混合模型來補充傳統療法。加強治療的驅動工具」。

這表明,人工智慧非但沒有耗盡人性實踐,反而有能力釋放同理心、連結和同情心等人類技能,幫助客戶從服務中獲得更多利益。

然而,照顧心理健康是一件嚴肅的事情,往往事關生死。 在人工智慧成為每個治療師的助手或真正取代他們之前,需要考慮對其部署和使用的嚴格規定。

在這一刻到來之前,人工智慧聊天機器人在改善心理健康支援方面的明顯潛力與它們帶來的風險無法完全協調。 在一個道德兩難常常司空見慣的世界裡,這個問題實在太大了,不容忽視。