如何檢測 ChatGPT 和 AI 抄襲

已發表: 2023-06-22ChatGPT 能夠在幾秒鐘內生成有關地球上幾乎任何主題的連貫且寫得好的副本,從而徹底顛覆了學術界和商業界。

它的非凡能力讓所有教育水平的學生都轉向聊天機器人以及它的競爭對手,如巴德,來撰寫複雜的論文,否則這些論文需要幾個小時才能完成。

這引發了一場關於一種新現象的全球對話,這種現象通常被稱為“ChatGPT 抄襲”。 本指南涵蓋了企業和教育機構用於檢測 ChatGPT 抄襲的工具、ChatGPT 作弊的危險 - 以及使用 ChatGPT 是否算作抄襲。

- 如何檢測 ChatGPT 抄襲

- 最受歡迎的 AI 和 ChatGPT 抄襲檢查器

- 人工智能內容檢查器真的有用嗎?

- 使用 ChatGPT 或 Bard 實際上是抄襲嗎?

- ChatGPT 作弊的危險

- ChatGPT 抄襲嗎?

- 巴德抄襲嗎?

- 其他人工智能工具是否存在抄襲行為?

- 我應該在論文或工作中使用 ChatGPT 嗎?

最受歡迎的 AI 和 ChatGPT 抄襲檢查工具評測

自 ChatGPT 於 2022 年 11 月推出以來,許多公司和教育機構都製作了 AI 內容檢查器,聲稱能夠區分人工生成的內容和人類創建的內容。 現在,很多公司也在使用谷歌的聊天機器人 Bard,它使用不同的語言模型。

然而,即使是最有信譽的人工智能內容檢測工具所聲稱的準確性也存在激烈爭議,並且學生之間被錯誤指控使用人工智能內容和教育的法庭案件已經成為現實。

底線是:這個領域沒有任何工具是 100% 準確的,但有些工具比其他工具要好得多。

GPT零

GPTZero 是一款流行的免費 AI 內容檢測工具,聲稱它是“跨用例最準確的 AI 檢測器,經過多個獨立來源驗證”。

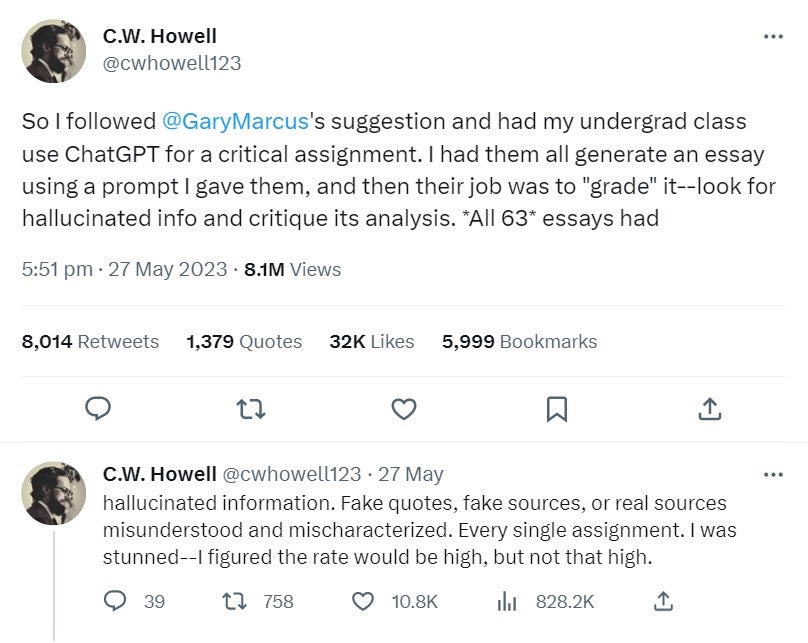

然而,早在四月份,加州大學戴維斯分校的一名歷史系學生就證明,GPTZero——他的教授使用的人工智能內容檢測工具——將他的論文標記為人工智能生成是不正確的。

我們通過要求 ChatGPT 寫一個短篇故事來測試 GPTZero。 不幸的是,GPTZero 無法判斷該內容是由人工智能工具編寫的:

創意.ai

Originality.ai 無疑是目前可用的更準確的人工智能內容檢測工具之一。

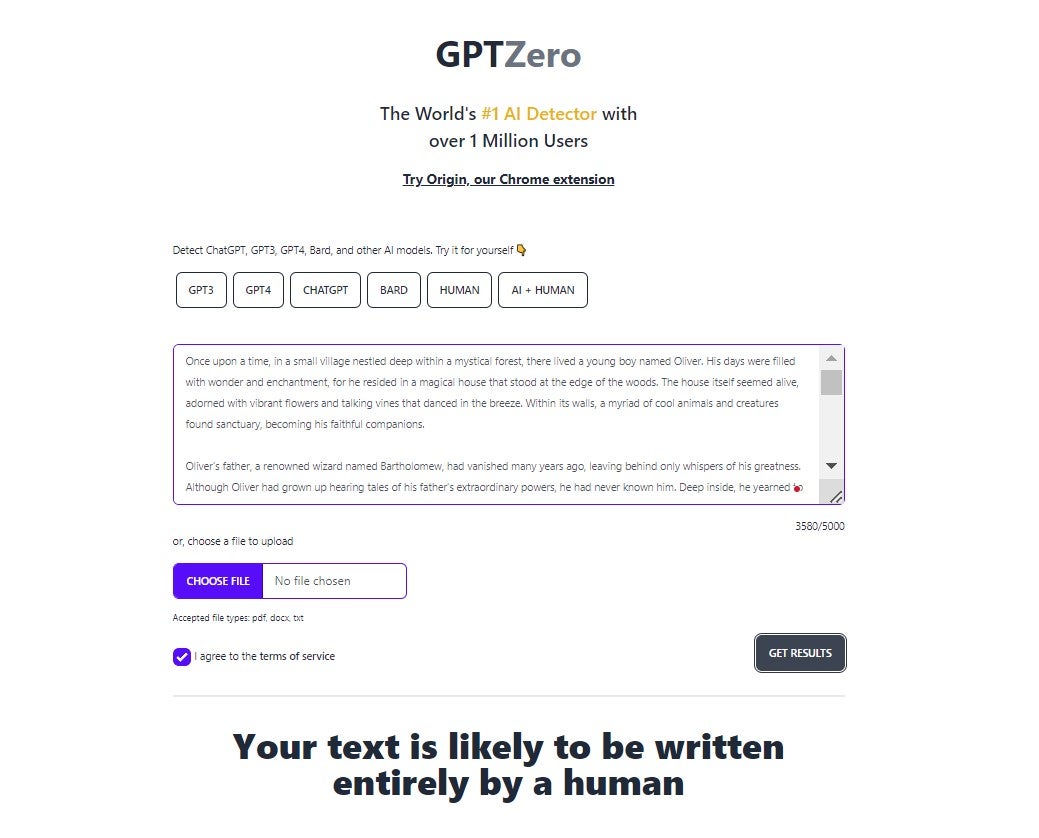

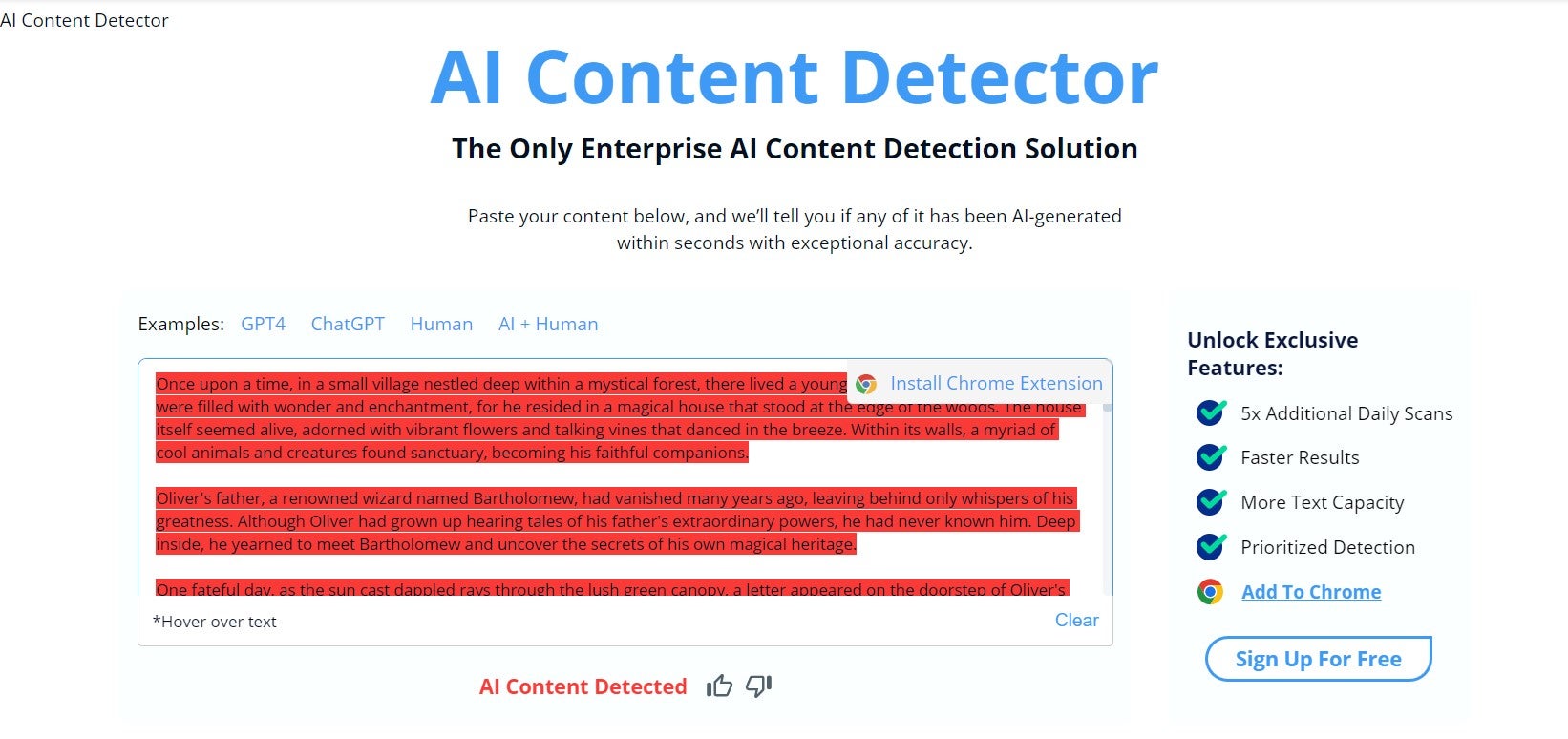

該公司於今年 4 月對人工智能內容檢測工具進行了自己的研究,其中將 600 個人工生成的文本塊和 600 個人工生成的文本塊輸入到自己的內容檢測系統中,以及其他聲稱具有類似功能的流行工具。

從下面的結果中可以看出,Originality.ai 的表現優於測試中包含的所有工具:

Originality.ai 的唯一缺點是沒有免費計劃,您甚至無法像本文中包含的其他應用程序那樣免費測試它。 2,000 個學分的費用為 20 美元,可以讓你檢查 200,000 個單詞。

Copyleaks AI 內容檢測器

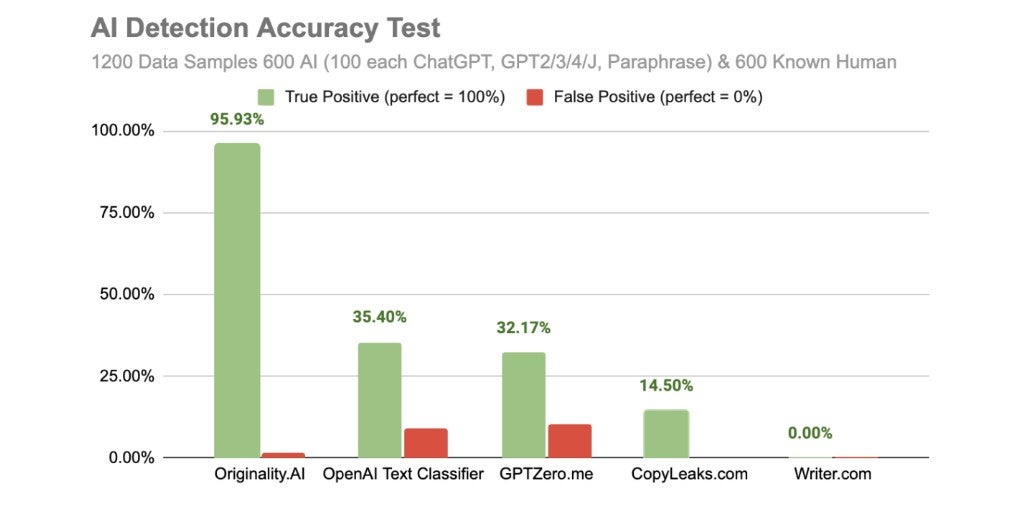

Copyleaks 是一款免費使用的人工智能內容檢測器,聲稱能夠以 99.12% 的準確率區分人類生成的副本和人工智能生成的副本。

Copyleaks 還會告訴您文檔或段落的特定方面是否由人工智能編寫,即使其其他部分似乎是由人類編寫的。

Copyleaks 表示,它能夠檢測由“ChatGPT、GPT-4、GPT-3、Jasper 等”創建的人工智能生成的內容,甚至聲稱“一旦更新的模型出現,我們將能夠自動檢測它。”

CopyLeaks 每月 8.33 美元,可獲得 1,200 個積分(每個積分 250 個字的副本)。

然而,在 TechCrunch 於 2023 年 2 月進行的測試中,Copyleaks 錯誤地將各種不同類型的人工智能生成的副本(包括新聞文章、百科全書條目和求職信)歸類為人類生成的副本。

此外,上述 Originality.ai 的研究僅發現其在 14.50% 的情況下是準確的,這與 CopyLeaks 聲稱的 99.12% 的準確率相去甚遠。

然而,當我們測試它時,它似乎能夠識別出我們輸入的文本是由 ChatGPT 生成的:

Turnitin 人工智能檢測器

Turnitin 是一家總部位於美國的抄襲檢測公司,許多大學都部署該公司來掃描學生的作業。 Turnitin 旨在檢測各種抄襲行為,但在 4 月份透露,它已經投資一個專注於人工智能的團隊一段時間了。

Turnitin 表示,它“可以在我們受控的實驗室環境中以 98% 的置信度檢測人工智能書寫的存在,誤報率低於 1%”。

然而,該公司還表示,如果內容將一段內容標記為人工智能生成,則應將其視為“指示,而不是指控”。 Turnitin 人工智能探測器的真實準確性受到《華盛頓郵報》和其他消息來源的質疑。

Turnitin 的 AI 內容檢測軟件目前是免費的,但該公司在其網站上的常見問題解答中表示,他們將於 2024 年 1 月轉向付費許可計劃,但未具體說明其價格。

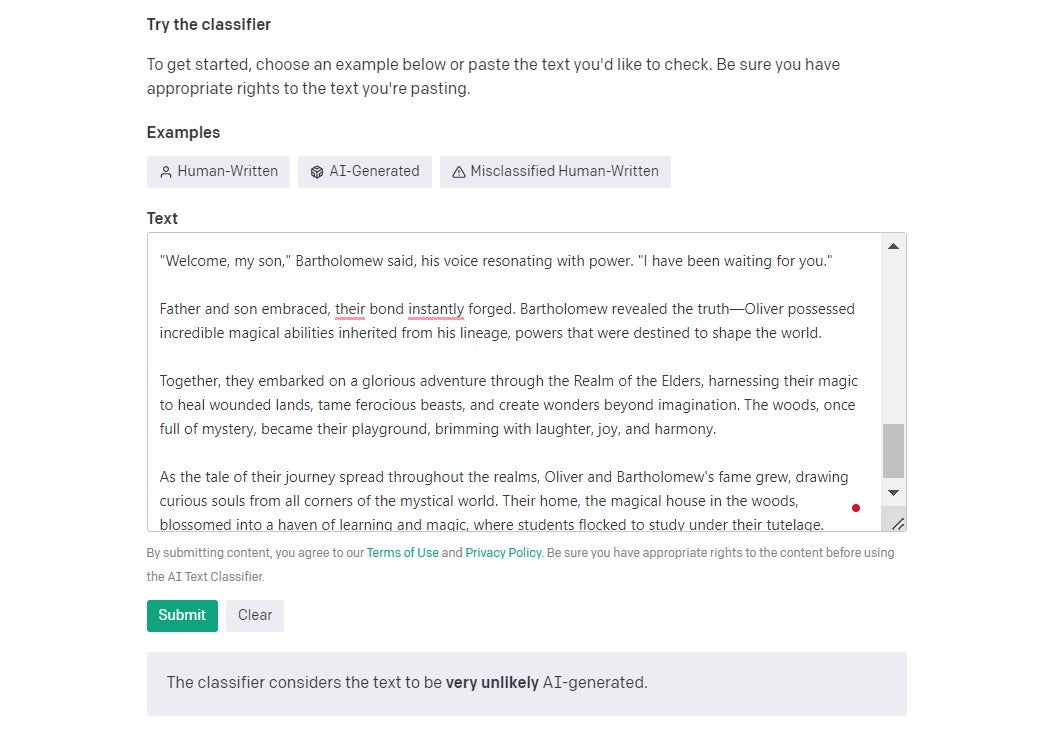

OpenAI 文本分類器

OpenAI 不願被第三方人工智能內容檢查器打敗,他們自己發布了一款軟件,旨在對內容是否由人工智能生成進行分類。

您輸入的文檔或文本的長度必須超過 1000 個字符。 輸入文檔後,OpenAI 幾乎會立即告訴您它認為該文檔是由人類生成的可能性有多大。

我發布了 Tech.co 最近一篇文章的摘錄,該文章由一位作家撰寫,OpenAI 正確地確定該文章“非常不可能”是由 AI 撰寫的。

在我們之前引用的同一篇 TechCrunch 文章中,該出版物表示 OpenAI 估計其文本分類器錯過了 74% 的人工智能生成內容。 他們對此也很誠實,這是一件好事——當我們使用 ChatGPT 生成的短篇故事進行第二次測試時,它沒有意識到它是人工智能生成的事實:

AI內容檢測真的有效嗎?

沒有任何人工智能內容檢測工具是 100% 可靠的——我們的測試充分證明了這一點。

然而,我們今天討論的工具中沒有一個真正聲稱 100% 準確,也很少有聲稱完全沒有誤報。 其他人,比如 GPTZero,則發布了免責聲明,稱他們的結果是福音。

一些被指控使用人工智能撰寫論文的大學生已經被迫證明他們的作品是原創的。

今年 3 月,在德克薩斯州,一位教授錯誤地指責全班學生使用 ChatGPT 寫論文,導致他們不及格。 還有一系列報告(以及 Originality.ai 進行的研究)表明,即使是最有能力的抄襲檢查員也並不像他們聲稱的那麼準確。

即使 Turnitin 的 AI 內容檢測器也並非萬無一失。 在我們之前討論過的《華盛頓郵報》最近進行的相對較小的測試中,其準確率遠遠低於他們聲稱能夠達到的 98%。

另一方面,Originality.ai 無疑是目前最強大的技術之一,甚至它的檢測技術也並非每次都正確。

此外,如果存在任何形式的誤報,那麼學生總會有空間聲稱他們的作品是原創的,只是被錯誤識別了。

使用 ChatGPT 或 Bard 是否抄襲?

ChatGPT 是否真的抄襲是有爭議的。 牛津語言將剽竊定義為“將他人的作品或想法冒充為自己的作品或想法的行為”。

ChatGPT 不是一個人,它在生成答案時並不是簡單地複制其他人的工作和想法。 因此,根據字典的定義,這並不是徹底的抄襲。

即使它這樣做了,如果你誠實地知道它來自哪裡(即 ChatGPT),可以說,無論如何這都不會是抄襲。

然而,一些學校和大學有影響深遠的抄襲規則,並考慮使用聊天機器人來撰寫論文。 去年 12 月,弗曼大學的一名學生在使用 ChatGPT 撰寫論文後未能獲得哲學學位。 在另一個案例中,北密歇根大學的一位教授報告稱,他發現兩名學生使用聊天機器人為班級寫論文。

使用 ChatGPT 生成論文,然後將其冒充為自己的作品,也許更準確地描述為“作弊”,而且絕對是“不誠實”。

寫論文的全部目的是表明你有能力產生原創想法、理解相關概念、仔細考慮相互矛盾的論點、清晰地呈現信息並引用你的資料來源。

以這種方式使用 ChatGPT 和花錢請其他學生為你寫論文沒有什麼區別——這當然是作弊。

對於谷歌的巴德來說,答案有點複雜。 上面使用的邏輯同樣適用於 Bard,也適用於 ChatGPT,但 Bard 因抄襲和錯誤引用其從互聯網上獲取的內容的指控而受到損害,而 ChatGPT 卻沒有這樣做。 因此,使用 Bard 可能會導致您無意中抄襲其他來源(更多內容見下文)。

ChatGPT 的回復是否抄襲?

不 – ChatGPT 不會從其他來源獲取信息,然後簡單地將其逐句拼湊在一起。 這是對生成式預訓練 Transformer 工作原理的誤解。

ChatGPT(或更準確地說是 GPT 語言模型)是在龐大的文檔、網站材料和其他文本數據集上進行訓練的。

它使用算法來查找數據集中的語言序列和模式。 然後可以根據語言模型從這些數據集中的序列中學到的語言知識來生成段落、句子和單詞。

這就是為什麼如果你在兩個不同的設備上同時向 ChatGPT 詢問相同的問題,它的答案通常非常相似——但仍然會存在差異,有時,它會提供完全不同的答案。

巴德的回應是否抄襲?

ChatGPT 最大的競爭對手,谷歌的 Bard 自推出以來,與更受歡迎的同行相比,在抄襲內容方面遇到的問題要多得多。 科技網站 Tom's Hardware 發現巴德抄襲了其一篇文章,然後在其一名員工指出此事後道歉。

最近,即 2023 年 5 月,PlagiarismCheck 告訴雅虎新聞,他們與 Bard 生成了 35 段文本,發現其中 25 段通過簡單地解釋互聯網上已發布的現有內容而抄襲了 5% 以上。

Bard 和 ChatGPT 之間的一個很大的區別或許可以解釋這一點,那就是 Bard 可以在互聯網上搜索答案,這就是為什麼它往往能更好地處理與 2021 年之後事件相關的問題,而 ChatGPT 則在這方面遇到了困難。 然而,這似乎也意味著它以不那麼原始的方式從來源中提取數據,並更頻繁地引用其來源。

這些示例可能只是小插曲,但如果您使用 Bard 進行重要工作,了解其中的風險是有好處的。

其他人工智能工具是否存在抄襲行為?

不幸的是,是的——一些公司已經因為使用抄襲內容的人工智能工具而讓自己陷入尷尬境地。 例如,世界上最大的科技網站之一 CNET 被發現使用人工智能工具來生成文章,而且對此完全不透明。 CNET 發表的使用人工智能的文章中約有一半被發現包含一些不正確的信息。

更糟糕的是,對 CNET 的 AI 剽竊行為發起調查的 Futurism 表示,“該機器人的不當行為包括逐字複製、適度編輯和重大改寫,所有這些都沒有正確註明原文”。

無法生成獨特原創內容(無論是藝術還是文本)的人工智能工具有可能抄襲互聯網上已發布的內容。 準確理解你的 AI 工具使用的語言模型是如何工作的,並對它生成的內容進行嚴格監督,這一點很重要,否則你最終可能會陷入與 CNET 相同的境地。

您應該將 ChatGPT 用於論文還是工作?

使用 ChatGPT 進行論文

事實上,ChatGPT 並不是簡單地從其他來源獲取答案並將句子混搭在一起,這意味著企業已經能夠使用 ChatGPT執行各種不同的任務,而不必擔心版權問題。

但其內部機制也意味著它經常產生幻覺並犯錯誤。 它遠非完美——儘管讓 ChatGPT 為大學或學院撰寫論文很誘人,但我們建議不要這樣做。

當然,每個教育機構的具體提交指南都會略有不同,但很可能在您所在的大學或學校已經被視為“作弊”或抄襲。 另外,無論準確性如何,教育機構都在使用人工智能內容檢測器,隨著時間的推移,這種檢測器將會得到改進。

在工作中使用 ChatGPT

當然,很多人已經在工作中使用 ChatGPT - 事實證明它在各個行業都很有用,可以幫助各種角色的員工在日常任務中節省寶貴的時間。

但是,如果您在工作中使用 ChatGPT,我們建議您向您的經理或主管坦白,尤其是當您將其用於重要活動(例如為外部利益相關者編寫報告)時。

我們還強烈建議您對使用 ChatGPT、Bard 或任何其他 AI 工俱生成的所有工作進行大量編輯和仔細審查。 將敏感的個人或公司信息放入任何聊天機器人中都是不明智的,因為關於這些聊天記錄的存儲位置或 OpenAI 的安全基礎設施的公開信息並不多。

使用其他人工智能工具進行論文或工作

當然,Bard 和 ChatGPT 並不是唯一的人工智能聊天機器人。 然而,我們會猶豫是否要支持任何沒有強大語言模型支持的小型人工智能工具。 它們的資源不會那麼豐富,而且如果您嘗試在工作中使用它們,您也不太可能發現它們有用。

然而,同樣的規則仍然適用 - 向您的經理開放並獲得使用它們的批准,不要輸入任何敏感的公司數據,並始終查看您得到的答案。