克服數據註釋中的偏見

已發表: 2024-11-22請注意,如果您透過我們的連結購買商品,我們可能會獲得一小部分銷售份額。這是我們保持這裡燈火通明的方式之一。按此處了解更多。

在人工智慧中,附註釋的數據直接決定了機器學習模型的準確性和公平性。然而,偏差可能會導致機器學習模型的結果不可靠且表現不佳。

讓我們深入探討這項挑戰的核心,並探索實用、可行的策略來克服資料註釋中的偏見。

了解資料註釋中的偏差

首先,什麼是資料註釋,偏差如何影響它?

資料註釋是標記資料(例如圖像、文字或影片)以訓練機器學習模型的過程。

當標籤受到個人觀點或外在影響的影響時,這個過程就會出現偏差。這是一個常見的陷阱,如果不加以控制,它可能會破壞機器學習的整個目的。

例如,如果使用始終將特定方言中的短語評為「負面」的註釋來訓練情緒分析模型,則該模型在用該方言編寫的文本上可能表現不佳。

更糟的是,它可能會強化刻板印象,導致道德擔憂和人工智慧結果有缺陷。

資料註釋中的偏差類型

資料註釋偏差不僅以一種方式表現出來;它們根據資料來源、註釋器和標籤說明採取不同的形式。以下是一些常見的罪魁禍首:

抽樣偏差

當收集的數據不包括人口的所有多樣性時,就會發生這種情況。例如,在主要是淺膚色的臉孔上訓練臉部辨識系統可能會導致深色膚色的準確性較差。

註釋者偏差

這源自於註釋者的背景、觀點或先入為主。兩個註釋者查看相同的圖像或文字可能會對其進行不同的解釋,尤其是在涉及文化或社會差異的情況下。

標籤偏差

這種偏見通常源自於模糊或主觀的標籤說明,當指南將註釋者推向特定的解釋時,就會發生這種偏見。

由於刻板印象驅動的標籤指南,儘管女性代表,但將運動員的形象標記為“男性”,就是一個典型的例子。

最小化註釋偏差的策略

值得慶幸的是,偏見不一定是不可避免的。您可以採取一些具體步驟來避免偏見,確保您的資料註釋盡可能保持中立和代表性。

制定明確和中立的指導方針

首先制定資料註釋技術指南,為主觀解釋留下最小的空間。

想像一下,如果註釋電影評論只有「負面」和「正面」類別,但沒有提供具體指導,註釋者可能會錯誤地對中性或諷刺性評論進行分類。

相反,為每個標籤提供明確的描述和範例,甚至包括邊緣情況。

組成多樣化的註釋器池

將註釋者視為模型觀察世界的鏡頭。狹隘的視角會導致狹隘的見解,因此同質的註釋者池可能會注入狹隘的視角。

透過整合來自不同背景的不同註釋者群體,您更有可能捕捉廣泛的觀點。

提供定期培訓和回饋

培訓不僅僅是針對機器。人類註釋者也可以從透過訓練課程和回饋循環進行的定期重新校準中受益。

一致的、結構化的回饋以及從不同角度進行的資料註釋審查可以幫助他們認識到工作中無意識的偏見。

此外,舉辦偏見意識研討會可以培訓註釋者發現自己的傾向並做出公正的決定。

就像語言透過練習變得更加細緻一樣,註釋者的標註技能在適當的指導下也可以變得更加敏銳和客觀。

使用交叉註釋和共識機制

讓我們面對現實:沒有人是完美的。即使是最勤奮的註釋者有時也可能達不到目標。這就是交叉註釋派上用場的地方。

透過讓多個註釋者處理相同的數據點,您可以識別差異並就不明確的情況達成共識。

這不僅平衡了個人偏見,還為您提供了更可靠的標籤集。

這種方法對於主觀類別特別有用,例如情緒檢測,其中個人觀點經常滲透到註釋中。

利用科技消除偏見

僅靠人類的努力可能無法捕捉到所有偏見實例,尤其是在大規模註釋項目中。這就是數據註釋公司的技術和專業知識可以幫助您發現和解決可能逃脫人類監督的偏見的地方。

自動化品質控制工具

自動化品質控制工具就像註釋線的品質檢查員。這些工具會檢查標記資料是否不一致,並標記可能表示存在偏差的模式。

人工智慧驅動的異常檢測

異常檢測技術提供了另一層保護。這些演算法可偵測註釋資料中的異常值,標記顯著偏離正常值的資料點。

透過查看標記的案例,您可以發現可能表明偏見的異常標籤模式,例如過度標記特定人口統計文字中的某些情緒。

偏見審計框架

有幾個框架是專門為審核資料集是否存在潛在偏差而設計的。偏差審核工具會掃描資料中代表性過高或代表性不足的類別,幫助您達到平衡分佈。

將其視為聚光燈,照射在數據可能不均勻的區域。定期執行這些審核可以檢查您的資料集,並使其與道德人工智慧目標保持一致。

最佳實務回顧

克服專家註釋中的偏見是一個持續的過程。您可以重新審視以下一些最佳實踐,以保持數據的高標準客觀性:

- 清晰的指導方針:精確、定義明確的說明和範例有助於消除歧義。

- 多樣化的註釋者:確保您的註釋者團隊盡可能具有代表性,以捕捉不同的觀點。

- 交叉註釋:在不明確的情況下使用多個註釋器來平衡主觀性。

- 回饋循環:隨著時間的推移,持續的訓練和回饋可以完善註釋者的理解並減少偏見。

- 技術輔助:品質控制工具、異常檢測和偏差審計架構都致力於維持資料公正。

| 策略 | 客觀的 | 範例用例 |

| 明確的指導方針 | 盡量減少主觀解釋 | 情感標籤的詳細規則 |

| 多樣化的註釋者 | 捕捉廣闊的視角 | NLP 專案的多元文化團隊 |

| 交叉註釋 | 平衡個人偏見 | 情緒偵測中的歧義案例共識 |

| 回饋循環 | 透過持續改進減少偏見 | 辨識隱性偏見的研討會 |

| 科技輔助工具 | 偵測大型資料集中的偏差模式 | 自動化品質控制和異常檢測工具 |

最後的想法

資料註釋中的偏差是一項挑戰,但可以透過仔細的規劃和正確的工具來解決。透過建立包含不同觀點、清晰指南和先進技術的強大框架,您可以將機器學習模型建立在堅實、客觀的基礎上。

每一份努力都很重要,當您完善註釋方法時,您不僅可以提高模型的準確性,還可以為道德、公正的人工智慧這一更廣泛的目標做出貢獻。

畢竟,人工智慧系統的成功取決於它所學習的數據的可靠性,因此要使數據盡可能公平和平衡。

對此有什麼想法嗎?請在下面的評論中給我們留言,或將討論轉移到我們的 Twitter 或 Facebook。

編輯推薦:

黑色星期五:GoveeLife 漏水探測器(3 件裝)45% 折扣

從數據到洞察:自動化大規模線上數據收集

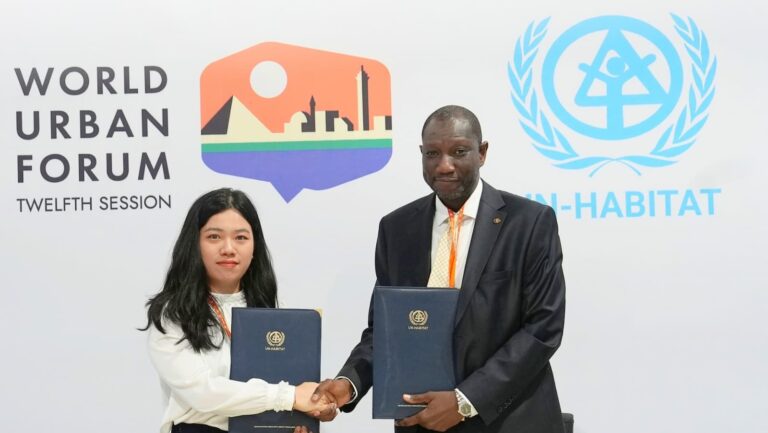

Bluetti 與聯合國人居署合作推動非洲清潔能源發展

披露:這是一個贊助帖子。然而,我們的觀點、評論和其他編輯內容不受贊助的影響,保持客觀。